GPU还是IPU?IPU 芯片厂商 Graphcore 的 2021

Posted CSDN云计算

tags:

篇首语:本文由小常识网(cha138.com)小编为大家整理,主要介绍了GPU还是IPU?IPU 芯片厂商 Graphcore 的 2021相关的知识,希望对你有一定的参考价值。

作者 | 宋慧

出品 | CSDN 云计算&AI 科技大本营

AI 人工智能毋庸置疑是目前最火的 IT 技术领域之一,而主攻图形计算的 NVIDIA GPU(图形处理器)又是现今 AI 领域的当红炸子鸡。不过 AI 芯片领域又迎来了新的挑战者,2016 年创立于英国的 Graphcore 设计并推出了 AI 专用芯片 IPU,在短短几年时间即完成 E 轮 2.22 亿美元融资,并在开拓全球多个市场。

在刚刚过去的 2021 年,Graphcore 在继续加速增长,一年时间内员工就从 400 人增至 700 人,几乎翻倍,而中国团队则从 20 人增至 80 人。2022 年初,CSDN 访问了 Graphcore 大中华区总裁兼全球首席营收官卢涛,对于 Graphcore IPU 的核心架构的设计思路,以及 AI 领域前沿的应用案例,他分享了最新的进展与见解。

IPU vs GPU:解耦后,更快更灵活

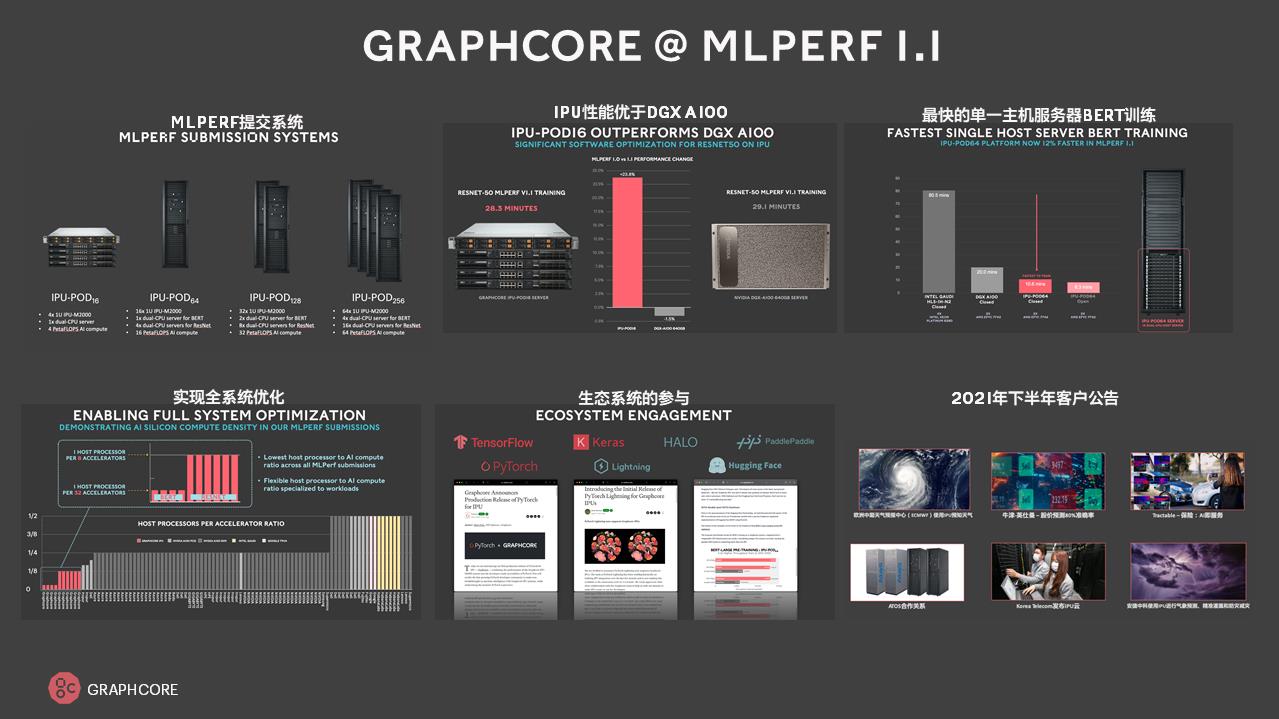

提到 AI 底层芯片,业界首先关注的,就是芯片性能与跑分的数据。Graphcore 全系列的芯片在 2021 年 11 月参加了 MLCommons 的 AI 基准评测 MLPerf 1.1 的训练模型评测,其中 IPU-POD16 在 ResNet 模型测试中,性能超过了 NVIDIA 旗舰的 DGX A100 80G GPU 系统,另外,Graphcore IPU-POD64 也拿下了单一主机服务器下自然语言训练模型 BERT 最快的系统称号。

在 MLPerf 1.1 基准测试中,除了对 ResNet、BERT 等模型的支持,Graphcore 也在探索更多新的计算机视觉模型,如 EfficientNet,还有 2021 年下半年热门的基于 Transformer 的视觉模型 ViT,以及更大的主流 GPT 模型等。

卢涛对 CSDN 分享了,Graphcore IPU 的架构设计中,与 GPU 设计的三大核心差异点。第一,Graphcore IPU 的计算核心有多达 1400 多个处理器内核,每个内核可运行 6 个线程。第二,与 GPU 的存储架构不同的是,IPU 采用处理器片内分布式存储架构,如 Graphcore GC200 拥有 900MB 处理器内存储,而 GPU 采用显存或高宽带显存 HBM,是片外的大型存储。最后,在跨芯片多核通信调度设计上,GPU 是以多核多线程呈现,开发者需要处理不同线程之间的通信与数据同步问题,而 Graphcore IPU 设计了 BSP(Bulk Synchronous Parallel)的软硬件结合算法,让芯片内 1000 多个内核,以及多芯片可以跨 IPU 连接。

与 GPU、CPU 等芯片对比,Graphcore IPU 另一个重要的设计思想,是实现 CPU 与 AI 处理引擎的解耦,依据 AI 的不同场景,灵活和优化配置 CPU 与 IPU 的比例。为此,Graphcore 设计了一系列的系统级优化,例如对于谷歌的 BERT 模型,通常 NVIDIA 或 Intel 都是固定比例的架构,如 CPU 与 GPU 的 1:4 数量比,或 Intel 的 CPU 与 AI 加速引擎的 1:2 数量比。而 CPU 与 Graphcore 的 IPU 可以是 1:32,而基于计算机视觉,比例则又可以是 1:8。

解耦之后更加灵活的底层芯片性能,让 Graphcore 敢于设计并探索更多 AI 的前端场景。2021 年,Graphcore 在已有的、可用于初建或较小的机器学习的 IPU-POD16、IPU-POD64 之后,重磅推出了 IPU-POD128、IPU-POD256 两个可以应用于超大规模、云化的大型超算 AI 集群或计算系统的新品。现在,IPU-POD128、IPU-POD256 两个平台已下柜销售,用户可以直接商用部署。

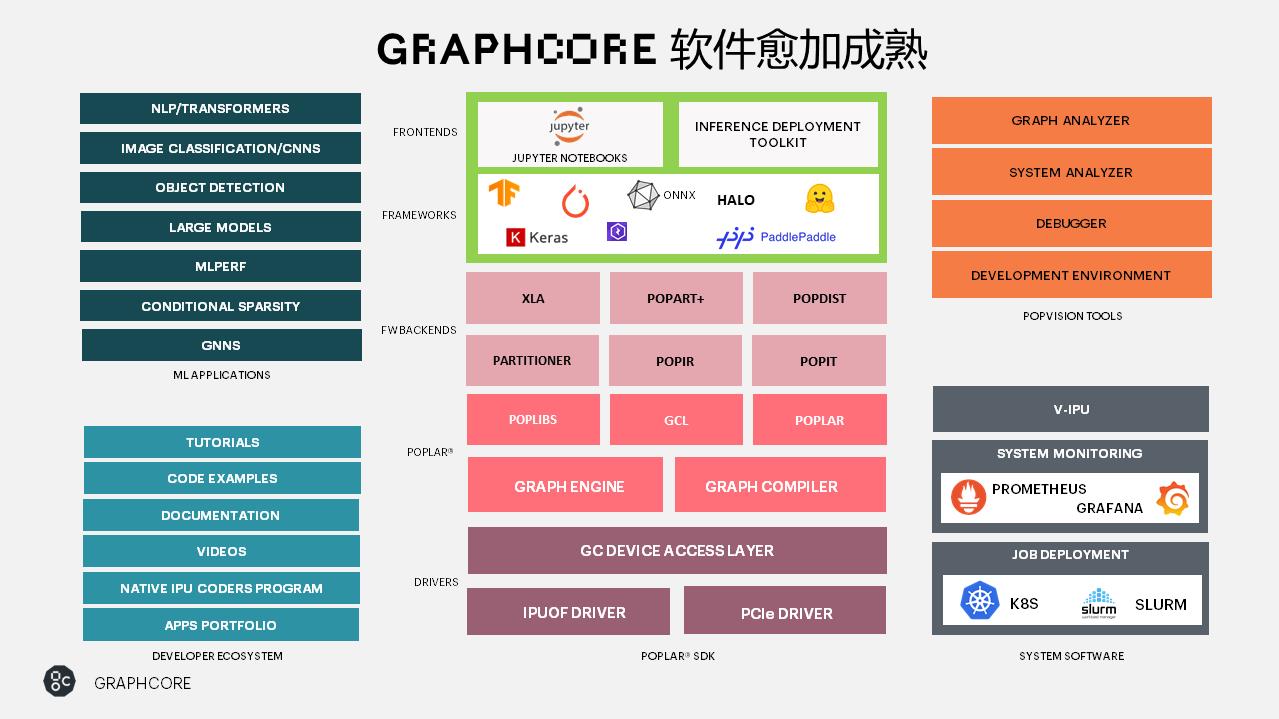

除了硬件之外,Graphcore 也在软件层面持续丰富和完善自身的技术与软件生态。在 Graphcore 的 Poplar SDK 中,在硬件相关的驱动、协议栈,和机器学习框架 XLA、图编译器、PopART 等之外,2021年 Graphcore Poplar SDK 增加了对 PyTorch Lightning、百度飞桨、Hugging Face 的支持,其中百度飞桨在 Graphcore IPU 上已经实现训练与推理的全面支持。此外,对开发工具、硬件管理与 IPU 虚拟化的支持也在增强。

商用市场为核心,拥抱开放的生态

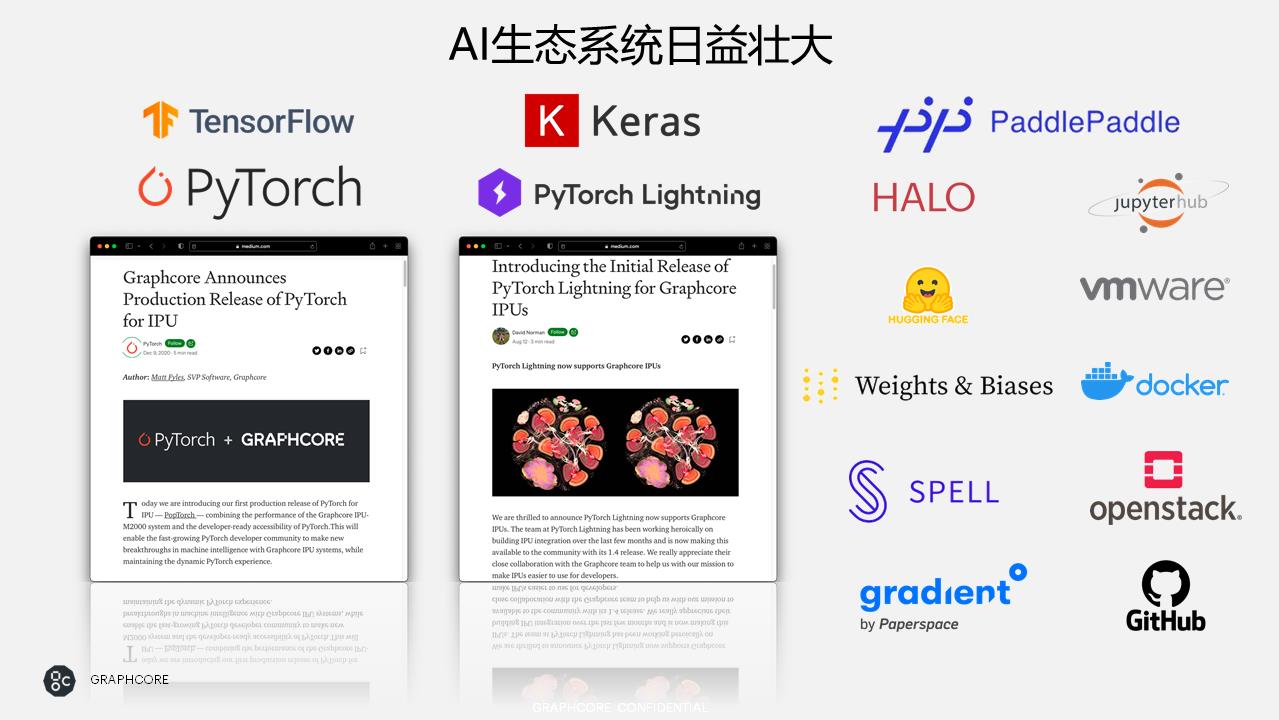

底层芯片之上,丰富的生态一直是芯片厂商重要的目标。在 AI 生态方面,Graphcore 已经与 PyTorch Lightning、百度飞桨、阿里云 HALO、Jupyter Notebook、Hugging Face、Weights & Biases、Spell、Gradient 等成为合作伙伴。

在基础设施层,2021 年 VMware 的 Project Radium 宣布将支持 Graphcore IPU 以作为其硬件分解倡议的一部分,云原生的 Docker、Kubernetes 均支持 IPU,这也可以看出人工智能在关注机器学习框架和模型之后,开始更细致地去改进底层资源的部署与调度,以及任务分配。

服务器 OEM 合作伙伴方面,在戴尔和浪潮之后,Graphcore 在 2021 年新增了 Atos、NEC、Supermicro、2CRSi 4 个服务器合作伙伴。存储方面,2021 年 Graphcore 和国际主流的商用存储设备,如 DDN、Pure Storage、Vast Data、WekaIO 均达成了合作。

卢涛表示,目前,对稳固和性能要求更高的商用市场,是 Graphcore 的核心目标,此外,Graphcore 将最大程度的拥抱开放的生态,并用技术为中国市场服务,实现科技惠民。

Graphcore IPU 的主场,从前沿科学到民生应用

除了产品与生态的建设,卢涛也分享了 Graphcore 在 2021 年最新的案例与应用,遍及前沿科学研究和惠及民生的应用领域。例如 Graphcore 与安捷数科合作,利用 IPU 进行气象预测、精准灌溉、防灾减灾等;与巴黎大学在宇宙学应用方面合作;与深势科技合作完成分子动力学模拟软件 DeePMD-kit 向 IPU 硬件的迁移,探索基于分子动力学模拟的科学计算、药物设计、材料设计和新型能源等场景。

在金融保险方面,牛津-英仕曼使用 Graphcore IPU 进行股价预测;Tractable 利用 IPU 进行 AI 保险理赔方面的辅助工作。在电信领域,Graphcore 与韩国电信合作发布了 IPU 云。关于城市环境可持续发展,Graphcore 和升哲科技基于 IPU 进行城市相关可持续发展应用。在医疗、生命科学领域,Graphcore 和斯坦福大学医学院合作,使用 IPU以“医疗+隐私计算”为核心方向进行了相关的研究和探索。

卢涛透露,2022 年,除了新的硬件产品发布计划之外,Graphcore 将与国内公有云厂商合作发布 IPU 产品。AI 应用领域的研究也将会进一步加深,例如 AI 辅助科研、自动驾驶等。

卢涛和 Graphcore 深知,Graphcore 一直被冠以 AI 芯片领域的新入局者,不过,在 2022 年和更远的未来,Graphcore 希望转变这一认知,在性能、创新、TCO、软件易用性多个维度建立市场领导力。

从挑战者到领导者,Graphcore 还有哪些转变,我们拭目以待。

以上是关于GPU还是IPU?IPU 芯片厂商 Graphcore 的 2021的主要内容,如果未能解决你的问题,请参考以下文章