spark 与 Hadoop 融合后启动 slf4j提示Class path contains multiple SLF4J bindings

Posted Hello_BeautifulWorld

tags:

篇首语:本文由小常识网(cha138.com)小编为大家整理,主要介绍了spark 与 Hadoop 融合后启动 slf4j提示Class path contains multiple SLF4J bindings相关的知识,希望对你有一定的参考价值。

相关参考文献:

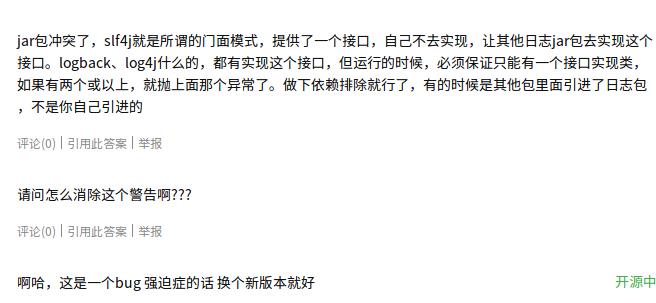

https://www.oschina.net/question/93435_174549

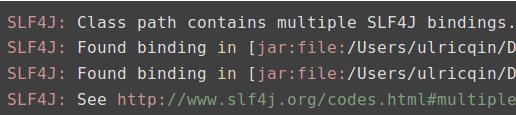

警告信息如下:

看起来明明就是一个文件,怎么还提示multiple bindings呢,slf4j这货一直没用明白,求解

其它参考文献:

http://www.slf4j.org/news.html

August 19th, 2011 - Release of SLF4J 1.6.2

本文解决方法:

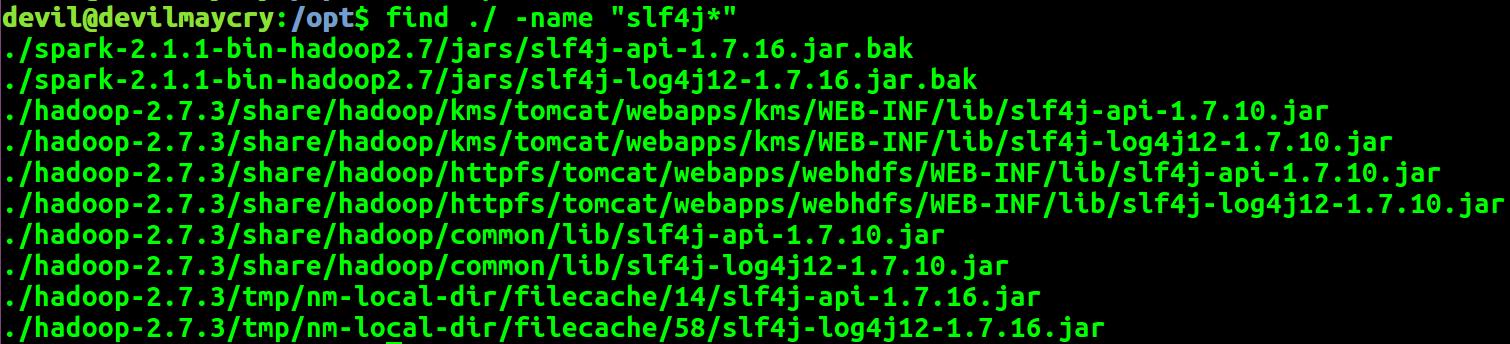

find ./ -name "slf4j*"

分别找出 hadoop 和 spark 下 SLF4J 位置。

将 SPARK 下的 SLF4J 改名, 加后缀 .bak

以上是关于spark 与 Hadoop 融合后启动 slf4j提示Class path contains multiple SLF4J bindings的主要内容,如果未能解决你的问题,请参考以下文章

spark启动后出现“JAVA_HOME not set” 异常和"org.apache.hadoop.security.AccessControlException"异常