windows配置spark开发环境

Posted 小狐白白

tags:

篇首语:本文由小常识网(cha138.com)小编为大家整理,主要介绍了windows配置spark开发环境相关的知识,希望对你有一定的参考价值。

声明:搭建过程中,会因为版本兼容问题,造成闪退等问题,以下是我自用的版本,如需其他版本,最好先查一下兼容问题

1.jdk-8u333-windows-x64下载链接

2.scala-2.13.10下载链接

3.hadoop-3.2.2下载链接

4.spark-3.0.3-bin-hadoop3.2下载链接

开始搭建

1、安装jdk,这个不会安装的自己找个资料看一下,需要说明一下,jdk安装最好不要放在有空格的文件夹下,这样会导致hadoop启动,读不到这个jdk地址,如果你已经安装了,也没有必要卸载,可以交大家一个方法:

我的jdk安装路径:

C:\\Program Files\\Java\\jdk1.8.0_333

配置环境变量改为:

C:\\PROGRA~1\\Java\\jdk1.8.0_333

2、安装scala,这个正常安装即可

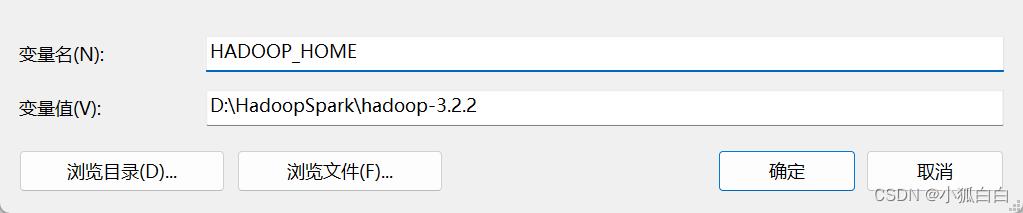

3、安装hadoop:解压安装包到你存放的位置,同样要求避免出现路径中出现空格,配置环境变量,在Path变量下新建%HADOOP_HOME%\\bin

4、安装spark,解压安装包到你存放的位置,同样要求避免出现路径中出现空格,配置环境变量,在Path变量下新建%SPARK_HOME%\\bin

5、在https://github.com/cdarlint/winutils对应版本的bin目录下载hadoop.dll和winutils.exe,复制到hadoop目录的bin目录下

6、启动测试,cmd依次执行以下指令:

java -version

scala -version

hadoop version

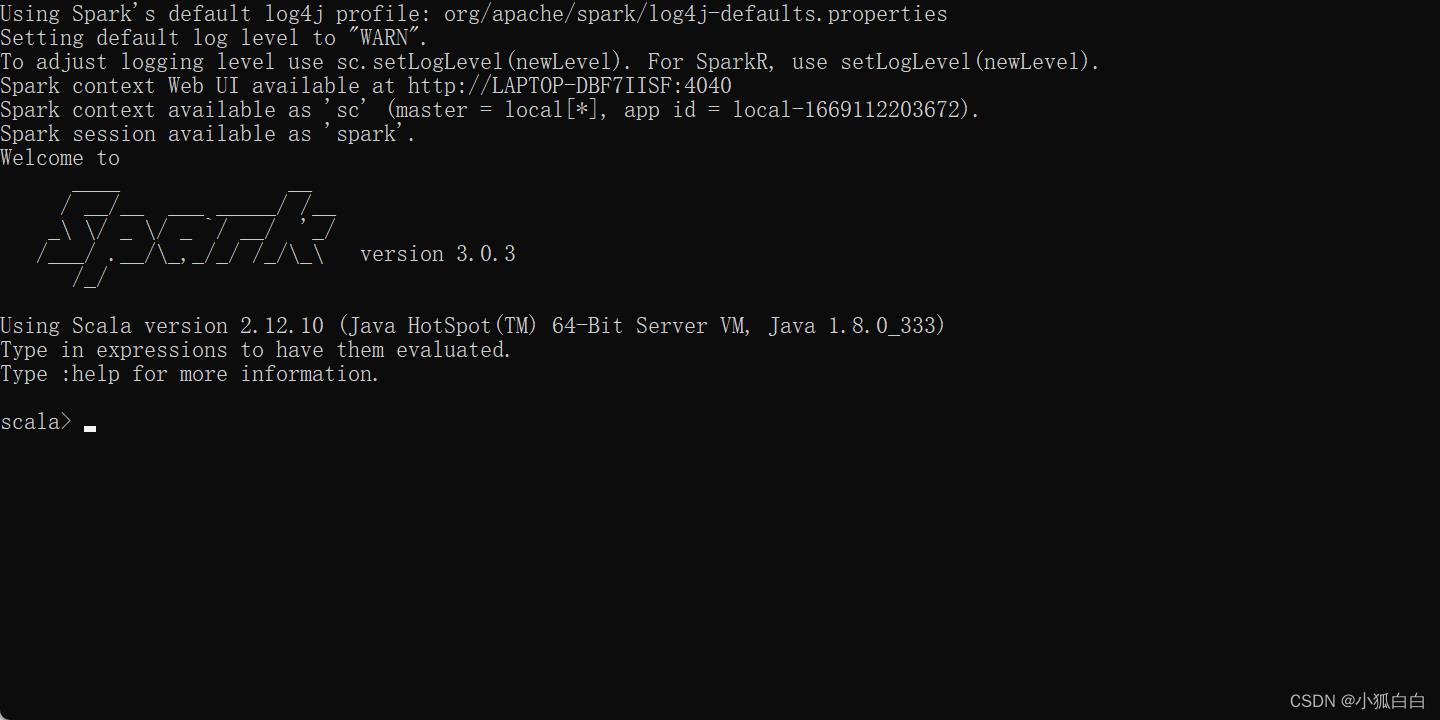

都能查看到环境信息,在spark安装目录下双击spark-shell.cmd,个别出现闪退,需要以管理员身份执行,出现以下信息,安装成功

以上是关于windows配置spark开发环境的主要内容,如果未能解决你的问题,请参考以下文章