趣味实践自动补帧算法——RIFE的使用

Posted zstar-_

tags:

篇首语:本文由小常识网(cha138.com)小编为大家整理,主要介绍了趣味实践自动补帧算法——RIFE的使用相关的知识,希望对你有一定的参考价值。

前言

视频制作者往往对于高帧率的视频画面有所追求,因为更高帧率的画面意味着在相同时间内能够播放更多帧画面,意味着视频观感更为流畅。

本篇就来尝试一个开源的自动补帧算法——RIFE。

论文标题:RIFE: Real-Time Intermediate Flow Estimation for Video Frame Interpolation

论文地址:https://arxiv.org/pdf/2011.06294v5.pdf

论文中文翻译:https://blog.csdn.net/superbinlovemiaomi/article/details/121305931

开源代码:https://github.com/megvii-research/ECCV2022-RIFE

RIFE简介

RIFE是由北大和Megvii Inc的研究人员于2020年发表在ArXiv上的视频插帧算法,之后发表在ECCV2022。

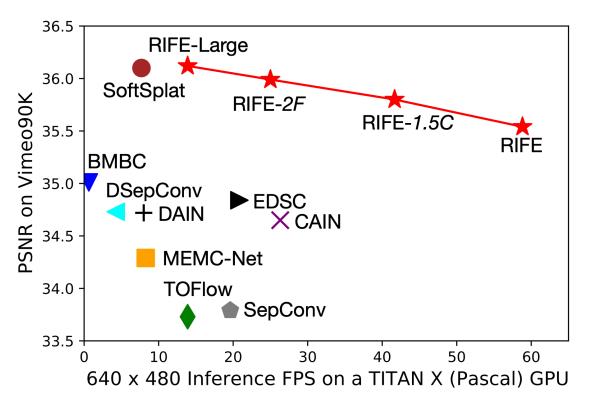

在论文的开篇,作者就放了一张RIFE和其他补帧算法的效果比较图,纵坐标是PSNR(峰值信噪比),从下图中可以看到,在不同帧率下,RIFE均取得了较好的效果。

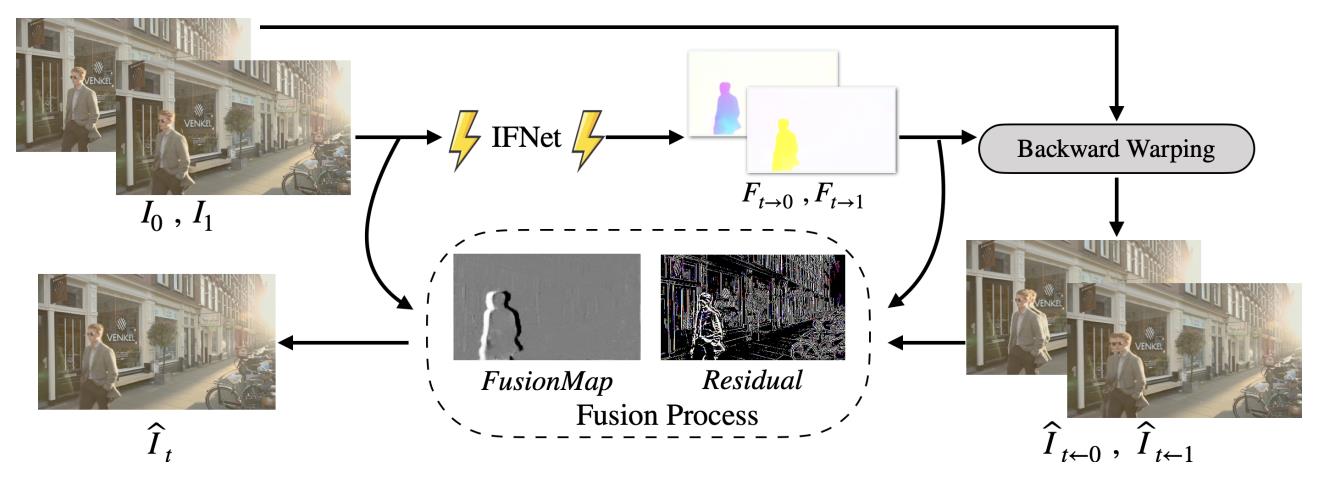

RIFE的大致结构如下图所示:

输入两张相邻帧的图片到IFNet中,输出近似中间流(approximate intermediate flows)(类似光流法),然后和第一帧的图片一起进行后向变形(Backward Warping),得到两张预测图片,最后和第二帧的图片,一起经过一个融合过程(Fusion Process),最终输出中间帧(第一帧和第二帧之间)的预测图片。

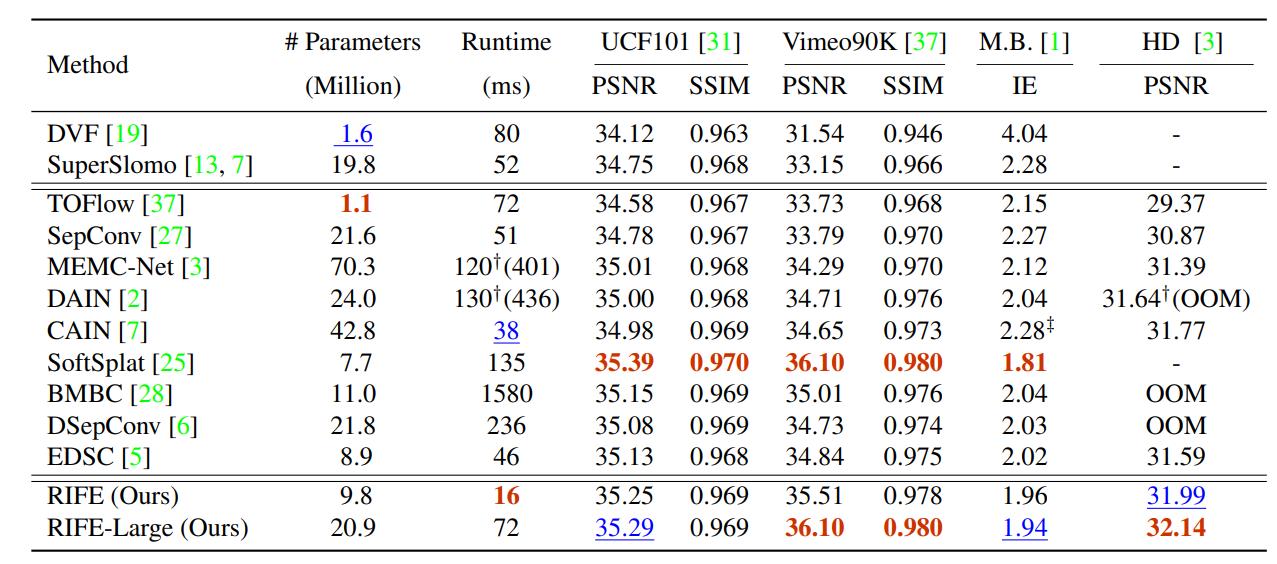

论文最后,作者给出了各算法详细的数据比较和可视化比较结果,可以看到RIFE基本处于领先地位,而且它在模型复杂度上也比其它模型要好很多。

更多具体细节不仔细研究了,需要进一步了解可以看原论文。

RIFE实践

下面就到快乐的实践环节,基于RIFE的应用有很多,为了开发便利,这里直接运行官方开源的Github版本。

克隆代码,配置环境不做细述。

配置好环境后,需要下载官方提供的模型,放置在train_log目录下。

之后,终端输入:

python inference_video.py --exp=1 --video=video.mp4

这里的exp是一个帧率倍数,exp=1表示将视频帧率修复为原来的2倍;exp=2表示将视频帧率修复为原来的4倍(

2

2

2^2

22),以此类推。

video为视频路径。

稍等片刻,即可在输入视频的路径下得到新生成的视频。

效果演示

我这里用好友绘制的低帧素材进行测试。

原视频:https://www.bilibili.com/video/BV1Rt4y1L7Rb

AI补帧:RIFE效果演示

注:由于B站限制最高只能到60帧,因此96fps和192fps看不出差别。

视频中将RIFE的效果和PR自带的帧采样,光流法,帧混合效果进行对比,这三种补帧方式简介如下:

- 帧采样:在调整视频的播放速度之后,多出来的帧或空缺的帧按现有前后帧来生成。也就是复制前后帧。

- 光流法:软件根据上下帧来推断像素移动的轨迹,自动生成新的空缺帧。有点类似于运动模糊计算方法。

- 帧混合:混合上下两帧合并生成一个新的帧来填补空缺。

整体看下来RIFE补帧效果还是可以的,不过视频里存在一个小Bug:人物的左侧衣襟会“瞬移”到右侧,这主要是由于RIFE运用到了前后两帧的信息,两侧衣襟过于靠近且相似,造成了程序的误判。

附录:PR设置滑动变化效果

上面的演示视频中的滑动对比效果制作方式也简单记录下。

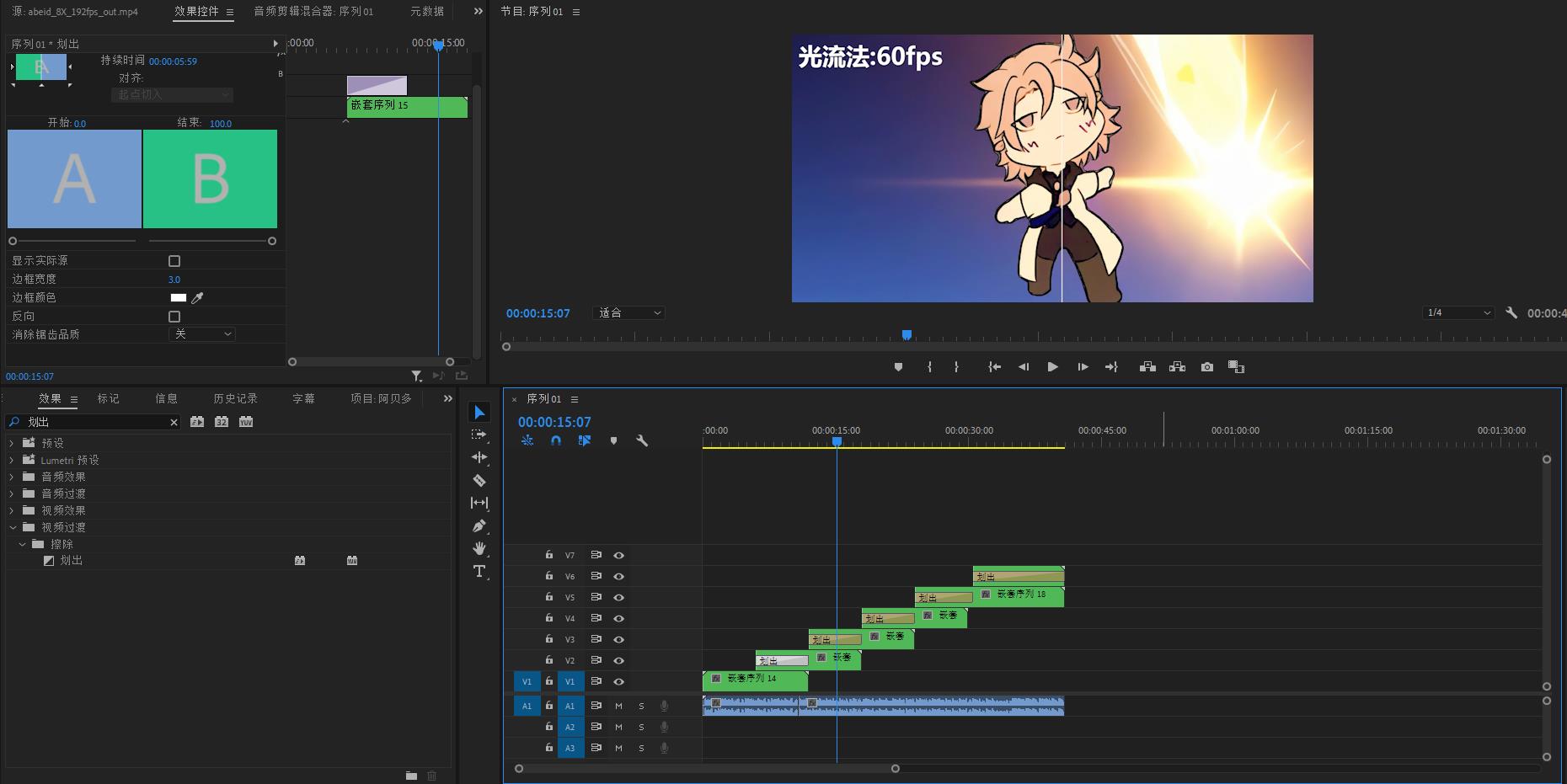

滑动效果核心是PR自带的视频过渡中的“划出”效果。

首先需要将素材按照下面时间轴的方式进行排布,滑动过程中需要两段素材有重叠。

然后将每一段字幕和素材进行嵌套:

最后添加划出效果,设置划出线条的颜色和粗细,拖动划出时间条如下图所示:

代码备份

RIFE源代码和模型文件备份如下:

https://pan.baidu.com/s/1gmN_5K6Re324AyZIGMQLmA?pwd=8888

以上是关于趣味实践自动补帧算法——RIFE的使用的主要内容,如果未能解决你的问题,请参考以下文章