美军飞行员大战人工智能,重要的却并不是输赢

Posted 新浪军事

tags:

篇首语:本文由小常识网(cha138.com)小编为大家整理,主要介绍了美军飞行员大战人工智能,重要的却并不是输赢相关的知识,希望对你有一定的参考价值。

新浪军事

关注

温馨提醒

解锁屏幕旋转,横屏看大图,效果更佳!

伴着音乐,一起欣赏本期《校场》吧!

文末更有彩蛋来袭!

8月7日,美国国防部高级防卫研究计划局(DARPA)宣布,其将在8月18日至20日举办三场名为AlphaDogfight(阿尔法狗斗)的比赛。届时,由8个团队分别研发的AI算法将在空战模拟机上进行对抗,决出优胜者,并最终与美军现役的F-16战斗机飞行员进行模拟空战较量。如果这次对抗比赛取得成功,将标志着空战型人工智能的发展迈上了一个新的台阶。人工智能型无人机的出现或已不再遥远。

自2016年,Google下属人工智能公司DeepMind出品的AlphaGo以4:1的比分战胜了韩国职业棋手李世石后,“人工智能”一词就在一夜之间热了起来。一年之后,AlphaGo又以3:0的总比分大胜世界排名第一的人类棋手柯洁。这也标志着在围棋领域,人类已经不是人工智能的对手了。这些里程碑事件在经过了媒体疯狂的炒作后,不免给人留下了一种“人工智能马上就要超过人类”的错觉。

其实,电脑在游戏中胜过人类哪怕放到2016年都算不上什么新鲜事,比如在2006年浪潮集团就组织了一场名为“浪潮杯”的中国象棋人机比赛。当时一台名为浪潮天梭的超级计算机同时迎战并战胜了5位中国象棋特级大师。有趣的是,这个浪潮天梭甚至连人工智能都算不上,只是凭借着超强的算力把这5位特大给“穷举”输了。时至今日,随便一个“算力拔群”的付费软件就能杀得中国象棋第一人王天一处处掣肘(反而学习型AI可能还打不过王天一,笑)。

说到这里,可能会有人问:那为啥象棋这事就没那么大轰动,围棋就可以呢?其实象棋和围棋两者的差异主要在于一个棋子越下越少,一个棋子越下越多,计算机的计算量有着几何倍数的差别。象棋不需要多么高深的算法,只要穷举就能穷举出先手必胜的下法,围棋却不行,所以只能用AI算法。但如果不谈两者的差别,围棋也不过只是一个在19x19的棋盘上,按照死板的规则玩的游戏。AI本身不需要有多复杂,只要自我学习的够多,肯定算的比人快。因此,在AlphaGo战胜李世石后,马上就有一种论调表示“你让人工智能来玩电竞游戏试试”。

为此DeepMind的团队在2016年宣布要设计一种用来“打电竞”的人工智能。这就是后来的AlphaStar。但自2019年1月公开面世以来,AlphaStar就一直表现的不尽如人意。在2019年1月的比赛中,AlphaStar的开发团队先是神神叨叨的放了10盘不对AI设限的Replay(游戏录象),把AlphaStar狂吹一顿,又表示这次挑战人类要为AlphaStar设下“每分钟操作次数(APM)”和“不能使用全局视野(就是和人类一样,只能同时获得显示器那么大的区域内的信息)”等限制条件。结果在实际对战中却毫无悬念的败给了人类电竞选手MaNa。

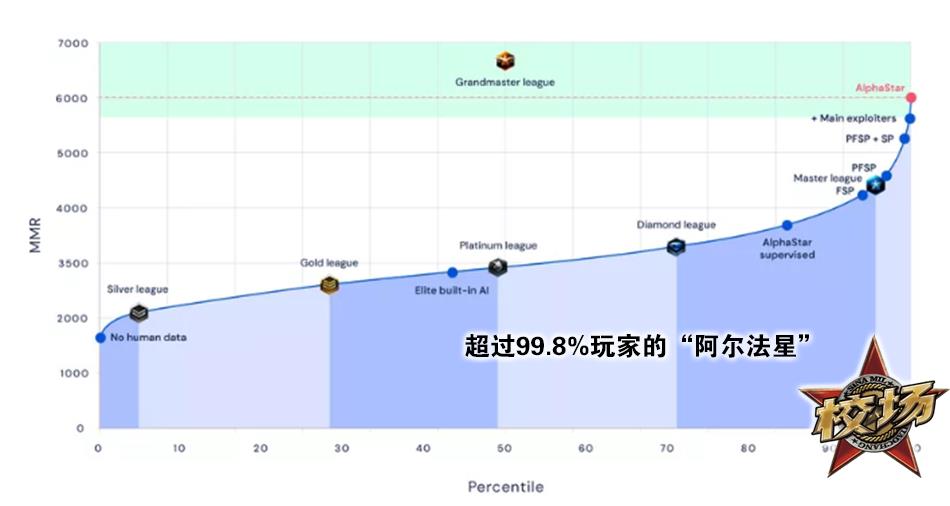

后来,随着人类选手对AlphaStar的了解越来越多,AlphaStar也越来越“吃瘪”。虽然DeepMind在2019年11月宣布AlphaStar已经打到了“大师”等级,胜过了99.8%的人类玩家。但基本是人都看得出来AlphaStar之所以能赢,靠的纯粹是精准的操作,而非对电子竞技游戏的战术理解。事实上,AlphaStar对电竞游戏的战术压根就没什么理解,十分死板。甚至有人觉得如果让其恢复到Human-Level(通过识别图像获取信息,通过鼠标键盘进行操作),它可能打不过游戏自带的电脑对手。

换句话说,以现在的技术,让学习型人工智能理解什么叫做“战术”还为时尚早。说到这里,我们终于能引入今天的主题了——如果学习型AI连电子游戏中的战术都理解不了、连穷举型AI都打不过,那还怎么让他去理解空战中更加复杂、更加诡谲多变的战术?

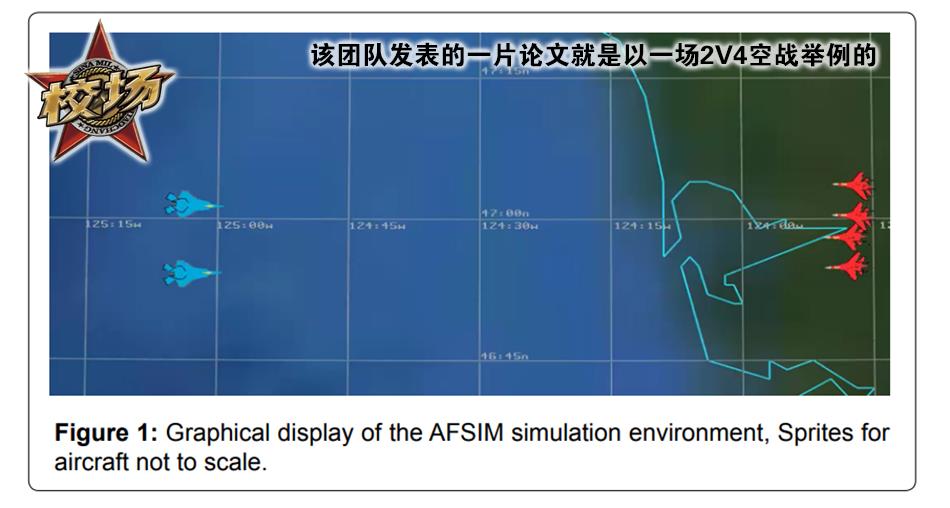

战斗机“人机大战”严格意义上来说也已经不算什么“新话题”了,早在2016年就有军方的人工智能团队放出过在战斗机人工智能(Alpha)的开发过程中,Alpha与人类飞行员进行空战对抗并取得了胜利的消息。只不过当时对抗的目的与现在有所区别,更像是为了开发AI而进行的。当时人类一方拥有预警指挥机和更多的导弹,但AI飞机的数量却远比人类更多。

安排这场战斗机“人机大战”的DARPA也深知目前学习型AI的局限性,因此也为这场“人机大战”中的人类飞行员设下了种种限制,比如只有1v1空战没有多机协同、只涉及狗斗不涉及其他战术性更强的对抗等等。同时,DARPA的目的也并不是要在人类飞行员和学习型AI中决出一个高低,而是要检验AI空战算法的有效性,同时试图通过对抗比赛让AI算法获得人类飞行员的“尊重”,进而实现人机协作的中远期目标。

相比于1v1、2v2自由空战,1v1狗斗对战术的要求很少,经过长时间的摸索,基本每一种敌我态势都可以对应少数几种“最优解”。换句话说,这次“人机大战”考验的就是学习型AI能否通过对敌我态势的把握,迅速且精准的作出最优的动作。虽然这听起来很容易,但实现起来却并不简单,毕竟天空没有棋盘……

不过即使是这种简单的“应激反应”,也已经算得上具有里程碑意义了。因为人不可能不犯错,而AI算法只要可靠性足够,确实可以做到不犯错。这意味着,如果我们能够开发出可靠的AI算法,就算他一时半会理解不了什么战略战术,也可以在类似的需要“应激反应”的场合帮助人类飞行员控制飞机;或者是作为“忠诚僚机”辅助有人驾驶战机执行任务。

举例来说,2018年1月7日,也门胡塞武装使用一枚改进型R-27T导弹击落了一架沙特F-15战斗机。一般而言,红外导弹在距离飞机较近处发射时,正确的处置方式应该是抛弃副油箱减轻飞机重量增强飞机机动性,齐射热焰弹干扰导弹导引头同时进行大过载机动甩脱导弹导引头的锁定范围。但当时沙特飞行员急中出错,没有抛弃副油箱,仅以单发模式抛射热焰弹,并同时开启了加力逃逸。这一错误处置方式令飞机机动性大打折扣,同时飞机加力尾焰的信号特征还要远大于单发热焰弹,导弹的导引头并没有被成功干扰,始终牢牢锁定着飞机。反之,如果这架F15搭载了一款高可靠性的AI,很可能就可以骗过导弹安全返航。

其实除了“不会犯错”以外,很多人对空战型AI还有着“超越人体极限”的期待。众所周知,人的抗过载能力是有极限的,但是搭载AI的芯片却基本不会受过载的制约。因此很多人认为人工智能型无人战斗机不会有过载限制,空战能力的上限远强于有人作战飞机。但这种说法其实并不准确,目前战斗机过载能力的最大瓶颈在于机体结构强度和能量补充能力。比如,美军F-14战斗机的最大过载限制不过7.4G,远低于飞行员的抗过载极限,早期F-15A战斗机在正常空战载荷下的过载限制为8.5G,同样低于飞行员的过载极限,历史上也曾经出现过F-22不小心拉了11G,飞行员没啥事飞机却报废了的情况。

同时,飞机长时间高过载势必会消耗巨量的能量,如果飞机的剩余能量(SEP)不足,飞机很快就会因为掉高掉速而失去继续维持高过载的能力。而现在还没有任何一种战术飞机能够长时间维持8~9G的超高过载。换句话说,就算AI的抗过载能力强于人类飞行员,在可预见的未来,人工智能型战斗机的机动性也未必能够显著强于有人战斗机。

不过,正如AlphaGo出现之前没有人愿意相信人工智能居然能在下棋方面碾压人类一样,我们今天对于空战型人工智能的认识同样有诸多局限。但不可否认的是学习型AI确实已经成为了未来战斗机的重要发展方向,在世界主要航空强国都已经把AI技术、忠诚僚机概念纳入下一代战斗机发展方向的当口,我们也没有理由不好好把握这一机遇。

《校场》可以投稿了!

E-mail: mil@vip.sina.com

邮件主题烦请标明:《校场》投稿,期待中……

未来充满着智能化,智能也同时伴随着风险,但人定胜天!

今日彩蛋

新浪军事

球分享

球点赞

球在看

以上是关于美军飞行员大战人工智能,重要的却并不是输赢的主要内容,如果未能解决你的问题,请参考以下文章