玩电子游戏的神经网络,告诉我们大脑是如何决策的

Posted 人工智能学家

tags:

篇首语:本文由小常识网(cha138.com)小编为大家整理,主要介绍了玩电子游戏的神经网络,告诉我们大脑是如何决策的相关的知识,希望对你有一定的参考价值。

当你开车的时候,你的大脑会接收大量的视觉信息,并用它来做出驾驶的决定,比如什么时候刹车或者换车道。大脑需要决定在你的视野中哪些信息是做出这些决定所必需的。例如,另一辆车的位置是非常重要的,但是天空中的云彩或者那辆车的颜色并不会对你的驾驶方式产生影响。

这是在复杂的自然环境中做决定的日常例子。在面临大量感官数据和需要迅速做出决定的情况下,大脑会做什么?为了研究这个和相关的问题,研究人员可以使用我们日常生活中的模拟进行实验: 电子游戏。

加利福尼亚理工学院的一项新研究将玩Atari经典游戏的人脑扫描图像与玩相同游戏的复杂人工智能(AI)网络进行了对比。研究人员将受过训练的人工智能的行为与人类的行为进行了比较,发现人工智能中人工“神经元”的活动与人类大脑的活动十分相似。这意味着,人工智能代理可能以类似于人类大脑的方式进行类似的决策,使其成为一个很好的模型,研究人类大脑如何将高维视觉输入映射到复杂环境中的行动与决策中。

这项研究是在心理学教授 John o’ doherty 的实验室里进行的。一篇描述这项研究的论文发表在12月15日的《Neuron》杂志上。这篇论文的题目是“使用深强化学习来揭示大脑如何在高维环境中编码抽象的状态空间表征”

“人工智能和神经科学之间的互动是双向的,” o’ doherty 说。“如果我们能够发现人工智能算法与大脑有多么相似,这将帮助我们更好地理解大脑是如何解决这类难题的。相反的,如果我们能够理解大脑为什么以及如何比人工智能更有效地解决这些问题,这可能有助于指导未来更智能、更像人工智能算法的发展。”

在决策神经科学领域,许多研究使用简单的任务来检验人类是如何做决定的。例如,一个研究参与者可能被要求玩两个有不同奖金的老虎机。在实验过程中,参与者将了解哪种老虎机赚的钱更多,并相应地调整自己的行为。解决这些任务的一般学习框架被称为强化学习框架,因为决策带来的奖励结果强化了行为。

然而,强化学习框架本身并不能充分描述在更大和更复杂的任务中的决策。2015年,谷歌(Google)旗下的人工智能公司 DeepMind 开发了一种复杂的人工智能算法,称为“深度 Q网络”(Deep q Network,DQN) ,它可以学会玩几十款Atari视频游戏,达到人类或超人级的水平。

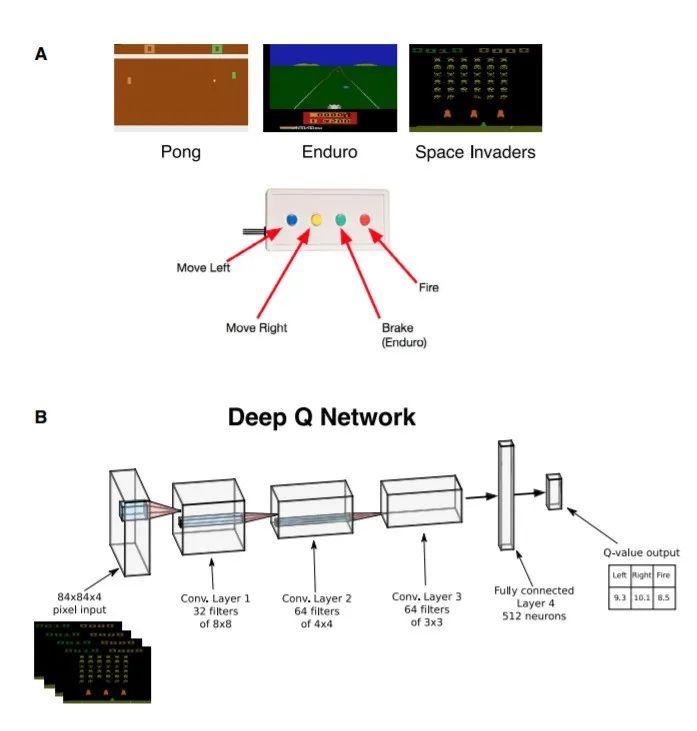

深度Q网络用于Arari游戏的示意图

该技术结合了经典的强化学习框架和最近的另一个新进展-卷积神经网络。卷积神经网络作为一个感知系统,学会在 Atari 像素空间(游戏屏幕)中检测视觉特征,这些特征可以预测奖励(得分)。这使 DQN 能够通过观察游戏中的像素来了解在给定的情况下应该采取哪些动作。重要的是,游戏规则并没有编入 DQN 代理程序; 它必须自己学习如何通过尝试和错误进行游戏,因为当代理程序得分(以及导致得分的行动)时,正确的决定会得到积极的加强。

在这项研究中,DQN 被训练玩 Atari 公司的视频游戏 Pong、 Space Invaders 和 Enduro (一款赛车游戏) ,然后它的人工神经元被用于预测行为和大脑活动,这些行为和大脑活动来自玩游戏的人类参与者的功能性磁共振成像脑部扫描进行对比。研究人员发现,大脑中涉及知觉和视觉的两个区域---- 背测视觉通路(dorsal visual pathway)和后顶叶皮层(posterior parietal cortex)的大脑活动可以用 DQN 特征来模拟。

从人脑神经编码模型分析的可视化过程。

在所有的游戏中,DQN 必须学会如何像人一样从大量的视觉输入中挑选出相关的特征。它必须将相关信息形式化的放置在状态空间中,这是一种紧凑地表示当前游戏状态中正在发生事情的方式。例如,在 Pong 中,研究人员发现 DQN 代码中的状态空间代表了球和球拍的空间位置; 它忽略了一些特征,比如背景的颜色和屏幕顶部的游戏分数。这非常类似于人类大脑在背测视觉通路中表征游戏的方式,背测视觉通路是大脑的一部分,负责识别空间中物体的位置,以引导与这些物体相关的动作。

在分布式感觉运动神经网络中,DQN 的隐层与人脑活动有惊人的相似之处,它贯穿整个背侧视觉通路,延伸至后顶叶皮层。神经状态空间表征产生于从像素空间到知觉到行动和奖励的非线性转换。在这些转换中,去除与任务无关的感官特征的信息,以反映相关的高层次特征。该研究结果揭示了在现实世界情境中任务表征的神经编码。

例如:在塞车游戏中,玩家开车越快越好,并尽量避开其他车辆。在驱车的过程中,天空从白天变成了黑夜。玩游戏的人很容易忽略这些参数,因为它们与实际游戏无关,就像我们开车时学会忽略天空中的云一样。但是,人工智能网络必须认识到,天空颜色的变化对驾驶没有影响。

研究人员发现,DQN 会忽略这些不相关的视觉特征的特征,这更好地解释了玩游戏的志愿者后顶叶皮层的大脑活动模式。后顶叶皮层是大脑中连接知觉和运动动作的部分。在太空入侵者中这个游戏中也发现了类似的现象。

虽然研究人员已经发现了 DQN 和人类大脑之间的相似之处,但两者并不完全相同。

“为了学会玩这些游戏,DQN 需要连续玩上几天,但是人类可以在几分钟内学会,”本文作者克罗斯说。“为什么人类的大脑在驾驶汽车时很容易找出相关的特征,而人工智能却很难找到?回答这个问题对人工智能研究人员来说是一个巨大的挑战。这对人工智能来说很难,由于随着背景颜色的改变,它的视觉输入会发生巨大的变化。因为神经网络只是在像素空间中“看到”数字。DQN 需要经过大量的训练,才能了解在像素空间中有显著差异的两种情况实际上在概念上是相似的,即你应该做什么。”

另一方面,克罗斯补充说,人类的大脑在整个发育过程中都在学习为日常工作挑选最重要的信息。“特别是我们感兴趣的主要区域——背测视觉通路,能够快速地独立于物体的颜色来定位物体,”他说。“此外,大脑以某种方式编码物理学的常识概念和物体典型运动方式,这使得人类能够在很少训练的情况下很好地完成各种各样的任务。所有这些都必须由 DQN 从头学习。”

近年来,其他研究已经发现了大脑和深层神经网络之间的相似性,但这些研究大多集中在物体识别,而不是主动决策。这项研究为研究复杂决策任务中的行为和大脑活动提供了一个新的框架,这个框架可能比以前在该领域使用的任务更能代表日常生活。

未来智能实验室的主要工作包括:建立AI智能系统智商评测体系,开展世界人工智能智商评测;开展互联网(城市)云脑研究计划,构建互联网(城市)云脑技术和企业图谱,为提升企业,行业与城市的智能水平服务。

如果您对实验室的研究感兴趣,欢迎加入未来智能实验室线上平台。扫描以下二维码或点击本文左下角“阅读原文”

以上是关于玩电子游戏的神经网络,告诉我们大脑是如何决策的的主要内容,如果未能解决你的问题,请参考以下文章