统计文本挖掘

Posted 我们可不low

tags:

篇首语:本文由小常识网(cha138.com)小编为大家整理,主要介绍了统计文本挖掘相关的知识,希望对你有一定的参考价值。

致歉:由于上一周小编们因事停更一周,给大家带来不便尽请谅解!

文本挖掘——jiebaR包

文本挖掘

在自然语言处理(NLP)技术发达的今天,小编就给大家讲一讲文本挖掘,文本挖掘指的是从文本数据中获取有价值的信息和知识,它是数据挖掘中的一种方法。文本挖掘中最重要最基本的应用是实现文本的分类和聚类,前者是有监督的挖掘算法,后者是无监督的挖掘算法。

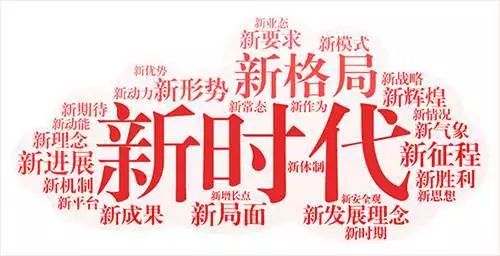

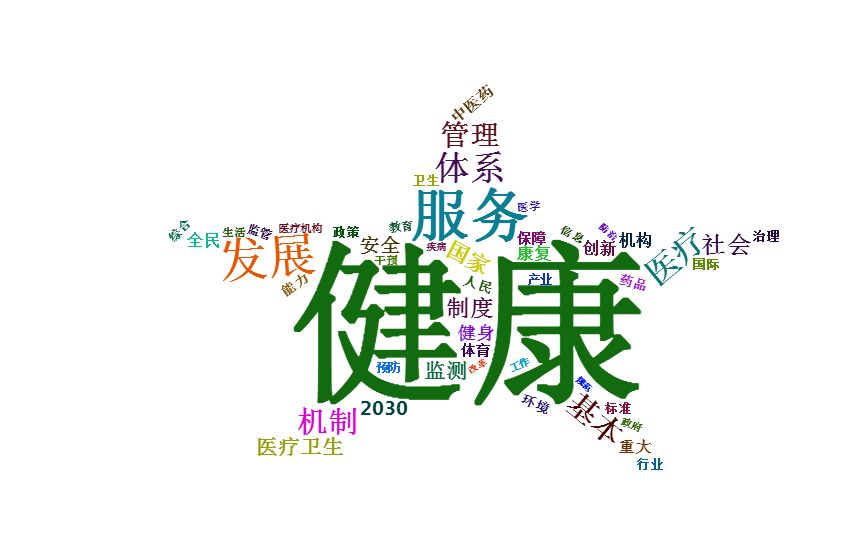

词云

“词云”就是对网络文本中出现频率较高的“关键词”予以视觉上的突出,形成“关键词云层”或“关键词渲染”,从而过滤掉大量的文本信息,使浏览网页者只要一眼扫过文本就可以领略文本的主旨

实战

《“健康中国2030”规划纲要》是卫生领域一个重要的政府文件。挖掘《“健康中国2030”规划纲要》主要思想可以更好地了解中国卫生领域的发展趋势。下面就有小编我利用文本挖掘技术分析此份报告。

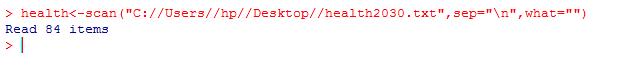

1、 读取文本文件

将健康2030转化为txt格式文件,利用R3.4.3软件读取txt格式文件。

语句:

scan("C://Users//hp//Desktop//health2030.txt",sep=" ",what="")->health

根据文件路径,导入txt文件

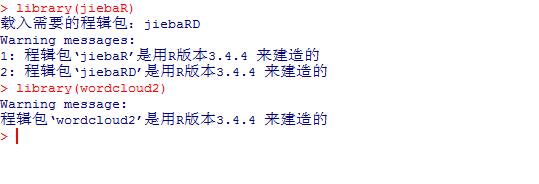

2、 下载安装包

本实例中将应用jiabaR包和wordcloud2包。

语句:

install.packages()

library(jiabaR)

library(wordcloud2)

下载并安装jiabaR包和wordcloud2包

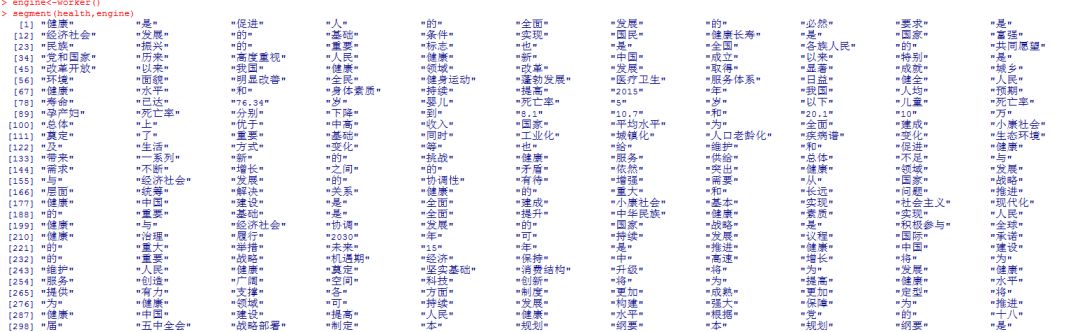

3、导入分词函数

本实例中将应用两个重要的函数,worker()函数和segment()函数。

语句:

engine<-worker()

worker(stop_word="C://Users//hp//Desktop//stop.txt")->engine_s

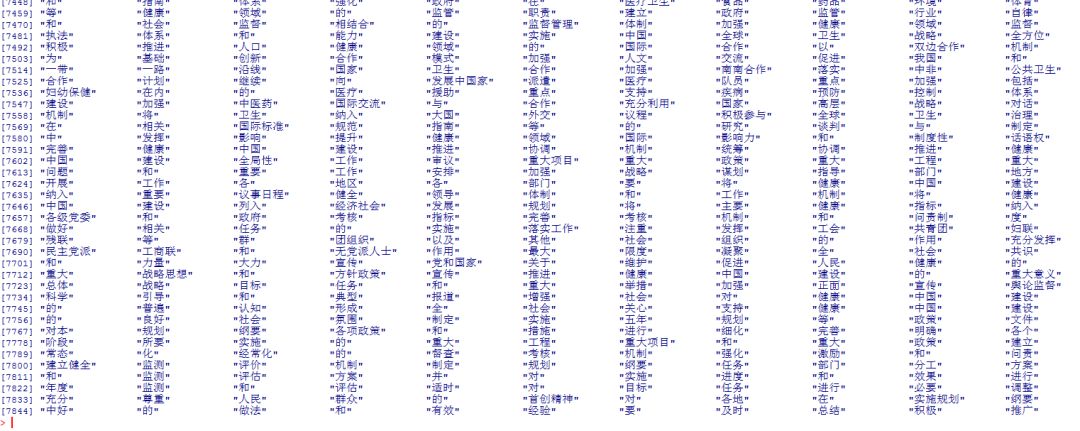

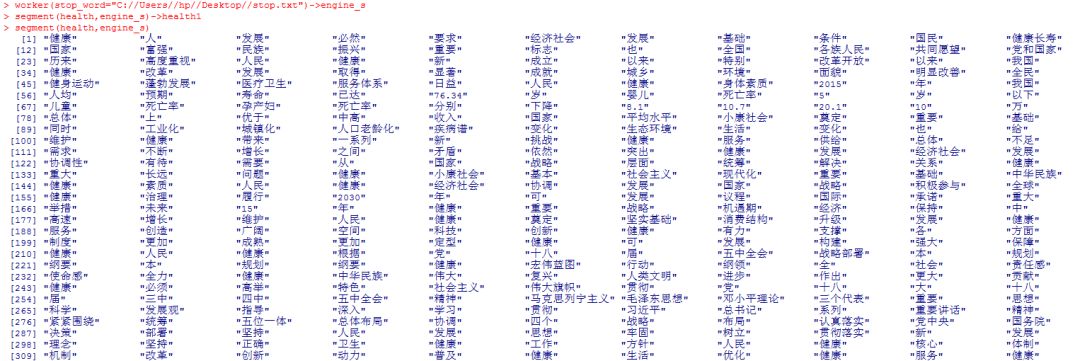

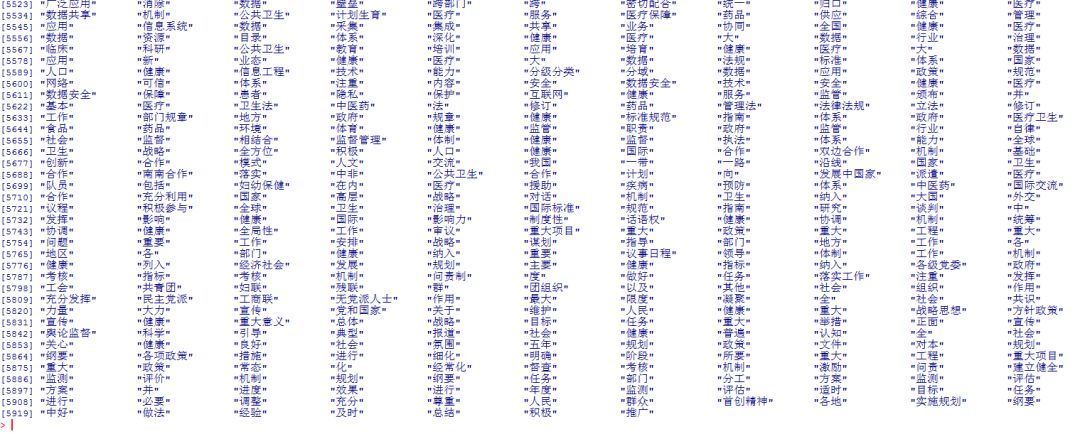

segment(health,engine_s)->health1

删除停用词,对报告进行分词处理

<< 滑动查看下一张图片 >>

4、挑选关键词

语句:

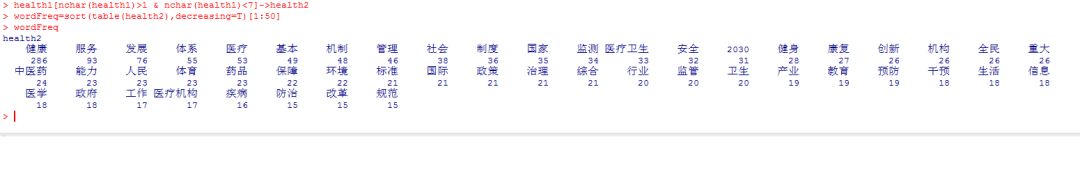

health1[nchar(health1)>1 & nchar(health1)<7]->health2

wordFreq=sort(table(health2),decreasing=T)[1:50]

挑选词条长度在2~6个字之间,出现频率前50个,降序排列

4、制作词云

语句:

wordcloud2(wordFreq,size=1,shape="star")

制作星型词云

重点函数

worker()函数原型:

worker(type = "mix", dict = DICTPATH, user = USERPATH, stop_word = STOPPATH, topn = 5,encoding = "UTF-8")

type

分词引擎类型,包括mix、keyword、tag等

dict

词库路径

user

用户自定义的词库

stop-word

停用词路径

topn

关键词个数

温馨提示

1.R软件和Python都可以进行文本挖掘,R语言中tm包和Rwordseg包也可以进行文本挖掘。

2.在文本挖掘过程中利用worker函数中通过user参数添加词库

3.词库第一行一定要空着

4.自行添加词库,建议使用notepad++编辑,编码设置为UTF-8

5.如需要添加搜狗细胞词库,建议安装cidian包

撰稿:小怪兽

以上是关于统计文本挖掘的主要内容,如果未能解决你的问题,请参考以下文章