大数据HDFS技术干货分享

Posted 机器学习算法与Python学习

tags:

篇首语:本文由小常识网(cha138.com)小编为大家整理,主要介绍了大数据HDFS技术干货分享相关的知识,希望对你有一定的参考价值。

关键字全网搜索最新排名

【机器学习算法】:排名第一

【机器学习】:排名第二

【Python】:排名第三

【算法】:排名第四

1

HDFS前言

设计思想

分而治之:将大文件、大批量文件,分布式存放在大量服务器上,以便于采取分而治之的方式对海量数据进行运算分析;

在大数据系统中作用:

为各类分布式运算框架(如:mapreduce,spark,tez,……)提供数据存储服务

重点概念:

文件切块,副本存放,元数据

重要特性如下:

⑴ HDFS中的文件在物理上是分块存储(block),块的大小可以通过配置参数( dfs.blocksize)来规定,默认大小在hadoop2.x版本中是128M,老版本中是64M

⑵ HDFS文件系统会给客户端提供一个统一的抽象目录树,客户端通过路径来访问文件,形如:hdfs://namenode:port/dir-a/dir-b/dir-c/file.data

⑶ 目录结构及文件分块信息(元数据)的管理由namenode节点承担——namenode是HDFS集群主节点,负责维护整个hdfs文件系统的目录树,以及每一个路径(文件)所对应的block块信息(block的id,及所在的datanode服务器)

⑷ 文件的各个block的存储管理由datanode节点承担---- datanode是HDFS集群从节点,每一个block都可以在多个datanode上存储多个副本(副本数量也可以通过参数设置dfs.replication)

⑸ HDFS是设计成适应一次写入,多次读出的场景,且不支持文件的修改

2

HDFS的shell(命令行客户端)操作

HDFS集群分为两大角色:NameNode、DataNode

NameNode负责管理整个文件系统的元数据

DataNode 负责管理用户的文件数据块

文件会按照固定的大小(blocksize)切成若干块后分布式存储在若干台datanode上

每一个文件块可以有多个副本,并存放在不同的datanode上

Datanode会定期向Namenode汇报自身所保存的文件block信息,而namenode则会负责保持文件的副本数量

HDFS的内部工作机制对客户端保持透明,客户端请求访问HDFS都是通过向namenode申请来进行

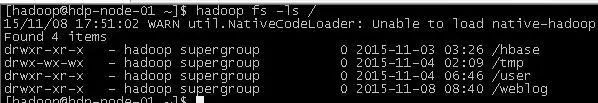

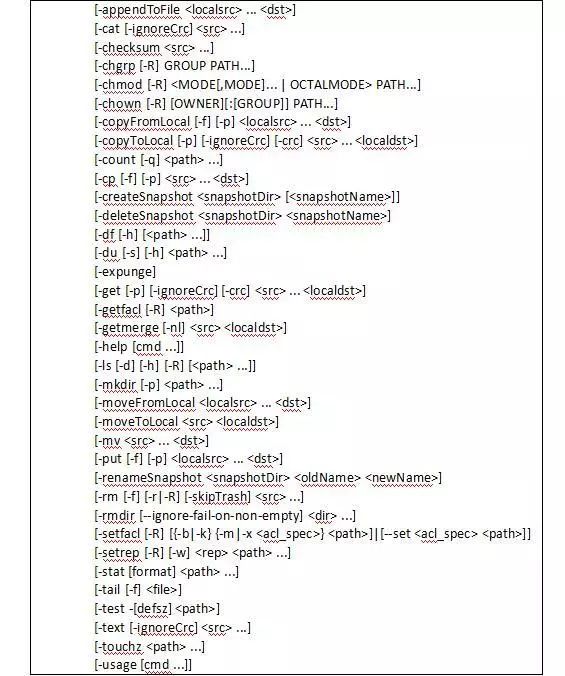

HDFS提供shell命令行客户端,使用方法如下:

3

HDFS写读数据流程

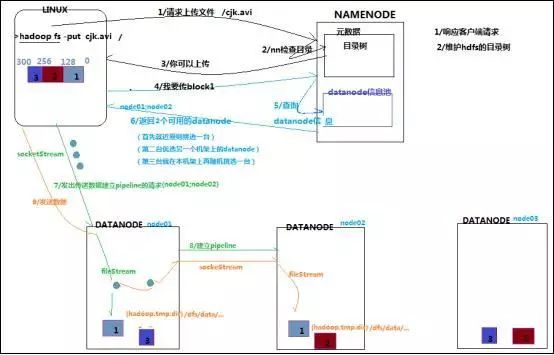

写数据

1

根namenode通信请求上传文件,namenode检查目标文件是否已存在,父目录是否存在

2

namenode返回是否可以上传

3

client请求第一个 block该传输到哪些datanode服务器上

4

namenode返回3个datanode服务器ABC

5

client请求3台dn中的一台A上传数据(本质上是一个RPC调用,建立pipeline),A收到请求会继续调用B,然后B调用C,将真个pipeline建立完成,逐级返回客户端

6

client开始往A上传第一个block(先从磁盘读取数据放到一个本地内存缓存),以packet为单位,A收到一个packet就会传给B,B传给C;A每传一个packet会放入一个应答队列等待应答

7

当一个block传输完成之后,client再次请求namenode上传第二个block的服务器

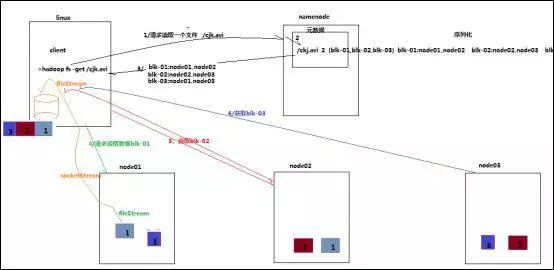

读数据

1

跟namenode通信查询元数据,找到文件块所在的datanode服务器

2

挑选一台datanode(就近原则,然后随机)服务器,请求建立socket流

3

datanode开始发送数据(从磁盘里面读取数据放入流,以packet为单位来做校验)

4

客户端以packet为单位接收,现在本地缓存,然后写入目标文件

HDFS以流式数据访问模式来存储超大文件,运行于商用硬件集群上。

HDFS上的文件也被划分为块大小的多个分块(chunk),作为独立的存储单元。但与其他文件系统不同的是,HDFS中小于一个块大小的文件不会占据整个块的空间。

点击“阅读原文”也可以加入学习交流群哦~

以上是关于大数据HDFS技术干货分享的主要内容,如果未能解决你的问题,请参考以下文章