独家 | 带你认识HDFS和如何创建3个节点HDFS集群(附代码&案例)

Posted 数据派THU

tags:

篇首语:本文由小常识网(cha138.com)小编为大家整理,主要介绍了独家 | 带你认识HDFS和如何创建3个节点HDFS集群(附代码&案例)相关的知识,希望对你有一定的参考价值。

翻译:陈之炎

校对:王威力

本文约1500字,建议阅读5分钟。

在本文中,大数据专家将为您介绍如何使用HDFS以及如何利用HDFS创建HDFS集群节点。

我们将从HDFS、Zookeeper、Hbase和OpenTSDB上的系列博客开始,了解如何利用这些服务设置OpenTSDB集群。在本文中,我们将探究HDFS。

HDFS

Hadoop分布式文件系统(HDFS)是一种基于Java的分布式文件系统,它具有容错性、可伸缩性和易扩展性等优点,它可在商用硬件上运行,也可以在低成本的硬件上进行部署。HDFS是一个分布式存储的Hadoop应用程序,它提供了更易访问数据的接口。

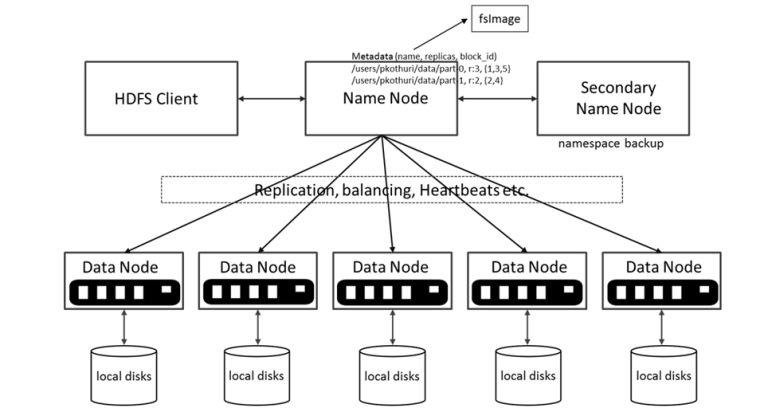

架构

HDFS架构包含一个NameNode、DataNode和备用NameNode。

HDFS具有主/从架构。

NameNode:HDFS集群包含单个NameNode(主服务器),它管理文件系统命名空间并控制客户端对文件的访问权限。它维护和管理文件系统元数据;例如由哪些块构成文件,以及存储这些块的数据节点。

DataNode:可以有多个DataNode,通常是集群中每个节点有一个DataNode,它负责管理运行节点的存储访问。HDFS中的DataNode存储实际数据,可以添加更多的DataNode来增加可用空间。

备用NameNode :备用NameNode服务并非真正的备用NameNode,尽管名称是称为备用NameNode。具体来说,它并不为NameNode提供高可用性(HA)。

为什么需要备用NameNode?

备用NameNode记录文件系统的修改痕迹,追加到本机文件系统文件的后面,作为修改日志。

启动备用NameNode时,它会从映像文件fsimage中读取HDFS状态,然后启用“编辑日志文件”对它进行编辑。

然后将新的HDFS状态写入fsimage,并使用“空编辑文件”启动正常操作。

由于NameNode只在启动时合并fsimage和编辑文件,所以在繁忙的集群中,随着时间的推移,“编辑日志文件”会变得非常大。

大“编辑日志文件”的另一个副作用是:在下次重新启动NameNode时,需要花费更长的时间。

备用NameNode定期合并fsimage和“编辑日志文件”,并将“编辑日志文件”的大小保持在限定范围内。

备用NameNode通常在与主NameNode不同的计算机上运行,因为它的内存要求与主NameNode的相同。

关键特征

容错:为了防止机器故障,可跨多个DataNode复制容错数据,复制因子的默认值是3(如果有3个DataNode,每个块至少存储在三台计算机上)。

可伸缩性- DataNode之间可实现直接数据传输,所以读/写次数应与DataNode的数量相匹配。

空间-需要更多的磁盘空间?只需添加更多DataNodes和再平衡。

行业标准-其他分布式应用程序均构建在HDFS之上(HBASE,Map-Reduction)。

HDFS是用来处理大数据集的,它具有write-once-read-many(一次写-多次读)的语义,不适合低延迟访问。

数据结构

写入HDFS的每个文件被分割为64MB或128MB大小的数据块。

每个块存储在一个或多个节点上。

块的每个副本均称为副本。

分块安置策略

第一副本放在本地节点上。

第二副本放在不同的机架上。

第三副本与第二副本放置在同一机架中。

设置HDFS集群

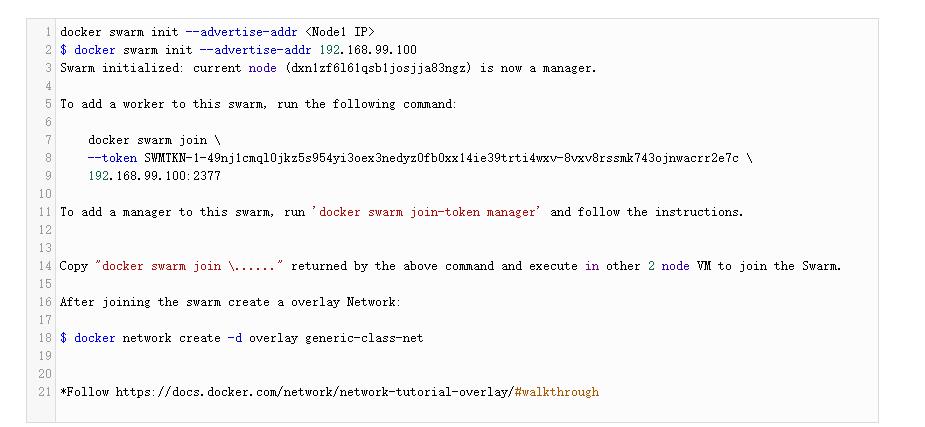

要创建HDFS集群,会用到Docker。有关Docker映像的详细信息,请参见:

https://hub.docker.com/u/uhopper/

步骤

创建一个Docker群网络。

查看Gist上的代码。

链接:https://gist.github.com/NitinRanjan/58427ee62d3575f85b3c4f22cdae47cb

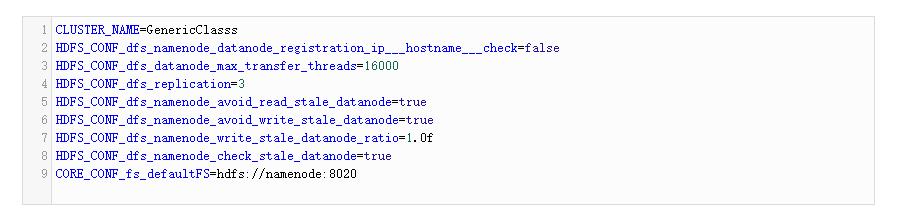

NameNode

在VM1中为NameNode创建环境变量文件(namenode_env)。

查看Gist上的代码。

链接:

https://gist.github.com/NitinRanjan/58427ee62d3575f85b3c4f22cdae47cb

在VM1上创建NameNode:

查看Gist上的代码。

链接:

https://gist.github.com/NitinRanjan/58427ee62d3575f85b3c4f22cdae47cb

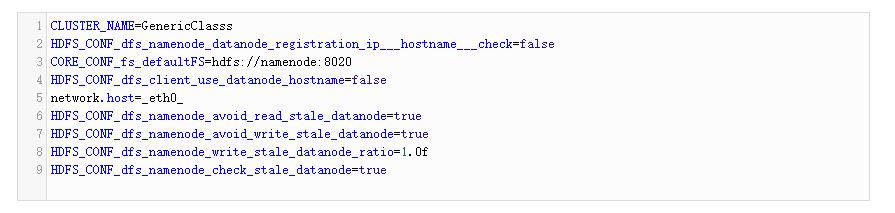

在所有3个VM中为DataNode创建环境变量文件(datanode_env)。

查看Gist上的代码。

链接:

https://gist.github.com/NitinRanjan/58427ee62d3575f85b3c4f22cdae47cb

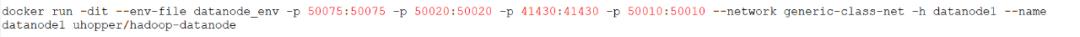

在VM1上创建DataNode1:

查看Gist上的代码。

链接:

https://gist.github.com/NitinRanjan/58427ee62d3575f85b3c4f22cdae47cb

在VM2上创建DataNode 2:

查看Gist上的代码。

链接:

https://gist.github.com/NitinRanjan/58427ee62d3575f85b3c4f22cdae47cb

在VM 3上创建DataNode 3。

查看Gist上的代码。

链接:

https://gist.github.com/NitinRanjan/58427ee62d3575f85b3c4f22cdae47cb

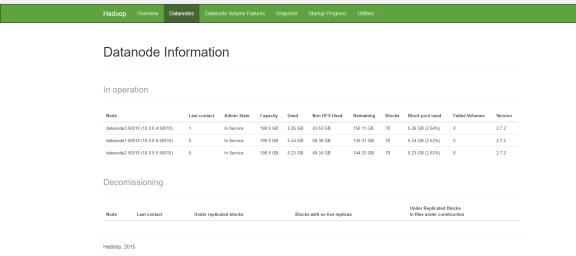

在所有vms中,通过执行docker ps检查所有容器是否已启动并正常运行。

一旦所有容器均已启动并运行,请转到VM1,打开浏览器,打开http://localhost:50070/dfshealth.html#tab-datanode.将会看到如下输出:

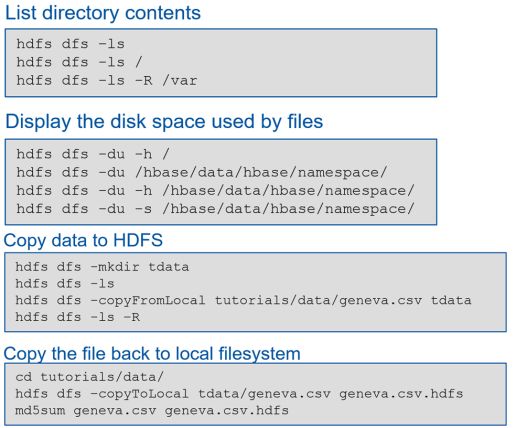

HDFS CLI

在本文中,我们研究了HDFS以及如何创建3个节点HDFS集群。在下一篇文章中,我们将关注Zookeeper,并创建一个Zookeeper集群。

参考文献:

https://hadoop.apache.org/docs/stable/hadoop-project-dist/hadoop-hdfs/HdfsUserGuide.html

https://hadoop.apache.org/docs/r2.4.1/hadoop-project-dist/hadoop-hdfs/HdfsUserGuide.html

https://docs.docker.com/network/network-tutorial-overlay/#walkthrough

https://hub.docker.com/u/uhopper/

本文首次在Generic Class博客上发表。

原文标题:

An Introduction to HDFS

原文链接:

https://dzone.com/articles/an-introduction-to-hdfs

编辑:王菁

校对:洪淑越

译者简介

陈之炎,北京交通大学通信与控制工程专业毕业,获得工学硕士学位,历任长城计算机软件与系统公司工程师,大唐微电子公司工程师,现任北京吾译超群科技有限公司技术支持。目前从事智能化翻译教学系统的运营和维护,在人工智能深度学习和自然语言处理(NLP)方面积累有一定的经验。业余时间喜爱翻译创作,翻译作品主要有:IEC-ISO 7816、伊拉克石油工程项目、新财税主义宣言等等,其中中译英作品“新财税主义宣言”在GLOBAL TIMES正式发表。能够利用业余时间加入到THU 数据派平台的翻译志愿者小组,希望能和大家一起交流分享,共同进步

翻译组招募信息

工作内容:需要一颗细致的心,将选取好的外文文章翻译成流畅的中文。如果你是数据科学/统计学/计算机类的留学生,或在海外从事相关工作,或对自己外语水平有信心的朋友欢迎加入翻译小组。

你能得到:定期的翻译培训提高志愿者的翻译水平,提高对于数据科学前沿的认知,海外的朋友可以和国内技术应用发展保持联系,THU数据派产学研的背景为志愿者带来好的发展机遇。

其他福利:来自于名企的数据科学工作者,北大清华以及海外等名校学生他们都将成为你在翻译小组的伙伴。

点击文末“阅读原文”加入数据派团队~

转载须知

发布后请将链接反馈至联系邮箱(见下方)。未经许可的转载以及改编者,我们将依法追究其法律责任。

点击“阅读原文”拥抱组织

以上是关于独家 | 带你认识HDFS和如何创建3个节点HDFS集群(附代码&案例)的主要内容,如果未能解决你的问题,请参考以下文章