HDFS集群扩容节点

Posted ItStar

tags:

篇首语:本文由小常识网(cha138.com)小编为大家整理,主要介绍了HDFS集群扩容节点相关的知识,希望对你有一定的参考价值。

在企业中,经常需要根据业务的发展对HDFS集群进行节点扩容。比如我们要添加一个新DataNode节点到集群中:

节点上运行进程: datanode、 nodemanager

操作步骤:

在bigdata114机器安装jdk并且配置环境变量。

在bigdata114机器安装hadoop2.8.4并且配置环境变量。

将namenode服务器上的hadoop2.8.4的配置复制到bigdata114机器上。

scp -r /opt/module/hadoop-2.8.4/etc/ root114:/opt/module/hadoop-2.8.4/将集群中所有的hadoop的slaves配置文件中都添加上“bigdata114”

bigdata111bigdata112bigdata113bigdata114

配置ssh免密操作:

生成秘钥:

ssh-keygen 发送秘钥至每个节点:

bigdata114秘钥-->bigdata111~114ssh-copy-id bigdata111ssh-copy-id bigdata113ssh-copy-id bigdata112ssh-copy-id bigdata114bigdata111~113秘钥-->bigdata114ssh-copy-id bigdata114

启动bigdata114节点的datanode、 nodemanager:

${HADOOP_HOME}/sbin/hadoop-daemon.sh start datanode${HADOOP_HOME}/sbin/yarn-daemon.sh start nodemanager

使用jps查看是否启动:

2729 NodeManager29081 Jps27643 DataNode

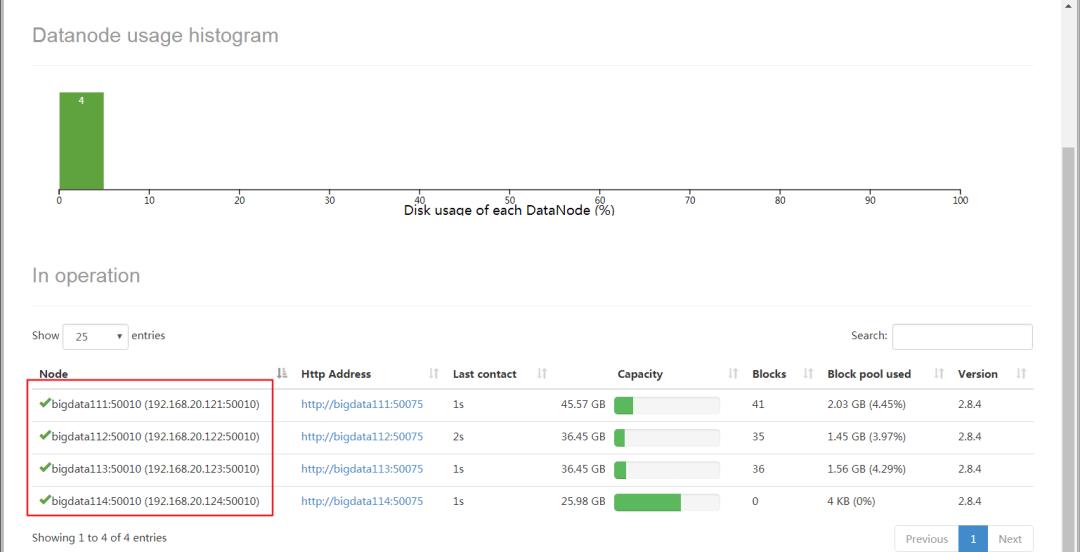

打开hadoop的web页面查看是否启动成功:

以上是关于HDFS集群扩容节点的主要内容,如果未能解决你的问题,请参考以下文章