HDFS与HBASE的动态节点的扩容(增删)小白级

Posted 稚何君

tags:

篇首语:本文由小常识网(cha138.com)小编为大家整理,主要介绍了HDFS与HBASE的动态节点的扩容(增删)小白级相关的知识,希望对你有一定的参考价值。

上一篇文章,介绍了动态扩容前的基础配置。

本文将讲述HDFS和HBASE动态增删的具体内容。

一、HDFS动态增节点---slave3

开始之前要保证其他节点开启Hadoop集群,毕竟是动态的嘛

1.安装Hadoop (slave3)

把其他节点上的hadoop发送到slave3节点上

scp -r /usr/hadoop root@slave3:/usr/2.修改slaves文件(所有节点)

#加入slave3

vi $HADOOP_HOME/etc/hadoop/slaves

slave1

slave2

slave33.启动节点 slave3

$HADOOP_HOME/sbin/hadoop-daemon.sh start datanode

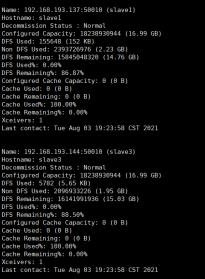

$HADOOP_HOME/sbin/yarn-daemon.sh start nodemanager4.查看状态 master

hdfs dfsadmin -refreshNodes

hdfs dfsadmin -report效果图:

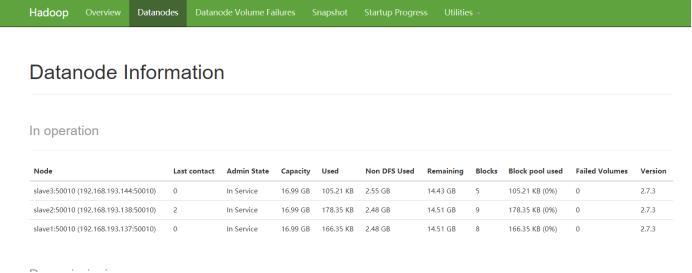

也可以通过web端进行查看:

二、HDFS动态删节点----slave2

在所有的节点上

1.修改hdfs-site.xml文件

cd /usr/hadoop/hadoop-2.7.3/etc/hadoop/

vi hdfs-site.xml

<!--不加入集群的节点列表-->

<property>

<name>dfs.hosts.exclude</name>

<value>/usr/hadoop/hadoop-2.7.3/etc/hadoop/excludes</value>

</property>2.创建excludes文件,加入slave2

touch excludes

vi /usr/hadoop/hadoop-2.7.3/etc/hadoop/excludes

slave23.关闭节点进程

在slave2上

sbin/hadoop-daemon.sh stop datanode

sbin/yarn-daemon.sh stop nodemanage4.查看状态

在master上

hdfs dfsadmin -refreshNodes

hdfs dfsadmin -report效果图:

也可以通过web端进行查看:

图中slave2的状态显示Decommission in Progress,表示slave2退出了集群

三、HBASE动态增删---slave3

HBASE的动态增删要比HDFS的简单一些。当然,要先保证其他节点的HBASE是开启的。

1.安装hbase 在slave3上

把其他节点上的hbase发送到slave3节点上

scp -r /usr/hbase root@slave3:/usr/2. 修改regionserver文件(所有节点)

#在hbase的conf路径下

vi regionserver

slave1

slave2

slave33.开启节点 (在slave3上)

#在bin目录下

./hbase-daemon.sh start regionserver

之后可以进入hbase shell 通过status 查看状态

在新的节点上进入hbase shell

然后输入balance_switch true

过一会,你就会发现regions 已经负载均衡了。同理要删除slave3节点则需要在slave3上运行

#bin目录下

./hbase-daemon.sh stop regionserver

或者

graceful_stop.sh regionser(主机名)

之后可以进入hbase shell 通过status 查看状态当然,也可以通过hbase web来进行查看状态,在这里就不再详细展示了。

至此,HDFS与HBASE的动态增删节点就讲完了,希望能对大家有所帮助。感谢大家的支持。

以上是关于HDFS与HBASE的动态节点的扩容(增删)小白级的主要内容,如果未能解决你的问题,请参考以下文章