小白学习大数据测试之hadoop hdfs和MapReduce小实战

Posted 测试帮日记

tags:

篇首语:本文由小常识网(cha138.com)小编为大家整理,主要介绍了小白学习大数据测试之hadoop hdfs和MapReduce小实战相关的知识,希望对你有一定的参考价值。

转发是对小编的最大支持

推荐

在这个基础上,我们来运行一个官网的MapReduce demo程序来看看效果和处理过程。

大致步骤如下:

新建一个文件test.txt,内容为

Hello Hadoop

Hello xiaoqiang

Hello testingbang

Hello http://xqtesting.sxl.cn

将test.txt上传到hdfs的根目录

/usr/lib/hadoop/hadoop-2.7.4/bin/hdfs dfs -put /root/install/test.txt /

然后浏览器访问可以看到刚才上传的文件,如下图

运行官方的一个wordcount程序来统计字符数量,命令如下:

/usr/lib/hadoop/hadoop-2.7.4/bin/hadoop jar /usr/lib/hadoop/hadoop-2.7.4/share/hadoop/mapreduce/hadoop-mapreduce-examples-2.7.4.jar wordcount hdfs://localhost:9000/test.txt hdfs://localhost:9000/out

解释下这个命令,大致意思是用hadoop执行一个叫hadoop-mapreduce-examples-2.7.4.jar的wordcount 方法,其中输入参数为hdfs上根目录的test.txt 文件,而输出路径为hdfs跟目录下的out目录

PS:我这里没有把hadoop配置成环境变量,所以命令很长,你可以配置下,这样命令就会短很多了,至于怎么配置,自己悟~

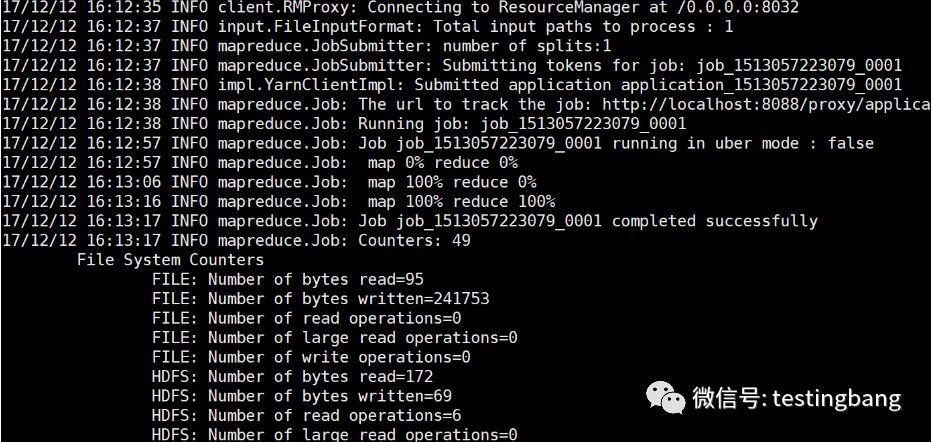

执行过程如下:

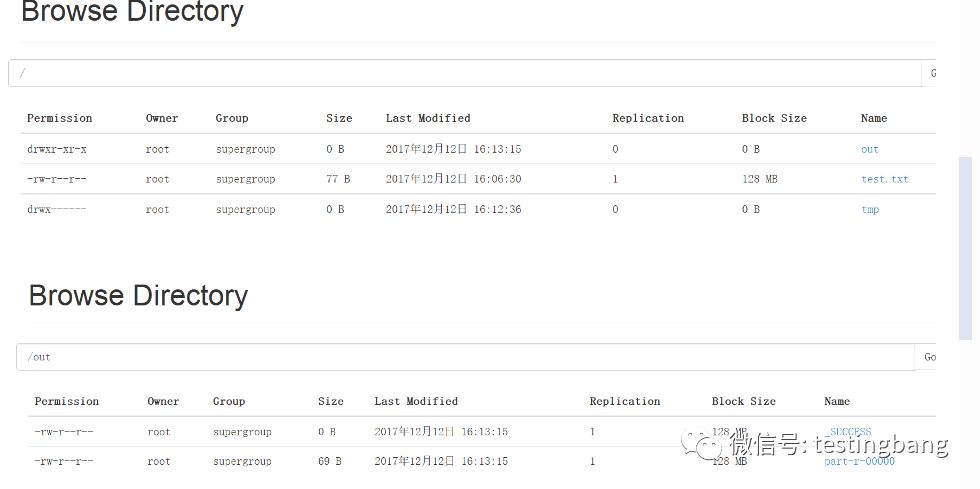

执行完成之后再次刷新浏览器可以看到out目录和结果了

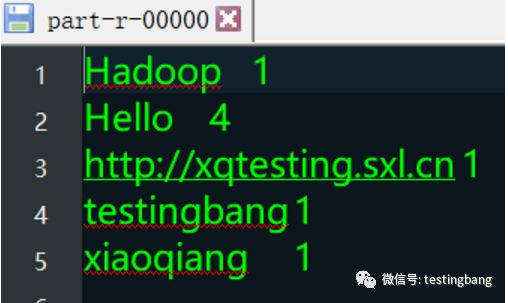

点击part-r-00000,在弹出的页面点击download

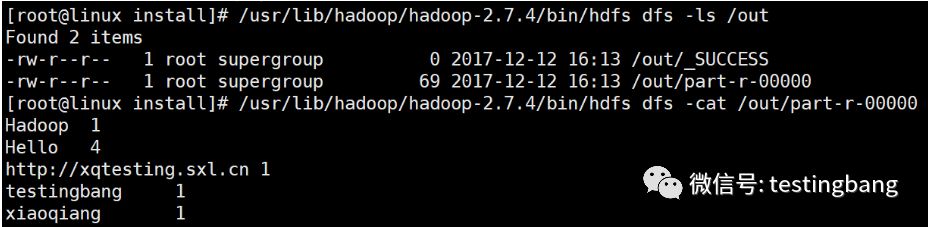

PS:你也可以用命令查看,如下图

到这里,我们既完成了hadoop环境的搭建,也完成一次MapReduce的执行。其实也算是对hadoop功能的测试。如果你都成功了,那么恭喜你!如果你没有成功,那么也恭喜你,因为你发现了自己的不足!

最后,大家请多多转发本文,每一步都是小编自己做的,耗费了很多脑细胞~转发才是对小编的最大支持哦

小强全栈自动化测试开发班(python+接口+app+web)3月7号开课,名额不多了

所有学员享受免费、不限次数、无限重学的权利直到学会为止,拒绝限制次数、缴纳重学费的恶心规矩

课程大纲与介绍点击文末【阅读原文】

咨询QQ:2083503238或扫下方微信二维码

安装荔枝FM手机APP,搜索“挨踢脱口秀”,可收听技术、娱乐、行业、爆料等语音,播放量已经破百万了哦

以上是关于小白学习大数据测试之hadoop hdfs和MapReduce小实战的主要内容,如果未能解决你的问题,请参考以下文章