论文泛读151Transformer-F:具有学习通用句子表示的有效方法的 Transformer 网络

Posted 及时行樂_

tags:

篇首语:本文由小常识网(cha138.com)小编为大家整理,主要介绍了论文泛读151Transformer-F:具有学习通用句子表示的有效方法的 Transformer 网络相关的知识,希望对你有一定的参考价值。

贴一下汇总贴:论文阅读记录

一、摘要

Transformer 模型广泛用于自然语言处理中的句子表示。然而,之前的基于 Transformer 的模型专注于在大多数情况下意义有限的功能词,并且只能提取高级语义抽象特征。在本文中,介绍了两种方法来提高 Transformer 的性能。我们通过将词性权重向量与相关系数相乘来计算注意力得分,这有助于提取更具有实际意义的单词。权重向量由输入文本序列根据词性的重要性得到。此外,我们融合了每一层的特征,使句子表示结果更加全面和准确。在实验中,我们证明了我们的模型 Transformer-F 在三个标准文本分类数据集上的有效性。实验结果表明,与基线模型相比,我们提出的模型显着提高了文本分类的性能。具体来说,我们在简单任务上比普通 Transformer 获得了 5.28% 的相对改进。

二、结论

本文提出了用于句子表示的Transformer-F,以解决普通Transformer只关注无意义的虚词,不能利用浅层特征的问题。我们从三个方面对Transformer进行了改进:(1)用相关系数代替点积来恰当地表示词与词之间的相关性;(2)通过将词性权重向量与相关系数矩阵相乘,我们计算注意力权重,这有助于提取具有实词的单词;(3)融合各层特征,使句子表征结果更加全面、准确。我们在三个标准文本分类数据集上评估了我们的模型TransformerF,并依次验证了上述策略的可行性。实验结果表明,基于Transformer-F模型的句子表示能够显著提高文本分类,尤其是在CED_dataset上比Transformer的准确率提升了5.28%,证明了我们创新点的有效性。虽然Transformer-F模型取得了很好的效果,但仍有很大的改进空间。在未来的工作中,我们将尝试将该模型引入到长文本特征表示任务中。此外,本文只做了文本分类任务的实验,我们将尝试测试Transformer-F模型在机器翻译、命名实体识别等任务中的性能。

三、model

模型概述:

用相关系数代替点积来恰当地表示词与词之间的相关性。

将输入文本序列转换为相应的词性权重向量,以便模型提取实词,并且通过将词性权重序列乘以相关系数矩阵来计算最终关注度。

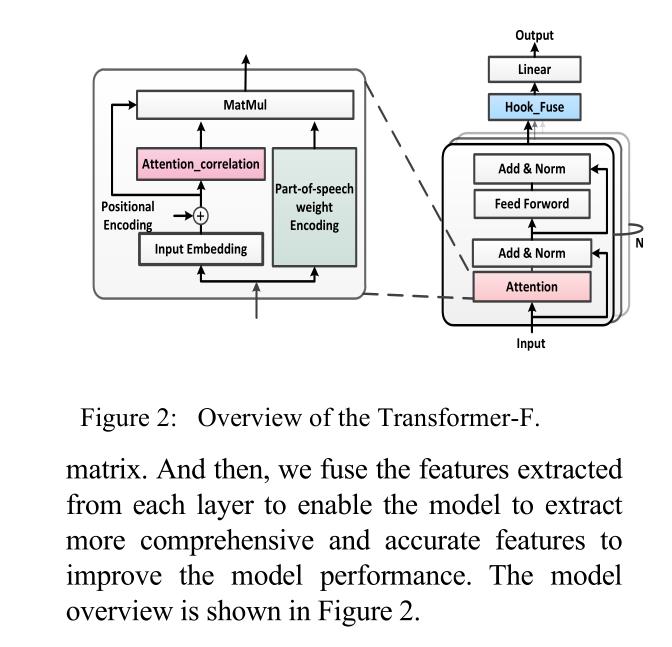

融合从每一层提取的特征,使模型能够提取更全面和准确的特征,以提高模型性能。

- 通过正则化相关系数矩阵,解决了相关系数矩阵的数据属性偏差范围大的问题。

- 使用hook函数作为算子来融合从每一层提取的特征,目的是获得无限接近最优的提取特征作为文本特征表示的最终结果。

以上是关于论文泛读151Transformer-F:具有学习通用句子表示的有效方法的 Transformer 网络的主要内容,如果未能解决你的问题,请参考以下文章

论文泛读171具有对抗性扰动的自监督对比学习,用于鲁棒的预训练语言模型

论文泛读176具有各向同性和等距条件的跨语言 BERT 上下文嵌入空间映射

论文泛读176具有各向同性和等距条件的跨语言 BERT 上下文嵌入空间映射