论文泛读138BARTScore:将生成的文本评估为文本生成

Posted 及时行樂_

tags:

篇首语:本文由小常识网(cha138.com)小编为大家整理,主要介绍了论文泛读138BARTScore:将生成的文本评估为文本生成相关的知识,希望对你有一定的参考价值。

贴一下汇总贴:论文阅读记录

论文链接:《BARTScore: Evaluating Generated Text as Text Generation》

一、摘要

各种各样的 NLP 应用程序,例如机器翻译、摘要和对话,都涉及文本生成。这些应用程序面临的一个主要挑战是如何评估此类生成的文本是否真正流畅、准确或有效。在这项工作中,我们将生成文本的评估概念化为文本生成问题,使用预训练的序列到序列模型进行建模。一般的想法是,当生成的文本更好时,训练模型将生成的文本转换为参考输出或源文本将获得更高的分数。我们使用 BART(一种基于编码器-解码器的预训练模型)来实现这一想法,并提出了一个具有多种变体的度量 BARTScore,这些变体可以以无监督的方式灵活应用于从不同角度(例如信息量、流畅度、或事实)。BARTScore 在概念上很简单,在经验上也很有效。它可以在 22 个测试设置中的 16 个测试设置中优于现有的最高分指标,涵盖对 16 个数据集的评估(例如,机器翻译、文本摘要)和 7 个不同的角度(例如,信息量、事实性)。计算 BARTScore 的代码可在github,并且我们在 ExplainaBoard 平台上的这个 github上发布了一个用于元评估的交互式排行榜 ,这使我们能够以交互方式了解每个指标的优势、劣势和互补性。

二、结论

在本文中,我们提出了一个度量标准BARTSCORE,它将生成文本的评估作为一个文本生成任务,并通过实验证明了它的有效性。在没有人工判断的监督下,BARTSCORE可以从7个角度有效地评估文本,并在22个设置中的16个设置上相对于现有的最高评分指标取得最佳性能。

三、model

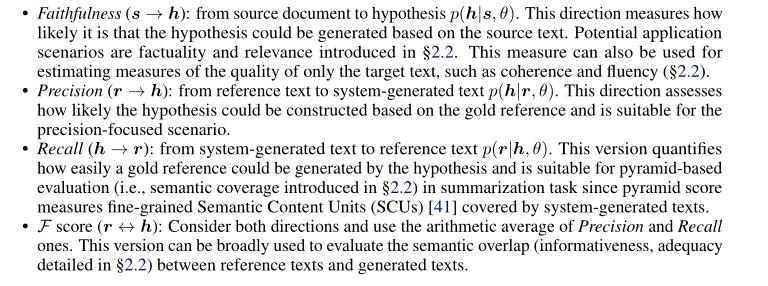

- faithfulness

- precison

- recall

- f score

以上是关于论文泛读138BARTScore:将生成的文本评估为文本生成的主要内容,如果未能解决你的问题,请参考以下文章