scala2.12+kafka2.7.1安装

Posted 逃跑的沙丁鱼

tags:

篇首语:本文由小常识网(cha138.com)小编为大家整理,主要介绍了scala2.12+kafka2.7.1安装相关的知识,希望对你有一定的参考价值。

目录

环境:

centos7

scala2.12

1 下载上传到机器解压

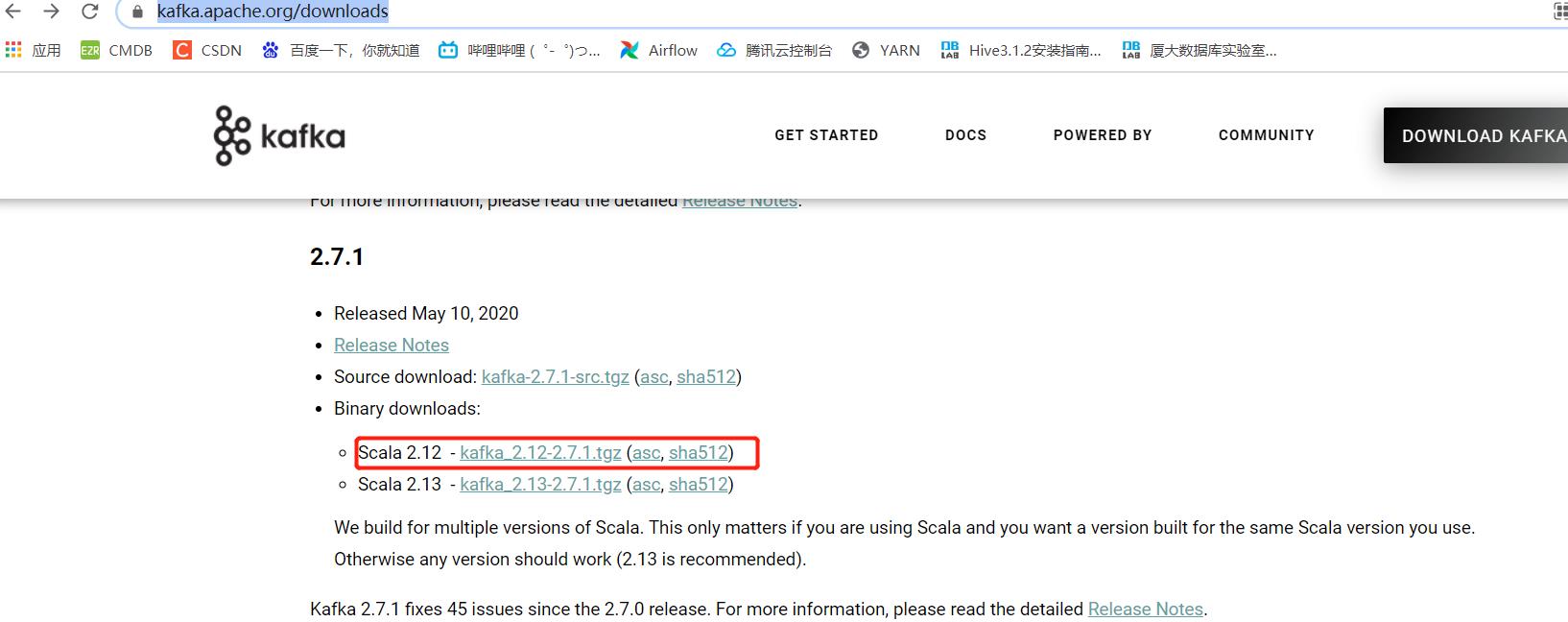

官网下载

https://kafka.apache.org/downloads

解压

[liucf@node1 softfile]$ tar -xvf kafka_2.12-2.7.1.tgz -C ../soft重新命名解压目录使自己看着舒服

[liucf@node1 soft]$ mv kafka_2.12-2.7.1 kafka-2.7.12 安装配置kafka

当前下载的kafka程序里自带Zookeeper,可以直接使用其自带的Zookeeper建立集群,也可以单独使用Zookeeper安装文件建立集群。

因为我的集群里已经有了单独安装的zookeeper,所以我使用自己安装的zookeeper进行配置

zookeeper安装参考:https://blog.csdn.net/m0_37813354/article/details/116721842

2.1 修改配置文件

/home/liucf/soft/kafka-2.7.1/config/server.properties修改如下配置 node1

# #指定kafka对应的broker id ,唯一

broker.id=0

#指定broker主机名

host.name=node1

# 指定数据存放的目录

log.dirs=/home/liucf/soft/kafka-2.7.1/logs

#指定zk地址

zookeeper.connect=node1:2181,node2:2181,node3:2181

#指定是否可以删除topic ,默认是false 表示不可以删除

delete.topic.enable=true拷贝到node2,node3

[liucf@node1 soft]$ scp -r kafka-2.7.1 liucf@node2:/home/liucf/soft

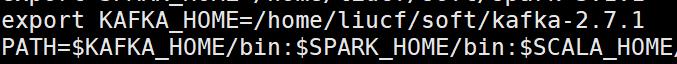

[liucf@node1 soft]$ scp -r kafka-2.7.1 liucf@node3:/home/liucf/soft配置 KAFKA_HOME 三台机器都做

分别修改node2,和node3机器上的

# #指定kafka对应的broker id ,唯一

broker.id=?

#指定broker主机名

host.name=?

node2

# #指定kafka对应的broker id ,唯一

broker.id=1

#指定broker主机名

host.name=node2

# 指定数据存放的目录

log.dirs=/home/liucf/soft/kafka-2.7.1/logs

#指定zk地址

zookeeper.connect=node1:2181,node2:2181,node3:2181

#指定是否可以删除topic ,默认是false 表示不可以删除

delete.topic.enable=truenode3

# #指定kafka对应的broker id ,唯一

broker.id=2

#指定broker主机名

host.name=node3

# 指定数据存放的目录

log.dirs=/home/liucf/soft/kafka-2.7.1/logs

#指定zk地址

zookeeper.connect=node1:2181,node2:2181,node3:2181

#指定是否可以删除topic ,默认是false 表示不可以删除

delete.topic.enable=true2.2 每台机器上启动kafka

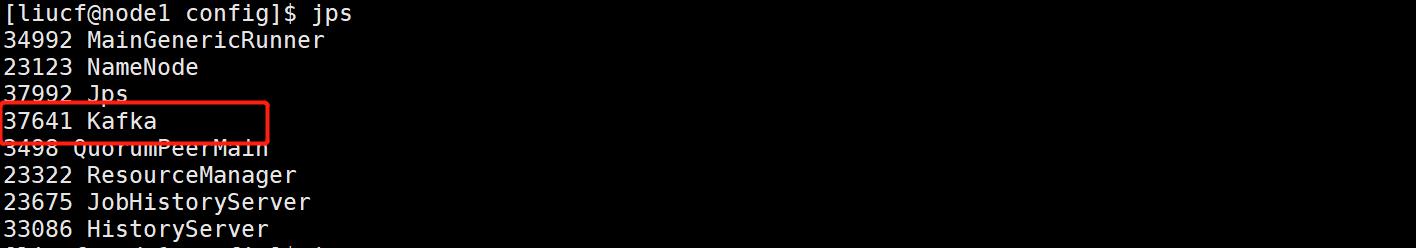

[liucf@node1 config]$ nohup /home/liucf/soft/kafka-2.7.1/bin/kafka-server-start.sh /home/liucf/soft/kafka-2.7.1/config/server.properties >/dev/null 2>&1 &

[liucf@node2 config]$ nohup /home/liucf/soft/kafka-2.7.1/bin/kafka-server-start.sh /home/liucf/soft/kafka-2.7.1/config/server.properties >/dev/null 2>&1 &

[liucf@node3 config]$ nohup /home/liucf/soft/kafka-2.7.1/bin/kafka-server-start.sh /home/liucf/soft/kafka-2.7.1/config/server.properties >/dev/null 2>&1 &

2.3 一键启停脚本

#!/bin/sh

case $1 in

"start"){

for host in node1 node2 node3

do

ssh $host "source /etc/profile; nohup /home/liucf/soft/kafka-2.7.1/bin/kafka-server-start.sh /home/liucf/soft/kafka-2.7.1/config/server.properties >/dev/null 2>&1 &"

echo "$host kafka is running..."

sleep 1.5s

done

};;

"stop"){

for host in node1 node2 node3

do

ssh $host "source /etc/profile; nohup /home/liucf/soft/kafka-2.7.1/bin/kafka-server-stop.sh >/dev/null 2>&1 &"

echo "$host kafka is stopping..."

sleep 1.5s

done

};;

esac

3 kafka 基本命令

3.1 创建topic

[liucf@node1 ~]$ kafka-topics.sh --create --zookeeper node1:2181 --replication-factor 1 --partitions 1 --topic test

Created topic test.

3,2 查看topic

[liucf@node1 ~]$ kafka-topics.sh --list --zookeeper node1:2181

test

3.3 topic详细

[liucf@node1 ~]$ kafka-topics.sh --topic test --describe --zookeeper node1:2181

Topic: test PartitionCount: 1 ReplicationFactor: 1 Configs:

Topic: test Partition: 0 Leader: 1 Replicas: 1 Isr: 1

3.4 生产测试

[liucf@node1 ~]$ kafka-console-producer.sh --broker-list node1:9092 --topic test

>hello kafka

>test input

3.5 消费测试

[liucf@node1 bin]$ kafka-console-consumer.sh --bootstrap-server node1:9092 --topic test --from-beginning

hello kafka

test input

test over

3.6 消费组列表

[liucf@node1 ~]$ kafka-consumer-groups.sh --list --bootstrap-server node1:9092

console-consumer-10187

3.7 消费组详细

[liucf@node2 ~]$ kafka-consumer-groups.sh --describe --group console-consumer-10187 --bootstrap-server node1:9092

GROUP TOPIC PARTITION CURRENT-OFFSET LOG-END-OFFSET LAG CONSUMER-ID HOST CLIENT-ID

console-consumer-10187 test 0 - 3 - consumer-console-consumer-10187-1-03529916-d5c1-4ba2-be51-bf23b4df6d55 /192.168.109.151 consumer-console-consumer-10187-1

3.8 删除topic

[liucf@node2 ~]$ kafka-topics.sh --delete --zookeeper node1:2181 --topic test

Topic test is marked for deletion.

Note: This will have no impact if delete.topic.enable is not set to true.可见需要设置:delete.topic.enable=true

我们上面已经设置过了,所以已经删除过了

[liucf@node1 ~]$ kafka-topics.sh --list --zookeeper node1:2181

__consumer_offsets

[liucf@node1 ~]$

可见已经删除过了。

完结

以上是关于scala2.12+kafka2.7.1安装的主要内容,如果未能解决你的问题,请参考以下文章

hadoop2.7.3+spark2.1.0+scala2.12.1环境搭建安装hadoop

Scala2.12 从入门到精通实战高端视频课程(含网盘下载地址)