经典分类:线性判别分析模型!

Posted Datawhale

tags:

篇首语:本文由小常识网(cha138.com)小编为大家整理,主要介绍了经典分类:线性判别分析模型!相关的知识,希望对你有一定的参考价值。

↑↑↑关注后"星标"Datawhale

每日干货 & 每月组队学习,不错过

Datawhale干货

作者:小雨姑娘,康涅狄格大学,Datawhale成员

这几天看了看SVM的推导,看的是真的头疼,那就先梳理基础的线性判别分析模型,加深对SVM的理解。

线性判别分析是一种线性的分类模型。

线性分类模型是指采用直线(或超平面)将样本直接划开的模型,其形式可以表示成 的形式,划分平面可以表示成 。这里可以看出,线性分类模型对于样本的拟合并不一定是线性的,例如逻辑回归(外面套了一层sigmod函数)和感知机(外面套了一层激活函数)。

线性判别分析的基本思想是把所有样本投影到一条直线上,使样本在这条直线上最容易分类。

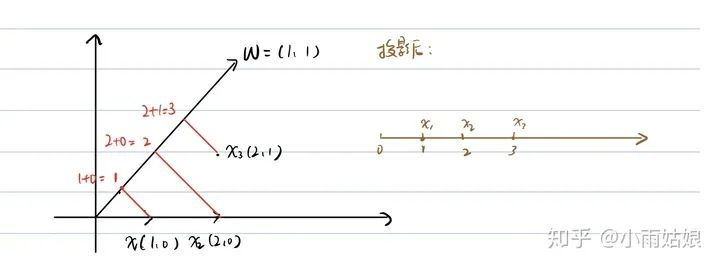

设直线的方向向量为 ,则样本 在直线上的投影为 ,如图:

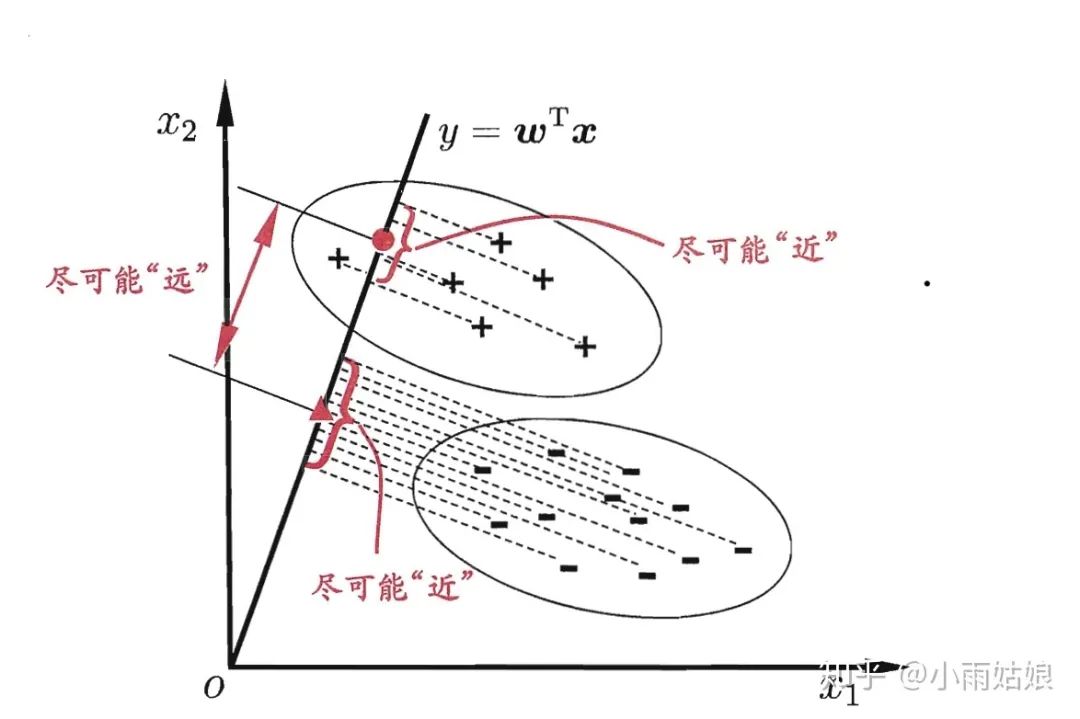

我们的目标是使两类样本的中心点在线上的投影距离大(两类样本区分度高),同时使每一类样本在线上投影的离散程度尽可能小(类内样本区分度低)。

令 , , 分别代表每一类的样本,每一类样本的均值向量,每一类样本的协方差矩阵。

若将所有样本都投影到直线上,则两类样本的中心点可分别表示为 , 。

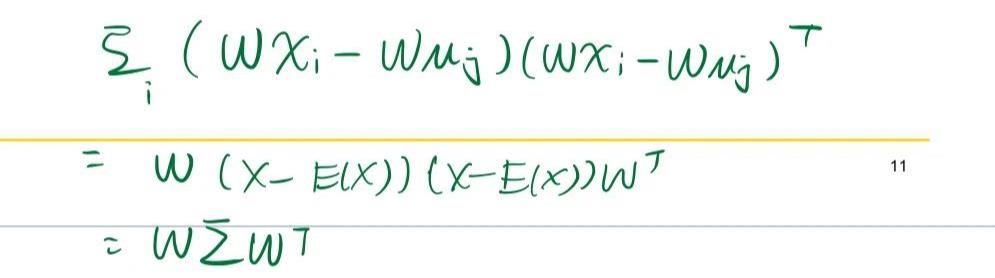

若将所有样本都投影到直线上,则两类样本的协方差可表示为 , 。

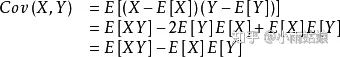

协方差是什么?协方差表示的是两个变量总体误差的期望。如果两个变量的变化趋势一致,则 为正值;若相反则为负值;变化趋势无关时为0,此时两个变量独立。

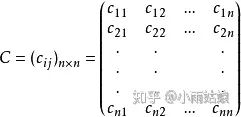

协方差矩阵是什么?协方差矩阵的元素是任意两个变量之间的协方差。

因此我们如果要让两类样本在投影后离散程度尽可能小,我们就应该让他们之间的方差尽可能小。计算每一类元素投影后的方差在做向量化时,中间就是协方差矩阵(不好意思,下面第二个 应该加个转置)。

使两类样本的中心点在线上的投影距离大,同时使每一类样本在线上投影的离散程度尽可能小的表达式可以写为:

对于参数 的优化问题可以做如下转换:

因为求的 是一个方向向量,所以 同样也是所求的解,因此我们可以假定

(相当于为 乘以一个系数 使得其最后的和为1)

则问题转换为二次规划问题: