机器学习笔记八 提升方法

Posted 猛男Banana君

tags:

篇首语:本文由小常识网(cha138.com)小编为大家整理,主要介绍了机器学习笔记八 提升方法相关的知识,希望对你有一定的参考价值。

一、基本定义

提升方法是一个线性组合多个不同的弱分类器使其成为强分类器的方法(结合多个分类器的优势),训练过程主要通过不断加大误分类样本权重,减小正确样本数据权重(改变训练数据概率分布)来达到最终的分类器。其中最为典型的是AdaBoost算法。

PS:提升方法是一种思路。

二、概念的强可学习&弱可学习

在概率近似正确学习的框架中:

1)一个概念,若存在一个多项式的学习算法能够学习它,并且正确率很高,那么这个概念就是强可学习的。

2)一个概念,若存在一个多项式的学习算法能够学习它,学习的正确率仅比随即猜测略好,那么这个概念就是弱可学习的。

三、Adaboost算法

1)Adaboost算法是一种迭代算法,其核心思想是针对同一个训练集训练不同的分类器(弱分类器),然后把这些弱分类器集合起来,构成一个更强的最终分类器(强分类器)。

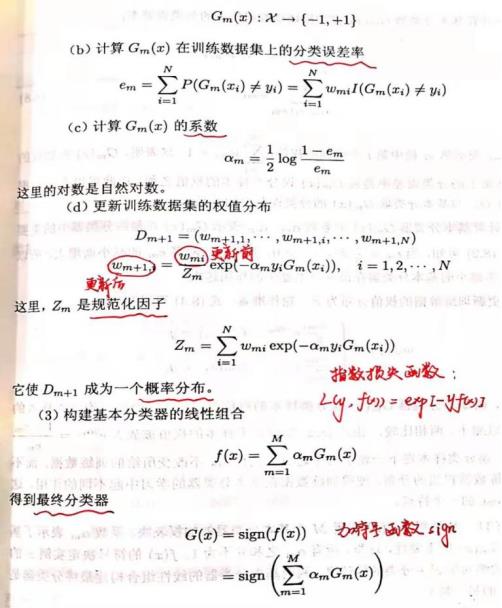

2)算法流程:

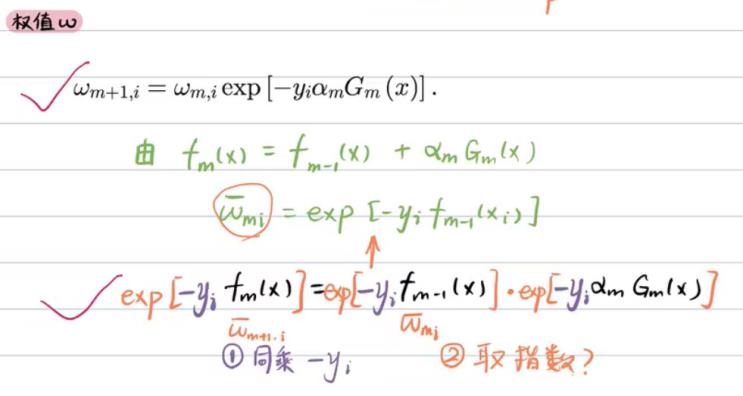

3)AdaBoost算法是向前分布加法算法的特例,损失函数是指数函数,学习算法是前向分步算法的二类分类学习方法。

4)指数损失函数:L(y,f(x))=exp[-yf(x)]

四、迭代计算最小损失函数

五、提升树

提升方法实际采用加法模型与向前分布算法,以决策树为基函数的提升方法称为提升树,对分类问题决策树是二叉分类树,对回归问题决策树是二叉回归树。

以上是关于机器学习笔记八 提升方法的主要内容,如果未能解决你的问题,请参考以下文章