浅谈个性化推荐系统中的非采样学习

Posted PaperWeekly

tags:

篇首语:本文由小常识网(cha138.com)小编为大家整理,主要介绍了浅谈个性化推荐系统中的非采样学习相关的知识,希望对你有一定的参考价值。

©PaperWeekly · 作者|陈冲、张敏

单位|清华大学人工智能实验室信息检索组

研究方向|推荐系统

引言

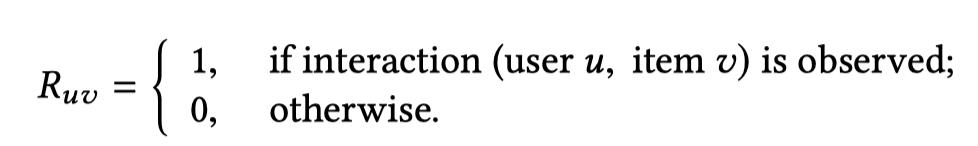

推荐系统中经常用到的数据是隐式反馈数据(Implicit Feedback Data),如浏览历史,点击日志等。这些数据往往只有正反馈而没有负反馈,并且数据是高度稀疏的(相比于用户点击过的产品,没有被点击过的产品的数量非常多)。在推荐系统中使用隐式反馈数据,有两种常见的学习方法:1)负采样策略,2)非采样策略。

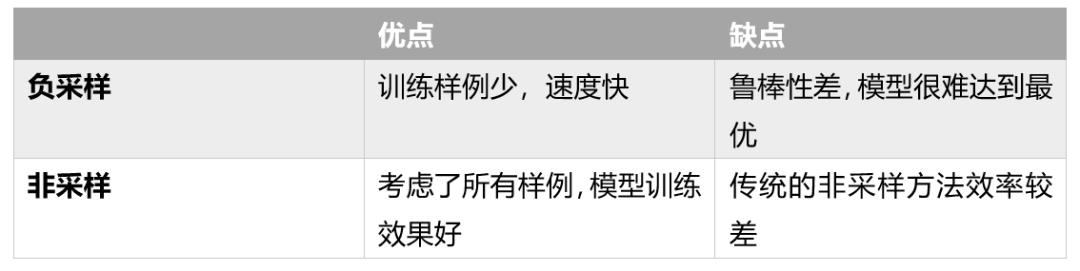

负采样策略是从所有用户未标记的样例中抽取一部分作为负例,而非采样策略则是将所有用户未标记的样例作为负例。两种方法都有各自的优点和缺点:

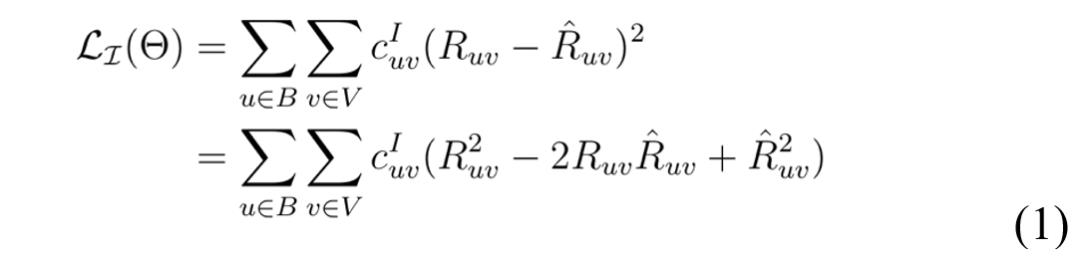

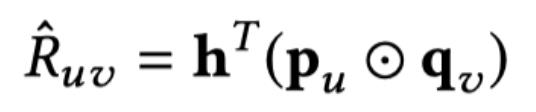

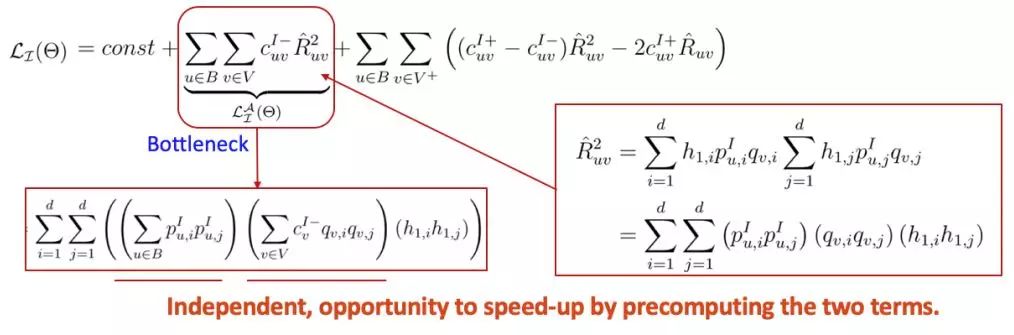

,非常大并且在基于神经网络的推荐模型中往往是不可接受的。

,非常大并且在基于神经网络的推荐模型中往往是不可接受的。

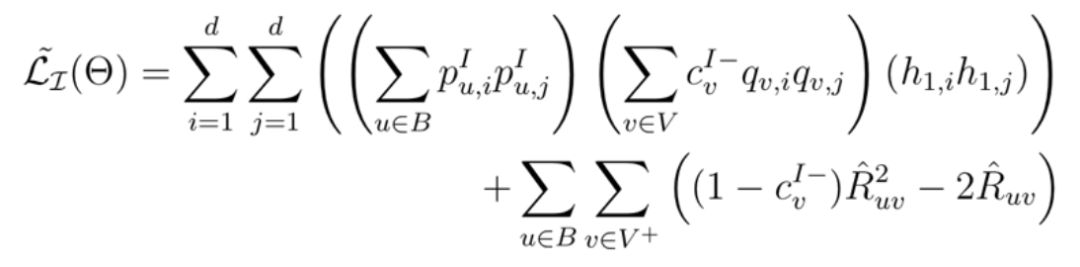

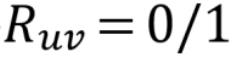

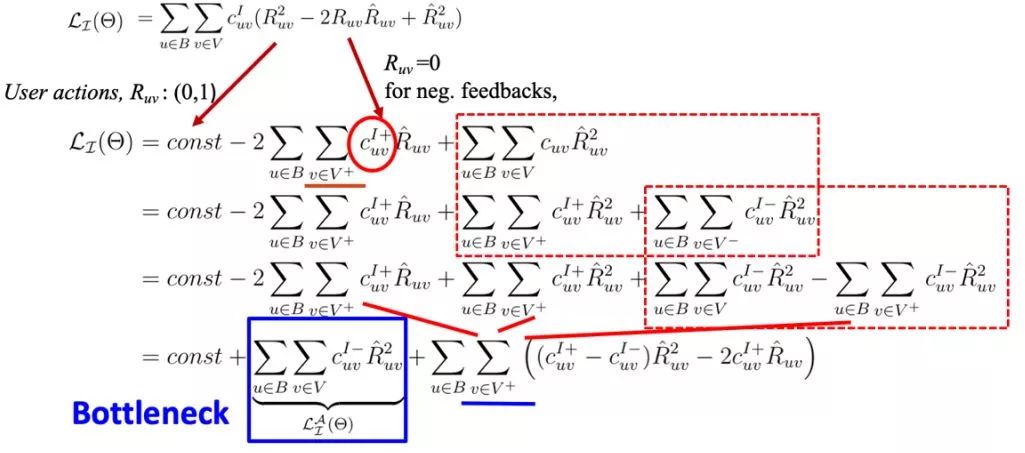

带入,并且进行合并操作:

带入,并且进行合并操作:

,因此新推导的 loss 的复杂度从理论上降低了一个数量级。

,因此新推导的 loss 的复杂度从理论上降低了一个数量级。

基于所设计的高效非采样训练策略,我们提出了若干个神经网络模型,简单介绍如下。

基础场景(只使用用户和商品ID信息)

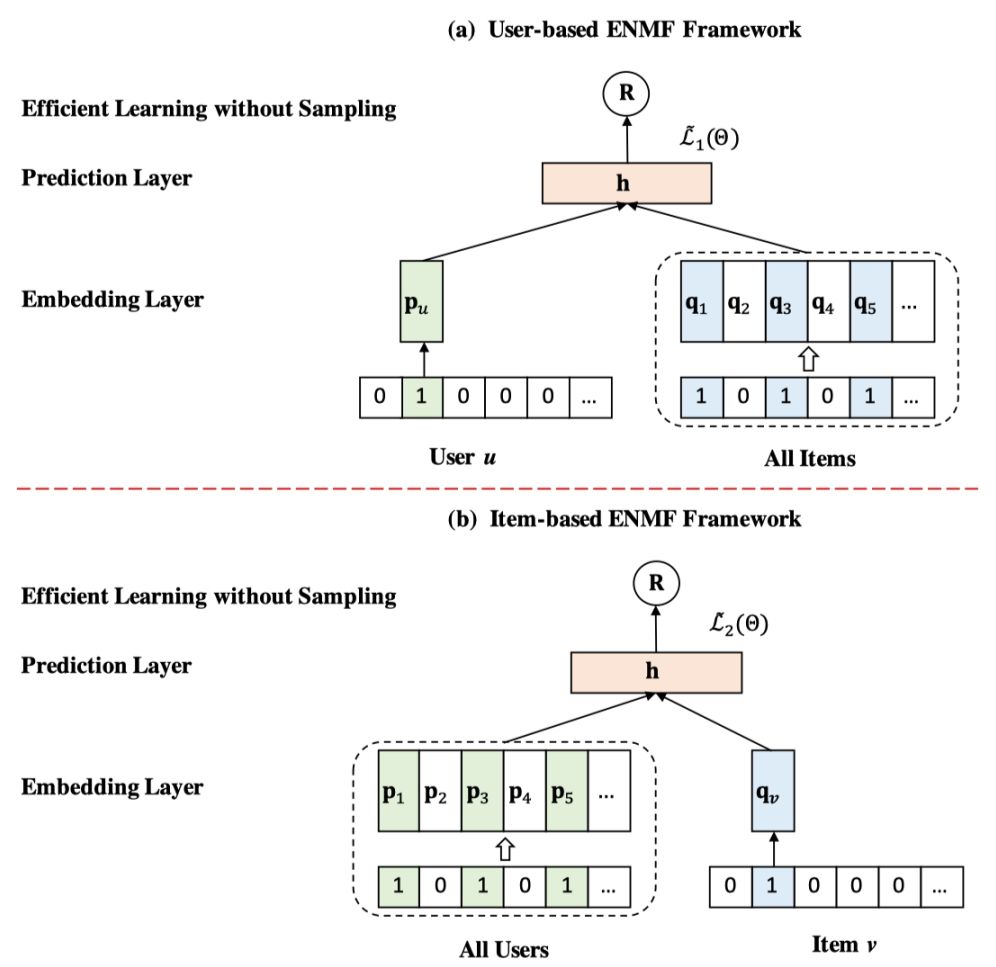

首先是在基础的推荐场景下,即只使用用户和商品的 ID 信息时,我们提出了非采样的高效神经网络矩阵分解框架(Efficient Neural Matrix Factorization, ENMF)。模型框架如下图所示:

ENMF 是一个非常基础的一层矩阵分解框架,模型结构与 Neural Collaborative Filtering (NCF) 类似但是有两个主要区别:

数据集

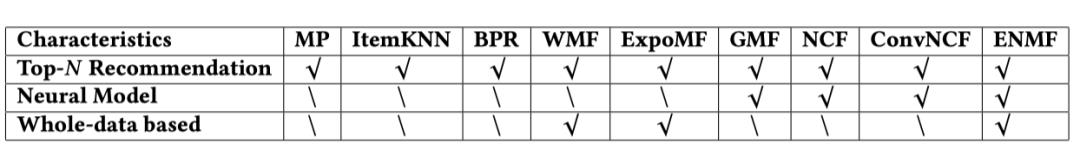

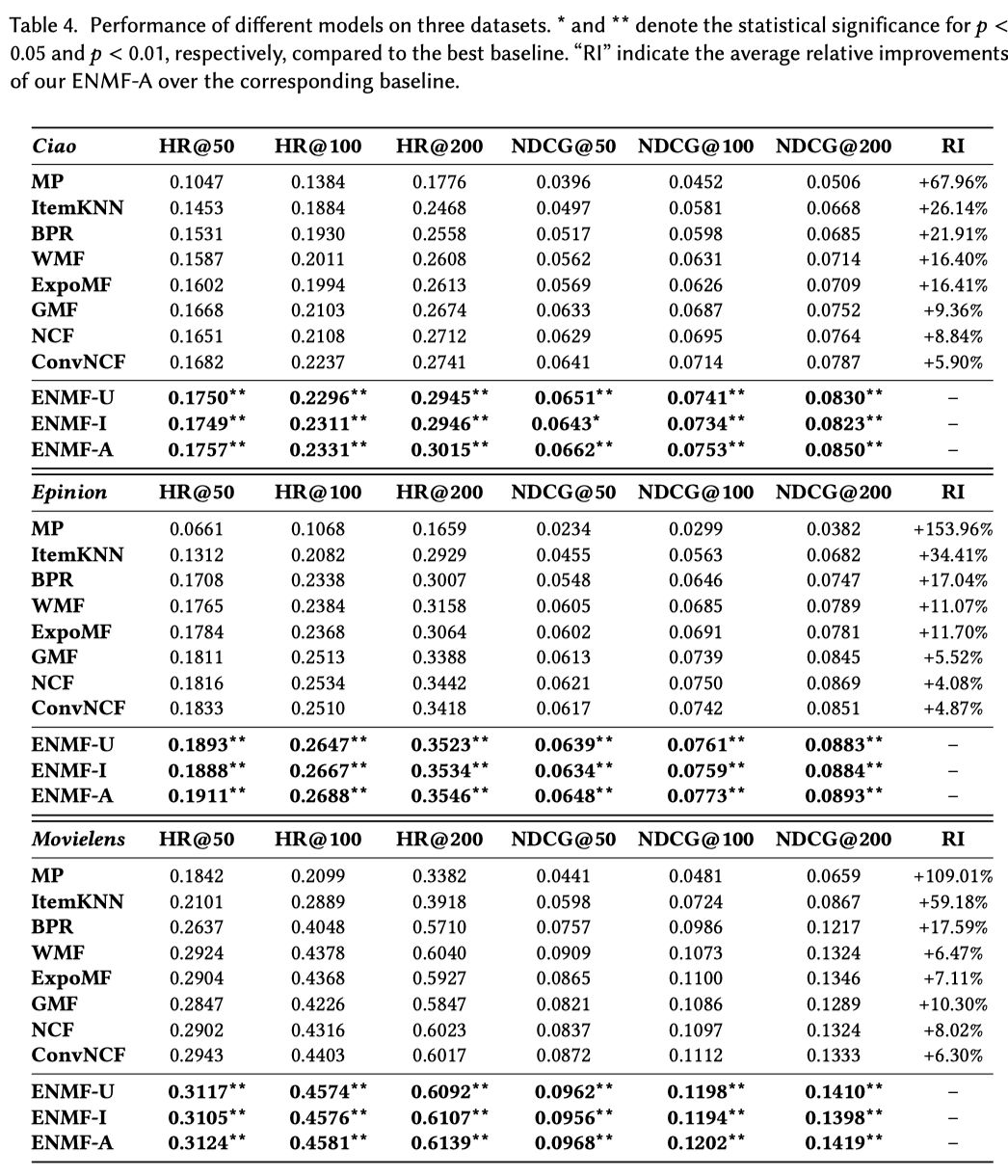

我们对比了多个 state-of-the-art 推荐模型,包括传统推荐模型 BPR (UAI’09),WMF (ICDM’08) 和 ExpoMF (WWW’16),以及神经网络模型 GMF (WWW’17),NCF (WWW’17) 和 ConvNCF (IJCAI’18)。各方法之间的比较如下:

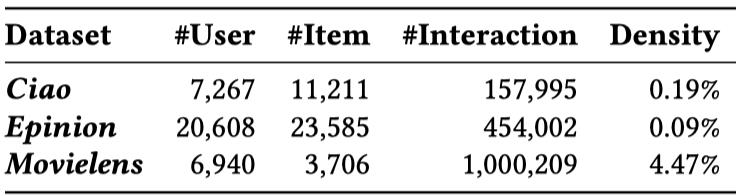

为了验证 ENMF 的效果,我们在 3 个公开数据集上进行了实验,数据集如下所示:

对比方法

我们对比了多个 state-of-the-art 推荐模型,包括传统推荐模型 BPR (UAI’09),WMF (ICDM’08) 和 ExpoMF (WWW’16),以及神经网络模型 GMF (WWW’17),NCF (WWW’17) 和 ConvNCF (IJCAI’18)。各方法之间的比较如下:

模型表现

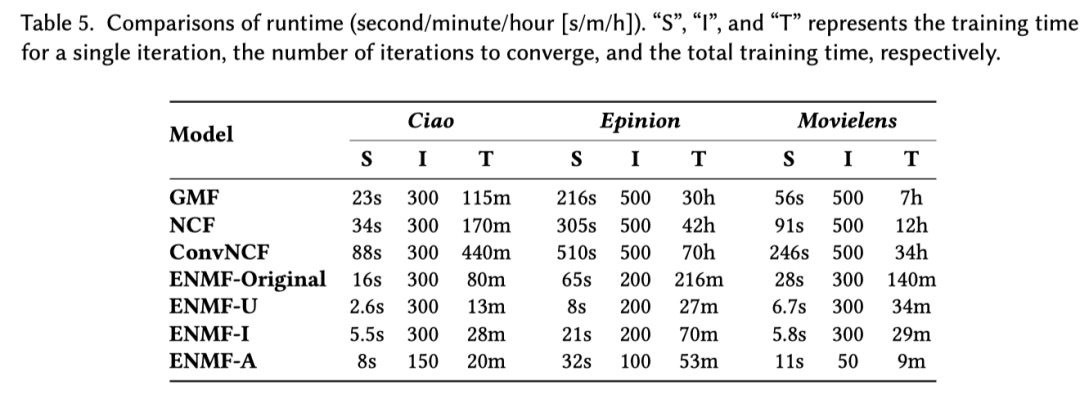

训练效率

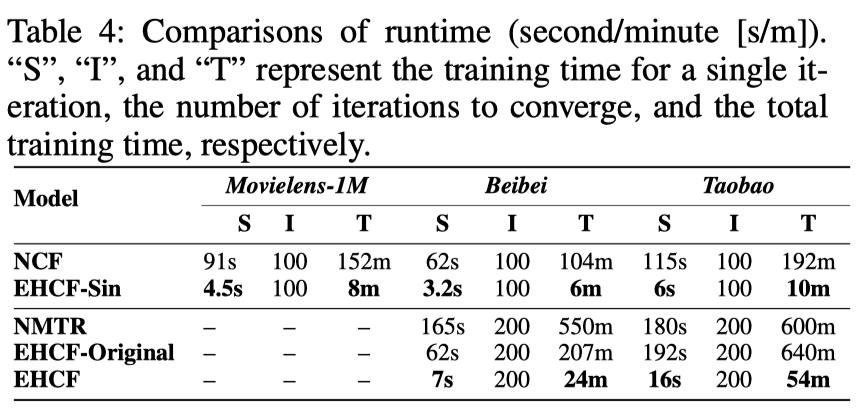

我们也在相同的机器上对比了 ENMF 和神经网络推荐算法的训练效率(Intel Xeon 8-Core CPU of 2.4 GHz and single NVIDIA GeForce GTX TITAN X GPU)。各个模型所需训练时间如下表所示:

Chong Chen, Min Zhang, Yongfeng Zhang, Yiqun Liu and Shaoping Ma. Efficient Neural Matrix Factorization without Sampling for Recommendation. ACM Transactions on Information Systems. (TOIS Vol. 38, No. 2, Article 14)

基于社交关系的推荐系统场景

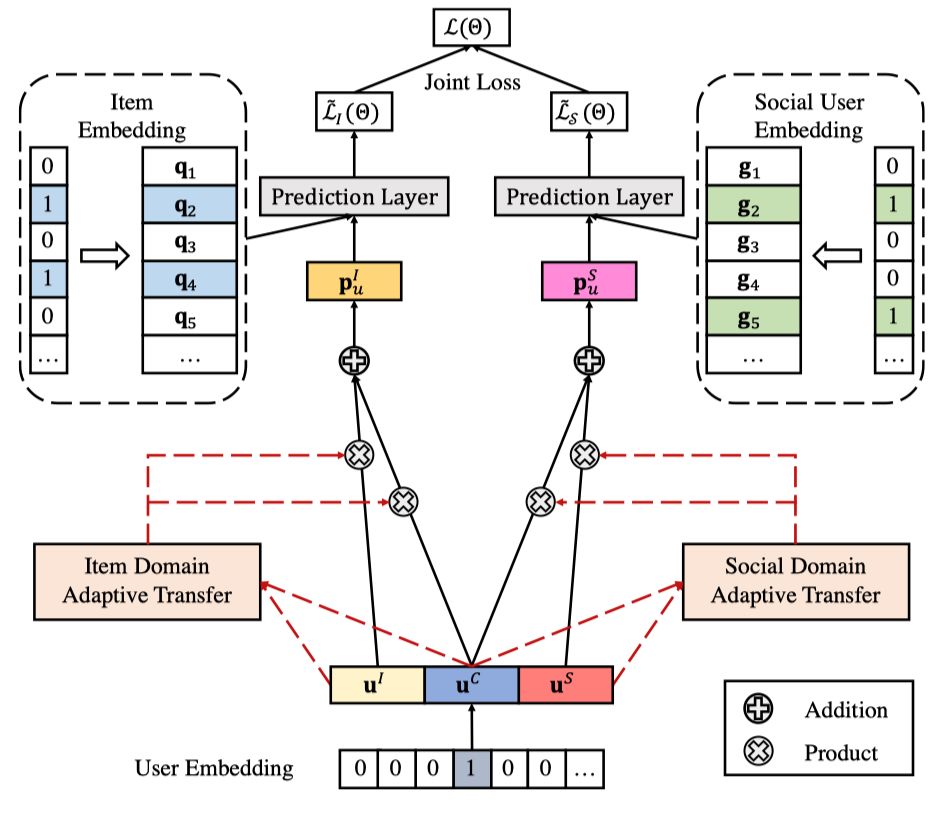

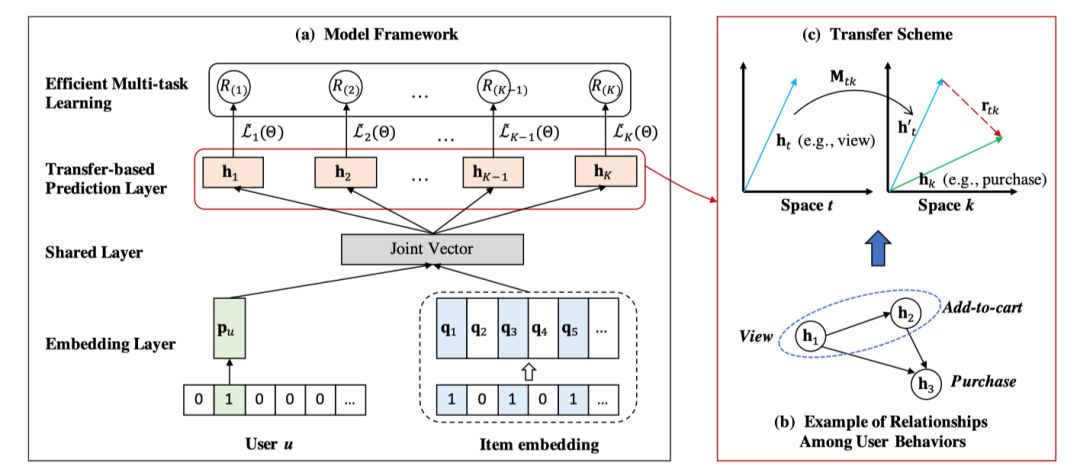

用户的社交信息可以用来帮助用户偏好建模,提高推荐结果的准确性。在基于社交关系的推荐场景下,同样可以使用非采样的训练策略。在这部分工作中,我们提出了一个应用于社交推荐的高效非抽样自适应迁移网络(Efficient Adaptive Transfer Neural Network, EATNN)。模型框架如下图所示:

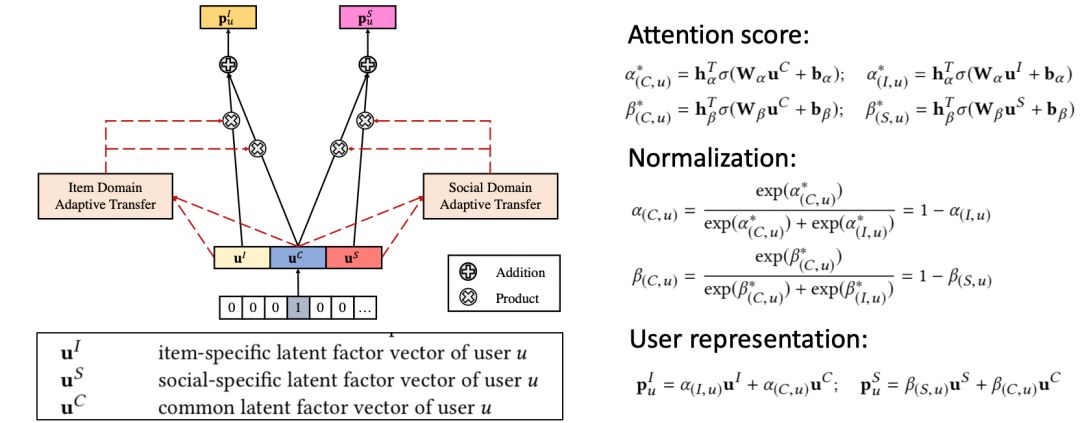

在已有的迁移学习方法中,通常采用静态传输方案来共享用户在商品和社交领域之间的共同偏好。我们认为这样是不符合实际场景的,因此,我们通过进入注意力机制,自动为每个用户分配一个个性化的迁移方案。我们同时扩展了高效非采样学习算法,使其可以支持多任务学习。模型具体结构如下:

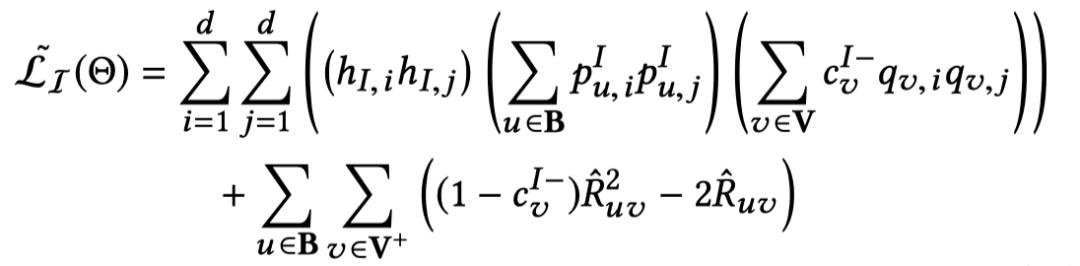

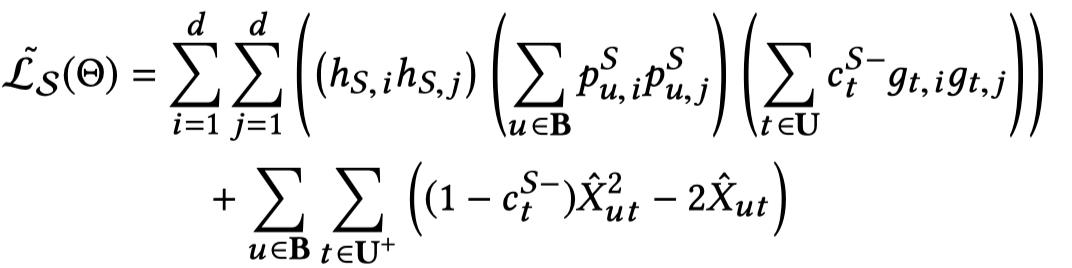

对于商品推荐任务:

对于社交发现任务:

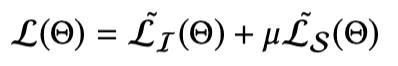

联合学习(Joint Learning):

数据集

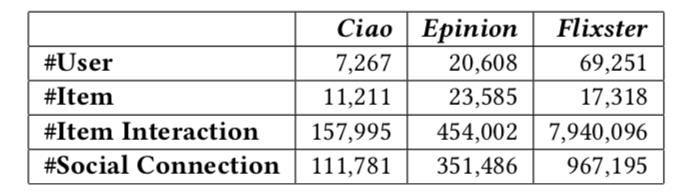

为了验证所提出的 EATNN 的效果,我们在 3 个公开数据集上进行了实验,数据集如下所示:

对比方法

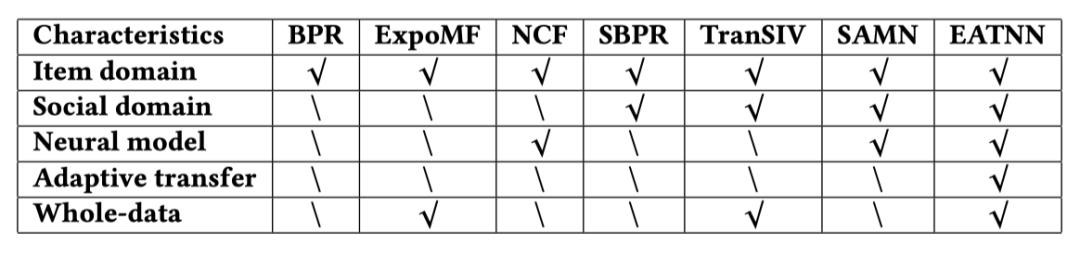

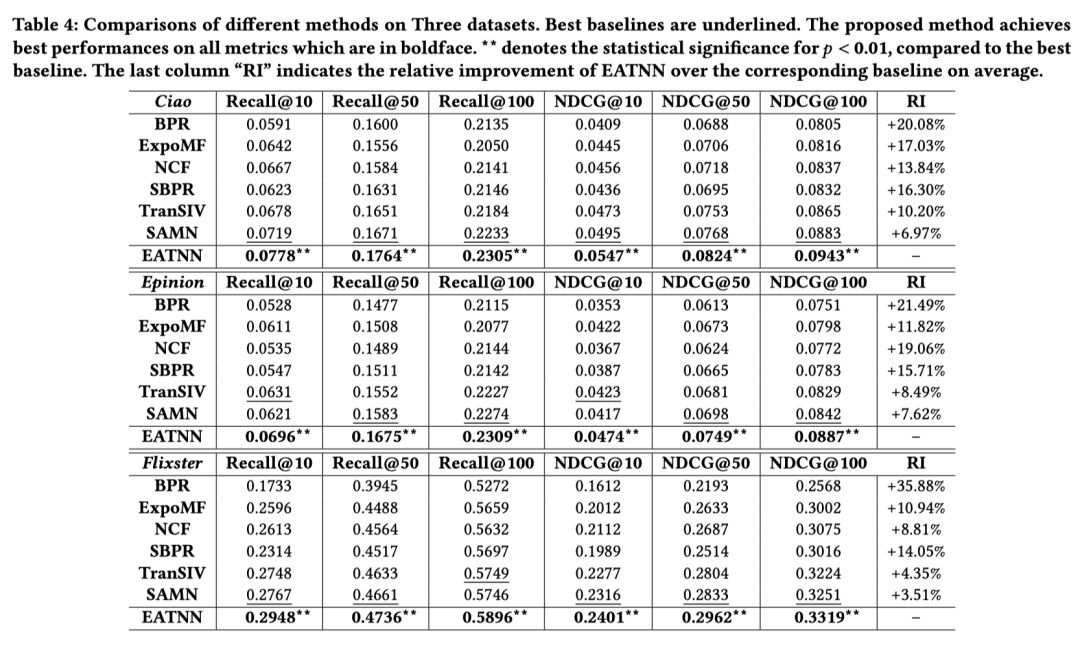

我们对比了多个 state-of-the-art 推荐模型,包括 BPR (UAI’09),ExpoMF(WWW’16),NCF (WWW’17),SBPR (CIKM’14),TranSIV (CIKM’17),以及 SAMN (WSDM’19)。各方法之间的比较如下:

模型表现

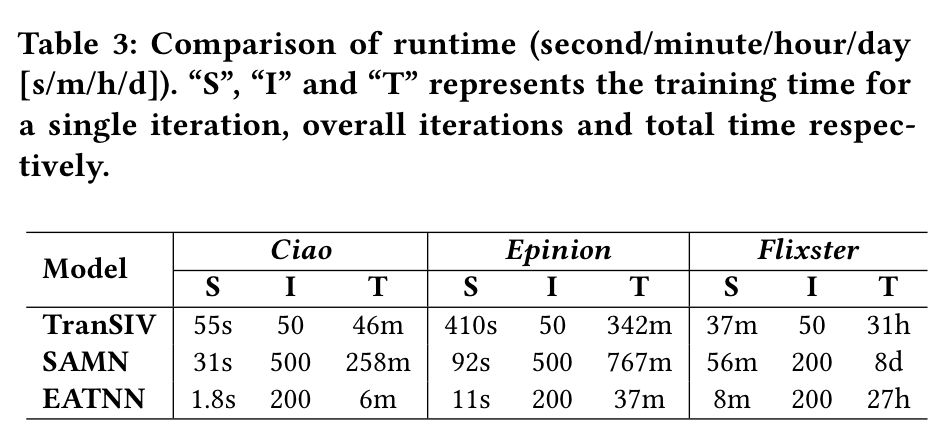

训练效率

我们也在相同的机器上对比了 EATNN 和基于社交信息的推荐算法的训练效率(Intel Xeon 8-Core CPU of 2.4 GHz and single NVIDIA GeForce GTX TITAN X GPU)。各个模型所需训练时间如下表所示:

从表中可以看到,我们的方法 EATNN 所需要的训练时间显著少于对比方法。比如,在最大的 Flixster 数据集上,同样是神经网络方法,SAMN 需要 8 天才能训练完毕,而我们的 EATNN 只需要 27 小时。对于其他两个数据集,EATNN 在效率上的提升同样引人注目。

该部分工作发表在 CCF A 类会议:

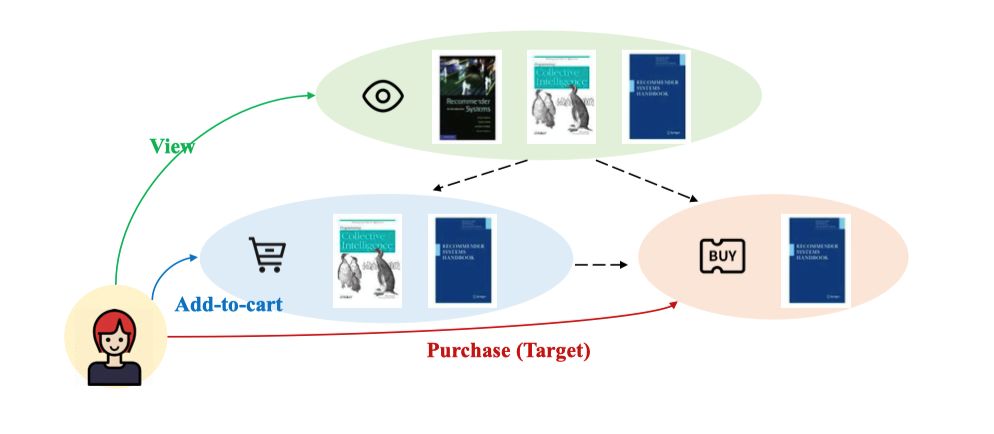

基于多行为数据的推荐系统场景

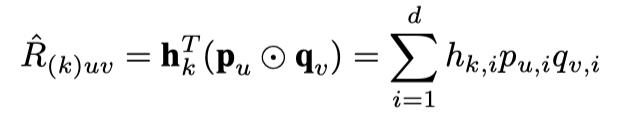

对第 k 种行为的预测函数:

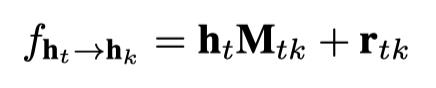

从行为 t 到 k 的转移函数:

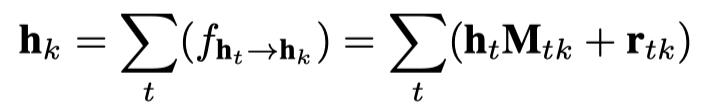

行为 k 的预测向量定义如下:

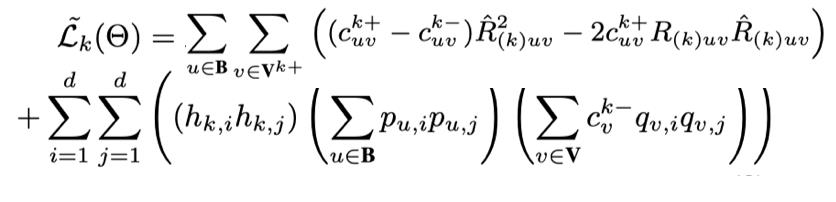

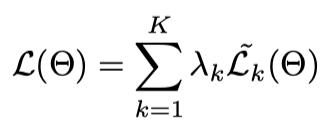

我们同样使用所设计的高效非抽样算法对每种行为进行优化:

多任务学习:

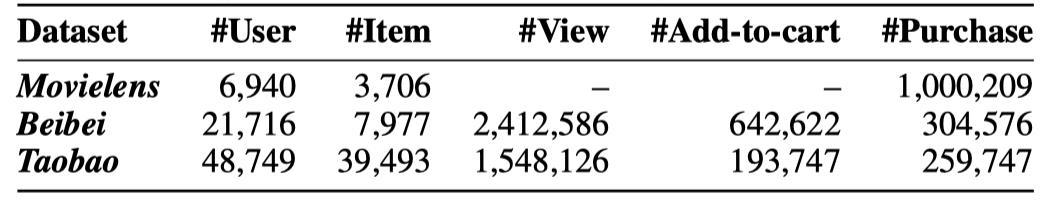

数据集

为了验证所提出的 EHCF 的效果,我们在 3 个公开数据集上进行了实验,数据集如下所示:

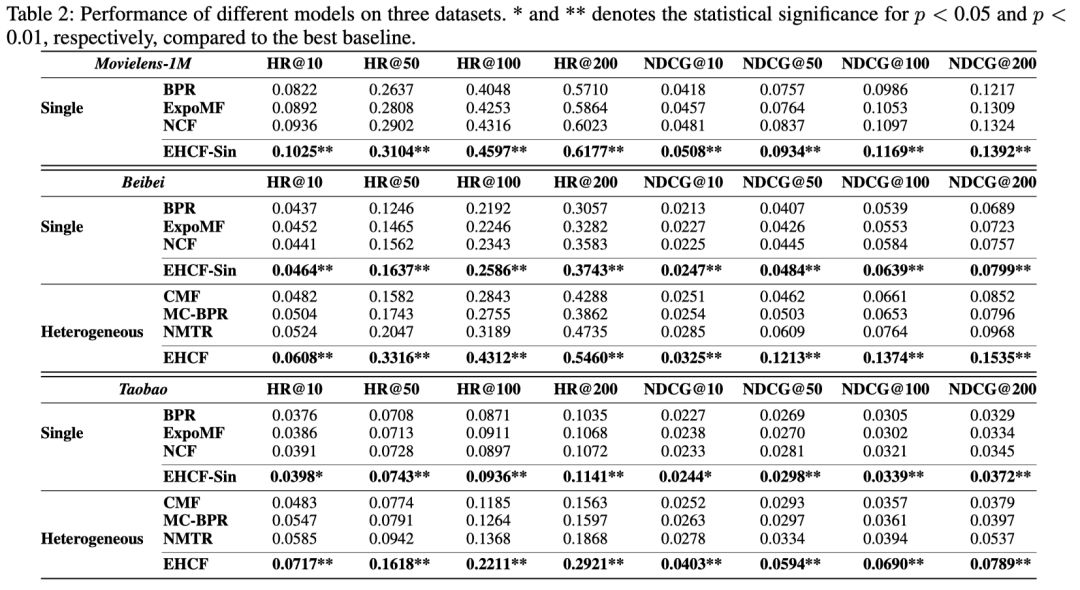

对比方法

我们对比了多个 state-of-the-art 推荐模型,包括单行为模型 BPR (UAI’09),ExpoMF (WWW’16),NCF (WWW’17) 以及多行为模型 CMF (WWW’15),MC-BPR (RecSys’16),以及 NMTR (ICDE’19, TKDE’20)。

模型表现

从表中可以看到,我们的方法 EHCF 所需要的训练时间显著少于对比方法。比如,在 Taobao 数据集上,同样是基于神经网络的多行为推荐模型,NMTR 需要 600 分钟(10 小时)才能训练完毕,而 EHCF 只需要 54 分钟,比 NMTR 快了 10 倍。在 Beibei 数据集上,EHCF 的训练时间比 NMTR 快了超过 20 倍。

该部分工作发表在 CCF A 类会议:

包含特征(feature)和上下文(context)的推荐系统场景

为了提供更准确的推荐结果,考虑用户和商品的特征以及上下文是非常重要的。考虑上下文的推荐系统(Context-aware Recommendation)正是这样一个任务。

分解机模型(Factorization Machines,FM)是一类很好的考虑上下文的推荐方法。然而,现有的对于 FM 的研究主要集中于使用不同的神经网络结构来建模高阶(high-order)关系,并且这些工作往往致力于解决评分预测(而不是 Top-N 推荐)任务。

虽然也有一些研究者结合负采样策略和 FM 来提供推荐结果,但由于负采样的不稳定性(容易忽视重要的训练样例导致训练不足),我们认为现有的 FM 方法对于考虑上下文的 Top-N 推荐系统仍然是不足够的。

在这部分工作中,我们提出从全部数据中学习 FM 来进行 Top-N 推荐,并设计了一个高效的非采样分解机框架(Efficient Non-Sampling Factorization Machines, ENSFM)。通过严格的数学推导,ENSFM 不仅在两类常用的推荐方法——分解机(FM)和矩阵分解(MF)之间建造了一个桥梁,并且可以高效的从整体数据中学习 FM 参数。

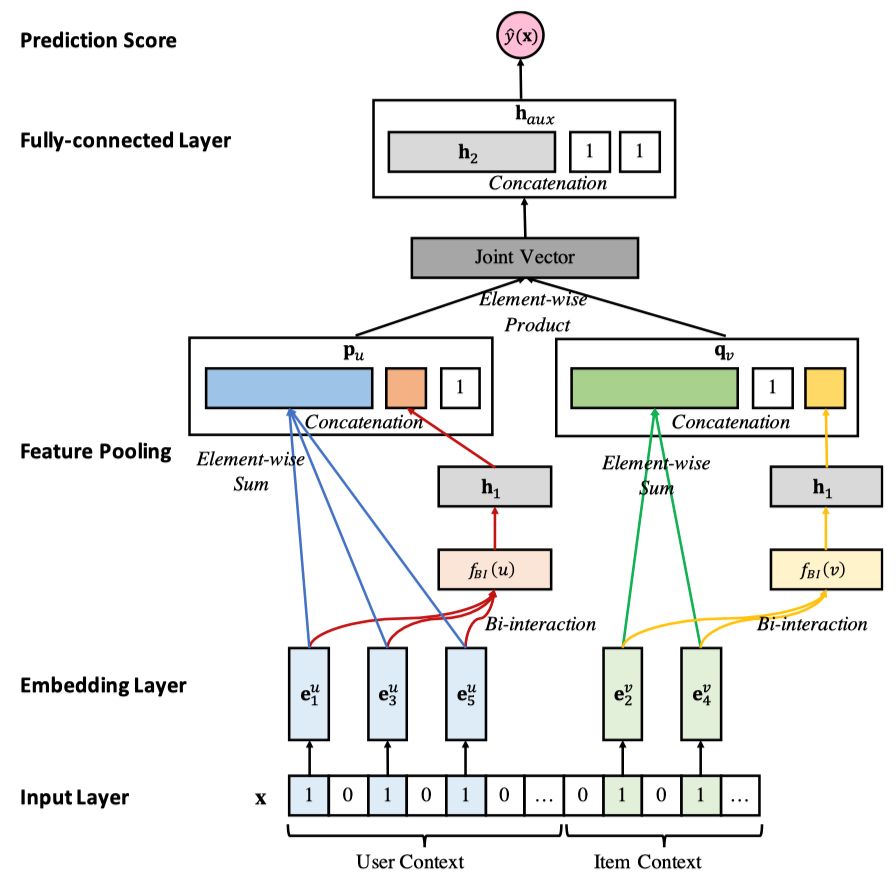

所设计的 ENSFM 框架如下所示:

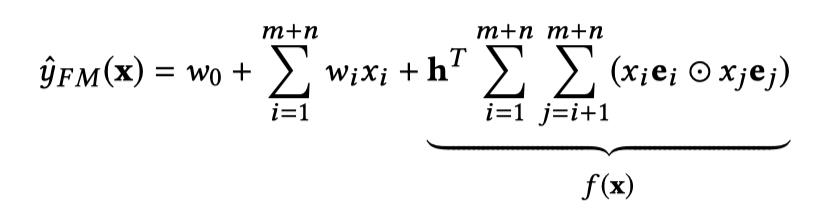

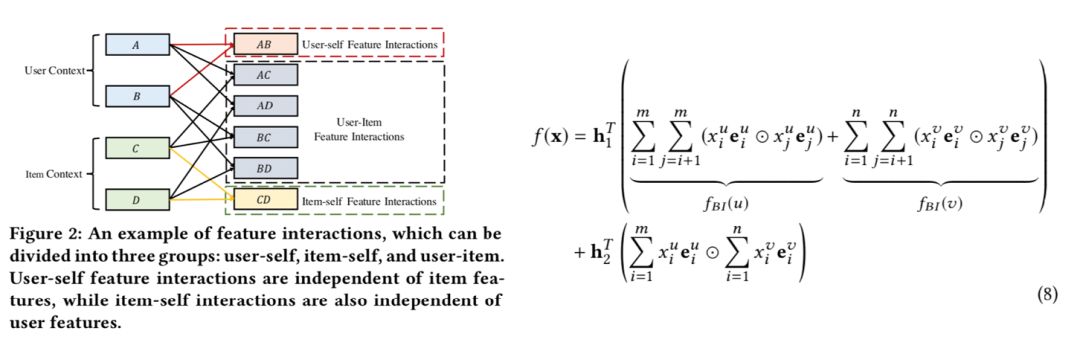

ENSFM 的预测函数是一个泛化的 FM 函数:

我们首先给出一个结论:

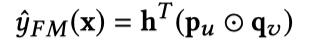

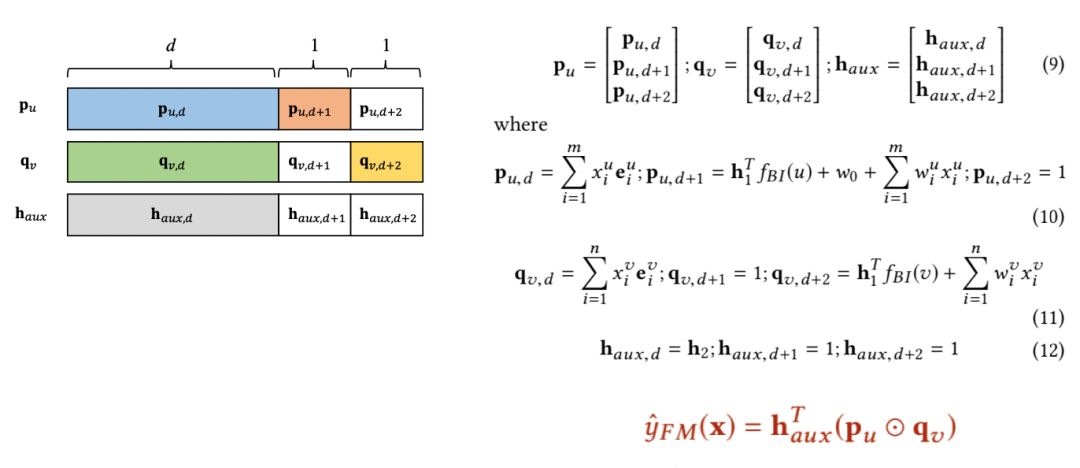

定理 2:一个泛化的 FM 预测函数可以重构成一个矩阵分解的形式:

其中 ![]() 只跟 u 的上下文相关,

只跟 u 的上下文相关,![]() 只跟 v 的上下文相关。

只跟 v 的上下文相关。

证明(详细证明请参考论文):

首先对 f(x) 展开,分成只跟用户 u 相关的 ![]() ,只跟商品 v 相关的

,只跟商品 v 相关的 ![]() ,以及跟用户和商品都相关的部分:

,以及跟用户和商品都相关的部分:

第二步,我们构建 3 个辅助向量如下:

得证。

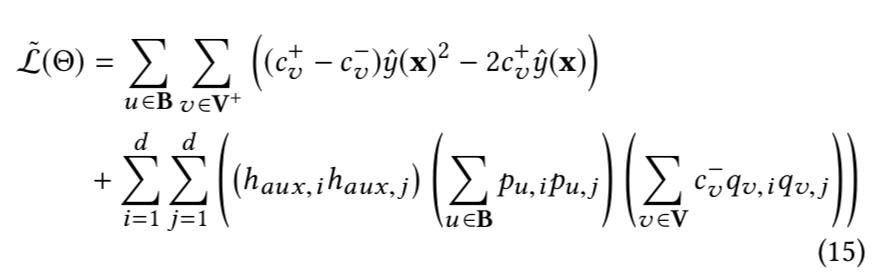

根据定理 1 和定理 2,我们可以得到 ENSFM 的高效非抽样 loss:

数据集

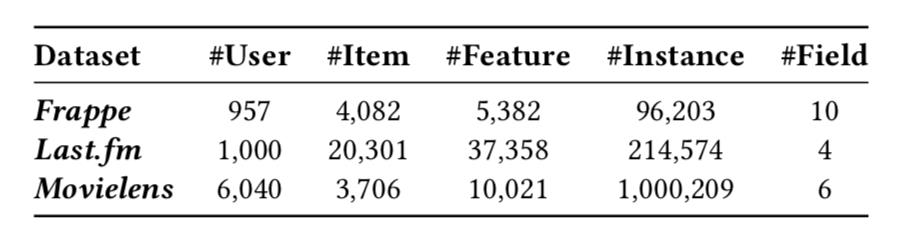

为了验证所提出的 ENSFM 的效果,我们在 3 个公开数据集上进行了实验,数据集如下所示:

数据集中 Frappe 和 Last.fm 和 CFM (IJCAI’19) 论文中使用的完全一致。

对比方法

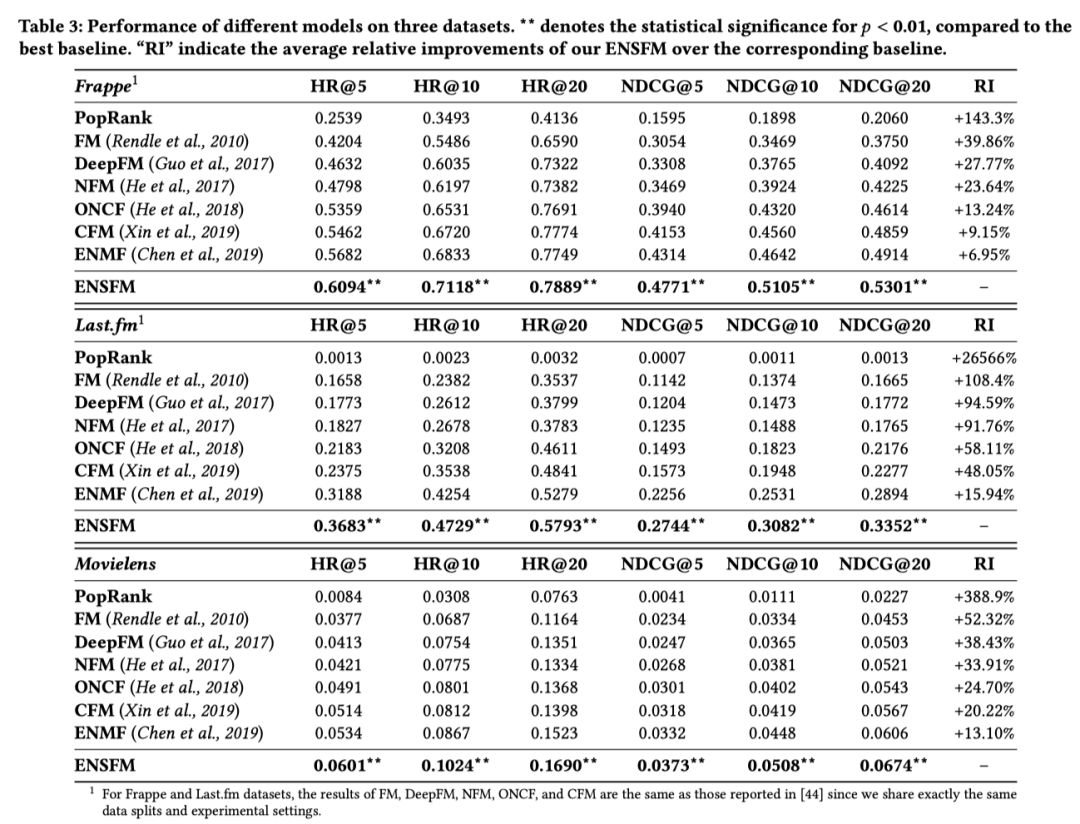

我们对比了多个 state-of-the-art 推荐模型,包括 FM (ICDM’10),DeepFM (IJCAI’ 17),NFM (SIGIR’17),ONCF (IJCAI’18),CFM (IJCAI’19) 以及我们之前的 ENMF (TOIS’20)。

模型表现

实验结果如上表所示,首先,我们的 ENSFM 效果显著优于所有的对比方法。与各种 FM 方法,包括最近提出的基于 CNN 的 CFM 相比,ENSFM 在三个数据集上的相对提升分别超过了 9.15%,48.05% 以及 20.22%。

ENSFM 是一个只有一层预测层的浅 FM 模型,跟 DeepFM, CFM 相比在复杂度和参数量上都更少,却在模型效果上表现显著的优势。这样的结果再一次验证了我们的观点:负采样策略并不足以使模型收敛到最优。与之相比,非采样学习对于优化 Top-N 推荐任务是非常有效的。

同时也可以看到,虽然深度学习的方法如 NFM, DeepFM, CFM 在使用同样的负采样训练时表现会优于 FM,所带来的提升相比于我们的 ENSFM 是相对较小的,这也显示了一个行之有效的学习方法有时候比更深更复杂的神经网络所带来的提升更加明显。

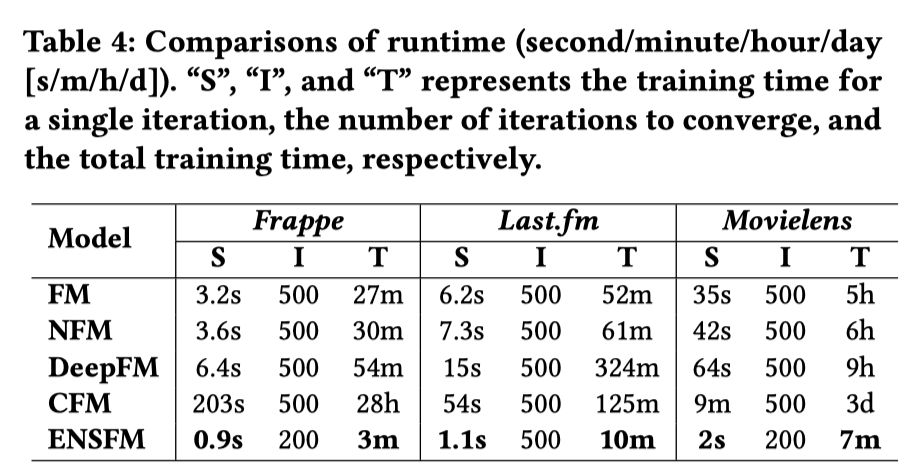

训练效率

我们也在相同的机器上对比了 ENSFM 和对比算法的训练效率(Intel Xeon 8-Core CPU of 2.4 GHz and single NVIDIA GeForce GTX TITAN X GPU)。各个模型所需训练时间如下表所示:

表中的实验结果显示,我们的 ENSFM 相比于现有的 FM 算法在训练效率上展现出巨大的优势。如在 Movielens 数据集上,已有的各种 FM 方法分别需要 5 小时,6 小时,9 小时和 3 天才能训好,而 ENSFM 只需要 7 分钟即可训练完毕,这比 NFM 快了 50 倍,以及比 CFM 快了 600 倍。这验证了我们新提出的非采样学习方法的高效性。

该部分工作发表在 CCF A 类会议:

约束,能够作为辅助的监督信息,适用于多种基于匹配代价体的立体匹配方法。

点击以下标题查看更多往期内容:

#投 稿 通 道#

让你的论文被更多人看到

如何才能让更多的优质内容以更短路径到达读者群体,缩短读者寻找优质内容的成本呢?答案就是:你不认识的人。

总有一些你不认识的人,知道你想知道的东西。PaperWeekly 或许可以成为一座桥梁,促使不同背景、不同方向的学者和学术灵感相互碰撞,迸发出更多的可能性。

PaperWeekly 鼓励高校实验室或个人,在我们的平台上分享各类优质内容,可以是最新论文解读,也可以是学习心得或技术干货。我们的目的只有一个,让知识真正流动起来。

以上是关于浅谈个性化推荐系统中的非采样学习的主要内容,如果未能解决你的问题,请参考以下文章