Azure Data PlatformETL工具——使用Azure Data Factory数据流传输数据

Posted 發糞塗牆

tags:

篇首语:本文由小常识网(cha138.com)小编为大家整理,主要介绍了Azure Data PlatformETL工具——使用Azure Data Factory数据流传输数据相关的知识,希望对你有一定的参考价值。

本文属于【Azure Data Platform】系列。

接上文:【Azure Data Platform】ETL工具(4)——Azure Data Factory Debug 管道

本文介绍如何 ADF 的数据流传输数据。

前面的几篇文章主要集中在“复制数据”工具的使用上。

数据传输

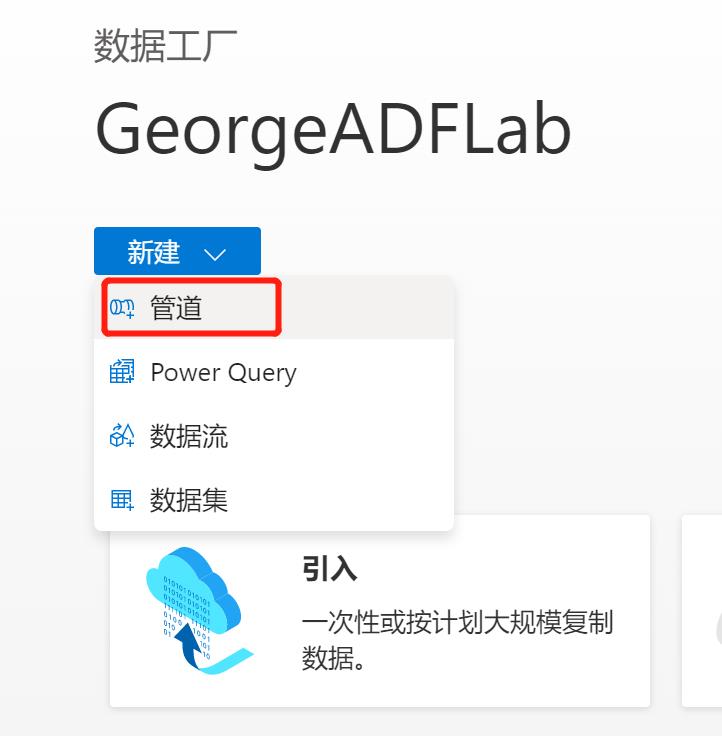

本次演示把Azure SQL DB中的一个表的值计算后,再写入一个新表中。为此,先在管道中创建一个data flow:

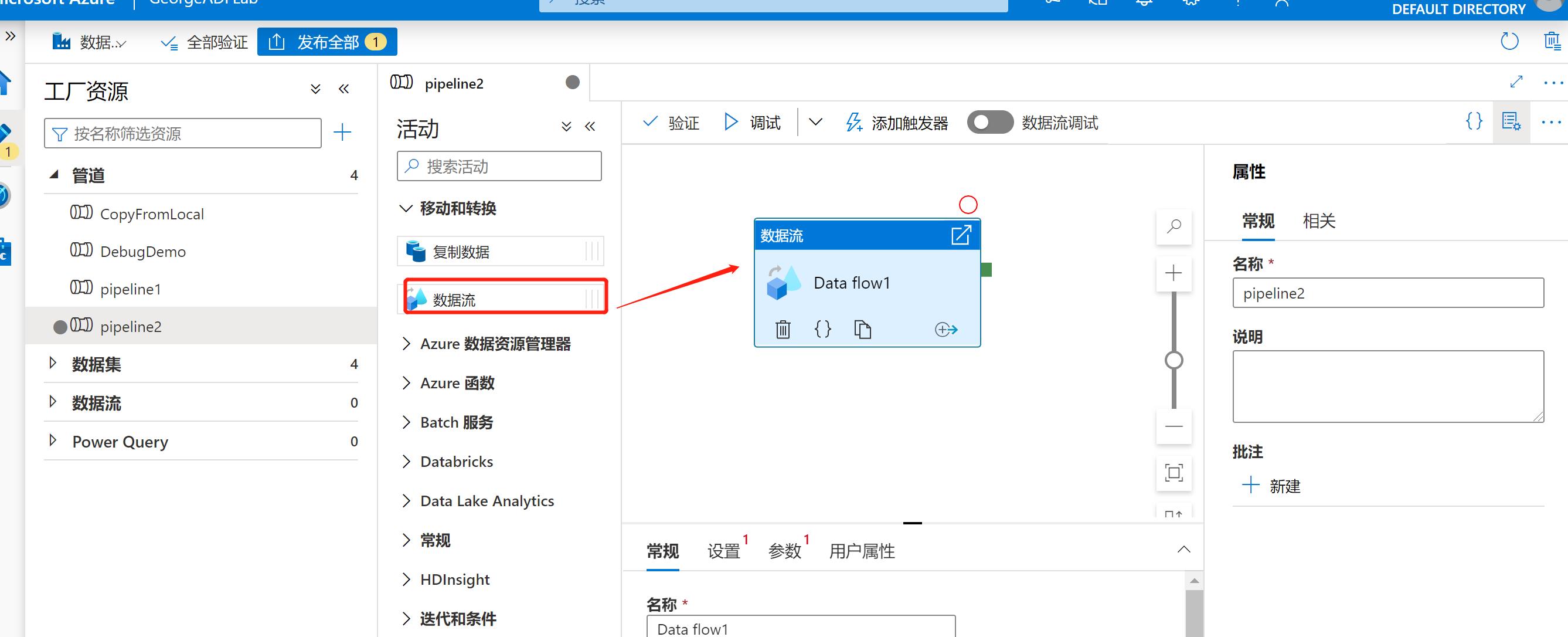

新建一个数据流:

添加源:

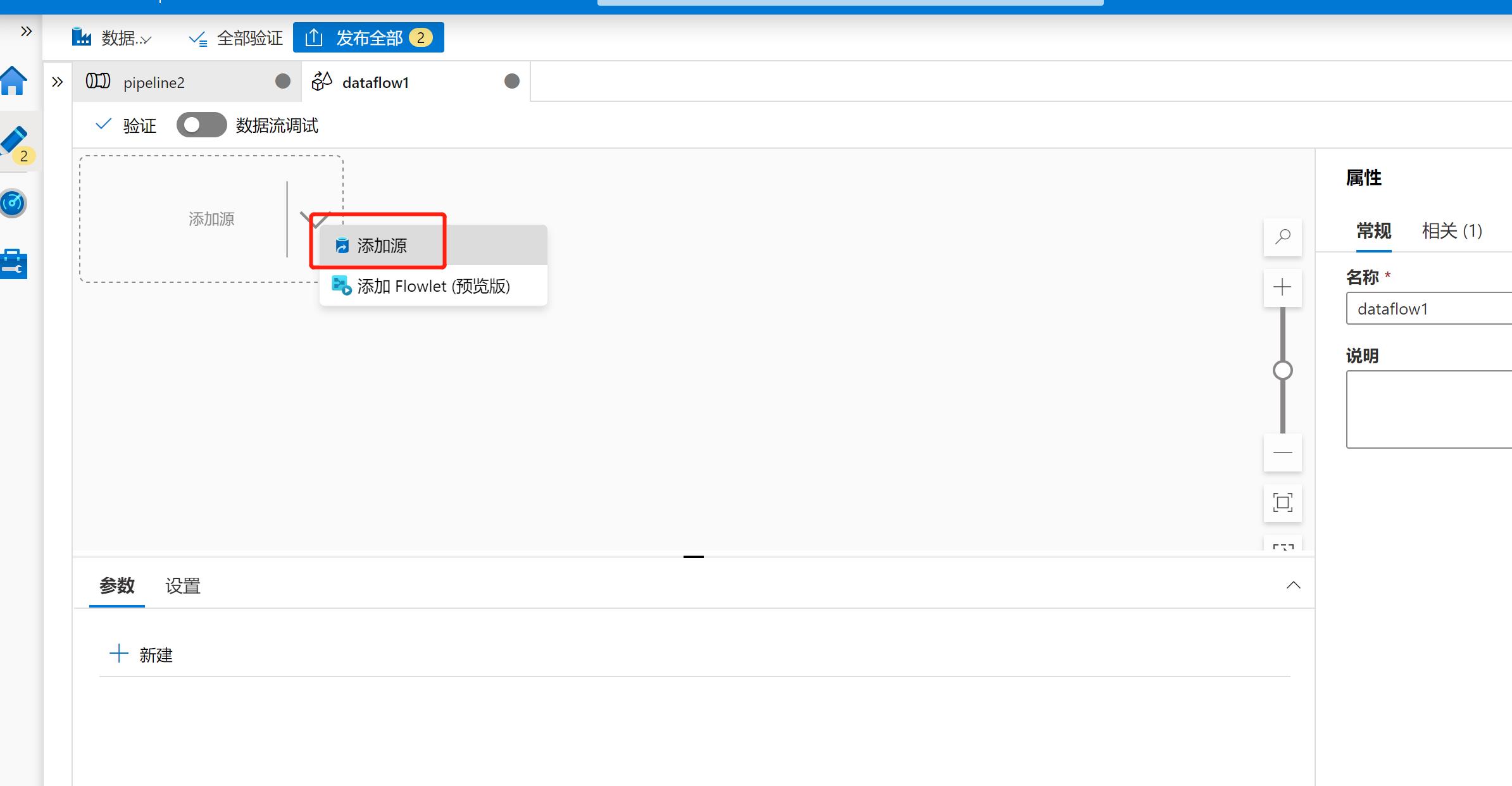

这里新建一个新的源以便与前面的区分开:

新建链接服务以便ADF能够访问Azure SQL DB:

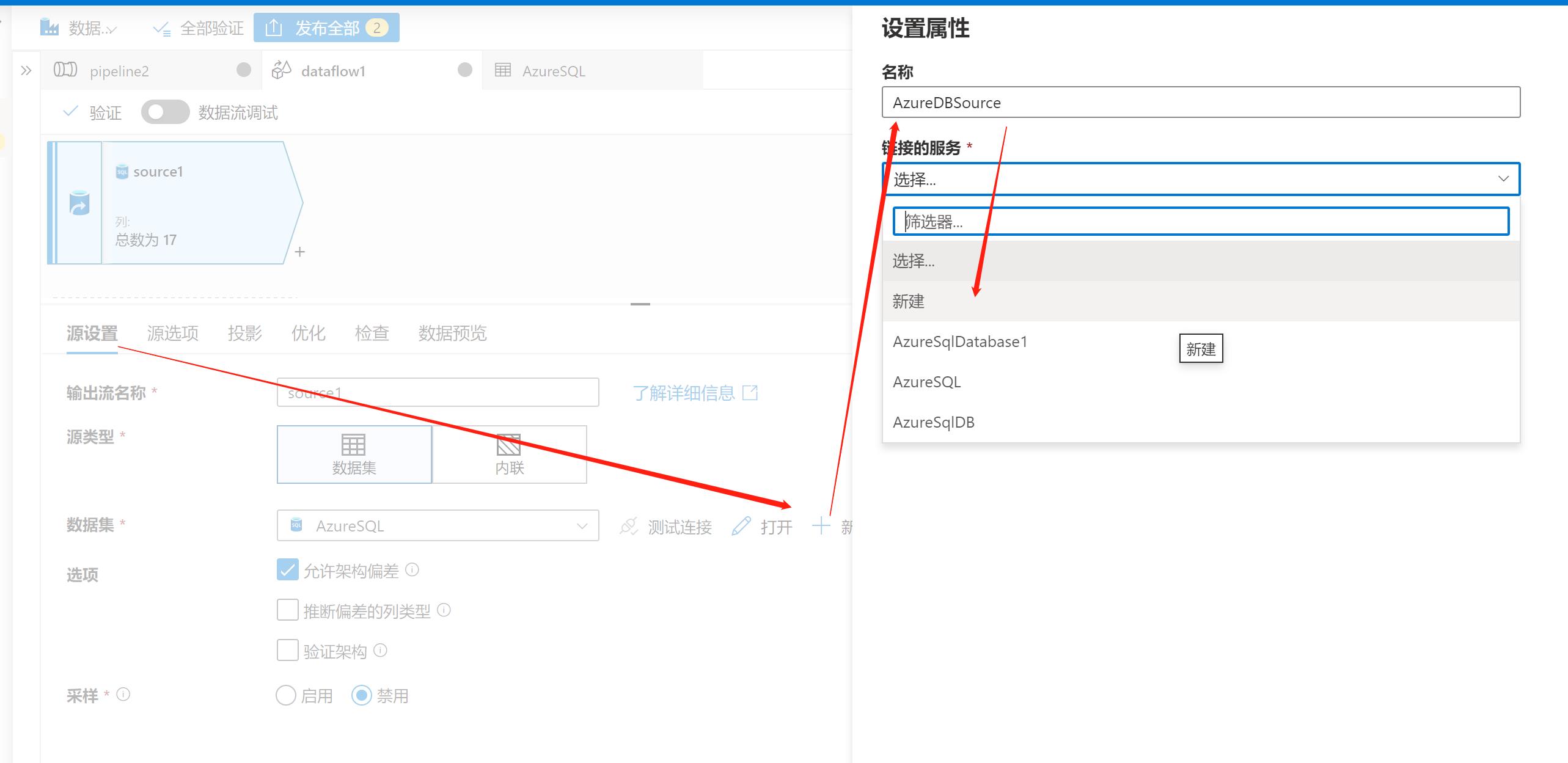

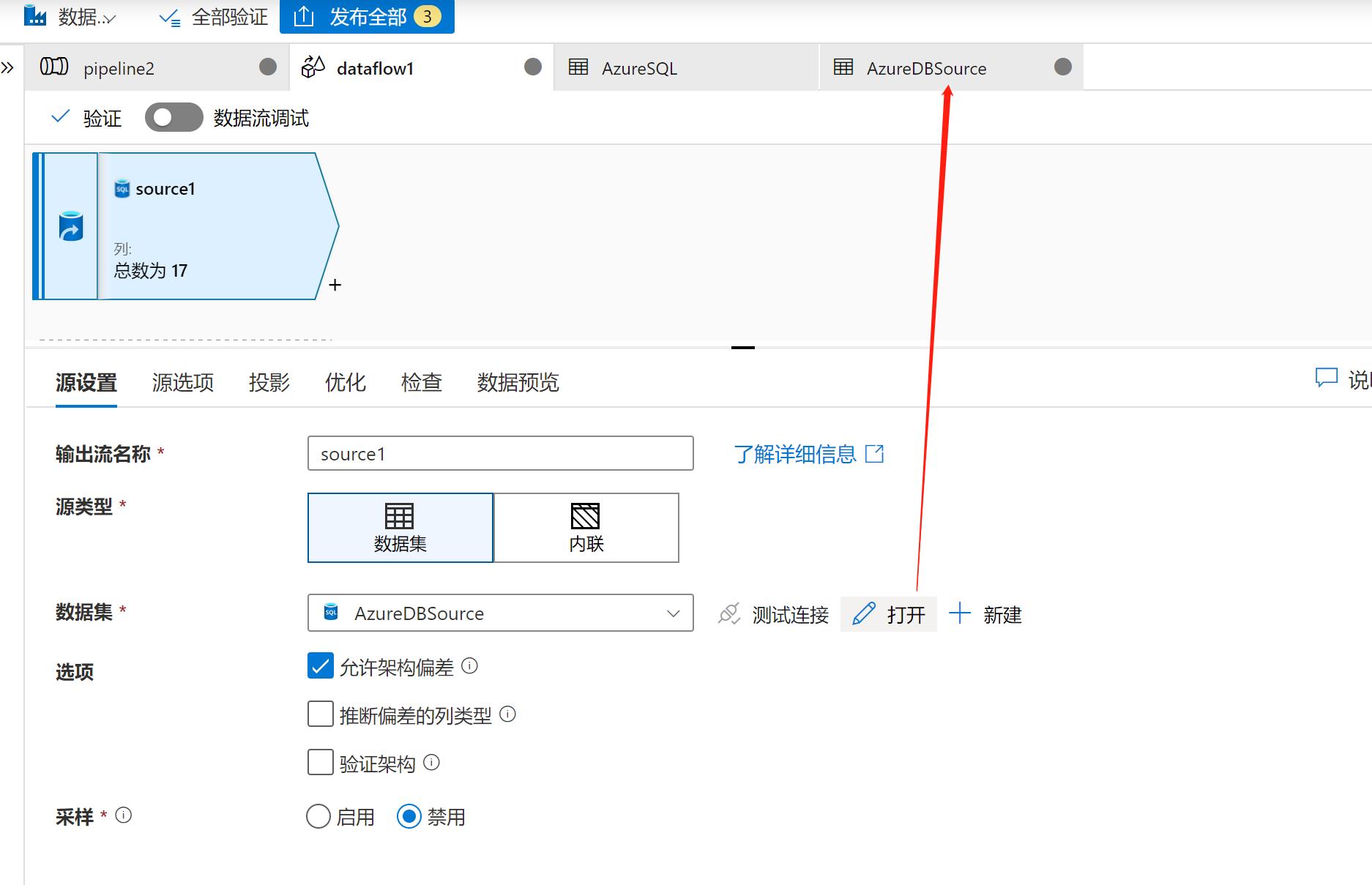

打开源,配置具体的源选项:

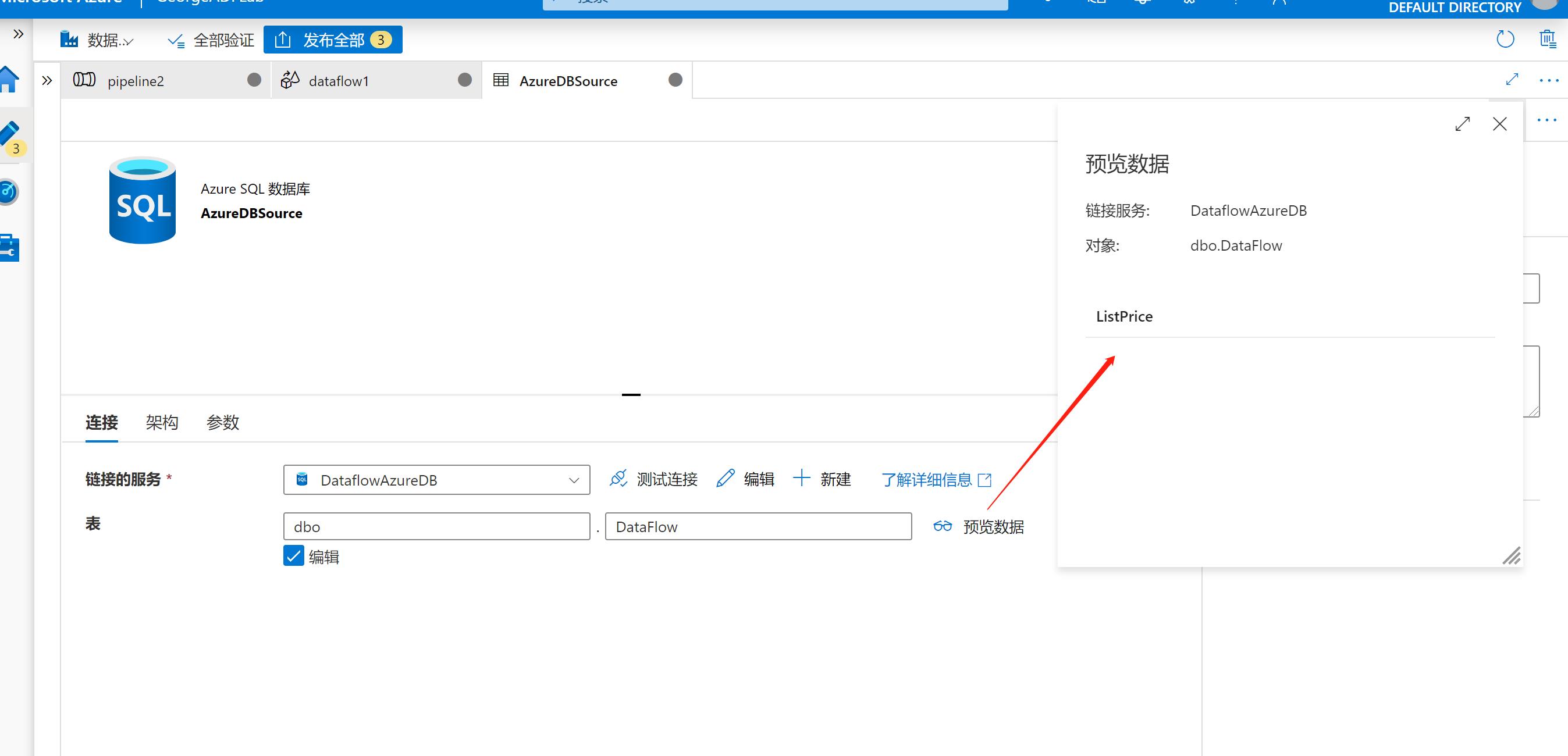

选择需要处理的表,可以从“预览数据”中检查是否连通:

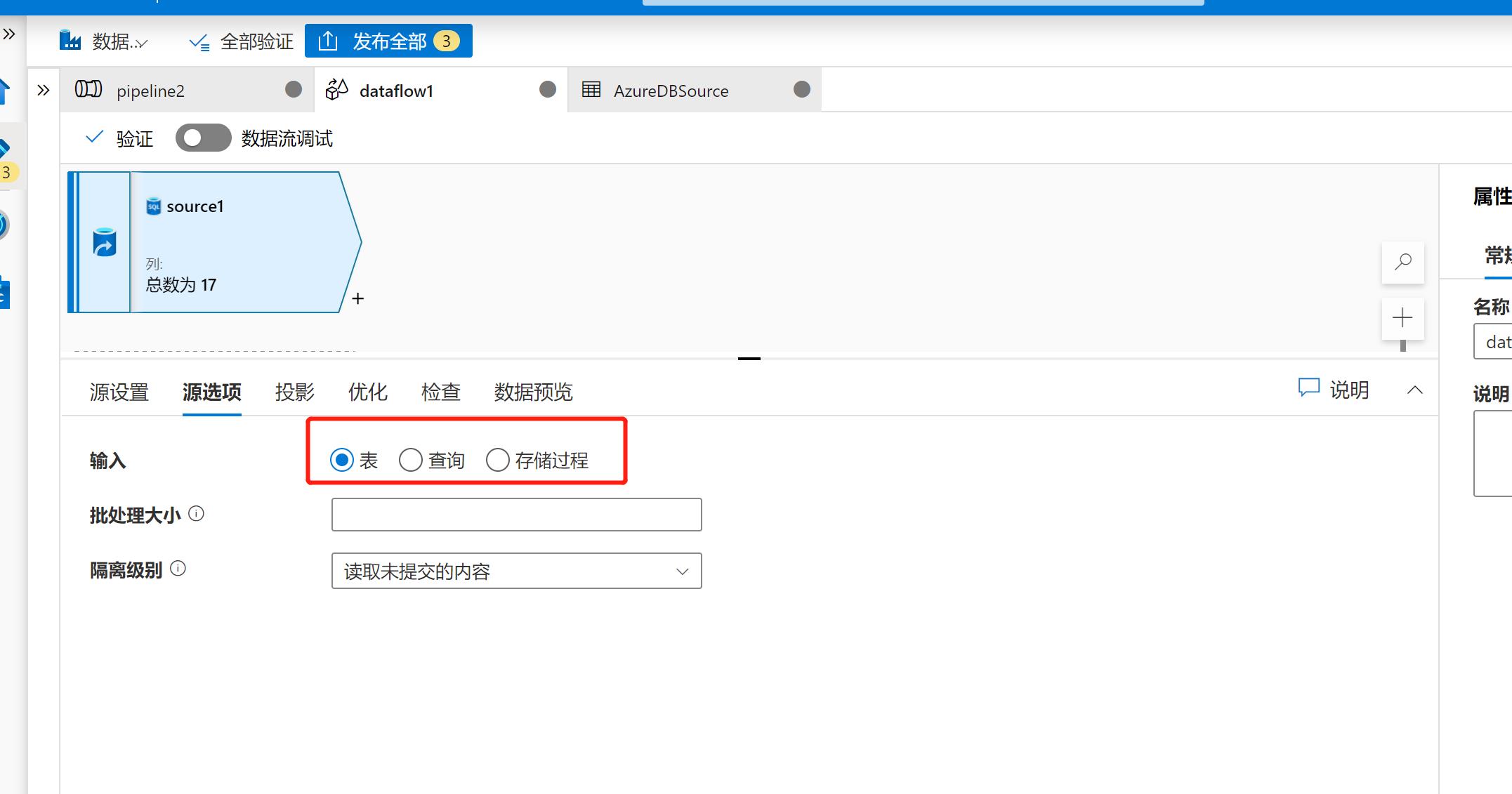

在源选项中,可以定义全表操作,还是使用特定的SQL/存储过程来处理数据, 同时还可以定义批处理的大小及隔离级别。

在【优化】选项中, 还能对已分区的表进行额外的处理。

然后点击【检查】选项,查看源表的表定义:

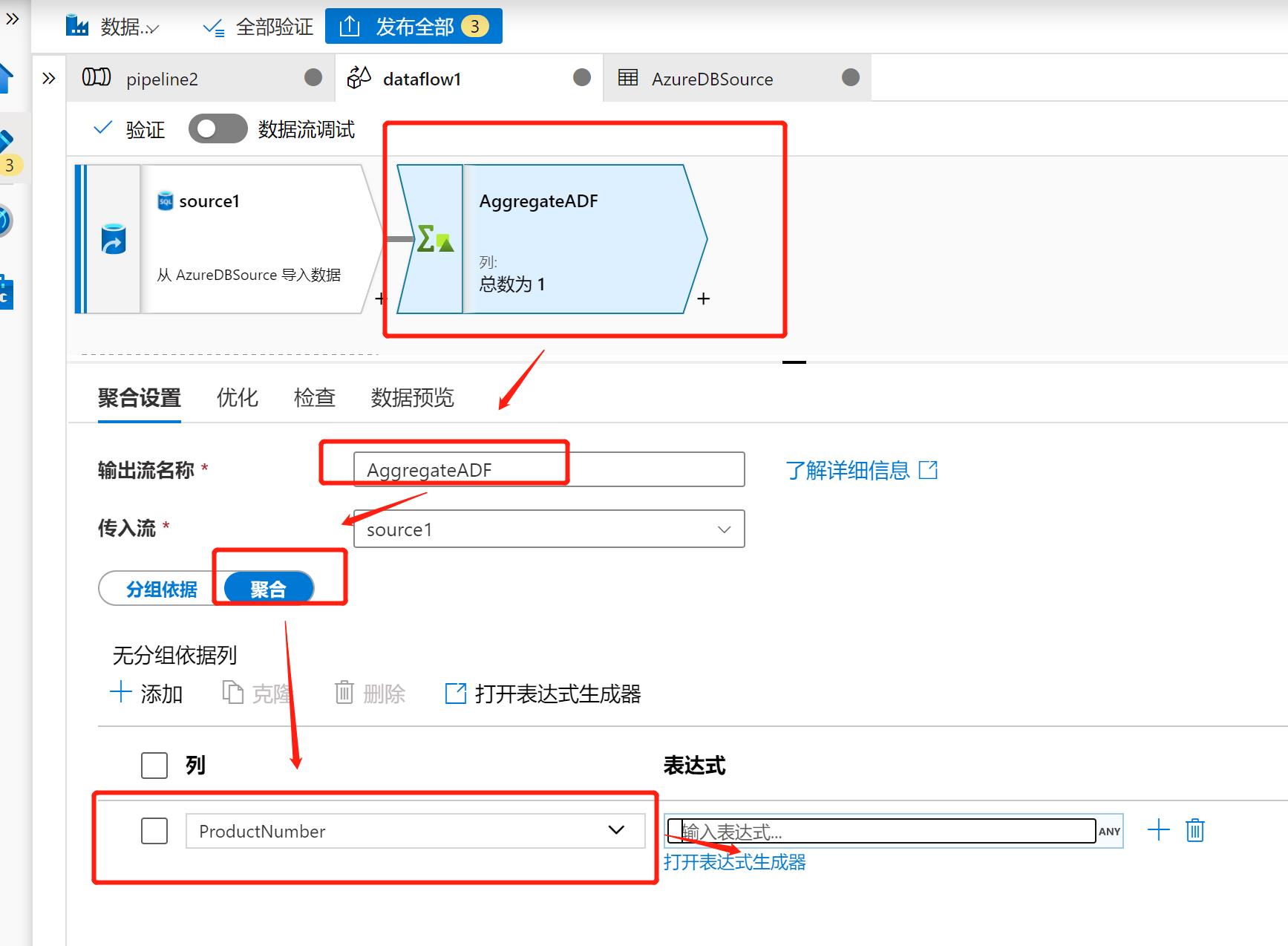

然后点击图形化界面中右下角的【+】, 如图所示,配置一个数据处理操作,这里选择聚合。

按下图顺序选择需要处理的列,在最后一步【打开表达式生成器】中我们选择需要处理的列和操作:

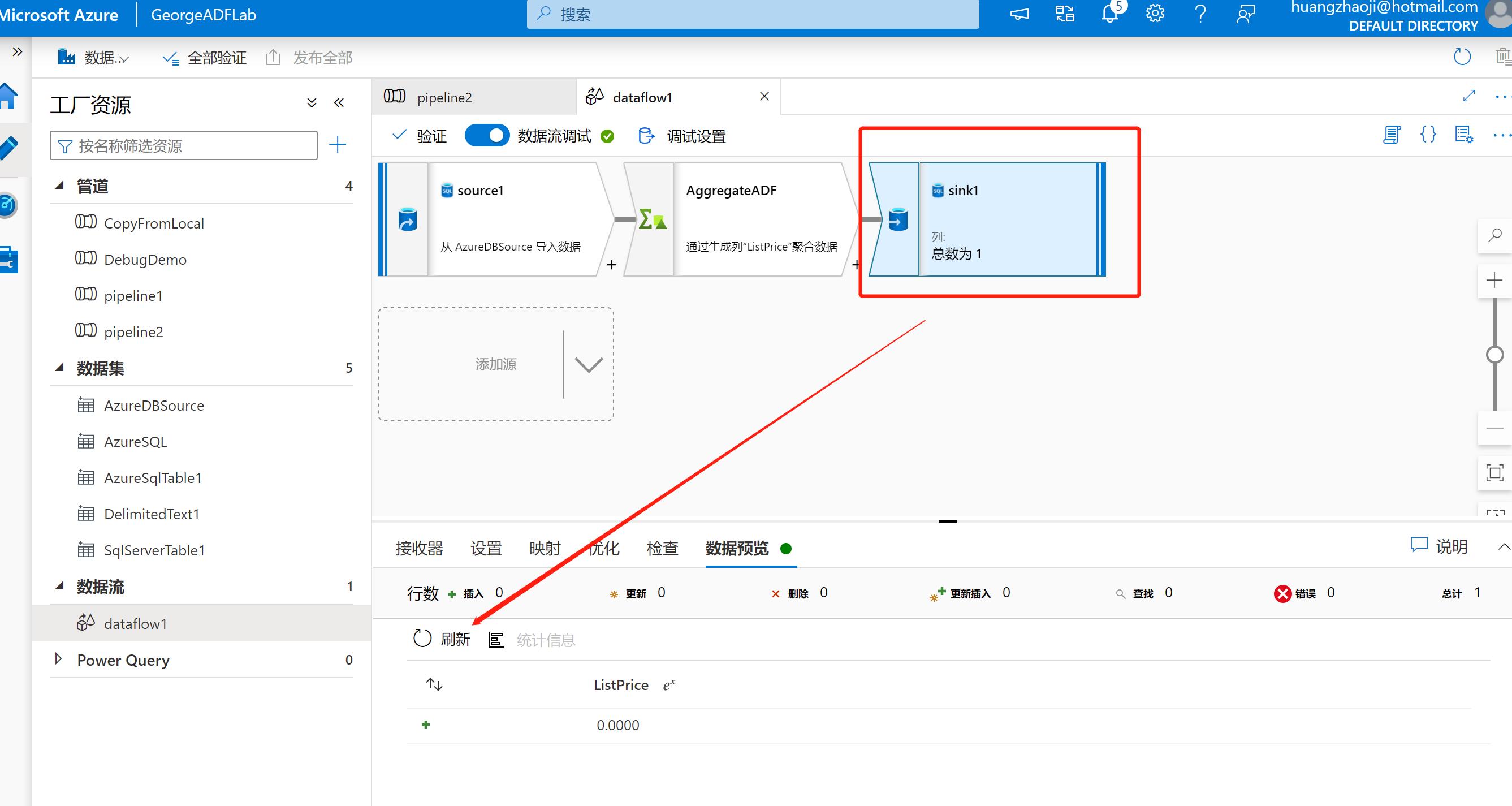

选择ListPrice列,然后使用countAll函数进行计算:

接下来再加一个流程【接收器】,意味着目标源,为了方便期间,这里选择同一个Azure SQL DB的库,只是使用不同的表:

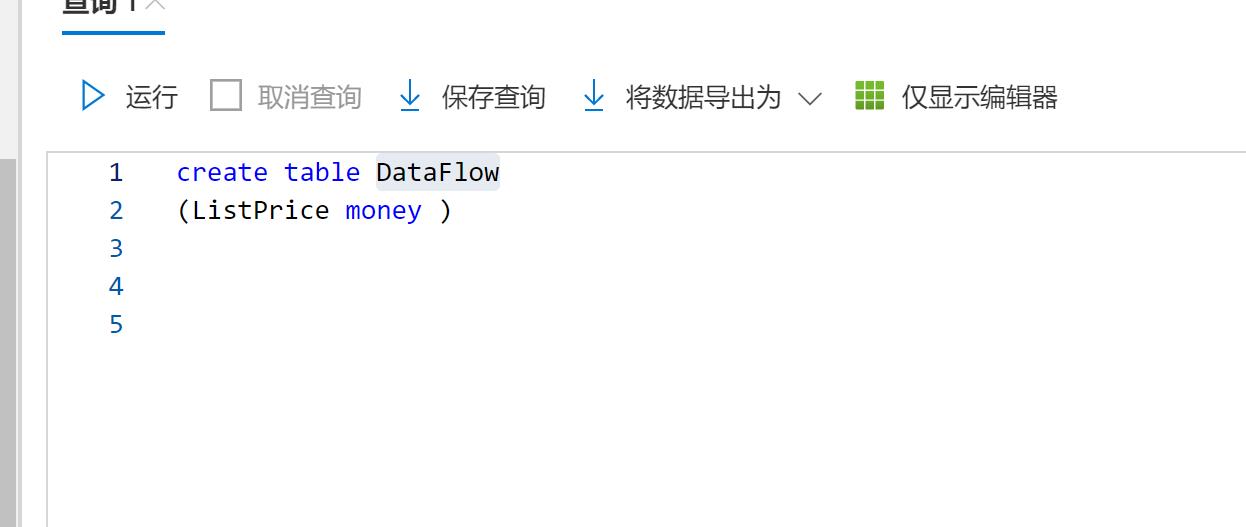

为方便期间,这里先创建好目标表:

在目的地中输入这个表并查看数据,可见目前表是空的。

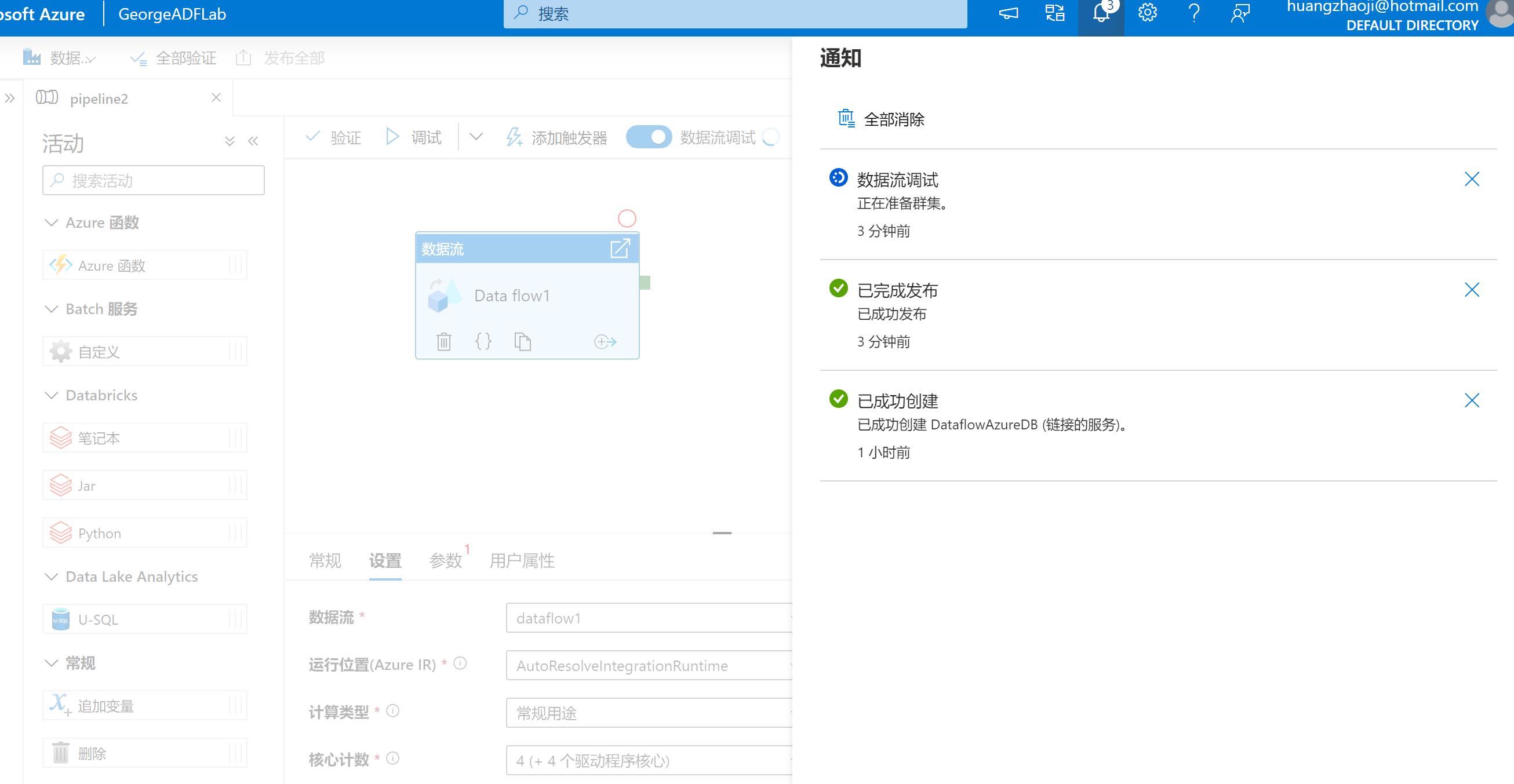

当所有东西都配置完毕之后,发布这个管道:

发布完毕后,使用调试功能,可以手动触发管道的执行。 从下图中可以看到已经有了计算结果:

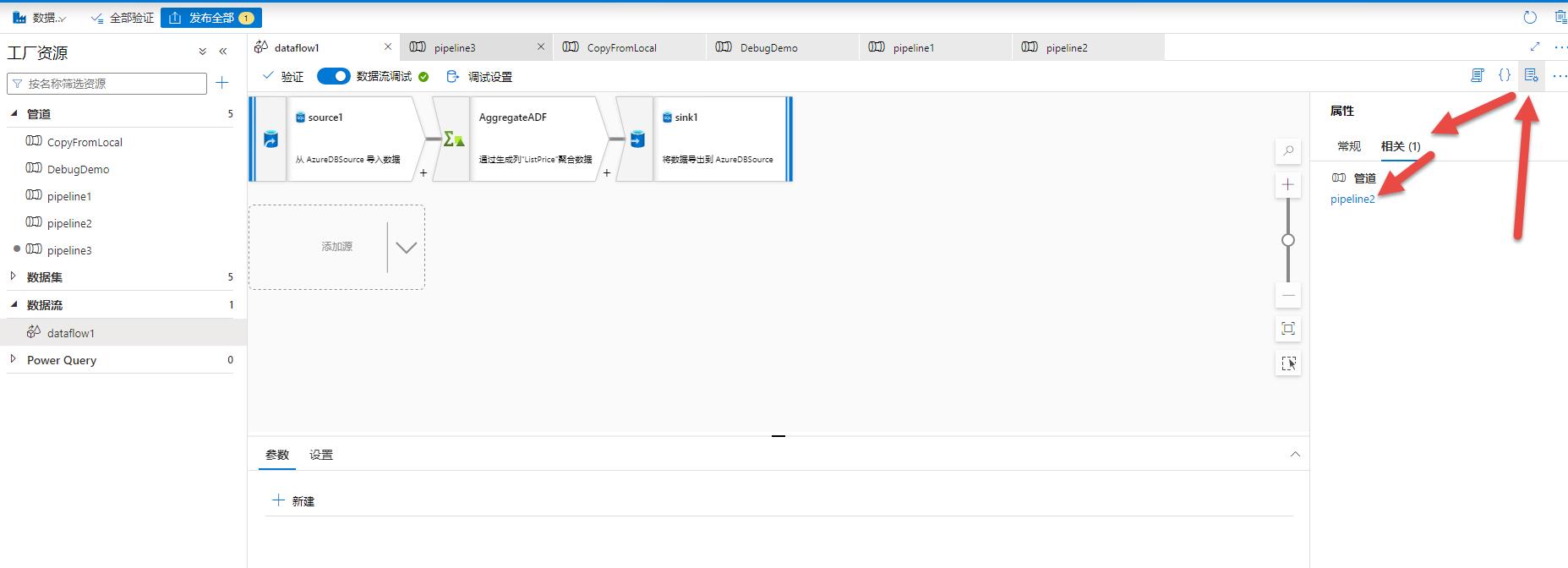

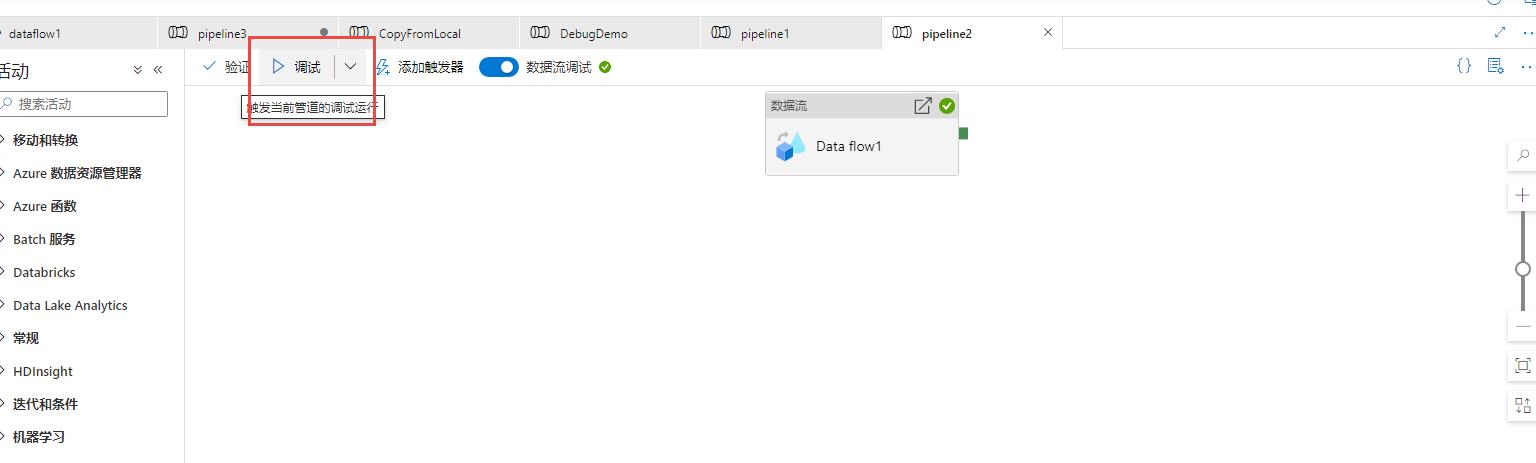

但是前面都还是调试模式,要实际运行,需要跳回Data Flow所在的管道:

然后点击调试,正如前文提到,调试按钮会实际执行管道,从而数据会真正计算并写入目标:

在数据表中查看可以看到已经实际运行了:

总结

目前为止,我们实现了用数据流进行数据传输,下一文我们演示一下如何执行SSIS包。在本次演示过程,本人学到了一个“新技能”, 就是单纯在Data flow上调试,数据是不会真正写到目标的,需要在所在的管道上执行才可以。

以上是关于Azure Data PlatformETL工具——使用Azure Data Factory数据流传输数据的主要内容,如果未能解决你的问题,请参考以下文章

Azure Data PlatformETL工具(19)——Azure Databricks

Azure Data PlatformETL工具(20)——创建Azure Databricks

Azure Data PlatformETL工具(20)——创建Azure Databricks

Azure Data PlatformETL工具——重新认识Azure Data Factory