Spark 安装和配置

Posted

tags:

篇首语:本文由小常识网(cha138.com)小编为大家整理,主要介绍了Spark 安装和配置相关的知识,希望对你有一定的参考价值。

参考技术A 单机搭建打开 http://localhost:50070/explorer.html 网页查看hadoop目录结构,说明安装成功

加入环境变量

设置配置文件

默认slaves现在就主机一台

jps 查看到多出一个Master,worker进程

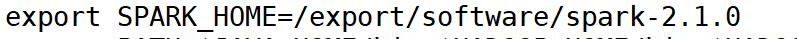

配置scala 、spark 、 hadoop 环境变量加入PATH ,方便执行

查看执行状态

http://localhost:8080 ,查看spark 集群运行情况。 此端口一般与其他端口冲突

在spark-env.sh 中加入 export SPARK_MASTER_WEBUI_PORT=98080 来指定端口

http://localhost:4040/jobs/ ,查看 spark task job运行情况

http://localhost:50070/ hadoop集群运行情况

Spark2.1.0安装和配置

一、scala的安装与配置

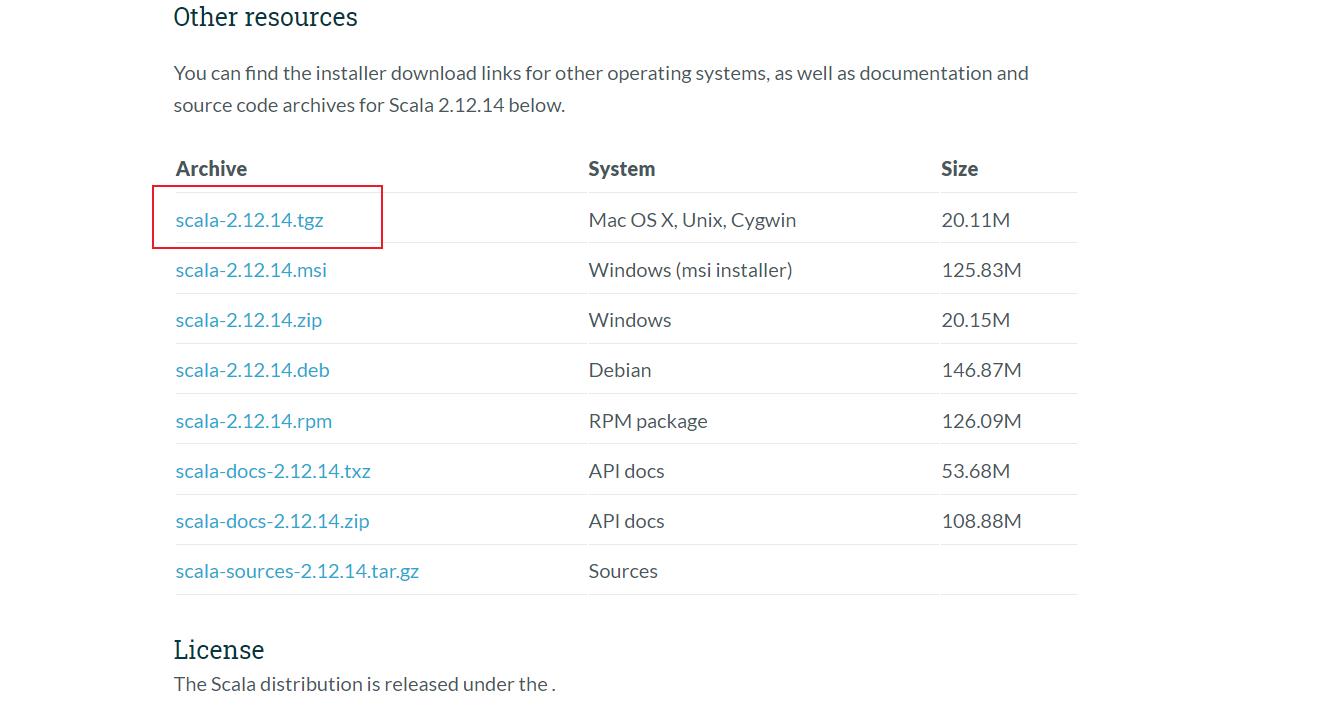

1.scala的下载

下载地址为:scala下载地址

2.scala的安装与配置

(1)安装包的解压

tar -zxvf scala-2.12.14.tgz

mv scala-2.12.14 /export/software/

(2)环境变量的配置

在命令行中输入如下命令,打开profile配置文件

vi /etc/profile

打开profile文件后在文件末尾加入如下配置语句:

然后再命令行中输入source/etc/profile使环境变量生效。

在命令行输入scala,能进入scala命令行说明安装成功.

注意!:退出Scala的命令为 :quit

注意!:退出Scala的命令为 :quit

二、spark的安装与配置

1.spark的下载

下载地址为:spark下载地址

下载对应的Hadoop版本的spark,这里我的Hadoop版本为

2.4.1,因此如图选择对应的版本。

2.spark的安装与配置

和Scala的安装与配置一样,先进行解压,然后打开profie文件配置环境变量。

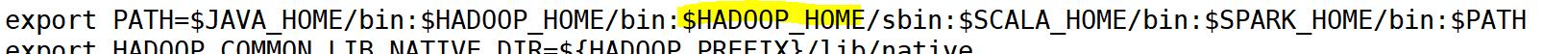

3.配置conf/spark-env.sh 文件

进入到conf目录下会发现spark-env.sh为临时文件,须重命名为spark-env.sh

执行如下命令:

mv spark-env.sh.template spark-env.sh

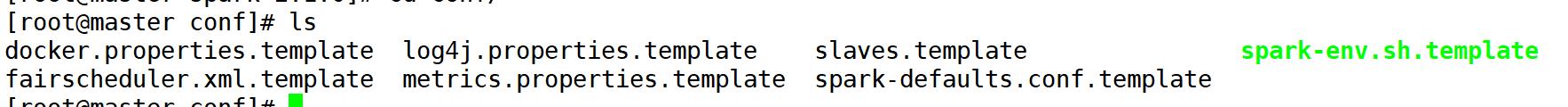

在文件中加入如下内容:

export SCALA_HOME=/export/software/scala-2.12.14

export JAVA_HOME=/export/software/jdk1.8.0_161

export SPARK_WORK_MEMORY=4g

export SPARK_MASTER_IP=master

export MASTER=spark://master:7077

参数解释:

- SPARK_WORK_MEMORY 决定在每一个Worker节点上可用的最大内存,增加这个数可以在内存中缓存更多数据,但一定要给Slave的操作系统和其他服务预留足够内存

- SPARK_MASTER_IP 参数可以是具体的IP地址也可以是hostname,系统会更具hosts文件进行解析

- MASTER 配置端口号

PS:SPARK_MASTER_IP和MASTER必须配置否则会造成Slave无法注册主机错误

配置conf/slaves 文件 将节点的主机名加入到slaves文件中

slave1

slave2

4.启动Spark集群

在启动前,将scala文件、spark文件以及etc目录下的profile文件传给slave1和slave2,并在slave1和slave2命令行中输入source/etc/profile使环境变量生效

进入spark目录下,输入如下命令:

sbin/start-all.sh

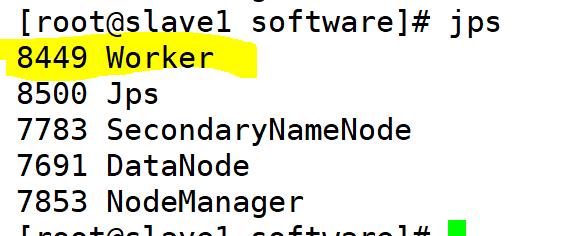

如上图所示说明启动成功,这时候分别在三个节点上通过jps查看进程,则如下图所示:

至此spark的安装结束,也已成功启动,如需停止,输入如下命令:

sbin/stop-all.sh

以上是关于Spark 安装和配置的主要内容,如果未能解决你的问题,请参考以下文章

spark HA 安装配置和使用(spark1.2-cdh5.3)