新手Python里面requests模块的问题

Posted

tags:

篇首语:本文由小常识网(cha138.com)小编为大家整理,主要介绍了新手Python里面requests模块的问题相关的知识,希望对你有一定的参考价值。

response=requests.get("url")

print(response.request.url)

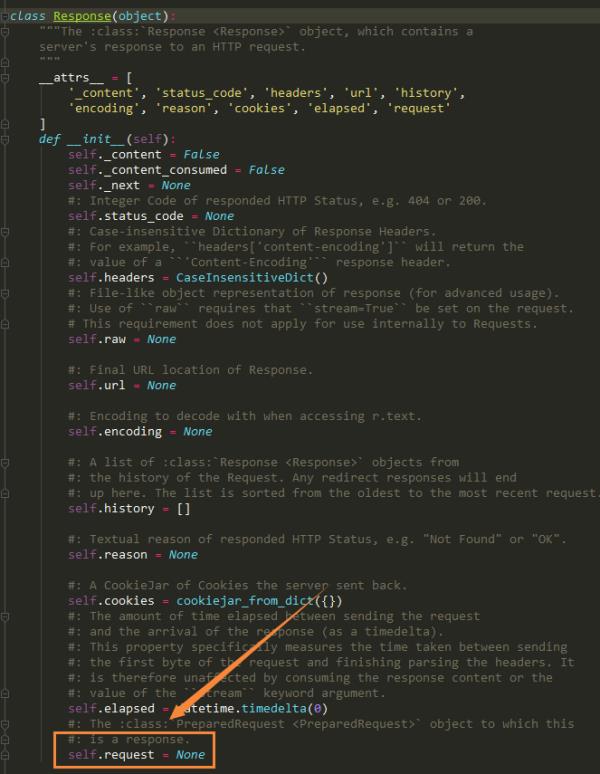

我查的reponse对象并没有request属性,那么这句reponse.request.url是什么意思

你怎么查的?

我百度找的啊,你这个是怎么找的

追答直接查看源文件

追问源码文件叫什么啊

追答你用的什么IDE

追问Pyharm

追答pycharm的话,按住ctrl键,鼠标左键点击一下request,就会自动找到它所在的类的位置

python里面request怎么读取html代码?

现在能够get的只是源码,我现在想要html代码怎么获得

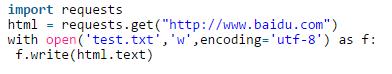

使用Python 3的requests模块抓取网页源码并保存到文件示例:

import requests

html = requests.get("http://www.baidu.com")

with open('test.txt','w',encoding='utf-8') as f:

f.write(html.text)

这是一个基本的文件保存操作,但这里有几个值得注意的问题:

1.安装requests包,命令行输入pip install requests即可自动安装。很多人推荐使用requests,自带的urllib.request也可以抓取网页源码

2.open方法encoding参数设为utf-8,否则保存的文件会出现乱码。

3.如果直接在cmd中输出抓取的内容,会提示各种编码错误,所以保存到文件查看。

4.with open方法是更好的写法,可以自动操作完毕后释放资源。

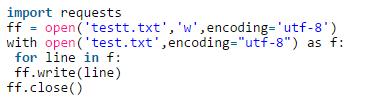

另一个例子:

import requests

ff = open('testt.txt','w',encoding='utf-8')

with open('test.txt',encoding="utf-8") as f:

for line in f:

ff.write(line)

ff.close()

这是演示读取一个txt文件,每次读取一行,并保存到另一个txt文件中的示例。

因为在命令行中打印每次读取一行的数据,中文会出现编码错误,所以每次读取一行并保存到另一个文件,这样来测试读取是否正常。(注意open的时候制定encoding编码方式)

参考技术A 用python的parser方法解析,xpath方法。,以上是关于新手Python里面requests模块的问题的主要内容,如果未能解决你的问题,请参考以下文章

Python爬虫连载10-Requests模块Proxy代理