恒源云(GPUSHARE)_AdderSR: Towards Energy Efficient Image Super-Resolution学习笔记

Posted AI酱油君

tags:

篇首语:本文由小常识网(cha138.com)小编为大家整理,主要介绍了恒源云(GPUSHARE)_AdderSR: Towards Energy Efficient Image Super-Resolution学习笔记相关的知识,希望对你有一定的参考价值。

文章来源 | 恒源云社区

原文地址 | CVPR2021

原文作者 | 学习cv的小何

一 研究问题

单图像超分辨率(SISR)是一项典型的计算机视觉任务,其目的是从低分辨率(LR)图像中重建高分辨率图像。SISR是智能手机和移动相机在现实应用中非常流行的图像信号处理任务。由于这些便携式设备的硬件限制,有必要开发具有低计算成本和高视觉质量的SISR模型。

第一个超分辨率的卷积神经网络(SRCNN)[5]只包含三个具有大约57K参数的卷积层。然后,随着深度和宽度的增加,DCNN的容量被放大,导致超分辨率的显著提高。最近DCNN的参数和计算成本也相应增加。例如,剩余密集网络(RDN)[30]包含22M参数,并且仅处理一个图像需要大约10,192GFLOP(浮数操作)。与视觉识别的神经网络(如50清晰度网)相比,由于较大的特征地图大小,SISR模型具有更高的计算复杂度。这些大量的计算将减少移动设备的持续时间。

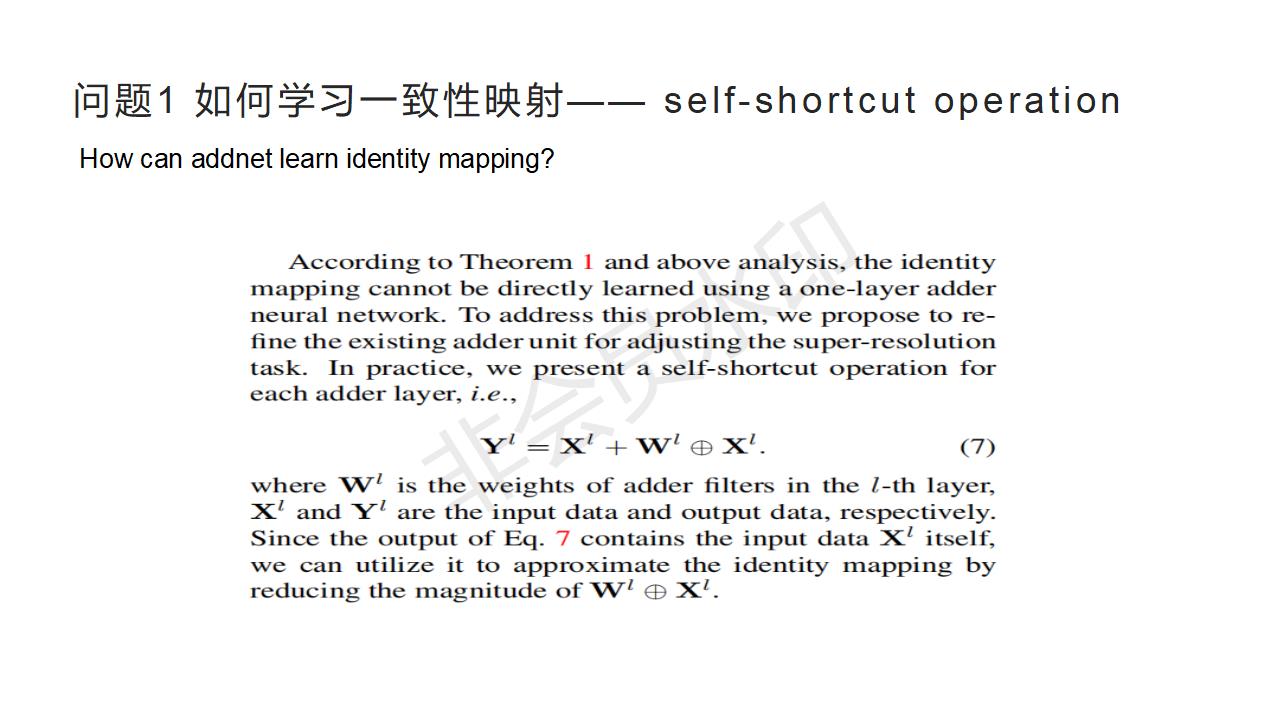

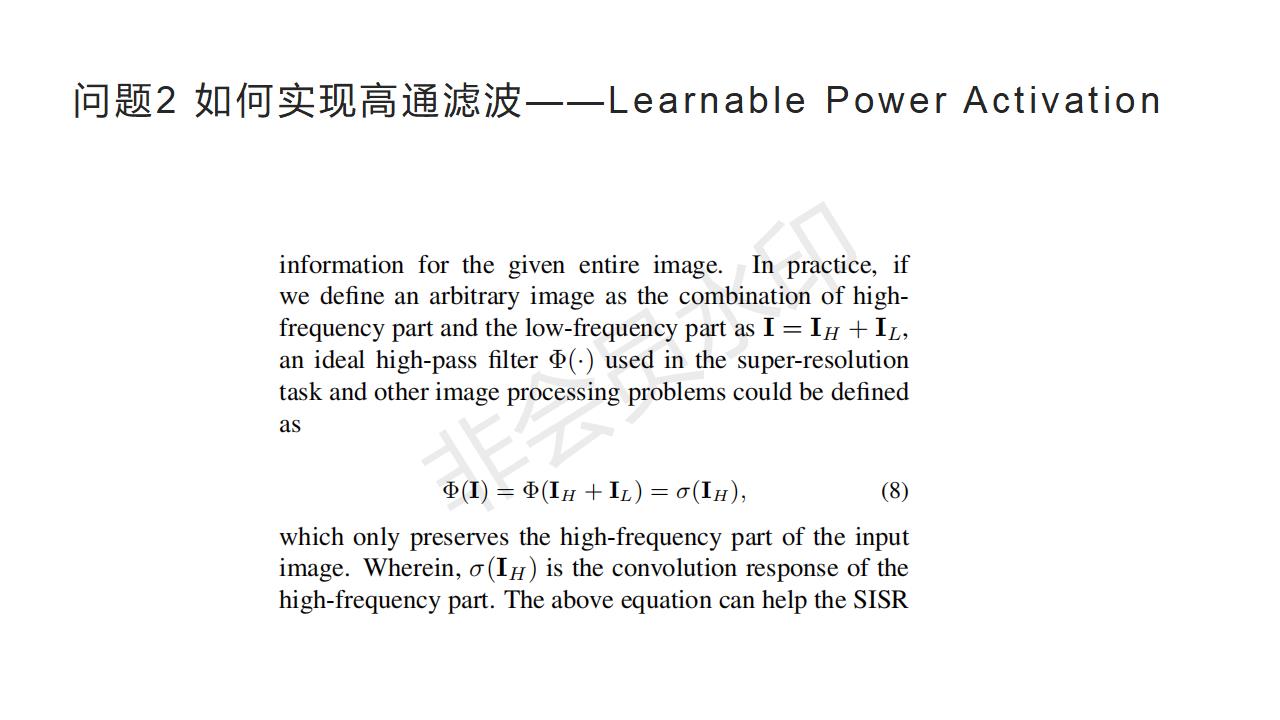

本文利用加法神经网络(AdderNet)研究了单幅图像超分辨率问题。 与卷积神经网络相比,加法网利用加法计算输出特征,避免了传统乘法的大量能量消耗。 然而,由于计算范式的不同,很难将AdderNet在大规模图像分类上的现有成功直接继承到图像超分辨率任务中。 具体来说,加法器操作不容易学习一致性映射,这对于图像处理任务是必不可少的。 此外,AdderNet无法保证高通滤波器的功能。 为此,我们深入分析了加法器操作与身份映射之间的关系,并插入快捷方式,以提高使用加法器网络的SR模型的性能。

二 背景介绍

AdderNet

加法网络,“计算机视觉研究院”平台之前就详细分析了,并且移植到目标检测,具体链接如下:

CVPR2020 AdderNet(加法网络)

代码实践 | CVPR2020——AdderNet(加法网络(代码分享)

现有的有效超分辨率方法旨在减少模型的参数或计算量。最近,[Hanting Chen, Yunhe Wang, Chunjing Xu, Boxin Shi, Chao Xu, Qi Tian, and Chang Xu. Addernet: Do we really need multiplications in deep learning? In CVPR, 2020]开创了一种新的方法,通过用加法运算代替乘法来减少网络的功耗。它在卷积层中没有任何乘法,在分类任务上实现了边际精度损失。本此研究旨在提高加法网络在超分辨率任务中的性能。

三 流程图

简要概括本文流程:

1、提出将Addnet应用在SR里会遇到的两个问题,

- 不能学习一致性映射

- 不能实现高通滤波

2、分析了这两个问题出现的原因并进行证明

3、提出了解决这两个问题的方法

4、实验验证

四 方法

核心方法简述:

- 利用类似残差的方法解决无法实现一致性映射的问题

- 利用指数激活解决无法实现高通滤波的问题

参考

AdderSR: Towards Energy Efficient Image Super-Resolution

AdderNet: Do We Really Need Multiplications in Deep Learning?

以上是关于恒源云(GPUSHARE)_AdderSR: Towards Energy Efficient Image Super-Resolution学习笔记的主要内容,如果未能解决你的问题,请参考以下文章

恒源云(GPUSHARE)_语音识别与语义处理领域之[机器翻译] 21.7 mRASP2

恒源云_AdderSR: Towards Energy Efficient Image Super-Resolution学习笔记