全闪分布式块存储性能实测1000万IOPS!

Posted 刘爱贵

tags:

篇首语:本文由小常识网(cha138.com)小编为大家整理,主要介绍了全闪分布式块存储性能实测1000万IOPS!相关的知识,希望对你有一定的参考价值。

Ceph性能数据来源:Redhat对Ceph 使用三星PM1725A进行的性能测试报告

性能测试说明

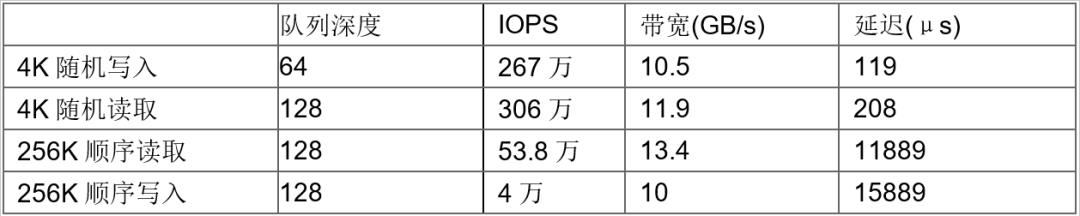

测试数据(简表)

测试方法

本次测试采用四台服务器作为存储节点搭建FASS,创建16个100GB双副本存储卷进行测试

8客户端压力读写,每个客户端读写2个存储卷,使用Intel SPDK自带的perf工具进行性能测试

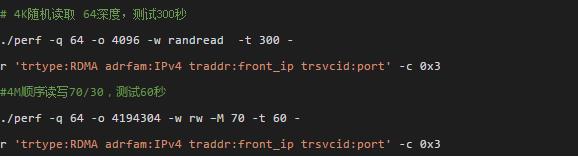

perf工具命令样例:

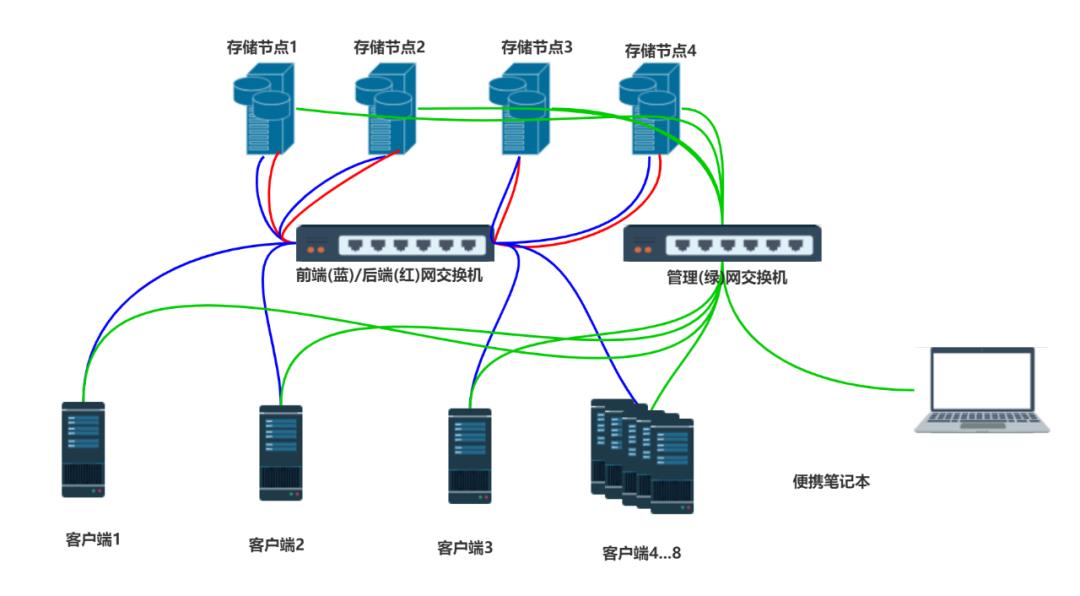

网络环境

前端和后端网采用100Gbps IB网交换机,管理网采用10Gbps以太网交换机。

前端网和后端网通过不同网段隔离,与管理网物理隔离。

网络拓扑图

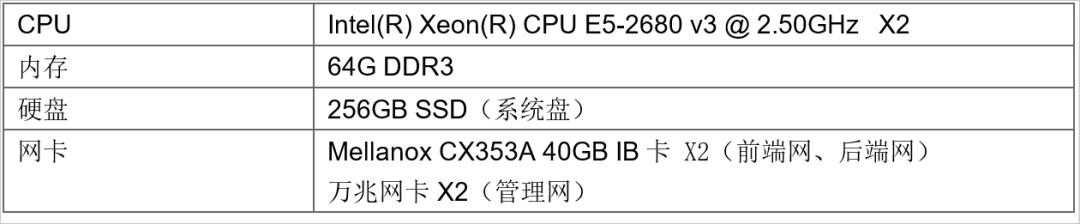

服务器环境

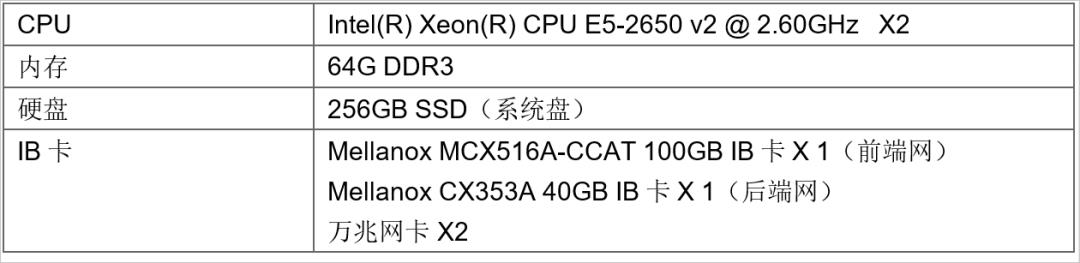

服务器配置(四台):

服务器本地硬盘性能测试结果:

测试时间为300s,未到稳态,性能相较于SPEC略有差异,仅供参考

客户端环境

客户端配置1(4台):

客户端配置2(4台):

性能说明

本次性能测试因为受限于硬件环境瓶颈,未能发挥出FASS完整的性能,主要包括以下几点:

1、PCI-E 3.0 X16接口仅能提供128Gbps的带宽,其上的双口IB网卡的极限性能受到影响,仅能提供16GB/s带宽,加上网络和协议损耗,四个节点网络性能极限带宽为60GB/s左右;

2、且因为PCI-E总线数量不足,5块NVMe硬盘本需20条PCI-E,却仅提供了16条,且5块硬盘无法均匀分布,实际本地硬盘测试中,单节点4K随机读取IOPS仅为300万,FASS已经发挥出了本地硬件90%的IOPS;

3、NVMe SSD本身的SPEC规格(随机读/写IOPS:830K/360K),写入性能相对较低;

4、为保证客户数据安全,FASS默认为双副本卷,本次测试同样采用双副本进行测试,还原实际性能,双副本卷会造成写入IOPS性能损失一倍左右;

5、客户端有一半仅有40Gbps网卡,单节点带宽上限为5GB/s左右,四台客户端仅能提供20GB/s的压力,另外四台100Gbps网卡的客户端可以提供28GB/s的压力,如果均为100Gbps网卡,FASS理应提供56GB/s的带宽,发挥出带宽极限的93%。

(TaoCloud团队原创)

以上是关于全闪分布式块存储性能实测1000万IOPS!的主要内容,如果未能解决你的问题,请参考以下文章