hadoop2.7配置文件在哪个目录

Posted

tags:

篇首语:本文由小常识网(cha138.com)小编为大家整理,主要介绍了hadoop2.7配置文件在哪个目录相关的知识,希望对你有一定的参考价值。

参考技术A (1)dfs.replication:指定DataNode存储block的副本数量,不大于DataNode的个数就行(2)dfs.nameservices:cluster1,cluster2,使用federation(HDFS联盟)时,如果使用了2个HDFS集群。这里抽象出两个NameService实际上就是给这2个HDFS集群起了个别名。名字可以随便起,相互不重复即可

(3)dfs.ha.namenodes.cluster1:hadoop101,hadoop102,指定NameService是cluster1时的namenode有哪些,这里的值也是逻辑名称,名字随便起,相互不重复即可

(4)dfs.namenode.rpc-address.cluster1.hadoop101:hadoop101:8020,指定hadoop101的RPC地址

(5)dfs.namenode.http-address.cluster1.hadoop101:hadoop101:50070,指定hadoop101的http地址!本回答被提问者采纳 参考技术B 在hadoop安装目录下的ect下面的hadoop中

具体路径为$HADOOP_HOME/etc/hadoop

Hadoop配置

Hadoop配置

一、配置jdk

二、配置ssh及免密登录

三、上传hadoop2.6.4.tar.gz文件到linux1

四、创建安装目录,并把hadoop2.6.4.tar.gz文件解压到目录中

下载地址:http://hadoop.apache.org/releases.html

命令:tar -zxvf hadoop-2.6.4.tar.gz

我的解压目录:/root/app/hadoop

五、配置hadoop环境变量

vi /etc/profile

配置hadoop的路径

export JAVA_HOME=/root/app/jdk/jdk1.8.0_152

export HADOOP_HOME=/root/app/hadoop/hadoop-2.6.4

export PATH=$PATH:$JAVA_HOME/bin

export PATH=$PATH:$HADOOP_HOME/bin:$HADOOP_HOME/sbin

使环境变量生效

source /etc/profile

六、进入hadoop配置文件目录

[root@linux1 hadoop]# cd /root/app/hadoop/hadoop-2.6.4/etc/hadoop/ [root@linux1 hadoop]# ll 总用量 152 -rw-r--r--. 1 root root 4436 5月 24 2017 capacity-scheduler.xml -rw-r--r--. 1 root root 1335 5月 24 2017 configuration.xsl -rw-r--r--. 1 root root 318 5月 24 2017 container-executor.cfg -rw-r--r--. 1 root root 963 12月 25 23:46 core-site.xml -rw-r--r--. 1 root root 3670 5月 24 2017 hadoop-env.cmd -rw-r--r--. 1 root root 4238 12月 25 23:49 hadoop-env.sh -rw-r--r--. 1 root root 2598 5月 24 2017 hadoop-metrics2.properties -rw-r--r--. 1 root root 2490 5月 24 2017 hadoop-metrics.properties -rw-r--r--. 1 root root 9683 5月 24 2017 hadoop-policy.xml -rw-r--r--. 1 root root 775 5月 24 2017 hdfs-site.xml -rw-r--r--. 1 root root 1449 5月 24 2017 httpfs-env.sh -rw-r--r--. 1 root root 1657 5月 24 2017 httpfs-log4j.properties -rw-r--r--. 1 root root 21 5月 24 2017 httpfs-signature.secret -rw-r--r--. 1 root root 620 5月 24 2017 httpfs-site.xml -rw-r--r--. 1 root root 3523 5月 24 2017 kms-acls.xml -rw-r--r--. 1 root root 1325 5月 24 2017 kms-env.sh -rw-r--r--. 1 root root 1631 5月 24 2017 kms-log4j.properties -rw-r--r--. 1 root root 5511 5月 24 2017 kms-site.xml -rw-r--r--. 1 root root 11291 5月 24 2017 log4j.properties -rw-r--r--. 1 root root 938 5月 24 2017 mapred-env.cmd -rw-r--r--. 1 root root 1383 5月 24 2017 mapred-env.sh -rw-r--r--. 1 root root 4113 5月 24 2017 mapred-queues.xml.template -rw-r--r--. 1 root root 844 12月 25 23:50 mapred-site.xml.template -rw-r--r--. 1 root root 21 12月 26 00:10slaves -rw-r--r--. 1 root root 2316 5月 24 2017 ssl-client.xml.example -rw-r--r--. 1 root root 2268 5月 24 2017 ssl-server.xml.example -rw-r--r--. 1 root root 2237 5月 24 2017 yarn-env.cmd -rw-r--r--. 1 root root 4567 5月 24 2017 yarn-env.sh -rw-r--r--. 1 root root 888 12月 25 23:53 yarn-site.xml

七、配置五个文件

7.1core-site.xml

<configuration>

<property>

<name>fs.defaultFS</name>

<value>hdfs://linux1:9000</value>

</property>

<property>

<name>hadoop.tmp.dir</name>

<value>/root/app/hadoop/hadoopdata</value>

</property>

</configuration>

7.2 hadoop-env.sh

# The java implementation to use.

export JAVA_HOME=/root/app/jdk/jdk1.8.0_152

7.3 mapred-site.xml.template

<configuration>

<property>

<name>mapreduce.framework.name</name>

<value>yarn</value>

</property>

</configuration>

将模版重命名

mv mapred-site.xml.template mapred-site.xml

7.4 yarn-site.xml

<configuration>

<property>

<name>yarn.resourcemanager.hostname</name>

<value>linux1</value>

</property>

<property>

<name>yarn.nodemanager.aux-services</name>

<value>mapreduce_shuffle</value>

</property>

</configuration>

yarn的主节点在生产环境下和hdfs的主节点是分开的

yarn的从节点和hdfs的从节点在生产环境下是放在同一台机器上

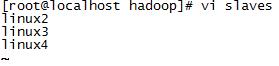

7.5 slaves

这里只配置从节点

八、把配置好的hadoop文件发到所有的从节点

新建patch.sh文件

#!/bin/bash for((i=2;i<5;i++)) do scp -r /etc/profile root@linux$i:/etc/profile scp -r /root/app/hadoop root@linux$i:/root/app/hadoop done

给文件授权,让它变成可执行

chmod u+x patch.sh

执行脚本

./patch.sh

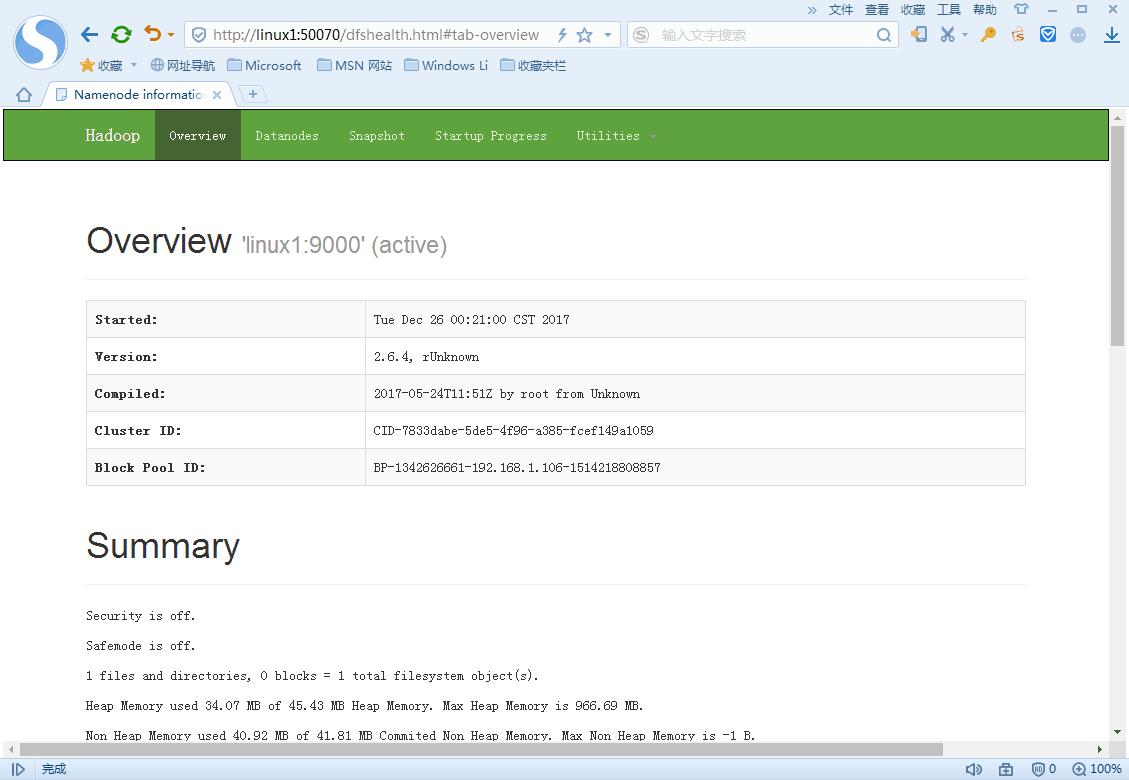

九、格式化hdfs,关闭防火墙,启动hdfs

hadoop namenode –format

service iptables stop

start-dfs.sh

浏览器输入:http://linux1:50070

十、介绍几个命令

|

-help 功能:输出这个命令参数手册 |

|

-ls 功能:显示目录信息 示例: hadoop fs -ls hdfs://linux1:9000/ 备注:这些参数中,所有的hdfs路径都可以简写 -->hadoop fs -ls / 等同于上一条命令的效果 |

|

-mkdir 功能:在hdfs上创建目录 示例:hadoop fs -mkdir -p /aaa/bbb/cc/dd |

|

-moveFromLocal 功能:从本地剪切粘贴到hdfs 示例:hadoop fs -moveFromLocal /home/hadoop/a.txt /aaa/bbb/cc/dd -moveToLocal 功能:从hdfs剪切粘贴到本地 示例:hadoop fs -moveToLocal /aaa/bbb/cc/dd /home/hadoop/a.txt |

|

--appendToFile 功能:追加一个文件到已经存在的文件末尾 示例:hadoop fs -appendToFile ./hello.txt hdfs://linux1:9000/hello.txt 可以简写为: Hadoop fs -appendToFile ./hello.txt /hello.txt

|

|

-cat 功能:显示文件内容 示例:hadoop fs -cat /hello.txt

-tail 功能:显示一个文件的末尾 示例:hadoop fs -tail /weblog/access_log.1 -text 功能:以字符形式打印一个文件的内容 示例:hadoop fs -text /weblog/access_log.1 |

手册:http://hadoop.apache.org/docs/r1.0.4/cn/hdfs_shell.html#FS+Shell

以上是关于hadoop2.7配置文件在哪个目录的主要内容,如果未能解决你的问题,请参考以下文章