Graphcore 联合百度飞桨提交 MLPerf Training 2.0,IPU 性能再下一城

Posted CSDN云计算

tags:

篇首语:本文由小常识网(cha138.com)小编为大家整理,主要介绍了Graphcore 联合百度飞桨提交 MLPerf Training 2.0,IPU 性能再下一城相关的知识,希望对你有一定的参考价值。

作者 | 宋慧

出品 | CSDN 云计算&AI 科技大本营

为 AI 与机器学习提供更高性能的支持,是芯片厂商的竞争特点。最近,AI 芯片厂商 Graphcore 联合国内知名的深度学习平台百度飞桨,共同提交了 MLCommons 的 AI 基准评测 MLPerf Training 2.0,提交的模型集合评测结果比以往测试和其他芯片平台,都有较大的提升,再次证明了 IPU 芯片的过硬实力。

CSDN 曾报道 Graphcore IPU 的发展: GPU还是IPU?IPU 芯片厂商 Graphcore 的 2021 ,与英伟达、Google、英特尔的 SIMD 的芯片架构不同,Graphcore 的 IPU 是 MIMD 架构的图处理器,Graphcore 的 IPU 多核最多已达 1472 核,每个核自有 SRAM,是多核分布式、片上内存分布式的多指令多数据的处理器。因此,Graphcore IPU 基于 AI 计算图的处理器,可以支持运行矢量处理器运行效果不佳的应用场景。

联合提交 MLPerf 测试模型,算力与性能继续提升

Graphcore 在 2022 年第一季度发布了最新的基于 Bow 芯片的 Bow Pod 平台,也是本次 MLPerf 2.0 主要提交的计算平台,Bow Pod16、Bow Pod64、Bow Pod128、Bow Pod256,为提交测试的各类模型,都提供了最新和最强的算力支持。例如 Bow Pod16 整体算力为 5.6 PetaFLOPS,到 Bow Pod256 整体接近 90 PetaFLOPS,几乎达到了数据中心的算力规模。

本次提交的测试模型是 ResNet-50、BERT 和 RNN-T,其中,ResNet-50 和 BERT 是标准提交的集合,另外语音方面在开放分区提交了 RNN-T(Recurrent Neural Network Transducer),性能指标可以直接供商业用户使用参考。

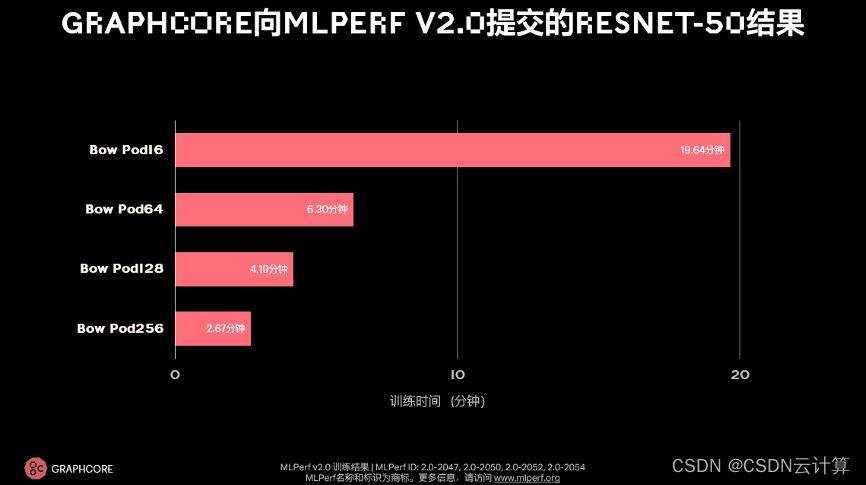

测试结果 1、ResNet-50 测试耗时,最短 2.67 分钟

Graphcore Bow Pod 在 ResNet-50 上的提交结果

在 2021 年底 Graphcore 提交的 ResNet-50 测试中,NVIDIA 的 DGX A100 和 Graphcore IPU-POD16 的对比上,Graphcore 第一次超过 NVIDIA,IPU-POD16 耗时 28.3 分钟。本次提交结果继续进步,缩短到 19.64 分钟。在 Bow Pod256 上,训练时间仅需 2.67 分钟,要知道几年前的模型训练时间都是以小时为单位起步的。Graphcore 技术负责人对 CSDN 介绍,性能的成绩得益于硬件层面 Graphcore Bow IPU 采用的 Wafer-on-Wafer 3D 堆叠技术,软件层面的通信库、内存优化,编译器优化,以及训练模型的优化等这些技术点的提升。

测试结果 2、BERT 测试,性能线性提升

与去年提交结果的对比,从 IPU-POD16 到 Bow Pod16 的训练时间提升了 31%,吞吐量的提升约为 1.6 倍,其中 1.3 倍来自硬件提升,1.26 倍来自软件提升。另外,Bow Pod256 提升了接近 30%,通常情况下,系统越大,越难提升,因此 Graphcore 在大尺度系统上做了很多通信库、集合通信(collective communication)优化,最终在大尺度系统上也达到了同比例提升。另外,BERT 和 ResNet 的提升幅度类似,训练时间提升了接近 37%,吞吐量提升了 1.6 倍。

本次测试和以往不同的,是 Graphcore 与百度飞桨联合提交。百度飞桨使用 Bow Pod16 和 Bow Pod64 进行了 BERT 在封闭分区的提交,结果与 Graphcore 使用自研的训练推理引擎 PopART 进行提交的结果几乎一致,说明了 Graphcore 软件栈能够快速对接新的 AI 框架。而百度飞桨在测试中,也体现了框架的接入高效性,没有任何性能侵入式的设计。

芯片之上,Graphcore 继续深耕软件与生态能力

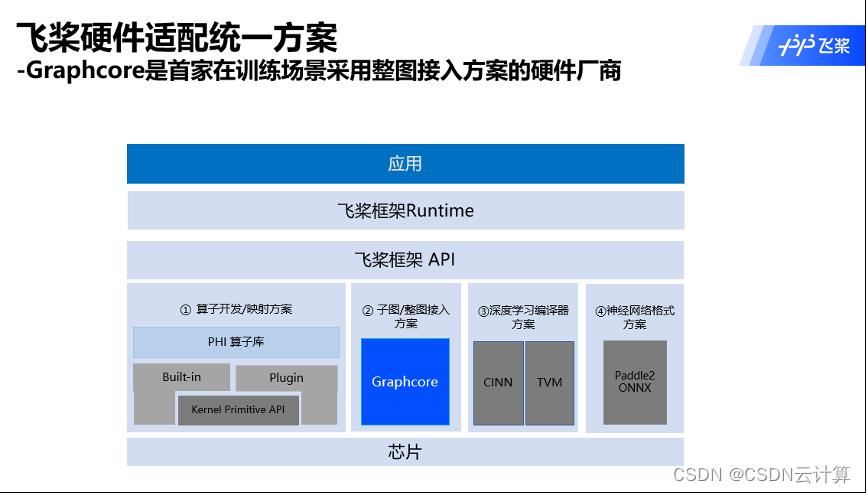

本次的联合提交测试,也是 Graphcore 与百度飞桨生态共建的重要一站。从共聚、共研到共创,百度飞桨的硬件生态正在快速发展,与以往算子开发、映射开发不同,Graphcore 以子图或者整图的方式,也为飞桨提供了创新思路。

据介绍,飞桨与 Graphcore 在 AI Ecosystem 的共创方面还有很多新的方向,如百度飞桨与 Graphcore 的软件栈,以及 Graphcore 的模型花园偏应用层面的开发工具等合作,并在百度的内部以及国内其他的行业,落地产业开展真实应用。此外,百度飞桨与 Graphcore 也计划在 AI Studio 上后续开设 Graphcore 的硬件应用专区,基于这个平台更好地共同拓展与国内开发者,以及国际开发者的合作。

硬件的发展之外,Graphcore 在软件层面也在持续发力。就像下图中的模型,除了黄色的是历届提交的 MLPerf 模型,在实践中 Graphcore 还积累了更多模型可供用户参考使用。比如在计算机视觉上,除了 CNN 卷积神经网络,还包括 ResNet-50、EfficientNet、MoblieNet,更多的类似 Transformer,DINO、Swin Transformer 等业界最新流行的模型。在物体检测方面 YOLOv3、v4,在目标分割以及医疗影像方面的 Unet,Graphcore 也在持续跟进、快速迭代。

另外,据介绍,Graphcore 在自然语言处理 NLP、强化学习、语音、时间图神经网络、聚类图神经网络上都在发力。在 HPC 领域,分子动力学、大气模拟、Covid-19、智能气象里 ET0 的计算,也都可以通过 Graphcore 的 IPU 硬件加速带来更高性能提升。在 AI 领域之外,金融行业销售预测、推荐引擎和生成式模型 DALL-E 以及 DALL-E 2,Graphcore 也在同步开发和研究。除了与百度飞桨的深度合作,Graphcore 也在与欧洲的 AI 公司 Aleph Alpha 在大模型大算力联合创新。

Graphcore 还在打造 AI 超级计算机 Good™ Computer(古德计算机),古德计算机是为100万亿参数量的模型打造,Good™ Computer将会达到约8192个路线图IPU,提供超过10 Exa-Flops的AI算力,也考虑继续往3D Wafer-on-Wafer演进(目前Graphcore采用3D Wafer-on-Wafer的Bow芯片,AI算力为350T)。其中存储需达到4PB,以及10 PB每秒的内存带宽,离不开Graphcore Poplar软件的迭代,以支持大算力和大模型的要求。

AI 芯片行业的爆发式发展,从本次联合提交 MLPerf 测试,能看到 AI 行业中的各方在寻求更加开放的合作与共赢,而生态的繁荣,也会让 AI 走得更远。CSDN 将继续关注 Graphcore 与 AI 芯片的最新发展。

以上是关于Graphcore 联合百度飞桨提交 MLPerf Training 2.0,IPU 性能再下一城的主要内容,如果未能解决你的问题,请参考以下文章

百度飞桨大企业开放创新中心联合赋能计划启动,助力浦东产业智能化升级

百度飞桨大企业开放创新中心联合赋能计划启动,助力浦东产业智能化升级

百度飞桨郑州大学联合培养AI工程人才,破解无纺布瑕疵检测难题

百度飞桨郑州大学联合培养AI工程人才,破解无纺布瑕疵检测难题