游戏玩得好的AI,已经在看病救人了

Posted QbitAl

tags:

篇首语:本文由小常识网(cha138.com)小编为大家整理,主要介绍了游戏玩得好的AI,已经在看病救人了相关的知识,希望对你有一定的参考价值。

明敏 羿阁 发自 凹非寺

量子位 | 公众号 QbitAI

一个游戏AI,怎么干起医生的活了?

而且这本事还是从打游戏的经验里总结来的。

喏,拿一张病理全片扫描图像,不用遍历所有高倍镜视野,也能找到病灶所在。

在它看来,这个过程和《我的世界》里伐木居然是类似的。

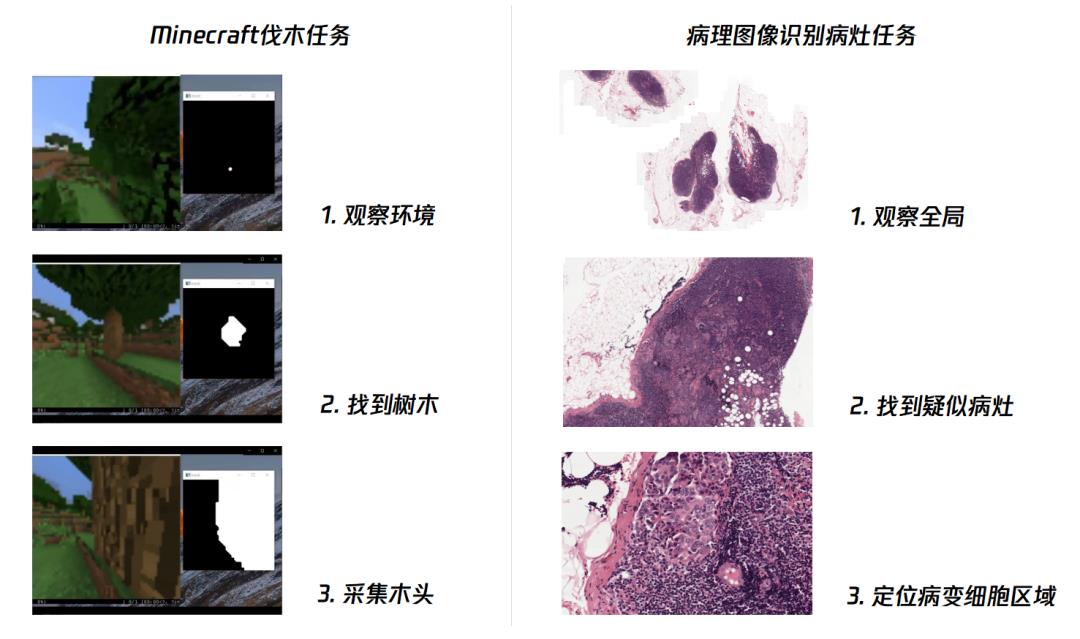

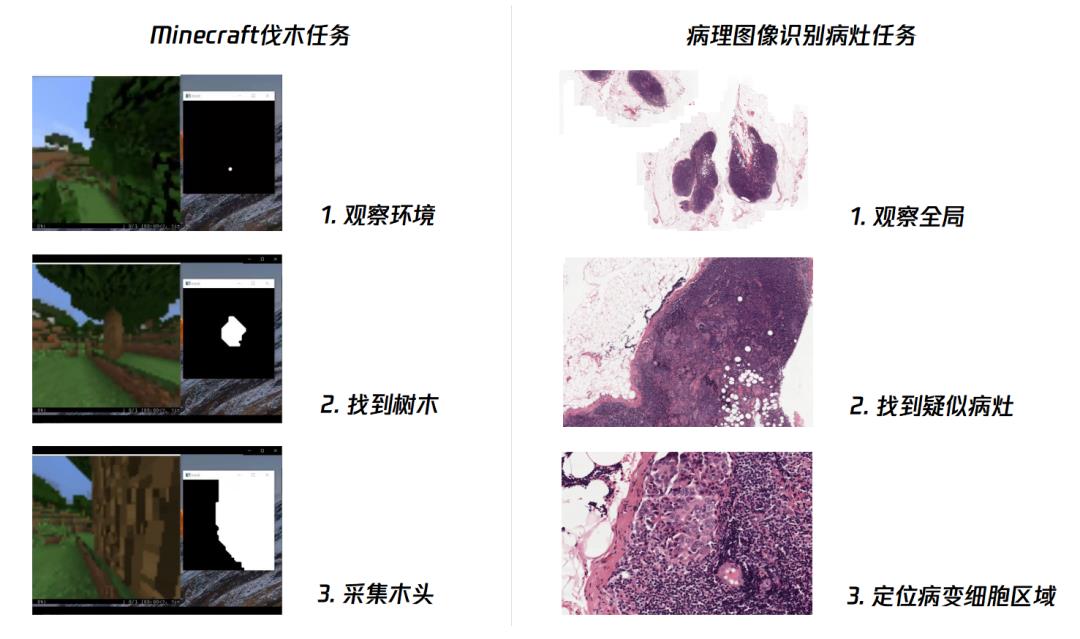

都是三步走:

先观察大环境

锁定小范围

最终确定目标。

而且这种方法效率还贼高,是传统方法的400%。

不愧是拿过NeurIPS MineRL竞赛冠军的游戏AI……

所以,它到底是怎么做到的?

游戏AI怎么悬壶济世?

在介绍这只游戏AI前,让我们先来了解一下处理病理切片的难点究竟在哪。

与想象中只需扫一眼不同,临床科室首先会将组织切片进行全片扫描数字化处理。

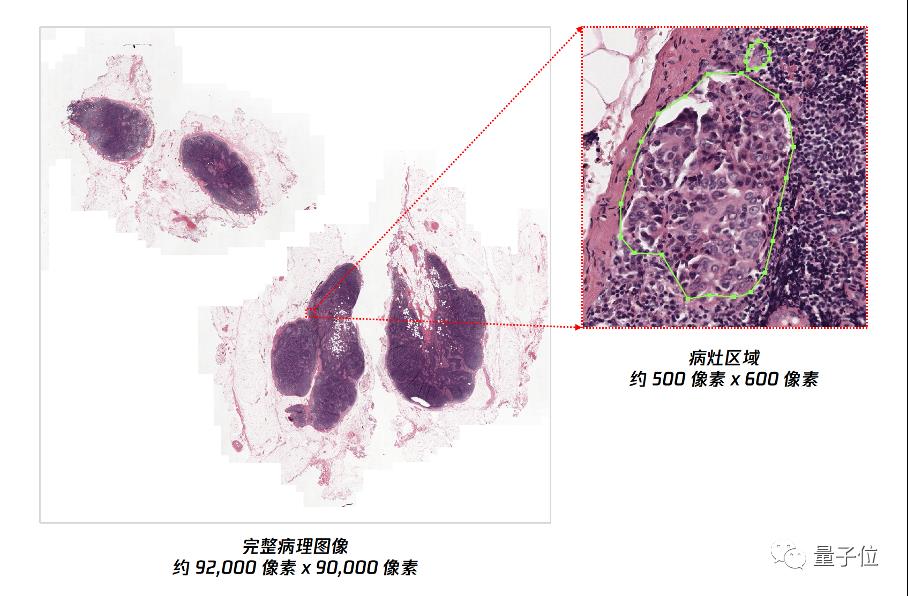

在这之后,交到医生手里的往往是一张几万乘几万像素、甚至更高的高分辨率图像,能达到每个像素0.25微米。

医生要做的就是在这幅布满密集细胞和组织的超大尺寸图像中,肉眼找到风险的病灶位置并进行判断,可谓是“大海捞针”了。

近些年也不是没有人尝试过用深度学习方法来解决这一问题,但遇到的挑战是:

第一个,尽管病理图像(WSI)具有十亿像素大小的高分辨率,却往往只有一个图像级标签。

目前绝大部分的方法都依赖于在高倍镜下对全切片进行密集采样的方式进行特征提取,并对所有采集特征进行信息整合进而实现全片诊断,工作量可想而知。

第二呢,这些图像的病变区域往往很稀疏。现有的方法大多依赖于多实例学习框架,需要在高倍率下密集采样局部的图像块(patch)。

这不仅增加了计算成本,还导致了诊断相关性弱、数据效率低下,一张切片往往需要几十分钟才能完成计算。

不过,这次来自腾讯的“绝悟”团队就发现了盲点——

传统模式下尽管医生需要肉眼去看,但他们往往会先用显微镜在低倍镜下扫片,凭借经验发现疑点后再用高倍镜复核。

而这种操作,如果放到AI的世界里,不就是最优路径决策问题吗?这不正是强化学习能搞定的事?

再联系到强化学习又常用在游戏AI里,游戏AI又是绝悟AI的长处所在,嗯优势闭环了。

此前,绝悟AI就凭借最优路径决策策略在MOBA、RTS、我的世界(Minecraft)等多类型游戏中战绩斐然,还拿过AI顶会NeurIPS MineRL竞赛冠军。

当时,CMU、微软、DeepMind和OpenAI联手在顶会NeurIPS上举办了一个名叫MineRL的竞赛,要求参赛队伍在4天时间内,训练出一个能在15分钟内挖出钻石的AI“矿工”。

来自腾讯的绝悟AI以76.97分的绝对优势一举夺魁,成功成为挑战赛历史上“挖矿最迅速”的AI。

而在《我的世界》里找木头的动作,和在病理切片里找病灶,其实思路差不多。

同样是环顾四周搜集全局信息(病理医生在低倍镜下扫片),然后锁定视角(高倍镜确认),找到木头后执行采集动作(确认病灶),如此往复。

于是,就在这只游戏AI的基础上,腾讯的研究人员推出了最新的研究成果“绝悟RLogist”,寓意正是RL(reinforcement learning)+ Pathologist(病理学家)。

那么绝悟RLogist具体是怎么实现的呢?

决策提效400%

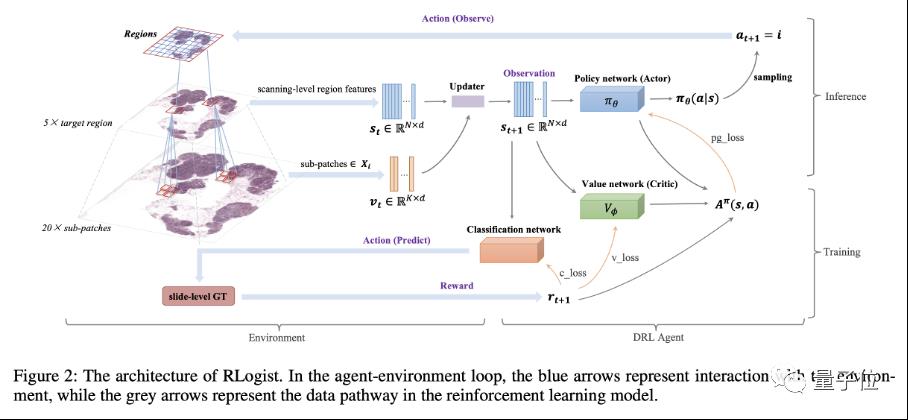

就像上文提到的人类医生的解决思路一样,“绝悟RLogist”采用的正是基于深度强化学习的,找寻最优看片路径的方法。

这一新方法的好处很明显:避免了用传统的穷举方式去分析局部图像切块,而是先决策找到有观察价值的区域,并通过跨多个分辨率级别获得代表性特征,以加速完成全片判读。

通过模仿人类的思维方式,不仅提高了看片效率,还做到了节约成本。

具体而言,研究人员通过条件特征超分辨率实现了交叉分辨率信息融合。

受益于条件建模,未观测区域的高分辨率特征,可以根据已经被观测过的低分辨率和高分辨率的特征配对,而被更新。

其中一个关键步骤,是为病理图像分析领域定义一个强化学习训练环境。该方法使用离散化的动作空间、设计合理的图像分块和完成状态奖励函数,去提升模型的收敛表现,以避免局部最优。

相应的训练pipeline如下述算法所示:

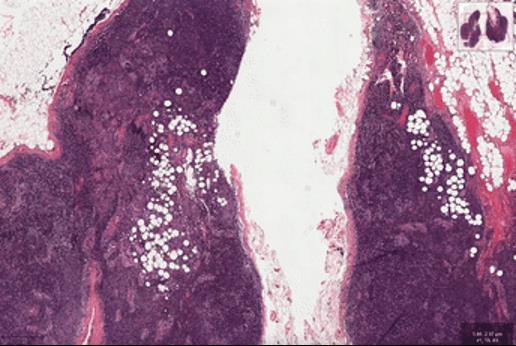

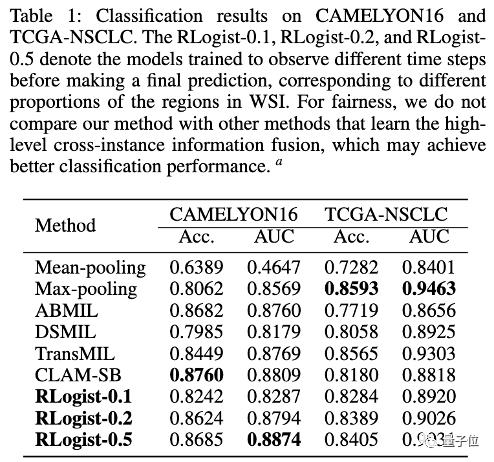

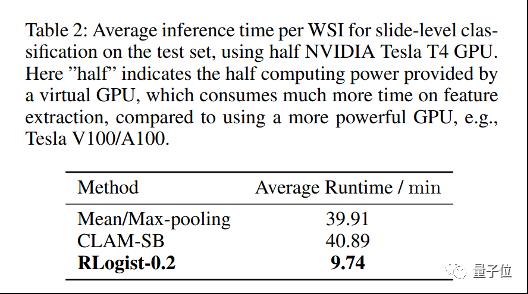

从结果上看,绝悟RLogist的优势非常明显。研究人员选择“淋巴结切片转移检测”及“肺癌分型”两个全片扫描图像的分类任务进行了基准测试。

结果表明,与典型的多实例学习算法相比,“绝悟RLogist”在观察路径显著变短情况下,能够实现接近的分类表现,平均用时缩短至四分之一,决策效率提升400%。

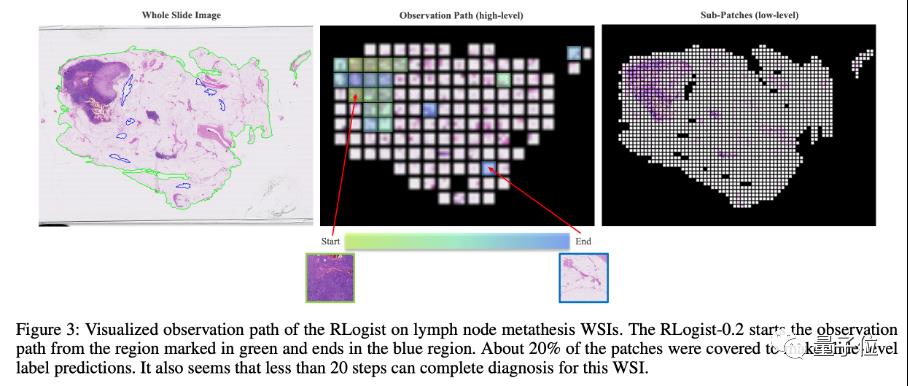

不仅如此,该方法同时还具有可解释性。研究人员将决策过程可视化后,发现未来不管是医疗教育还是实际场景,绝悟RLogist都能很好地发挥作用。

目前,该论文已被AAAI 2023接收,代码已开源。

值得一提的是,研究人员还强调,未来将沿着绝悟RLogist的方向继续优化,包括通过引入更强的神经网络结构增强RLogist的表征学习能力,以及使用更高阶的RL训练方法避免学习到错误的观测路径等。

“绝悟RLogist”从何而来?

提到AI“绝悟”,想必很多人都不会陌生。

毕竟《王者荣耀》里的AI玩法,就是“绝悟挑战”。

△红方 AI 铠大局观出色,绕后蹲草丛扭转战局

还有《我的世界》、3D-FPS品类游戏等,可以说“绝悟”游戏老玩家了。

其背后团队腾讯AI Lab也是让AI学会玩游戏的老玩家了,从2016至今已经开发出了AI“绝艺”、AI“绝悟”,并形成了“开悟”平台。

AI“绝艺”,是棋牌类游戏玩家。

它的开发始于2016年,最早从围棋起步。

2017年,“绝艺”在UEC世界电脑围棋大会上夺得冠军,现在是国家队的专业陪练。

除此以外,它还会下国际象棋、打麻将。在四人麻将上,“绝艺”是业界首个在国际标准时达到职业水准的麻将,拿下过IJCAI麻将AI比赛的冠军。

紧随“绝艺”身后,2017年“绝悟”研发启动。

它强调的不再是简单博弈,而是多智能体AI在面临更复杂环境下的策略问题。

2018年“绝艺”达到《王者荣耀》业余玩家水平,2019年达到职业电竞水平。

后面“王者绝悟”也为王者荣耀玩家带来了“挑战绝悟”、“英雄练习场”等玩法,成为玩家训练上分的好帮手。

此外,“绝悟”玩《我的世界》,拿下了NeurIPS MineRL竞赛的冠军,成功成为挑战赛历史上“挖矿最迅速”的AI。

“足球版”绝悟也曾获得过谷歌举办的线上世界足球赛冠军。

而在做游戏AI的过程中,腾讯AI Lab还顺道与王者荣耀一同沉淀出了一个平台“开悟”。

也就是将腾讯的平台、算法、场景给学生、学术界做一定的开放,让他们进行相关的博弈研究。2020年8月,“开悟”平台组织了第一场开悟的高校比赛,今年还发布了王者荣耀1v1开放研究环境。

实际上,游戏领域,一直被视为AI最好的试验田。

从“绝悟”这几年的战绩中,不难看出它在强化学习等方面已经积累了一定能力。

那么将最擅长的能力向外迁移,落在实际应用层面,也是行业内的大势所趋。

这一回,可真就不能说游戏AI“不学无术”了 。

。

论文地址:

http://arxiv.org/abs/2212.01737

开源地址:

https://github.com/tencent-ailab/RLogist

— 完 —

「2022人工智能年度评选」榜单揭晓

领航企业TOP50

点这里👇关注我,记得标星哦~

以上是关于游戏玩得好的AI,已经在看病救人了的主要内容,如果未能解决你的问题,请参考以下文章

推荐一个好的.NET 4.0/SQL Server 2008 网络主机(共享平台)