爬虫大作业

Posted 黄文麒

tags:

篇首语:本文由小常识网(cha138.com)小编为大家整理,主要介绍了爬虫大作业相关的知识,希望对你有一定的参考价值。

1.选一个自己感兴趣的主题(所有人不能雷同)。

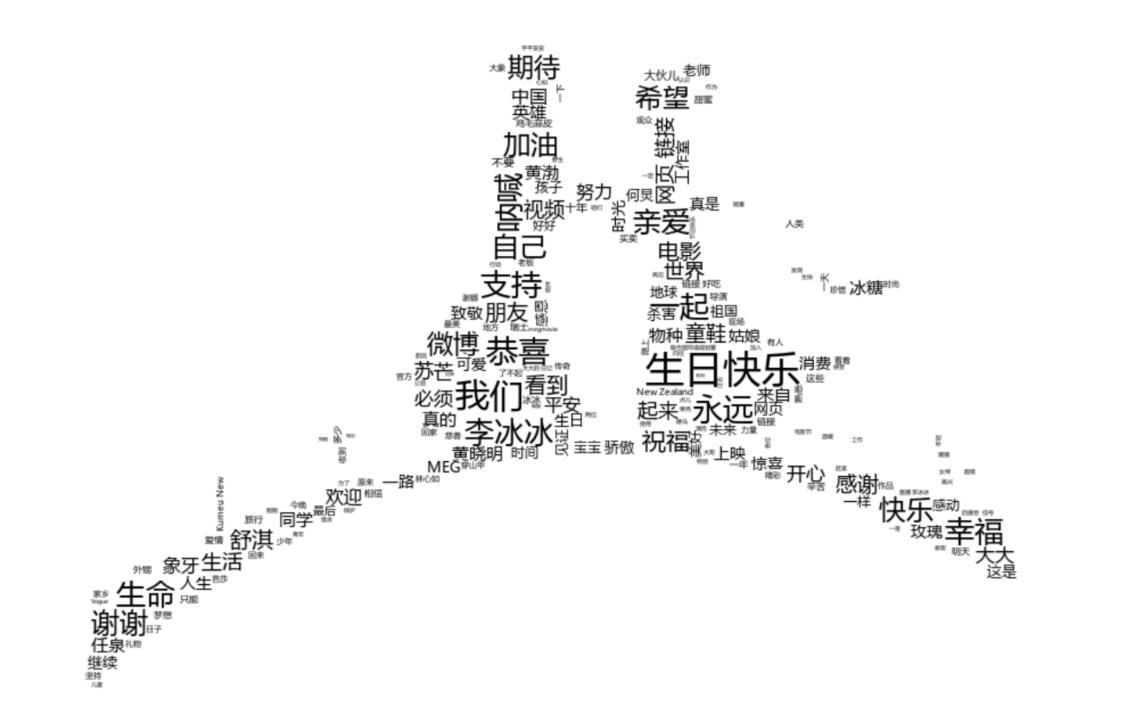

答:爬取李冰冰微博主页信息

2.用python 编写爬虫程序,从网络上爬取相关主题的数据。

3.对爬了的数据进行文本分析,生成词云。

4.对文本分析结果进行解释说明。

答:文本获取到的字符信息并不是我们想要的效果,因此,为了达到我们想要的效果,我就将所获取到的文本信息,生成一个词云图,这样我们就可以比较直观地看出,广州大学地新闻网地信息主要在强调些什么,从而达到此次爬取的目的。

5.写一篇完整的博客,描述上述实现过程、遇到的问题及解决办法、数据分析思想及结论。

答:首先要有信心。虽然可能你看了几个小时也没在屏幕上打出一个三角形,或者压根儿就没能把程序运行起来。但相信我,几乎所有程序员一开始都是这么折腾过来的。

尽量不要系统地去啃一些东西,找一个实际的项目,直接开始就好。

6.最后提交爬取的全部数据、爬虫及数据分析源代码。

# -*- coding: utf-8 -*- import requests from bs4 import BeautifulSoup as bs if __name__ == \'__main__\': url = "https://weibo.com/libingbing?refer_flag=1001030101_" #html = getreq(url) info = gettext(url) print(info) for i in info: print(i) f = open(\'i.txt\', \'a+\',encoding=\'utf-8\') f.write(i) f.write(\'\\n\') f.close() def gettext(url): header = { \'user-agent\': \'Mozilla/5.0 (Windows NT 10.0; Win64; x64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/66.0.3359.117 Safari/537.36\'} html = requests.get(url, headers=header).content soup = bs(html, \'html.parser\') info = soup.select(\'div.newList.black01 a\') a = [] for i in info: a.append(i.text) print(i.text) return a import jieba import PIL from wordcloud import WordCloud import matplotlib.pyplot as p import os info = open(\'i.txt\', \'r\', encoding=\'utf-8\').read() text = \'\' text += \' \'.join(jieba.lcut(info)) wc = WordCloud(font_path=\'C:\\Windows\\Fonts\\STZHONGS.TTF\', background_color=\'White\', max_words=50) wc.generate_from_text(text) p.imshow(wc) # p.imshow(wc.recolor(color_func=00ff00)) p.axis("off") p.show() wc.to_file(\'词云.jpg\')

以上是关于爬虫大作业的主要内容,如果未能解决你的问题,请参考以下文章