Docker集群管理Swarm数据持久化

Posted Bigberg

tags:

篇首语:本文由小常识网(cha138.com)小编为大家整理,主要介绍了Docker集群管理Swarm数据持久化相关的知识,希望对你有一定的参考价值。

一、前言

和docker容器一样,Swarm集群中运行的服务也能够做数据持久化。我们可以通过volume、bind和nfs等方式来实现swarm集群应用数据的持久化。其实和docker数据持久化的形式是一样的。

二、系统环境

| 节点名称 | IP | 操作系统 | 内核版本 |

| manager | 172.16.60.95 | CentOs7 | 4.16.1-1.el7.elrepo.x86_64 |

| node-01 | 172.16.60.96 | CentOs7 | 4.16.1-1.el7.elrepo.x86_64 |

| node-02 | 172.16.60.97 | CentOs7 | 4.16.1-1.el7.elrepo.x86_64 |

| node-03 | 172.16.60.98 | CentOs7 | 4.16.1-1.el7.elrepo.x86_64 |

三、通过volume实现数据持久化

3.1 volume说明

卷是绕过联合文件系统的一个或多个容器内的特定目录。 卷被设计为保持数据,与容器的生命周期无关。 因此,Docker在删除容器时不会自动删除卷,也不会“垃圾收集”不再由容器引用的卷。 也称为:数据卷。

需要更详细了解volume可参考官方文档:https://docs.docker.com/storage/volumes/

3.2 使用格式

docker service create \\ --replicas 1或2或3... \\ --name SERVICE-NAME \\ --mount type=volume,src=<VOLUME-NAME>,dst=<CONNTAINER-PATH> \\ <IMAGE>

3.3 创建服务的volume

When you start a service and define a volume, each service container uses its own local volume. None of the containers can share this data if you use the local volume driver, but some volume drivers do support shared storage. Docker for AWS and Docker for Azure both support persistent storage using the Cloudstor plugin. 使用service的方式创建的volume数据卷,该service中的容器只会使用其所在节点服务器的中的volume。 当使用本地数据卷驱动时,所用的容器都无法共享其数据。 但是有一些数据卷驱动支持共享存储。

1)创建数据卷

[root@manager ~]# docker service create \\ --replicas 5 \\ --name my-web \\ --mount type=volume,src=nginx-vol,dst=/data \\ nginx nsrkogg0x5t617qszxylv6rfn overall progress: 5 out of 5 tasks 1/5: running [==================================================>] 2/5: running [==================================================>] 3/5: running [==================================================>] 4/5: running [==================================================>] 5/5: running [==================================================>] verify: Service converged 参数说明: --replicas:创建5个nginx副本; --name:自定义名称为my-web; --mount:挂载类型为volume; src:src挂载源为nginx-vol,相当于执行了docker volume nginx-vol; dst:dst挂载目的路径为nginx容器中的路径/data; nginx:通过nginx镜像来运行;

2)查看创建的副本

[root@manager ~]# docker service ls ID NAME MODE REPLICAS IMAGE PORTS nsrkogg0x5t6 my-web replicated 5/5 nginx:latest [root@manager ~]# docker service ps my-web ID NAME IMAGE NODE DESIRED STATE CURRENT STATE ERROR PORTS sv6ho8p1ngoo my-web.1 nginx:latest manager Running Running 2 minutes ago p601cxw8x5gr my-web.2 nginx:latest node-02 Running Running 2 minutes ago qcgdyxkwzk00 my-web.3 nginx:latest node-03 Running Running 2 minutes ago 9adosd6zoaeb my-web.4 nginx:latest node-01 Running Running 2 minutes ago jjv4if4glv4b my-web.5 nginx:latest manager Running Running 2 minutes ago

3)查看数据卷、挂载的数据

在每个有task节点上都会自动创建一个nginx-vol的数据卷 # manager 节点 [root@manager ~]# docker volume ls DRIVER VOLUME NAME local nginx-vol # 工作节点 [root@node-02 ~]# docker volume ls DRIVER VOLUME NAME local nginx-vol

在通过docker volume inspect nginx-vol可以看到nginx-vol卷自动挂载到了/var/lib/docker/volumes/nginx-vol/_data目录下

[root@manager ~]# docker volume inspect nginx-vol

[

{

"CreatedAt": "2018-04-11T18:08:32+08:00",

"Driver": "local",

"Labels": null,

"Mountpoint": "/var/lib/docker/volumes/nginx-vol/_data",

"Name": "nginx-vol",

"Options": {},

"Scope": "local"

}

]

4)本地数据卷驱动数据不能共享

本地数据卷驱动创建的数据卷nginx-vol,其持久化的数据只能被本节点上service中的容器使用。在不同节点的数据卷中新建不同的文件,查看每个容器读取文件的情况: # 在/var/lib/docker/volumes/nginx-vol/_data 新建文件 # manager: manager.txt root@9590af9e71f5:/data# ls manager.txt # node-01: node-01.txt root@d5d785dbcdba:/data# ls node-01.txt ...... 其余节点是一样的,所以每个容器只能使用本节点数据卷中的内容

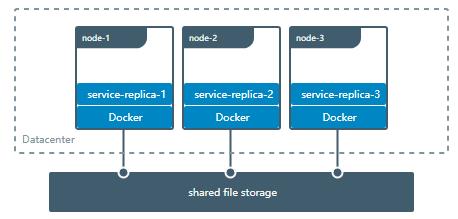

四、Swarm 共享存储NFS

当构建一个有容错机制的应用时,有一些数据或文件需要共享到各个节点服务的容器中,有多种方法可以实现,其中一种就是外部存储系统,比如NFS或者Amazon S3。

4.1 安装nfs

所以节点安装 yum -y install nfs-utils # 在manager节点上启动nfs服务端 [root@manager ~]# systemctl enable nfs [root@manager ~]# systemctl start nfs # 工作节点上启动nfs客户端 systemctl start rpcbind

4.2 在manager节点上配置nfs

# 创建目录 [root@manager ~]# mkdir -p /data/nfs_vol # 设置nfs vim /etc/exports # swarm nfs share volume /data/nfs_vol 172.16.60.0/24(rw,sync,no_root_squash) /data/nfs_vol : 共享的目录 172.16.60.0/24 : 可以访问的主机网段 rw : 可读写权限,只读权限ro sync : 同步,数据更安全,速度慢 async : 异步,速度快,效率高,安全性低 no_root_squash :NFS 服务共享的目录的属性, 如果用户是root, 对这个目录就有root的权限 # 重启nfs [root@manager data]# systemctl restart nfs

4.3 测试挂载nfs共享目录

在node-01节点 [root@node-01 ~]# mount -t nfs 172.16.60.95:/data/nfs_vol /tmp [root@node-01 tmp]# touch a.txt [root@node-01 tmp]# ls a.txt # 在manager节点查看 [root@manager ~]# ls /data/nfs_vol/ a.txt #可以,umount 掉 [root@node-01 ~]# umount /tmp

4.4 使用nfs volume创建服务

1)创建服务

[root@manager ~]# docker service create \\ > --replicas 5 \\ > --name my-nginx \\ > -p 80:80 \\ > --mount \'type=volume,src=nfs-vol,dst=/usr/share/nginx/html,volume-driver=local,volume-nocopy=true,volume-opt=type=nfs,volume-opt=device=172.16.60.95:/data/nfs_vol,"volume-opt=o=addr=172.16.60.95,vers=4,soft,timeo=180,bg,tcp,rw"\' \\ > nginx

如果遇到报错:

1/5: failed to chmod on /var/lib/docker/volumes/nfs-vol/_data: chmod /var/lib/d… 2/5: failed to chmod on /var/lib/docker/volumes/nfs-vol/_data: chmod /var/lib/d… 3/5: failed to chmod on /var/lib/docker/volumes/nfs-vol/_data: chmod /var/lib/d… 4/5: failed to chmod on /var/lib/docker/volumes/nfs-vol/_data: chmod /var/lib/d… 5/5: failed to chmod on /var/lib/docker/volumes/nfs-vol/_data: chmod /var/lib/d… # 加一个参数 volume-nocopy=true

2)查看服务

[root@manager ~]# docker service ls ID NAME MODE REPLICAS IMAGE PORTS 7xfkk34fs23o my-nginx replicated 5/5 nginx:latest *:80->80/tcp [root@manager ~]# docker service ps my-nginx ID NAME IMAGE NODE DESIRED STATE CURRENT STATE ERROR PORTS tmb0ifqwwiys my-nginx.1 nginx:latest manager Running Running 2 minutes ago 1899caz2mpuc my-nginx.2 nginx:latest node-01 Running Running 2 minutes ago o25ssf6zsbzo my-nginx.3 nginx:latest node-03 Running Running 2 minutes ago uhj1otbqw1ph my-nginx.4 nginx:latest node-03 Running Running 2 minutes ago jna7v8v6k1vm my-nginx.5 nginx:latest node-02 Running Running 2 minutes ago

3)查看数据卷

[root@manager ~]# docker volume ls DRIVER VOLUME NAME local nfs-vol

和volume一样,每个分配task的节点上都会有这个nfs-vol的数据卷

4)测试共享性

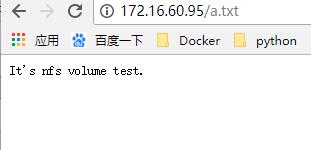

#刚才将数据卷挂载到了nginx的默认web目录/usr/share/nginx/html,是可以直接访问其中静态文件的

1. 在manager节点/var/lib/docker/volumes/nfs-vol/_data 新建 a.txt

2. 在node-01 /var/.../_data 中修改a.txt

It\'s nfs volume test.

3.访问测试

测试表明节点间可以通过nfs volume实现数据共享。

五、使用bind方式持久化数据

5.1 bind说明

Docker早期就支持这个特性。与volumes相比,Bind mounts支持的功能有限。使用bind mounts时,宿主机上的一个文件或目录被挂载到容器上。

警告:使用Bind mounts的一个副作用是,容器中运行的程序可以修改宿主机的文件系统, 包括创建,修改,删除重要的系统文件或目录。这个功能可能会有安全问题。

详细了解可参考官方文档:https://docs.docker.com/storage/bind-mounts/

5.2 使用格式

1. 读写挂载格式 #docker service create \\ --replicas 1或2或3... \\ --name SERVICE-NAME \\ --mount type=bind,src=<VOLUME-NAME>,dst=<CONNTAINER-PATH> \\ <IMAGE> 2.只读挂载格式 #docker service create \\ --replicas 1或2或3... \\ --name SERVICE-NAME \\ --mount type=bind,src=<VOLUME-NAME>,dst=<CONNTAINER-PATH>,ro \\ <IMAGE>

5.3 创建服务

1)创建挂载目录

# 在每个节点上创建 mkdir -p /data/bind_vol

2)使用bind形式创建服务

[root@manager ~]# docker service create \\ > --replicas 5 \\ > --name my-web \\ > -p 80:80 \\ > --mount type=bind,src=/data/bind_vol,dst=/usr/share/nginx/html \\ > nginx yt7gsouyw6zcdp13tay3f5eu4 overall progress: 5 out of 5 tasks 1/5: running 2/5: running 3/5: running 4/5: running 5/5: running verify: Service converged

整个形式和volume是差不多的,只不过需要指定目录路径。同样各个节点之间的数据不共享,每个容器只能使用本节点中数据卷中的内容。

以上是关于Docker集群管理Swarm数据持久化的主要内容,如果未能解决你的问题,请参考以下文章