Soft-Margin SVM

Posted wangyanphp

tags:

篇首语:本文由小常识网(cha138.com)小编为大家整理,主要介绍了Soft-Margin SVM相关的知识,希望对你有一定的参考价值。

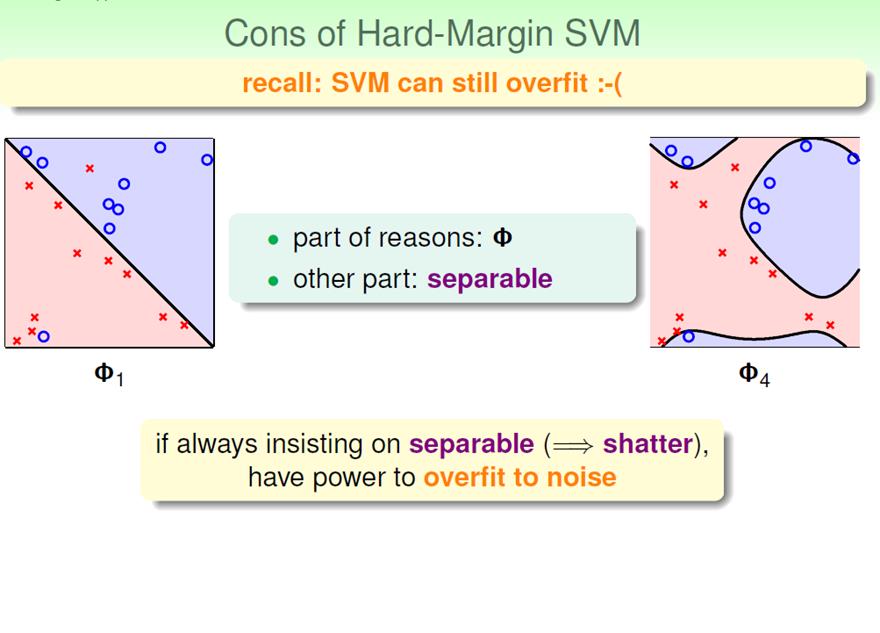

考虑这种情况:

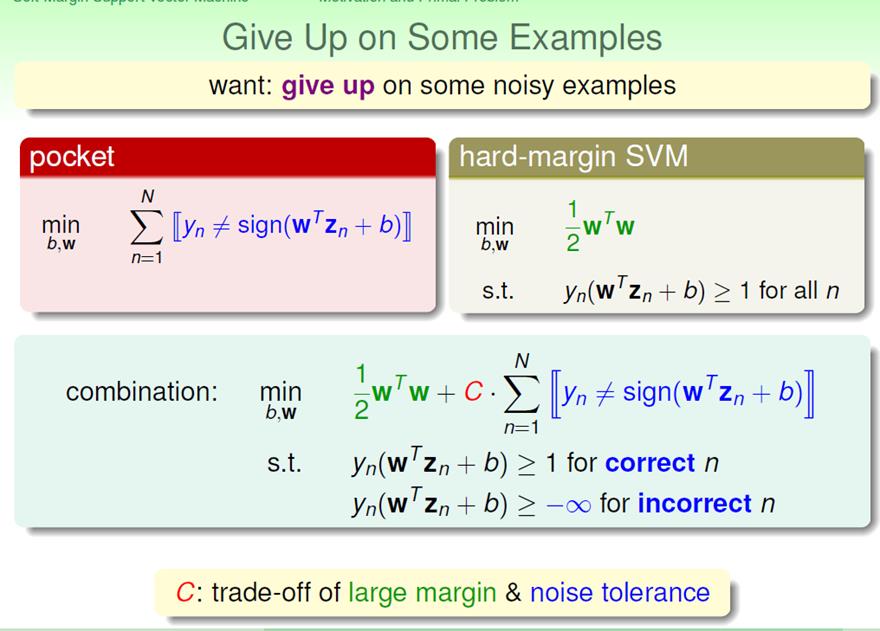

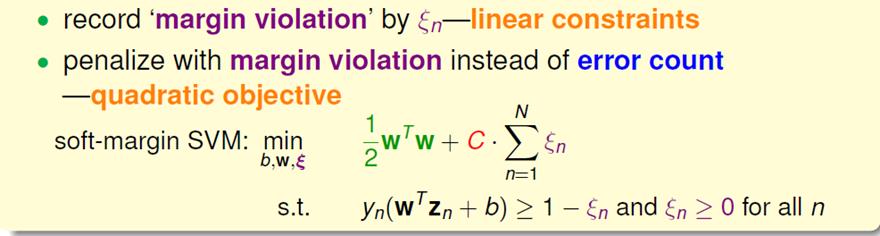

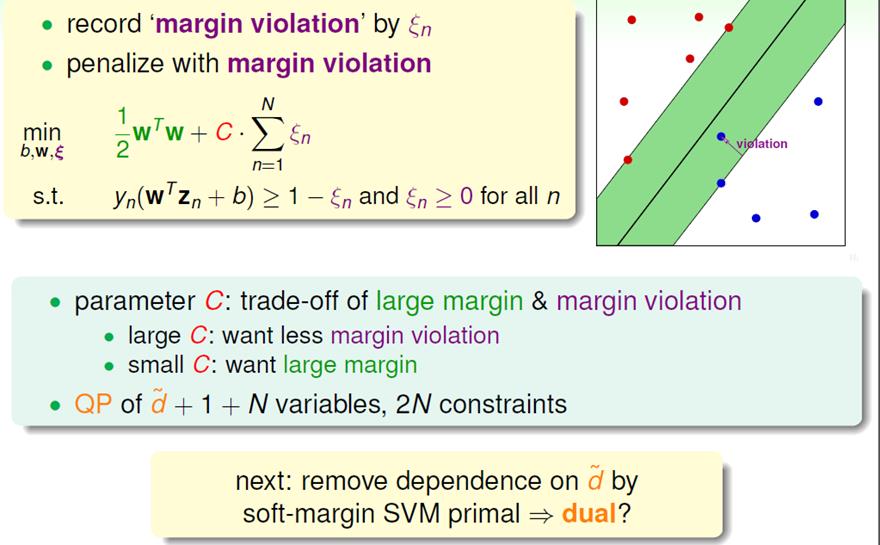

倘若我们使用Hard-Margin SVM,不容许一点点的错误,就会得到右边的结果。很显然,左边的结果更合理,所以在实际情况中,我们使用能够接纳一定错误(容忍噪声)的SVM,即:soft-margin SVM。

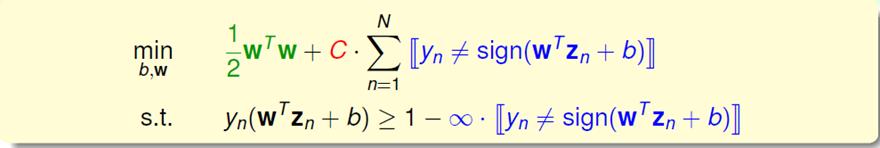

合并两个条件,得:

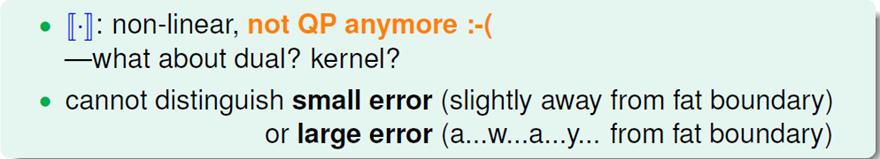

这样做有几个问题:

一是我们的目标函数不再是线性的,所以不能使用QP;第二是我们对大的误差和小的误差一视同仁。

所以我们将∞更换为ε:

(这一点也是一个疑问:ε对于每一个数据都不同,甚至也成为一个目标变量。不是很容易理解)

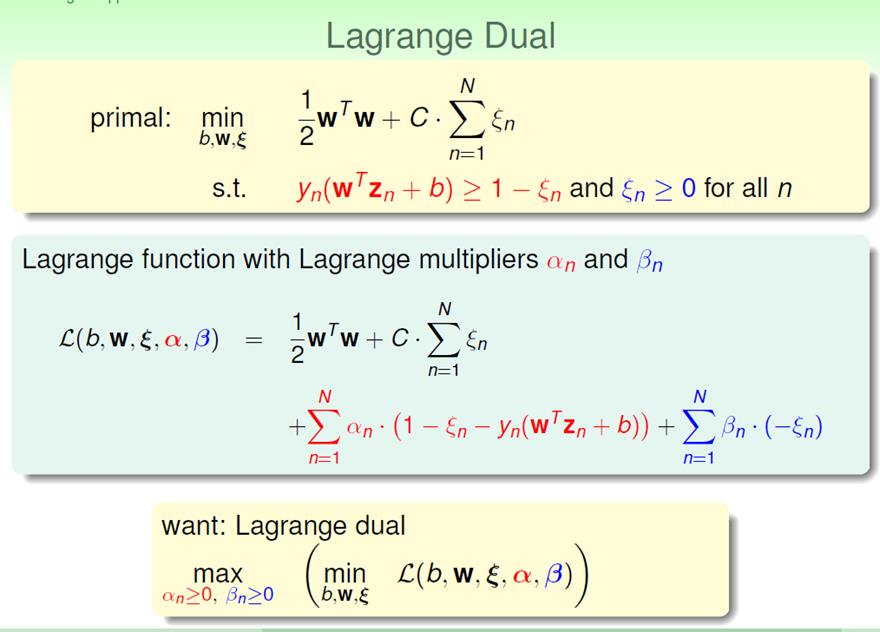

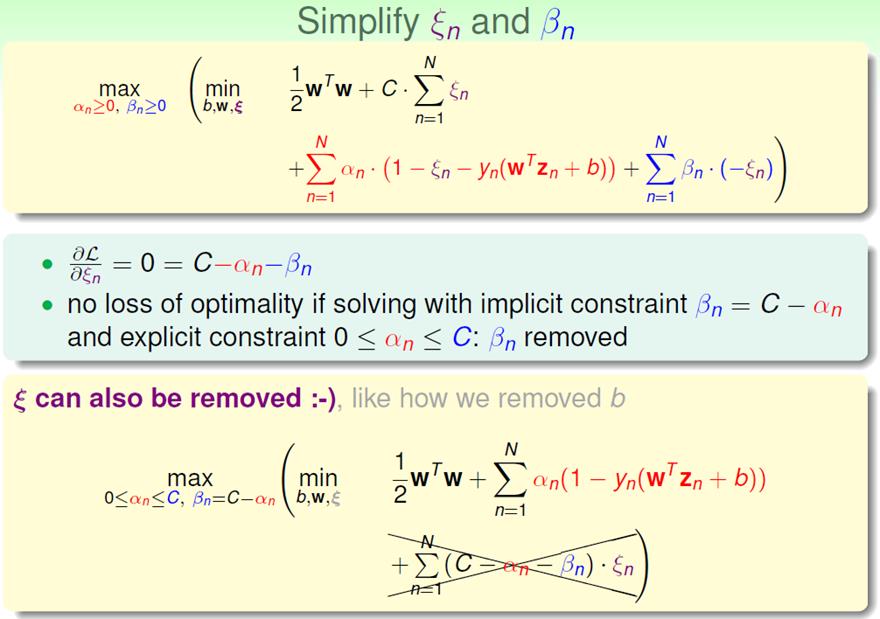

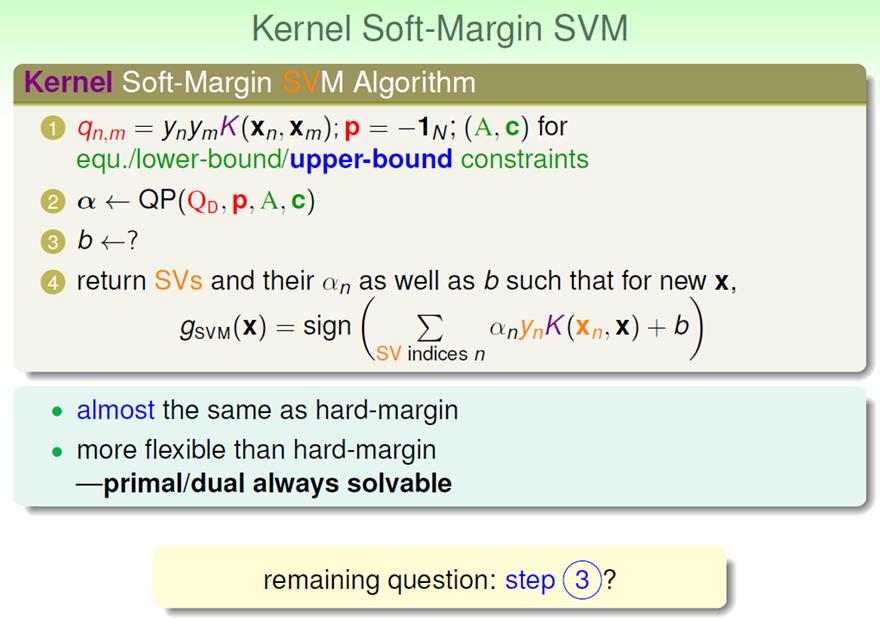

现在soft-margin SVM的形式已经阐明,如何来解?

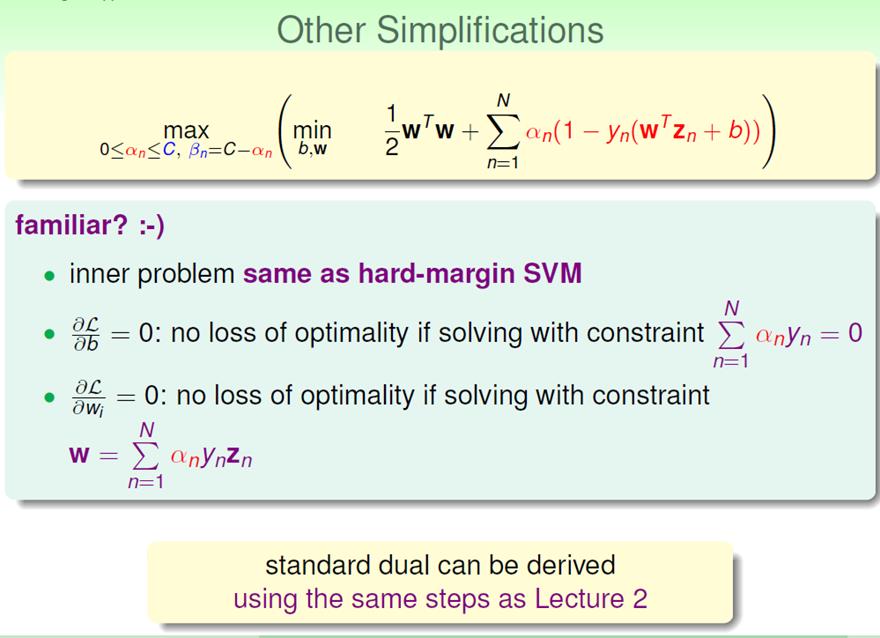

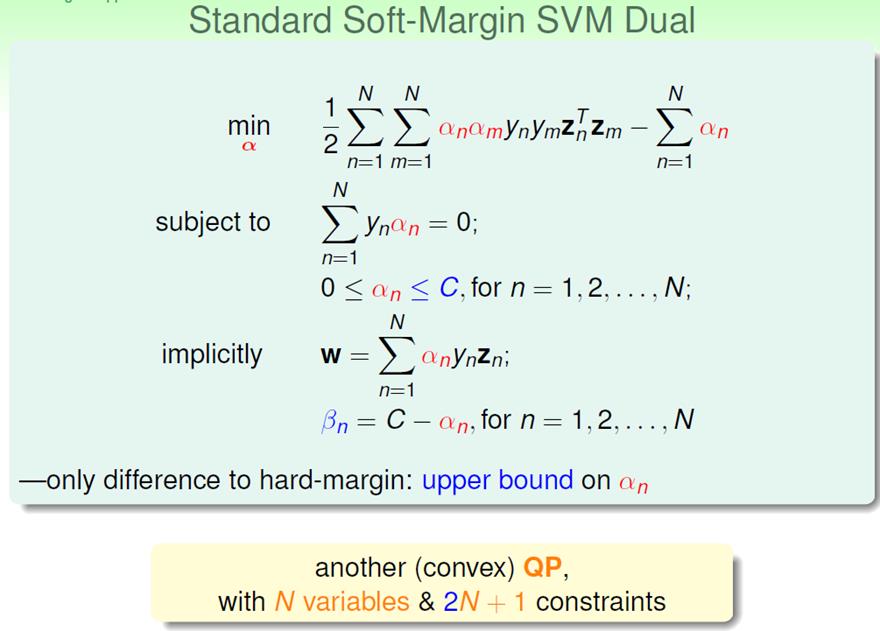

1.根据之前我们在hard-margin SVM中推导过的求解对偶问题的过程,可以得到如下结果,同时还有KKT condition中的primal-innner optimal(complementary slackness)。

求解:

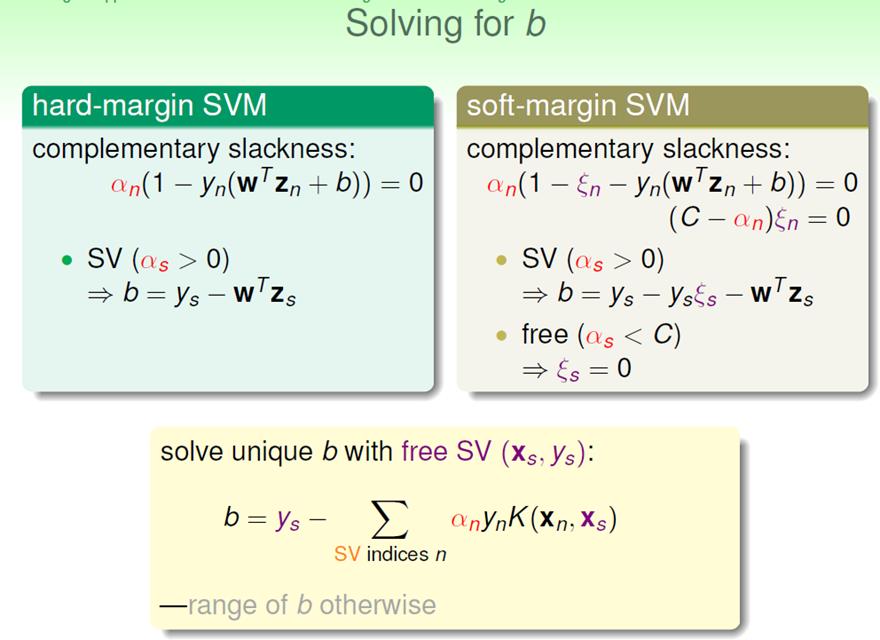

这里的问题是b如何求得?根据之前的primal-innner optimal 条件:

至此,soft-margin SVM的求解过程结束。

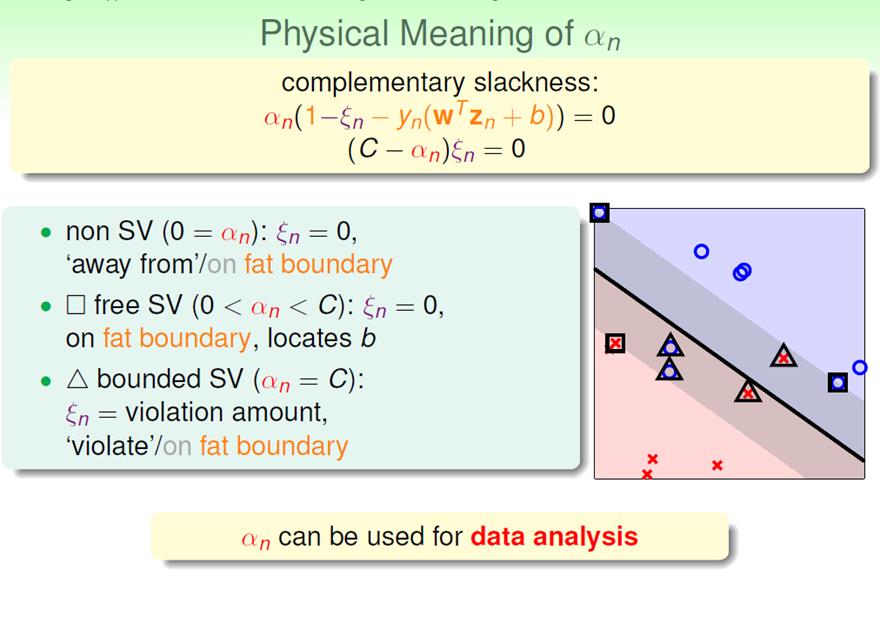

之前hard-margin我们将所有的数据点根据α的值,分为支持向量和一般向量。

现在soft-margin中,α有三种情况,可以分成三类:

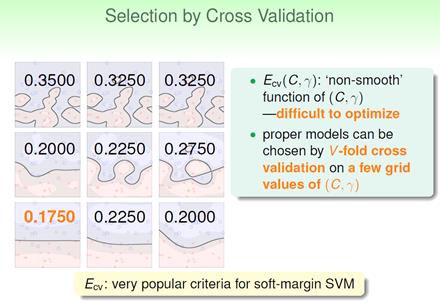

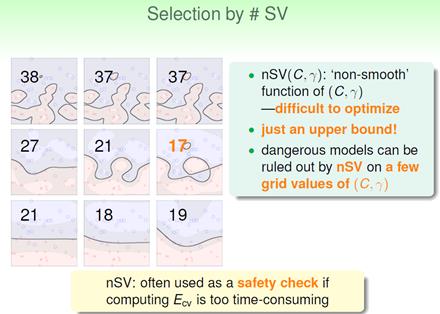

对于高斯核函数,如何选择适当的C和γ?

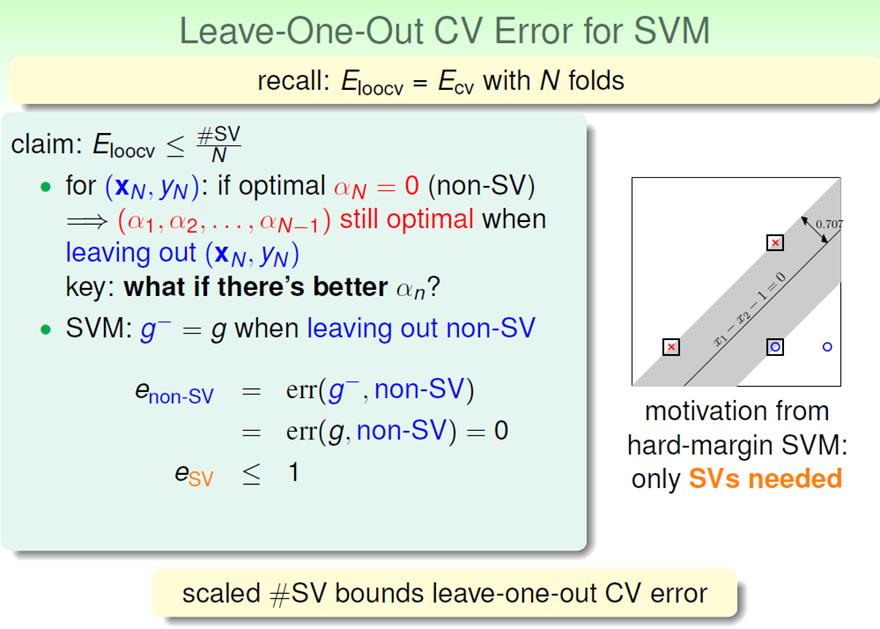

可以使用validation。同时也可以使用#SV,因为:

使用两者进行选择的区别如下:

以上是关于Soft-Margin SVM的主要内容,如果未能解决你的问题,请参考以下文章