docker mesos集群资源调度平台

Posted FRESHMANS

tags:

篇首语:本文由小常识网(cha138.com)小编为大家整理,主要介绍了docker mesos集群资源调度平台相关的知识,希望对你有一定的参考价值。

mesos原理与架构

首先,再次需要强调 Mesos 自身只是一个资源调度框架,并非一整套完整的应用管理平台,所以只有 Mesos 自己是不能干活的。但是基于 Mesos,可以比较容易地为各种应用管理框架或者中间件平台(作为 Mesos 的应用)提供分布式运行能力;同时多个框架也可以同时运行在一个 Mesos 集群中,提高整体的资源使用效率。

Mesos 对自己定位范围的划分,使得它要完成的任务很明确,其它任务框架也可以很容易的与它进行整合。

基本单元

Mesos 中有三个基本的组件:

管理服务(master)

任务服务(slave)

应用框架(framework)。

管理服务 - master

跟大部分分布式系统中类似,主节点起到管理作用,将看到全局的信息,负责不同应用框架之间的资源调度和逻辑控制。应用框架需要注册到管理服务上才能被使用。

用户和应用需要通过主节点提供的 API 来获取集群状态和操作集群资源。

任务服务 - slave

负责汇报本从节点上的资源状态(空闲资源、运行状态等等)给主节点,并负责隔离本地资源来执行主节点分配的具体任务。

隔离机制目前包括各种容器机制,包括 LXC、Docker 等。

应用框架 - framework

应用框架是实际干活的,包括两个主要组件:

调度器(scheduler):注册到主节点,等待分配资源;

执行器(executor):在从节点上执行框架指定的任务(框架也可以使用 Mesos 自带的执行器,包括 shell 脚本执行器和 Docker 执行器)。

应用框架可以分两种:一种是对资源的需求是会扩展的(比如 Hadoop、Spark 等),申请后还可能调整;一种是对资源需求大小是固定的(MPI 等),一次申请即可。

调度

对于一个资源调度框架来说,最核心的就是调度机制,怎么能快速高效地完成对某个应用框架资源的分配,是核心竞争力所在。最理想情况下(大部分时候都无法实现),最好是能猜到应用们的实际需求,实现最大化的资源使用率。

Mesos 为了实现尽量优化的调度,采取了两层(two-layer)的调度算法。

Mesos 拥有许多引人注目的特性,包括:

- 支持数万个节点的大规模场景(Apple、Twitter、eBay 等公司实践);

- 支持多种应用框架,包括 Marathon、Singularity、Aurora 等;

- 支持 HA(基于 ZooKeeper 实现);

- 支持 Docker、LXC 等容器机制进行任务隔离;

- 提供了多个流行语言的 API,包括 Python、Java、C++ 等;

- 自带了简洁易用的 WebUI,方便用户直接进行操作。

安装与使用

安装

安装主要需要 mesos、zookeeper 和 marathon 三个软件包。

Mesos 也采用了经典的主-从结构,一般包括若干主节点和大量从节点。其中,mesos master 服务和 zookeeper 需要部署到所有的主节点,mesos slave 服务需要部署到所有从节点。marathon 可以部署到主节点。

| 主机名 | IP地址 | 安装服务 |

| mesos-node1 | 192.168.132.131 |

mesos-master,mesos-slave,marathon,zookeeper,haproxy

|

| mesos-node2 | 192.168.132.132 | mesos-master,mesos-slave,marathon,zookeeper,haproxy |

| mesos-node3 | 192.168.132.133 | mesos-master,mesos-slave,marathon,zookeeper,haproxy |

源码编译

docker 安装

略过

zookeeper集群安装

略过

mesos+marathon集群部署(三台服务器上都要做同样的操作)

1、安装mesosphere仓库

rpm -ivh http://repos.mesosphere.com/el/7/noarch/RPMS/mesosphere-el-repo-7-1.noarch.rpm

2、安装mesos和marathon

yum -y install mesos marathon

3、增加zookeeper配置

$cat /etc/mesos/zk zk://192.168.132.131:2181,192.168.132.132:2181,192.168.132.133:2181/mesos

4、配置mesos-hostname

echo 本地IP地址 | tee /etc/mesos-master/ip echo 本地IP地址 | tee /etc/mesos-master/hostname echo 本地IP地址 | tee /etc/mesos-slave/ip echo 本地IP地址 | tee /etc/mesos-slave/hostname echo 2 > /etc/mesos-master/quorum #这个数字要大于安装的master节点的总数的0.5倍,即一半

5、配置mesos-master slave marathon开机自启动并启动

systemctl enable mesos-master mesos-slave marathon

systemctl start mesos-master mesos-slave marathon

6、分别编辑3台服务器的marathon,修改配置如下:

mkdir -p /etc/marathon/conf cd /etc/marathon/conf vim hostname 添加: 192.168.132.131 (其他2台为132,133)

重启服务命令:

systemctl restart mesos-master

systemctl restart marathon.service

systemctl restart mesos-slave

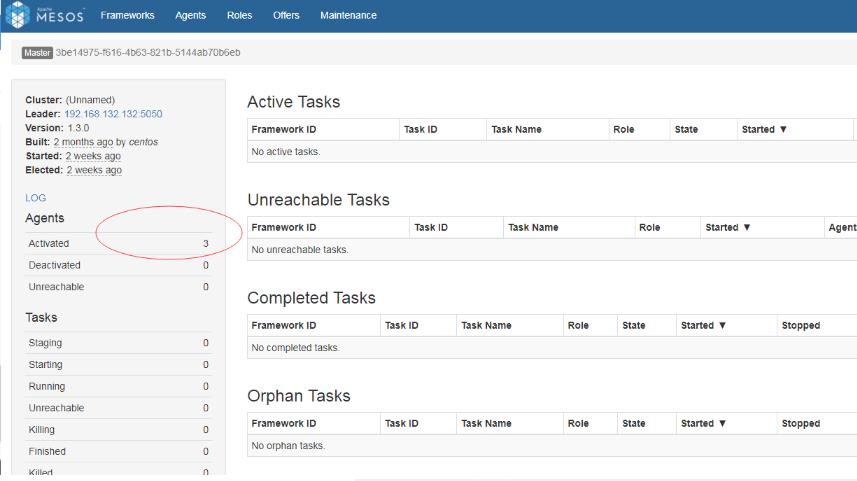

7、在浏览器打开任意一台服务的mesos

http://192.168.132.131:5050/

这里如果客户端显示不了的话,可以尝试清理mesos日志:

清理mesos:rm -rf /var/lib/mesos/*

8、配置marathon,使其可以创建docker容器(三台服务器上都要做同样的操作):

在所有mesos-slave上增加配置参数,并重启

# echo \'docker,mesos\' | tee /etc/mesos-slave/containerizers # systemctl restart mesos-slave #重启Mesos-slave

9、在浏览器中打开marathon,默认端口8080

http://192.168.132.131:8080

以上是关于docker mesos集群资源调度平台的主要内容,如果未能解决你的问题,请参考以下文章