scrapy 爬取糗事百科

Posted 严宏君

tags:

篇首语:本文由小常识网(cha138.com)小编为大家整理,主要介绍了scrapy 爬取糗事百科相关的知识,希望对你有一定的参考价值。

- 安装scrapy

conda install scrapy

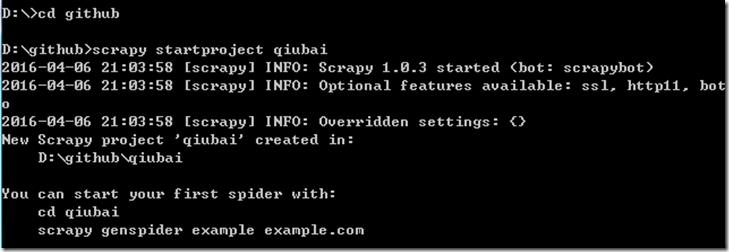

- 创建scrapy项目

scrapy startproject qiubai

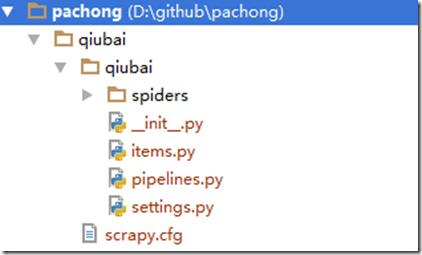

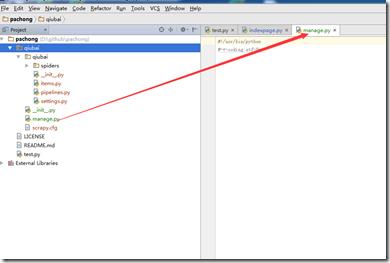

- 启动pycharm,发现新增加了qiubai这个目录

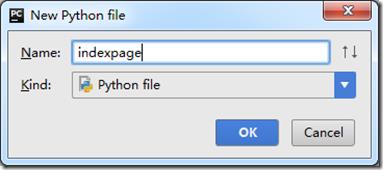

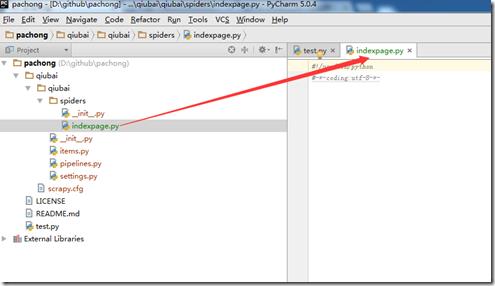

- 在spider目录下创建indexpage.py文件

- 编写糗百爬虫,获取首页的所有作者信息

#导入scrapy import scrapy #创建糗百爬虫类 class QiuBaiSpider(scrapy.Spider): #定义爬虫的名字 name = \'qiubai\' #定义爬虫开始的URL start_urls=[\'http://www.qiushibaike.com/\',] #处理爬取的信息 def parse(self, response): li=response.xpath(\'//div[@class="author clearfix"]/a[2]/h2/text()\').extract() #li=response.xpath("//h2/text()").extract() for item in li: print item

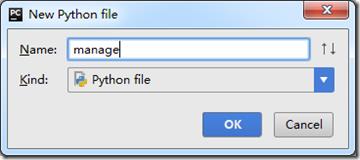

- 在和scrapy.cfg同级的目录下创建manage.py

输入代码

from scrapy.cmdline import execute execute()

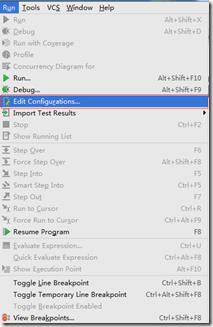

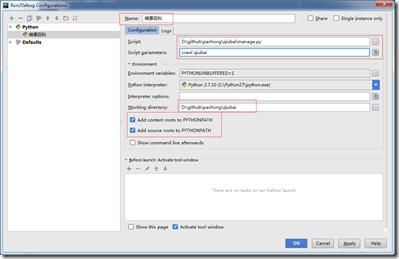

- 配置运行参数

- 查看本机useragent http://whatsmyuseragent.com/

- 在settings.py中设置USER_AGENT

USER_AGENT = \'Mozilla/5.0 (Windows NT 6.1; WOW64) AppleWebKit/537.36 (Khtml, like Gecko) Chrome/49.0.2623.110 Safari/537.36\'

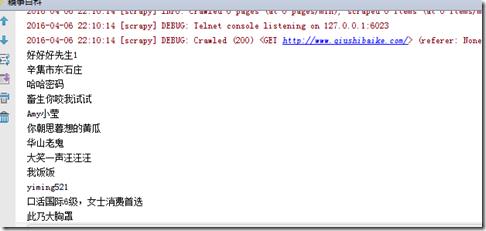

- 运行爬虫

以上是关于scrapy 爬取糗事百科的主要内容,如果未能解决你的问题,请参考以下文章