神经网络基础

Posted Google-boy

tags:

篇首语:本文由小常识网(cha138.com)小编为大家整理,主要介绍了神经网络基础相关的知识,希望对你有一定的参考价值。

2.1 二分分类

在一个二分分类问题中,结果是一个离散值的输出。

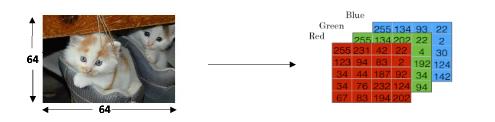

例如: 猫 VS 不是猫

这个目标是训练出一个分类器,输入是一个由特征向量x表示的图片,并且预测相关的标签y是1或者是0.这这个样例中,y是1表示是关于猫的图片(0表示非猫的图片)。

图片在计算机中存储在三个独立的矩阵中,表示图片中红、绿、蓝三色的像素值。这三个矩阵有相同的大小,例如,这张猫的图片的分辨率是64pixeis*64pixeis,这三个矩阵的(RGB)都是64*64的。

每一个单元的值表示像素的强度,像素的强度可以被用来构造一个n维的特征向量。在模式识别和机器学习中,一个特征向量表示一个对象,在本案例中,表示一只猫或者不是。

为构建一个特征向量x,对于每种颜色像素强度值将被展开重塑。输入特征向量x的维度是Nx = 64*64*3 = 12 288

2.2 logistic 回归

逻辑回顾是一个学习算法,当输出y是0或者1时被用在监督学习问题中。逻辑回归的目标是在预测和训练数据中最小化误差。

例如: 猫VS非猫

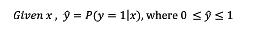

给定一个特征向量x表示一个图片,这个算法将去评估这张图片是一只猫的概率。

逻辑回归用的参数:

- 输出特征向量:

,而Nx表示特征向量的数量。

,而Nx表示特征向量的数量。 - 训练的标签:{0,1}。

- 权

,而Nx山师特征个数

,而Nx山师特征个数 - 线程数:

- 输出:

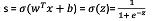

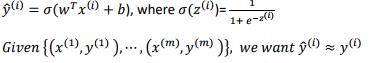

- sigmoid函数:

是一个线性函数(ax+b),但是因为我们是要寻找一个在[0,1]之间的约束的概率,因此我们使用sigmoid函数。如上图函数的取值介于[0,1]之间。

是一个线性函数(ax+b),但是因为我们是要寻找一个在[0,1]之间的约束的概率,因此我们使用sigmoid函数。如上图函数的取值介于[0,1]之间。从图中我们可以观察到:

-

如果z是一个较大的正样例,则

-

如果z是一个较小或者较大的负样例,则

-

如果z=0,则

2.3 逻辑回归之cost函数

为了训练参数w和b,我们需要定义cost函数。

概括如下;

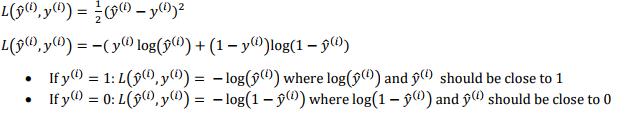

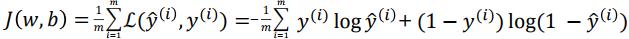

loss(error)函数:

loss函数估量的是预测值 和期望输出值

和期望输出值 之间的差异。换句话说,loss函数也就是衡量单一训练样例的(或者说算法)效果。

之间的差异。换句话说,loss函数也就是衡量单一训练样例的(或者说算法)效果。

cost函数:

cost函数是全部训练数据集的loss函数的平均估计。我们将查找出全部cost函数最小的那个对应的参数w和b,也就是说cost函数用于衡量参数w和b的效果。

2.4 梯度下降法

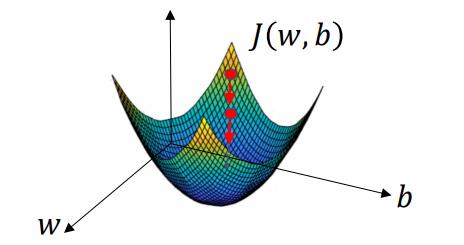

如何使用梯度下降法来训练或学习训练集上的参数w和b,使得cost函数J(w,b)尽可能小的w和b呢?

在全部训练集上,这里我们所要做的就是找到这样的w和b,使其对应的cost函数zhi使最小值。

概述:

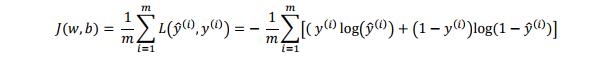

损失函数:

代价函数:

代价函数被定义为1/m的损失函数之和, 每一个训练样例都有一个输出 表示实际的输出值,与基本知识值标签

表示实际的输出值,与基本知识值标签 进行比较,等号右边对公式进行展开。要是J(w,b)最小化,这里我们所要做的就是找到这样的w和b,使其对应的cost函数zhi使最小值。下面我们一下梯度下降法:

进行比较,等号右边对公式进行展开。要是J(w,b)最小化,这里我们所要做的就是找到这样的w和b,使其对应的cost函数zhi使最小值。下面我们一下梯度下降法:

图中横纵轴分别表示w和b,在实践中w可能是更高维度的。曲面的高度表示的就是cost函数的值,我们可以看到cost函数J是一个凸函数。它的好处就不用多费口舌了哈哈。。

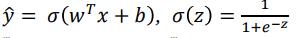

2.9逻辑回归中的梯度下降

回顾:

以上是关于神经网络基础的主要内容,如果未能解决你的问题,请参考以下文章