机器学习之Adaboost算法原理

Posted 远里歌声_why

tags:

篇首语:本文由小常识网(cha138.com)小编为大家整理,主要介绍了机器学习之Adaboost算法原理相关的知识,希望对你有一定的参考价值。

转自:http://www.cnblogs.com/pinard/p/6133937.html

在集成学习原理小结中,我们讲到了集成学习按照个体学习器之间是否存在依赖关系可以分为两类,第一个是个体学习器之间存在强依赖关系,另一类是个体学习器之间不存在强依赖关系。前者的代表算法就是是boosting系列算法。在boosting系列算法中, Adaboost是最著名的算法之一。Adaboost既可以用作分类,也可以用作回归。本文就对Adaboost算法做一个总结。

1. 回顾boosting算法的基本原理

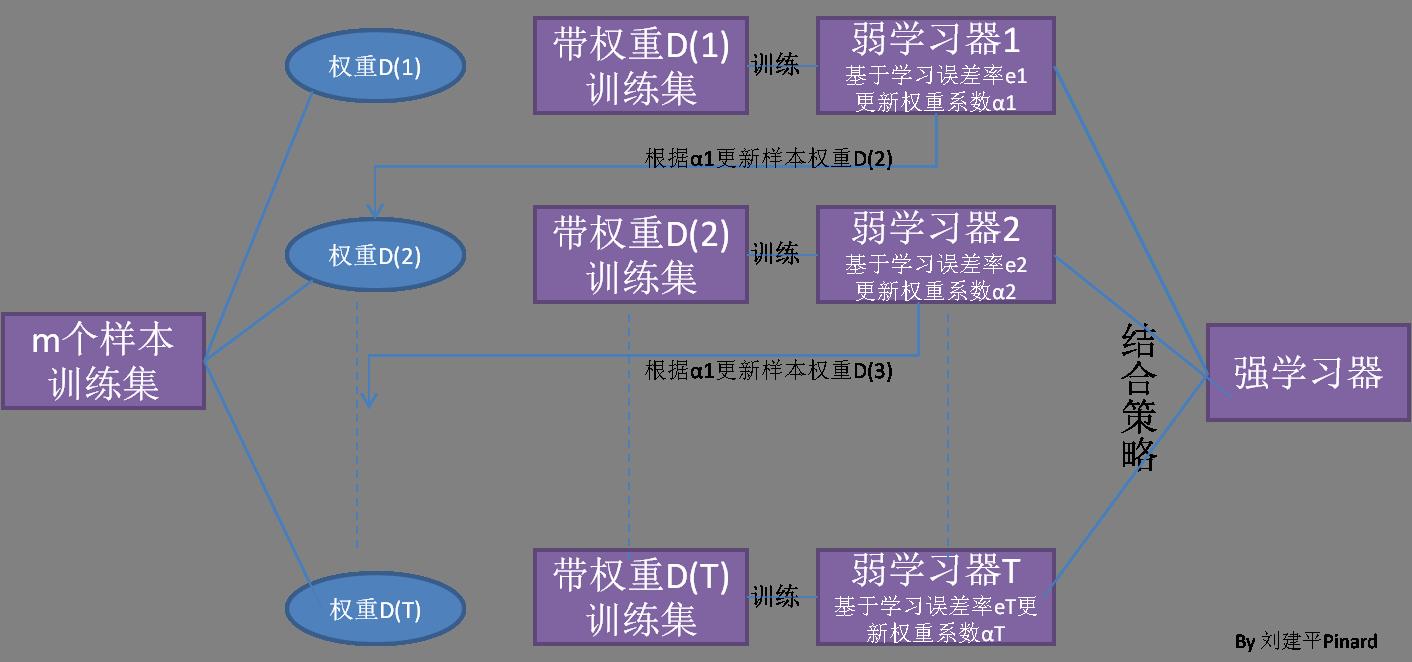

在集成学习原理小结中,我们已经讲到了boosting算法系列的基本思想,如下图:

从图中可以看出,Boosting算法的工作机制是首先从训练集用初始权重训练出一个弱学习器1,根据弱学习的学习误差率表现来更新训练样本的权重,使得之前弱学习器1学习误差率高的训练样本点的权重变高,使得这些误差率高的点在后面的弱学习器2中得到更多的重视。然后基于调整权重后的训练集来训练弱学习器2.,如此重复进行,直到弱学习器数达到事先指定的数目T,最终将这T个弱学习器通过集合策略进行整合,得到最终的强学习器。

不过有几个具体的问题Boosting算法没有详细说明。

1)如何计算学习误差率e?

2) 如何得到弱学习器权重系数 α?

α?

3)如何更新样本权重D?

4) 使用何种结合策略?

只要是boosting大家族的算法,都要解决这4个问题。那么Adaboost是怎么解决的呢?

2. Adaboost算法的基本思路

我们这里讲解Adaboost是如何解决上一节这4个问题的。

假设我们的训练集样本是

训练集的在第k个弱学习器的输出权重为

首先我们看看Adaboost的分类问题。

分类问题的误差率很好理解和计算。由于多元分类是二元分类的推广,这里假设我们是二元分类问题,输出为{-1,1},则第k个弱分类器![]()

![]()

![]() Gk(x)在训练集上的加权误差率为

Gk(x)在训练集上的加权误差率为

ek=P(Gk(xi)≠yi)=∑i=1mwkiI(Gk(xi)≠yi)

ek=P(Gk(xi)≠yi)=∑i=1mwkiI(Gk(xi)≠yi)

接着我们看弱学习器权重系数,对于二元分类问题,第k个弱分类器

Gk(x)的权重系数为

Gk(x)的权重系数为

αk=12log1−ekek

αk=12log1−ekek

为什么这样计算弱学习器权重系数?从上式可以看出,如果分类误差率

ek越大,则对应的弱分类器权重系数

ek越大,则对应的弱分类器权重系数

αk越小。也就是说,误差率小的弱分类器权重系数越大。具体为什么采用这个权重系数公式,我们在讲Adaboost的损失函数优化时再讲。

αk越小。也就是说,误差率小的弱分类器权重系数越大。具体为什么采用这个权重系数公式,我们在讲Adaboost的损失函数优化时再讲。

第三个问题,更新更新样本权重D。假设第k个弱分类器的样本集权重系数为

D(k)=(wk1,wk2,...wkm),则对应的第k+1个弱分类器的样本集权重系数为

D(k)=(wk1,wk2,...wkm),则对应的第k+1个弱分类器的样本集权重系数为

wk+1,i=wkiZKexp(−αkyiGk(xi))

wk+1,i=wkiZKexp(−αkyiGk(xi))

这里

Zk是规范化因子

Zk是规范化因子

Zk=∑i=1mwkiexp(−αkyiGk(xi))

Zk=∑i=1mwkiexp(−αkyiGk(xi))

从

wk+1,i计算公式可以看出,如果第i个样本分类错误,则

wk+1,i计算公式可以看出,如果第i个样本分类错误,则

yiGk(xi)<0,导致样本的权重在第k+1个弱分类器中增大,如果分类正确,则权重在第k+1个弱分类器中减少.具体为什么采用样本权重更新公式,我们在讲Adaboost的损失函数优化时再讲。

yiGk(xi)<0,导致样本的权重在第k+1个弱分类器中增大,如果分类正确,则权重在第k+1个弱分类器中减少.具体为什么采用样本权重更新公式,我们在讲Adaboost的损失函数优化时再讲。

最后一个问题是集合策略。Adaboost分类采用的是加权平均法,最终的强分类器为

f(x)=sign(∑k=1KαkGk(x))

f(x)=sign(∑k=1KαkGk(x))

接着我们看看Adaboost的回归问题。由于Adaboost的回归问题有很多变种,这里我们以Adaboost R2算法为准。

我们先看看回归问题的误差率的问题,对于第k个弱学习器,计算他在训练集上的最大误差