中文词频统计

Posted 刘大哈哈

tags:

篇首语:本文由小常识网(cha138.com)小编为大家整理,主要介绍了中文词频统计相关的知识,希望对你有一定的参考价值。

中文分词

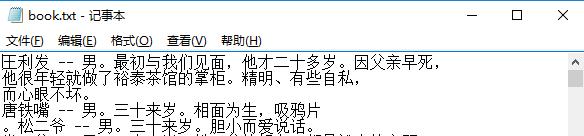

- 下载一中文长篇小说,并转换成UTF-8编码。

-

b=open(\'book.txt\',\'r\',encoding=\'utf-8\') book=b.read() b.close()

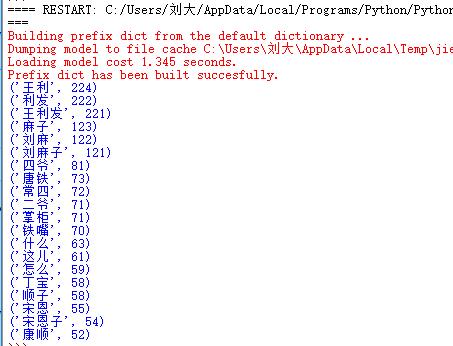

- 使用jieba库,进行中文词频统计,输出TOP20的词及出现次数。

import jieba b=open(\'book.txt\',\'r\',encoding=\'utf-8\') book=b.read() b.close() for i in \',。、!; )“”·)?:……[(-\': book=book.replace(i,\' \') books=jieba.cut(book) ex={\'的\',\'他\',\'她\',\'地\',\'吧\',\'咱们\'} ke=set(books)-ex dic={} for w in ke: if len(w)>1: dic[w]=book.count(w) wc=list(dic.items()) wc.sort(key=lambda x:x[1],reverse=True) for i in range(20): print(wc[i])

- 排除一些无意义词、合并同一词。

ex={\'的\',\'他\',\'她\',\'地\',\'吧\',\'咱们\'} ke=set(books)-ex dic={} for w in ke: if len(w)>1: dic[w]=book.count(w) wc=list(dic.items()) wc.sort(key=lambda x:x[1],reverse=True)

4.对词频统计结果做简单的解读。

老舍的《茶馆》,是一篇茶馆故事,主要人物为王利,围绕一些人物在茶馆发生的事……

以上是关于中文词频统计的主要内容,如果未能解决你的问题,请参考以下文章