中文词频统计及词云制作

Posted ZJQ-013

tags:

篇首语:本文由小常识网(cha138.com)小编为大家整理,主要介绍了中文词频统计及词云制作相关的知识,希望对你有一定的参考价值。

1.中软国际华南区技术总监曾老师还会来上两次课,同学们希望曾老师讲些什么内容?(认真想一想回答)

python的实际应用,Python的实际操作案例

2.中文分词

A.下载一中文长篇小说,并转换成UTF-8编码

《三体》中的第一章节

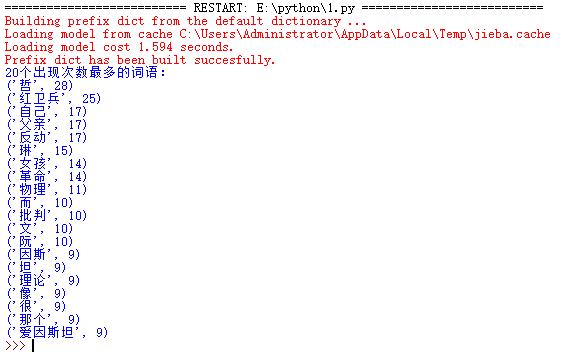

B.使用jieba库,进行中文词频统计,输出TOP20的词及出现次数

import jieba txt = open(\'三体01.txt\',\'r\').read() words = list(jieba.cut(txt)) dic= {} keys = set(words) for i in keys: dic[i] = words.count(i) wc = list(dic.items()) wc.sort(key=lambda x:x[1],reverse=True) print("20个出现次数最多的词语:") for i in range(20): print(wc[i])

C.**排除一些无意义词、合并同一词

import jieba txt = open(\'三体01.txt\',\'r\').read() exc = {\'\',\'\\n\\n\',\'叶\',\'当\',\'孩儿\',\'最\',\'就\',\'泰\',\'他们\',\'地\',\'对\',\'卫兵\',\'绍\',\'洁\',\'后\',\'们\',\'将\',\'女孩儿\',\'人\',\'已\',\'又\',\'为\',\'的\',\'了\',\'在\',\'她\',\'是\',\'你\',\'他\',\'那\',\'中\',\'都\',\'和\',\'这\',\'也\',\'着\',\'不\',\'但\',\'上\',\'被\',\'说\',\'我\',\'有\',\'一个\',\'没有\'} words = list(jieba.cut(txt,cut_all=True)) dic= {} keys = set(words) for i in exc: keys.remove(i) for i in keys: dic[i] = words.count(i) wc = list(dic.items()) wc.sort(key=lambda x:x[1],reverse=True) print("20个出现次数最多的词语:") for i in range(20): print(wc[i])

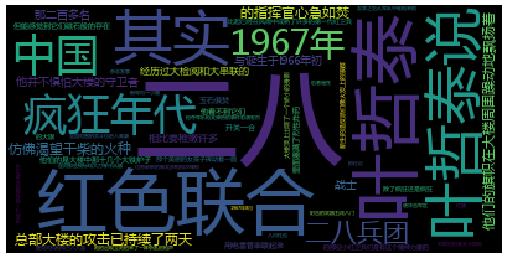

D.**使用wordcloud库绘制一个词云

from wordcloud import WordCloud import matplotlib.pyplot as plt txt = open(\'三体01.txt\',\'r\').read() words = WordCloud().generate(txt) plt.imshow(words) plt.axis(\'off\') plt.show()

以上是关于中文词频统计及词云制作的主要内容,如果未能解决你的问题,请参考以下文章