中文词频统计及词云制作

Posted 47何梓亮

tags:

篇首语:本文由小常识网(cha138.com)小编为大家整理,主要介绍了中文词频统计及词云制作相关的知识,希望对你有一定的参考价值。

1.中软国际华南区技术总监曾老师还会来上两次课,同学们希望曾老师讲些什么内容?(认真想一想回答)

希望老师能讲讲更多关于python的知识,并且讲讲大数据的的另一些方向

2.中文分词

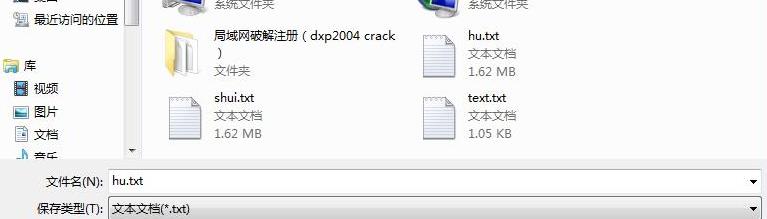

a。下载一中文长篇小说,并转换成UTF-8编码。

b.使用jieba库,进行中文词频统计,输出TOP20的词及出现次数。

import jieba ff=open(\'wdqk.txt\',\'r\',encoding=\'utf-8\') wdqk=ff.read() for i in \',.""?!,。?!“”\\n\': wdqk=wdqk.replace(i,\' \') wdqk=list(jieba.cut(wdqk)) zd={} paichu={\'我\',\'的\',\'心\',\'好\',\'冷\',\'在\',\'有\',\'了\',\'浩\',\'然\',} key=set(wdqk)-paichu for i in key: zd[i]=wdqk.count(i) lb=list(zd.items()) lb.sort(key=lambda x:x[1],reverse=True) print(\'频率最高top10:\\n\') for i in range(10): print(lb[i]) ff.close()

Building prefix dict from the default dictionary ...

Loading model from cache C:\\Users\\ADMINI~1\\AppData\\Local\\Temp\\jieba.cache

Loading model cost 0.723 seconds.

Prefix dict has been built succesfully.

我 575

的 413

心 375

好 286

冷 251

在 198

有 155

了 135

浩 124

然 113

以上是关于中文词频统计及词云制作的主要内容,如果未能解决你的问题,请参考以下文章