[持续交付实践] pipelne:pipeline 使用之项目样例

Posted Cay

tags:

篇首语:本文由小常识网(cha138.com)小编为大家整理,主要介绍了[持续交付实践] pipelne:pipeline 使用之项目样例相关的知识,希望对你有一定的参考价值。

项目说明

本文将以一个微服务项目的具体pipeline样例进行脚本编写说明。一条完整的pipeline交付流水线通常会包括代码获取、单元测试、静态检查、打包部署、接口层测试、UI层测试、性能专项测试(可能还有安全、APP等专项)、人工验收等研发测试环节,还会包括灰度发布、正式发布等发布环节。

补充说明:

1.此项目的部署还是使用传统虚拟机服务器的方式,暂未采用docker容器,docker容器与pipeline的结合后面会有其他专题进行说明。

2.灰度发布、正式发布等发布环节,由于涉及到线上发布系统对接,该项目暂未包括,后续专题展开。

3.采用jenkins官方推荐的declarative pipeline方式实现。

交付流水线(BlueOcean)

Jenkins UI从2006年-2016年,几乎没有变化。为了适应Jenkins Pipeline和 Freestyle jobs任务,Jenkins推出了BlueOcean UI,其目的就是让程序员执行任务时,降低工作流程的复杂度和提升工作流程的清晰度

BlueOcean目前为止还是作为一个插件,需要Jenkins版本2.7.x以上,按照jenkins社区的规划,未来也许会逐渐取代原有的jenkins界面。

当然目前功能上还不是太成熟,期待未来更加强大吧,不过UI界面上确实非常漂亮。

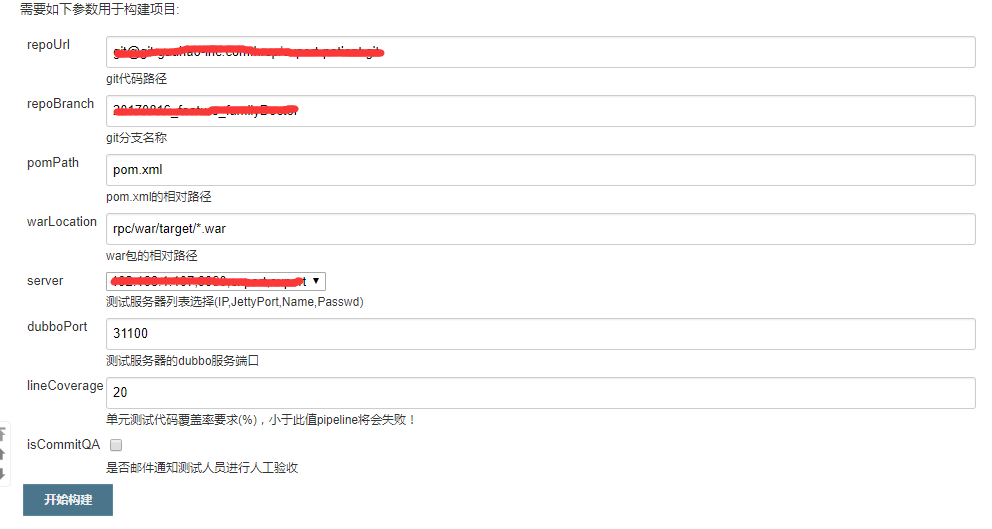

参数化构建界面

交付流水线界面

脚本详解

Pipeline支持两种语法:Declarative Pipeline(在Pipeline 2.5中引入,结构化方式)和Scripted Pipeline,两者都支持建立连续输送Pipeline。

为与BlueOcean脚本编辑器兼容,通常建议使用Declarative Pipeline的方式进行编写,从jenkins社区的动向来看,很明显这种语法结构也会是未来的趋势。

下面的样例以Declarative Pipeline的方式进行详细讲解,关键步骤都增加了注解和说明,部分公司敏感信息做了脱敏处理。

#!groovy

pipeline {

//在任何可用的代理上执行Pipeline

agent any

//参数化变量,目前只支持[booleanParam, choice, credentials, file, text, password, run, string]这几种参数类型,其他高级参数化类型还需等待社区支持。

parameters {

//git代码路径【参数值对外隐藏】

string(name:‘repoUrl‘, defaultValue: ‘[email protected]*****.com:*****/*****.git‘, description: ‘git代码路径‘)

//repoBranch参数后续替换成git parameter不再依赖手工输入,JENKINS-46451【git parameters目前还不支持pipeline】

string(name:‘repoBranch‘, defaultValue: ‘master‘, description: ‘git分支名称‘)

//pom.xml的相对路径

string(name:‘pomPath‘, defaultValue: ‘pom.xml‘, description: ‘pom.xml的相对路径‘)

//war包的相对路径

string(name:‘warLocation‘, defaultValue: ‘rpc/war/target/*.war‘, description: ‘war包的相对路径 ‘)

//服务器参数采用了组合方式,避免多次选择,使用docker为更佳实践【参数值对外隐藏】

choice(name: ‘server‘,choices:‘192.168.1.107,9090,*****,*****\n192.168.1.60,9090,*****,*****‘, description: ‘测试服务器列表选择(IP,JettyPort,Name,Passwd)‘)

//测试服务器的dubbo服务端口

string(name:‘dubboPort‘, defaultValue: ‘31100‘, description: ‘测试服务器的dubbo服务端口‘)

//单元测试代码覆盖率要求,各项目视要求调整参数

string(name:‘lineCoverage‘, defaultValue: ‘20‘, description: ‘单元测试代码覆盖率要求(%),小于此值pipeline将会失败!‘)

//若勾选在pipelie完成后会邮件通知测试人员进行验收

booleanParam(name: ‘isCommitQA‘,description: ‘是否邮件通知测试人员进行人工验收‘,defaultValue: false )

}

//环境变量,初始确定后一般不需更改

tools {

maven ‘maven3‘

jdk ‘jdk8‘

}

//常量参数,初始确定后一般不需更改

environment{

//git服务全系统只读账号cred_id【参数值对外隐藏】

CRED_ID=‘*****-****-****-****-*********‘

//测试人员邮箱地址【参数值对外隐藏】

QA_EMAIL=‘*****@*****.com‘

//接口测试(网络层)的job名,一般由测试人员编写

ITEST_JOBNAME=‘Guahao_InterfaceTest_ExpertPatient‘

}

options {

//保持构建的最大个数

buildDiscarder(logRotator(numToKeepStr: ‘10‘))

}

//定期检查开发代码更新,工作日每晚4点做daily build

triggers {

pollSCM(‘H 4 * * 1-5‘)

}

//pipeline的各个阶段场景

stages {

stage(‘代码获取‘) {

steps {

//根据param.server分割获取参数,包括IP,jettyPort,username,password

script {

def split=params.server.split(",")

serverIP