China Azure 在HDinsight 中使用Spark 功能

Posted

tags:

篇首语:本文由小常识网(cha138.com)小编为大家整理,主要介绍了China Azure 在HDinsight 中使用Spark 功能相关的知识,希望对你有一定的参考价值。

国际版的Azure 已经可以正常支持Spark应用,但是当我们在使用中国版的Azure的时候,在Azure中国版官网里面发现了有对Spark服务的介绍,而真正去使用的时候,却发现无法创建。只有Storm,HBase和Hadoop。如图:

那问题来了,中国版Azure的HDInsight是否支持Spark?

答案当然可以,不过需要自定义一下:

首先我们需要创建一个PAAS 层SQL Database 用来用以存储Hive、Oozie的元数据。

创建基于PAAS 层的HADOOP 集群:

HDInsight 3.1 clusters会安装Spark 1.0.2

HDInsight 3.2 clusters会安装Spark 1.2.0

配置集群节点和虚拟机:

配置访问用户,勾选配置Oozie云存储:

配置Oozie存储SQL Database数据库:

配置存储:

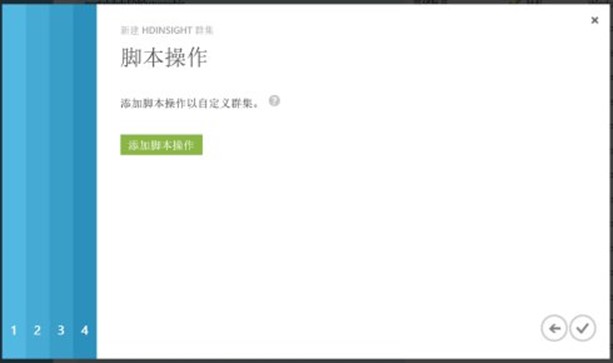

使用脚本安装Spark:

插入Spark 配置脚步:

https://hdiconfigactions.blob.core.windows.net/sparkconfigactionv03/spark-installer-v03.ps1 。节点类型选择"仅头结点"

最后点击"创建"按钮即可。

本文出自 “jeff-微软公有云” 博客,请务必保留此出处http://jeffcsc.blog.51cto.com/8669937/1738377

以上是关于China Azure 在HDinsight 中使用Spark 功能的主要内容,如果未能解决你的问题,请参考以下文章

Microsoft.Azure.Management.HDInsight.Job 的 .Netcore 替代品?

如何通过 Azure Hdinsight 在 Visual Studio 中使用 pig

基于 Azure 的 Hadoop 集群 (HDInsight) 如何转换为经典的本地 Hadoop 集群