统计学习方法[6]——逻辑回归模型

Posted WOTGL

tags:

篇首语:本文由小常识网(cha138.com)小编为大家整理,主要介绍了统计学习方法[6]——逻辑回归模型相关的知识,希望对你有一定的参考价值。

统计学习方法由三个要素组成:方法=模型+策略+算法

模型是针对具体的问题做的假设空间,是学习算法要求解的参数空间。例如模型可以是线性函数等。

策略是学习算法学习的目标,不同的问题可以有不同的学习目标,例如经验风险最小化或者结构风险最小化。

经验风险最小化中常见的损失函数有:0-1损失函数、残差损失函数、绝对值损失函数、平方损失函数、对数损失函数等等。

算法是按照上述策略求解模型的具体计算方法。模型定义了要求什么,策略定义了按照什么标准去求,算法则具体去解决。

线性回归模型

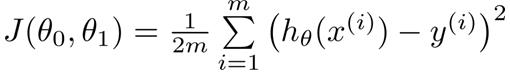

线性回归模型,众所周知就是给定给定训练集(Xi,Yi),模拟一个一次线性函数Y\'=∑ΘiXi(模型),使得误差J(Y,Y\')尽可能最小(策略)。

如果要用线性回归问题解决分类问题的话,需要将线性回归函数转换成0-1分布的函数,逻辑斯蒂函数就是这样一个函数,可以将值映射为区间(0,1)上,同时又能很好的表示概率意义。

那么如何求解参数使损失函数最小呢?

当然可以用暴力搜索所有的参数值Θ,但是效率肯定很低,所以用有目标的(启发式)搜索算法代替暴力搜索。这里的目标就是上述损失函数最小策略。

假设空间参数是经验风险的函数!举个例子,对于

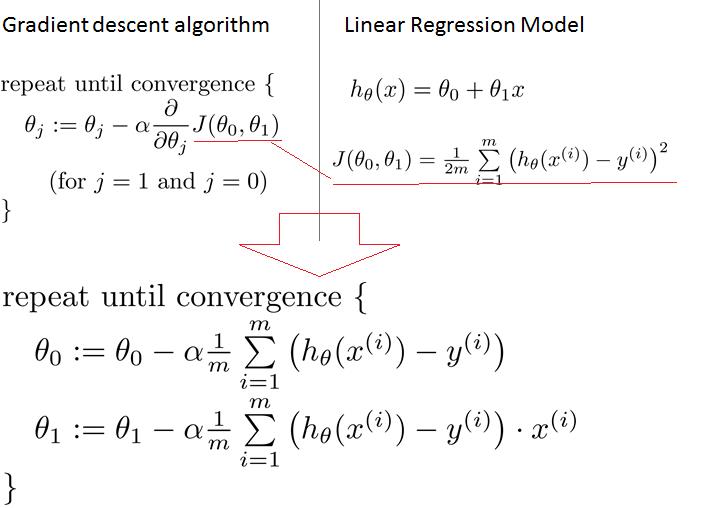

梯度下降法

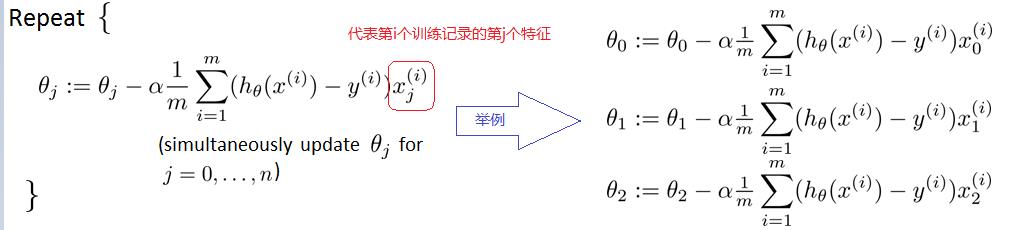

大致步骤如下:

1、随机初始化参数Θ,并给定一个学习速率α(下降的步长)

2、求解目标函数(损失函数)相对于各个参数分量Θi的偏导数

3、循环同步迭代Θi直到达到终止条件(迭代次数或者一个误差值)

参考博客:http://blog.csdn.net/xiazdong/article/details/7950084

以上是关于统计学习方法[6]——逻辑回归模型的主要内容,如果未能解决你的问题,请参考以下文章