搭建Hbase和Spark环境

Posted

tags:

篇首语:本文由小常识网(cha138.com)小编为大家整理,主要介绍了搭建Hbase和Spark环境相关的知识,希望对你有一定的参考价值。

前期准备:

1.默认已经搭建好了hadoop环境(我的hadoop版本是2.5.0)

2.这里我用的Hbase是0.98.6,spark是1.3.0

一、搭建Hbase

1、上传Hbase安装包,将/opt/software下的hbase安装包解压到/opt/app目录下

2、进入hbase目录下,修改配置文件

1>修改hbase-env.sh文件

将export JAVA_HOME = 你的Java安装路径,我的路径是/opt/app/jdk1.7.0_79

所以改完后是 export JAVA_HOME=/opt/app/jdk1.7.0_79

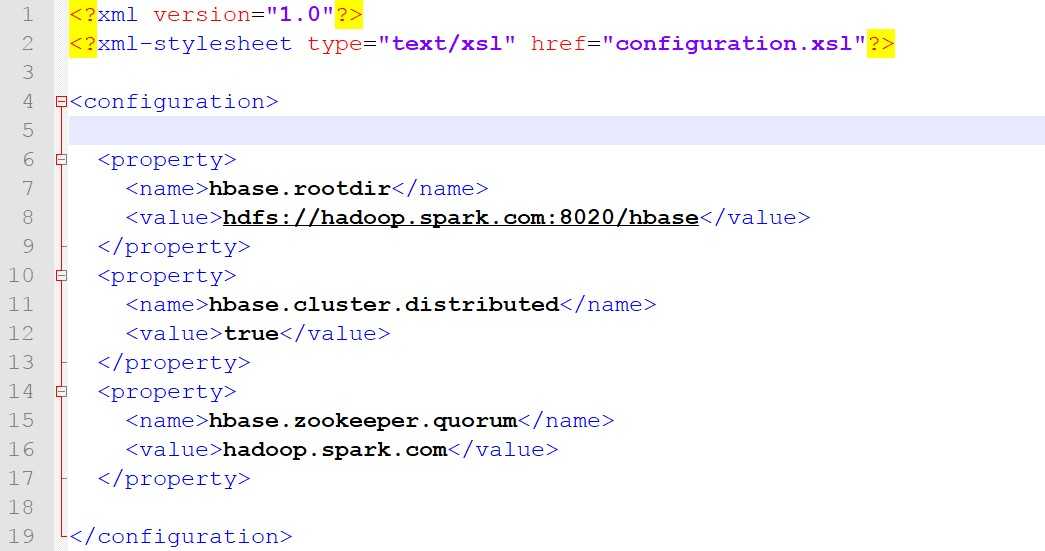

2>修改hbase-site.xml文件,改成以下内容

说明:

这里hadoop.spark.com是我的主机名,如果大家没有配置ip地址映射的话,这里就应该是你ip地址

这里hbase.zookeeper.quorum的值是zookeeper所在的机器,我这里是伪分布式,所以还是我的主机名

3>修改regionservers文件

将localhost 替换成 你的主机名(已经配置ip地址映射)或者ip地址

至此,Hbase环境搭建完成

二、搭建Spark

1.首先安装scala

1>上传scala安装包,将/opt/software/下的scala安装包解压到/opt/app/目录下

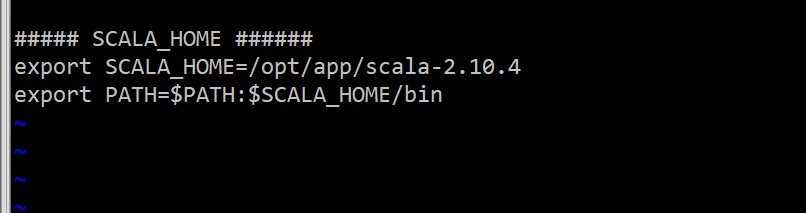

2>配置scala环境变量

切换到root用户下,编辑/etc/profile文件,在文件末尾加上环境路径

3>重启/etc/profile文件后者重启系统

source /etc/profile 或者 reboot

4>检查scala安装

scala -version

2、安装Spark

1>上传scala安装包,并将/opt/software目录下的scala安装包解压到/opt/app/目录下

2>进入Spark目录下,修改配置文件

-

-

- 将slaves.template文件重命名为slaves,并将里面的内容改成你的主机名或者你的ip地址

- 将log4j.properties.template文件重命名为log4j.properties,里面的内容不做任何修改,这个文件是记录日志的

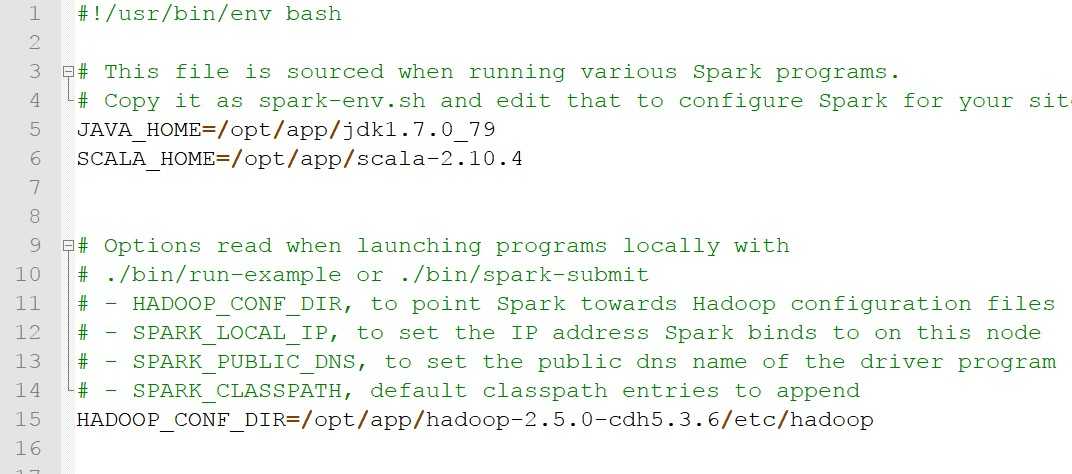

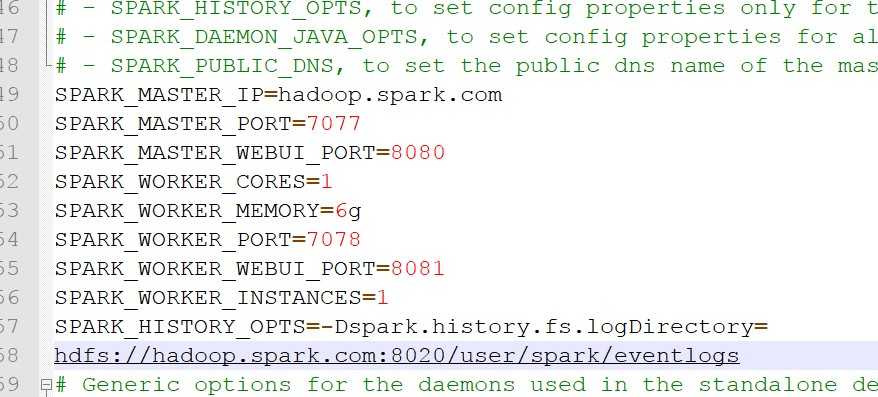

- 将spark-env.template文件重命名为spark-env,修改成以下:

-

注意:这里SPARK_HISTORY_OPTS=......,要一行写完,我这里是为了演示,所以分两行写

-

-

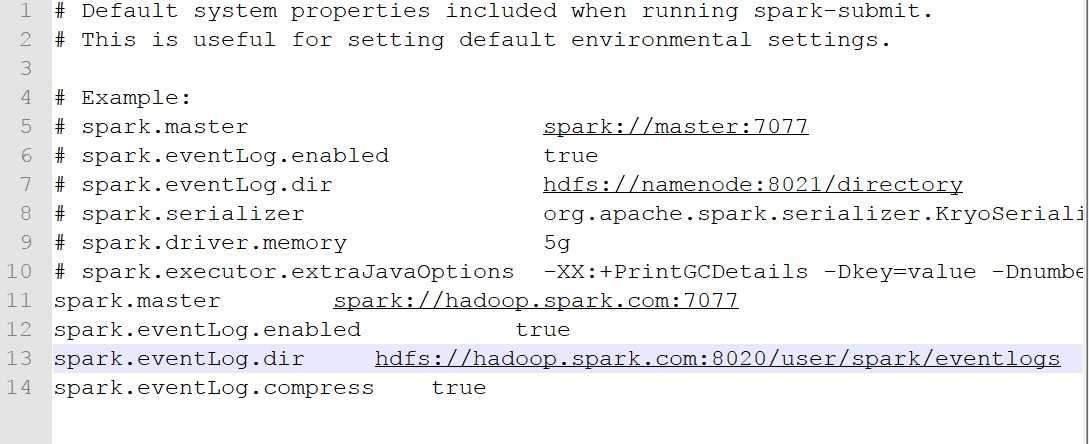

- 将spark-default.conf.template文件重命名为spark-default.conf,修改完成后内容如下

-

至此,spark环境搭建成功了

以上是关于搭建Hbase和Spark环境的主要内容,如果未能解决你的问题,请参考以下文章