梯度下降在实践I -特征缩放

Posted 郑哲

tags:

篇首语:本文由小常识网(cha138.com)小编为大家整理,主要介绍了梯度下降在实践I -特征缩放相关的知识,希望对你有一定的参考价值。

我们可以通过使每个输入值在大致相同的范围内加快梯度下降速度。这是因为θ下降很快在小范围和在大范围很慢,所以将振荡不到最佳当变量很不平衡

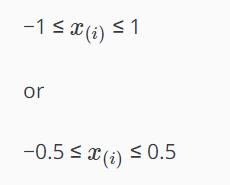

防止这种情况的方法是修改输入变量的范围,使它们完全相同。理想的:

这些不是确切的要求,我们只是想加快速度。我们的目标是将所有输入变量大致放在其中一个范围内,或取一些。

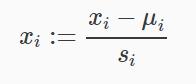

有两种技术可以帮助我们进行特征缩放和均值归一化。特征缩放包括将输入值除以输入变量的最大值(即最大值减去最小值),从而使新范围仅为1。均值归一化包括从输入变量的值减去输入变量的平均值,从而使输入变量的新平均值为零。要实现这两种技术,请调整您的输入值,如本公式所示:

ui:第i组输入量的平均值。

si:第i组输入量的最大值减去最小值。

请注意除以范围,或除以标准偏差,给出不同的结果。本课程的测验使用范围-编程练习使用标准差。

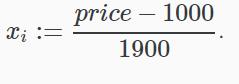

例如,如果XI表示房价为100到2000,平均值为1000,那么,

以上是关于梯度下降在实践I -特征缩放的主要内容,如果未能解决你的问题,请参考以下文章