MCMC采样理论的一点知识

Posted 我爱你,中国!中国加油,武汉加油!

tags:

篇首语:本文由小常识网(cha138.com)小编为大家整理,主要介绍了MCMC采样理论的一点知识相关的知识,希望对你有一定的参考价值。

看了好多相关的知识,大致了解了一下马尔可夫链-蒙特卡罗采样理论,有必要记来下来。

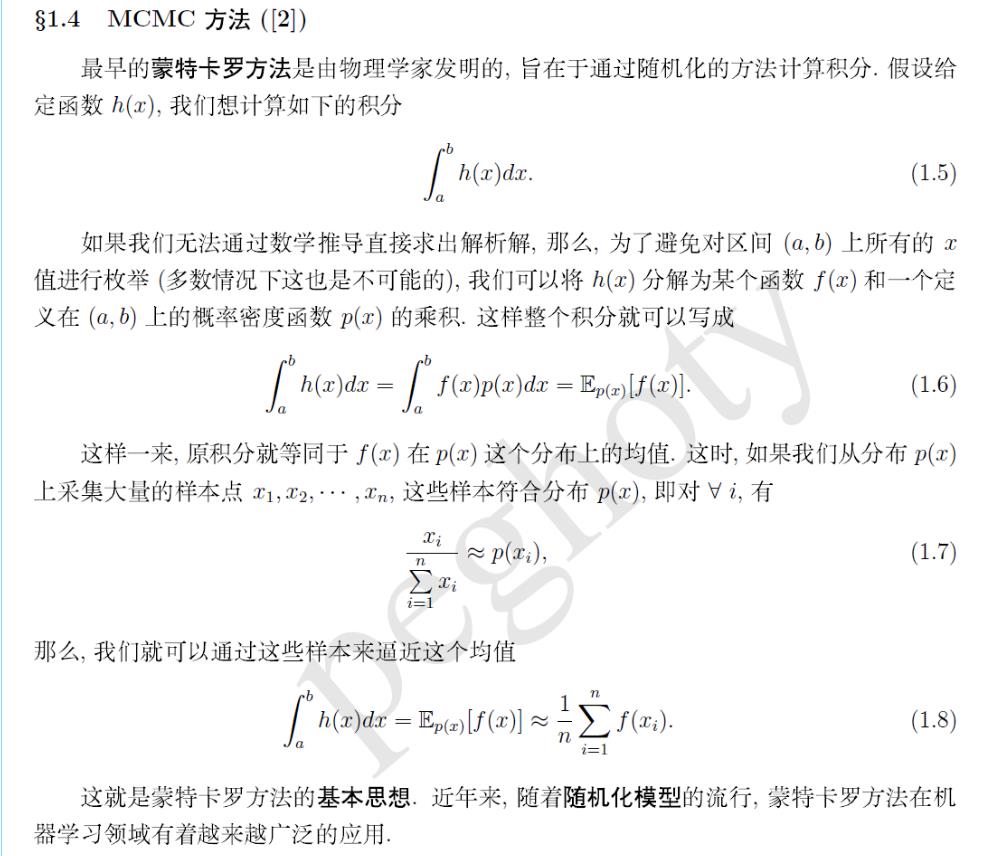

蒙特卡罗积分:(来自:http://blog.csdn.net/itplus/article/details/19168937)

下面的写的很让人明白:好好理解一下,第一次感觉到积分与统计学的联系。

利用蒙特卡罗方法求积分的重点就是怎么如何采样指定的分布。。。。简单的分布如均匀分布我们有方法可以采样,但是复复杂的分布呢?如高斯分布呢?你怎么办??

这是就利用马尔可夫链的性质进行采样。

一些马尔可夫链的相关知识

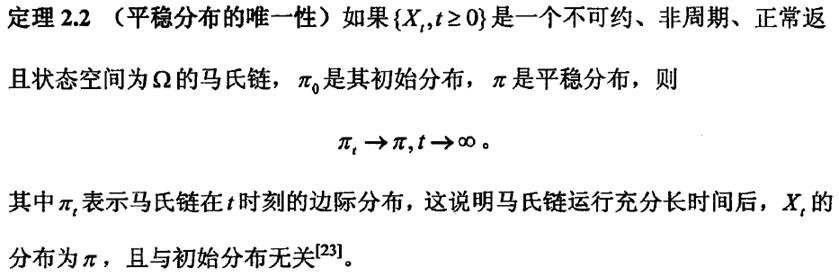

在学习随机过程中,我们已经学习到了马尔可夫链的平稳性质。下面列举一下它的我们需要用到的性质(参考:叶钫. 马尔可夫链蒙特卡罗方法及其R实现[D]. 南京大学, 2014.)

平稳性的性质:

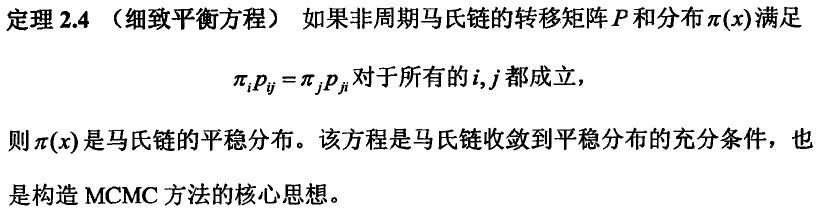

细致平衡性方程,很重要的。

这个等式,也可以这么理解,当进入稳定性的分布以后呢,从状态 i 传到状态 j 的能量与从状态 j 传递到状态 i 的能量是相同的。因为他们是平稳分布。

所以呢,现在的问题就是:我们想要按一定的 目标概率分布 进行采样,我们如何用马尔可夫链进行呢??

方法就是:构造一个马尔可夫链的稳态分布就是我们的 目标概率分布 , 谁决定了最后的稳态分布的概率呢?? 转移概率!!!!!所以呢,关键就是怎么构造转移概率。(一开始的时候,我老是想马尔可夫模型的状态如何确定呢?只有确定了状态才能求构造转移概率吧。。。。一直想不明白的。。。。。。现在觉得 这个问题不用先想,后面自然而然地就出来了)

我们构造转移概率的依据就是细致平衡条件;

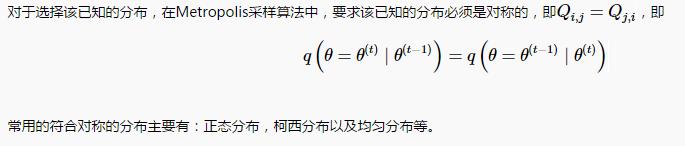

一, 最基本的Metropolis采样算法

不多说明,因为,它其实就是Metropolis-Hastings算法的殊形式,即要求使用的状态提议分布函数为对称的,即:

此时的状态的接受函数也跟着变化了。变简单了。。

所以呢,直接看Metropolis-Hastings算法就好了。

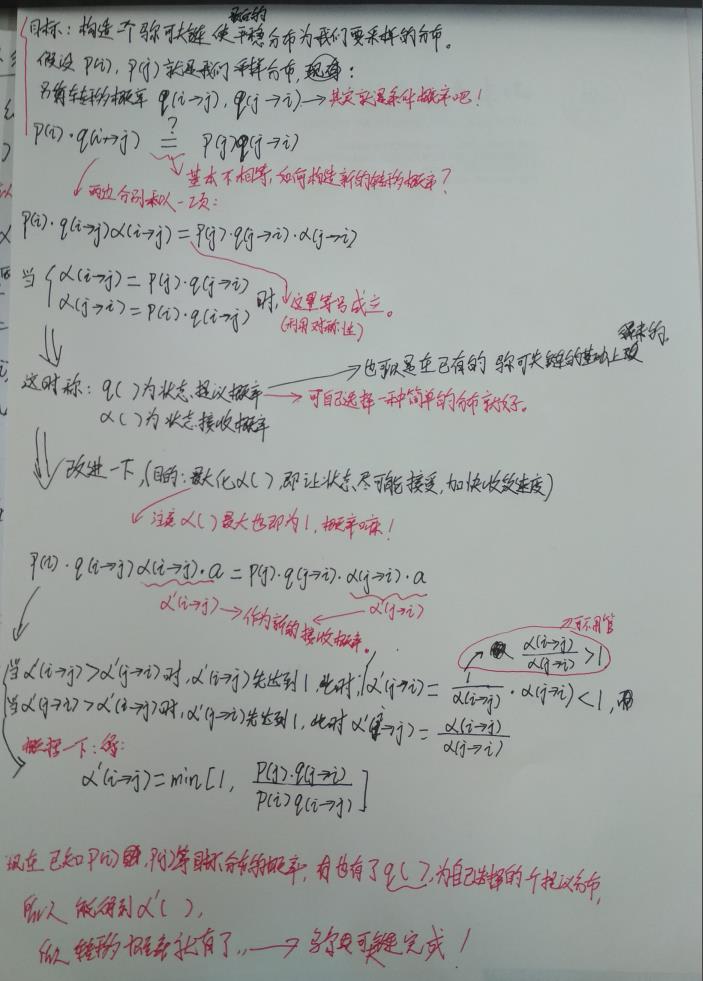

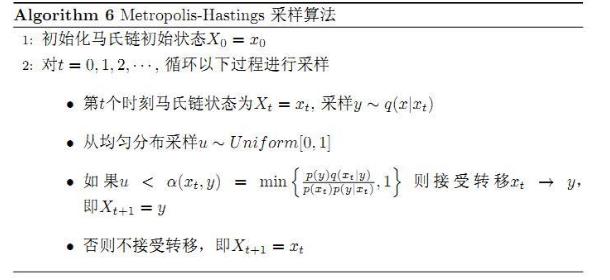

二, Metropolis-Hastings算法

在 http://cos.name/2013/01/lda-math-mcmc-and-gibbs-sampling/ 已经给出了很好的介绍。这里我自己再手写一遍。

对于证明这样的转移概率满足细致平衡条件,就没有必要了,因为上面的推导过程就是在细致平衡条件上推导出来的。

最终的采样算法:

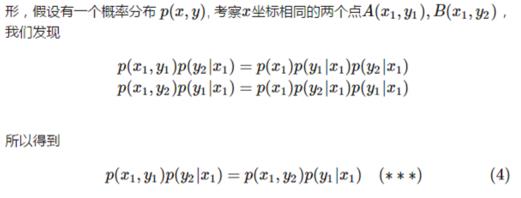

三, Gibbs 采样(吉布斯采样)

大家都说:Gibbs 采样也是Metropolis-Hastings算法的一种特殊的形式,怎么特殊呢?就是接受概率为1了。

我觉得呢,是找到了一个公式,一个什么公式呢?就是一个满足细致平衡条件的公式。

假如,二维的情况下,我们的目标采样分布函数表示为 P(x, y), 这时呢:有以下公式成立:

这么看, 公式4是不是满足细致平衡条件呢,对吧。。 只不过,两个状态的转移限定同一维坐标轴上进行的。

所以呢,只要我们把目标的采样分布函数的条件概率作为马尔可夫链的转移概率的话,转移一定的次数以后,最终的马尔可夫链的最终的状态分布就符合 我们的目标采样的分布函数。

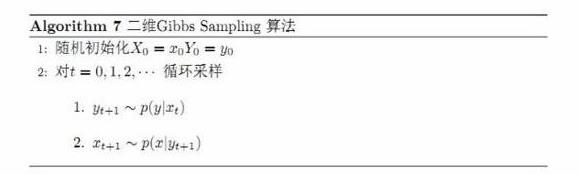

二维的Gibbs采样算法:

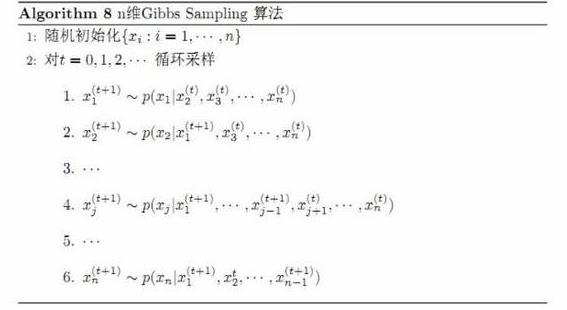

n维的Gibbs采样算法:

参考:

http://www.cnblogs.com/xbinworld/p/4266146.html 随机采样方法整理与讲解(MCMC、Gibbs Sampling等)

http://blog.csdn.net/itplus/article/details/19168937 受限玻尔兹曼机(RBM)学习笔记(一)预备知识

http://blog.csdn.net/google19890102/article/details/51785156 简单易学的机器学习算法——Metropolis-Hastings算法

http://blog.csdn.net/google19890102/article/details/51755242 简单易学的机器学习算法——马尔可夫链蒙特卡罗方法MCMC

http://blog.csdn.net/google19890102/article/details/51755245 简单易学的机器学习算法——Gibbs采样

以上是关于MCMC采样理论的一点知识的主要内容,如果未能解决你的问题,请参考以下文章