Softmax vs. Softmax-Loss: Numerical Stability

Posted 去做点事情

tags:

篇首语:本文由小常识网(cha138.com)小编为大家整理,主要介绍了Softmax vs. Softmax-Loss: Numerical Stability相关的知识,希望对你有一定的参考价值。

http://freemind.pluskid.org/machine-learning/softmax-vs-softmax-loss-numerical-stability/

softmax 在 Logistic Regression 里起到的作用是将线性预测值转化为类别概率

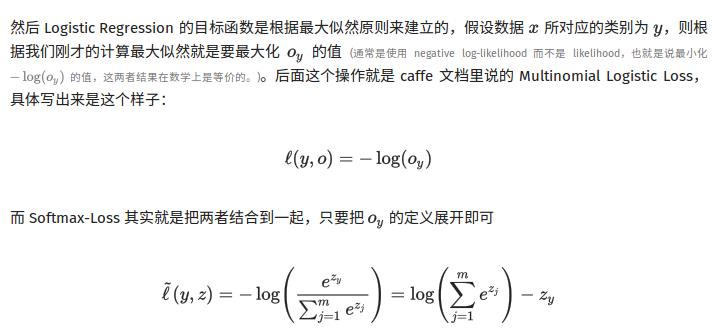

1.最大似然估计通常使用log-likelihood,并且是negative log-likelihood,将最大化转换为最小化

2.softmax loss是将softmax和最大似然估计结合起来

softmax-loss原本公式如下:

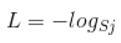

j表示的是第几个类别,由于gt只有一个类别,所以公式简化为:

https://blog.csdn.net/u014380165/article/details/77284921

以上是关于Softmax vs. Softmax-Loss: Numerical Stability的主要内容,如果未能解决你的问题,请参考以下文章