python中,进行爬虫抓取怎么样能够使用代理IP?

Posted

tags:

篇首语:本文由小常识网(cha138.com)小编为大家整理,主要介绍了python中,进行爬虫抓取怎么样能够使用代理IP?相关的知识,希望对你有一定的参考价值。

网络数据量越来越大,从网页中获取信息变得越来越困难,如何有效地抓取并利用信息,已成为网络爬虫一个巨大的挑战。下面IPIDEA为大家讲明爬虫代理IP的使用方法。

1. 利用爬虫脚本每天定时爬取代理网站上的ip,写入MongoDB或者其他的数据库中,这张表作为原始表。

2. 使用之前需要做一步测试,就是测试这个ip是否有效,方法就是利用curl访问一个网站查看返回值,需要创建一张新表,循环读取原始表有效则插入,验证之后将其从原始表中删除,验证的同时能够利用响应时间来计算这个ip的质量,和最大使用次数,有一个算法能够参考一种基于连接代理优化管理的多线程网络爬虫处理方法。

3. 把有效的ip写入ip代理池的配置文件,重新加载配置文件。

4.让爬虫程序去指定的dailiy的服务ip和端口,进行爬取。

参考技术A 在python中用爬虫再用到代理服务器,有两个办法,①直接在布署该python爬虫的电脑上设置代理服务器,这样从该电脑上出站的信息就只能由代理服务器处理了,爬虫的也不例外,可以搜"windows设置代理服务器"、"Linux设置代理服务器"。通常是”设置->网络->连接->代理“。②若想让python单独使用这个代理服务器,可以搜一下"python proxy config","python配置代理服务器",有一些库支持简单的BM代理服务器连接。 参考技术B

代理 IP 是 Python 中网络爬虫的重要组成部分。它通过以下几种方式增强了此过程:

使用代理池将显着降低您被禁止或阻止的情况发生。

无论您从哪个位置发送请求,代理都将帮助您解除对受地理限制的内容的阻止。当您打算抓取可以针对不同地区以不同方式显示的电子商务或旅行数据时,它可能非常有价值。

使用代理池,您可以在不超过目标请求限制的情况下向目标发出更多请求。

代理允许您拥有无限的并发会话,这意味着您可以检索更多数据。

要在 Python 中使用代理,您应该执行以下操作:

导入 requests 模块。

设置您的代理/代理 IP 地址和端口号。

初始化 URL。

向 URL 发送 GET 请求,并传入代理。

返回当前请求的代理地址。

方法步骤:

1、打开IP海换IP软件,设置网络类型。

2、设置IP节点线路,启动连接。

3、连接后打开网页查询当前IP地址。

如何使用Python实现爬虫代理IP池

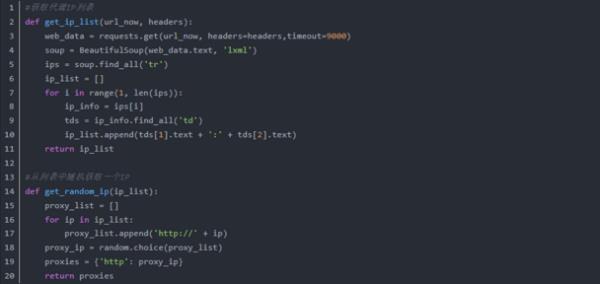

第一步:找IP资源

IP资源并不丰富,换句话说是供不应求的,因此一般是使用动态IP。

免费方法,直接在网络上找,在搜索引擎中一搜索特别多能够提供IP资源的网站,进行采集即可。

付费方法,通过购买芝麻ip上的IP资源,并进行提取,搭建IP池。

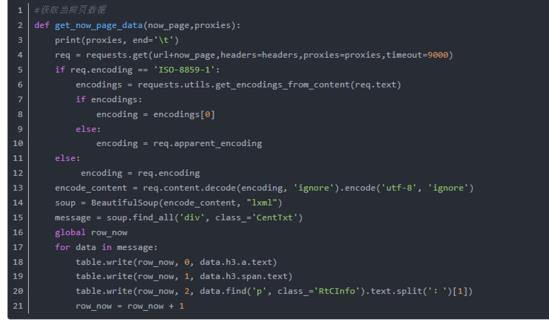

第二步,检测可用IP保存。提取到的IP,可以进一步进行检测是否可用,比如访问某个固定的网站,找出访问成功的IP进行保存。

第三步,随机调用IP

在爬虫需要使用IP时,可用读取保存IP的文件,进行随机调用IP。

本文介绍了如何建爬虫的IP池方法,可以说搭建IP池很容易,可有些IP的时效性很短,使用之前还可以再测试一次的。

可以根据爬虫对象的限制策略,写个程序进行定时定量自动重拨就可以。 参考技术C 为了突破次数的限制就可以使爬虫更高效的工作,代理IP是突破次数限制,提高爬虫高效工作的最好的工具。所以,很多人都想通过建立IP池的方法,实现换IP突破限制,那么这IP池如何进行搭建,接下来IPIDEA全球http简单的给大家讲讲如何搭建一个代理IP池。

一:搭建IP代理池的方法

1.主要用途

当进行数据爬取的时候,有一部分网站是设置了一些反爬虫的设置,这样你的本地IP就会被拉入该网站的系统黑名单中,从而达到禁止本地IP访问数据的请求。而使用代理IP池,即可通过更换IP的方法,突破IP的限制。

2.IP抓取

爬取代理ip,这也需要找网页,这就得看看哪个网页提供这些代理ip了,可以直接网上搜搜,然后进行IP抓取。

3.IP验证

抓取来网站代码之后,进行html的解析。并将代理IP验证,存放队列等操作。

判断是否用的方法就是随便拿一个获取别的网站,加上代理ip发送get请求,看看status_code()的返回码是不是200,即可。

4.运行效果

以上就是简单搭建的代理ip池了,等到以后慢慢完善,你可以把他们存入你的数据库,然后要用的时候,就随机拿出来,先看看有没有用,没用的话就删除,有用就拿来用即可。

二、拨号服务器搭建

如果需要高效果,可以选择拨号服务器,搭建代理IP池,,毕竟是独享,效果很好。但是用过一段时间后,就会出现一些问题,需要花费大量的时间去维护,甚至有时候出现的问题很难解决,烦不胜烦。所以,自己搭建代理IP池是有一定的难度,还需要更多的维护成本。

使用http是个提高效率的方法IPIDEA整合全球ip资源来自220+国家地区的ip资源支持自定义提取,提供IP的同时更注重保障安全性。可以应用在很多行业领域,比如网络投票,网络爬虫等行业,但在使用的过程中,也要遵守行业规则。

以上是关于python中,进行爬虫抓取怎么样能够使用代理IP?的主要内容,如果未能解决你的问题,请参考以下文章