Linux内核分析:完成一个简单的时间片轮转多道程序内核代码

Posted Linkle

tags:

篇首语:本文由小常识网(cha138.com)小编为大家整理,主要介绍了Linux内核分析:完成一个简单的时间片轮转多道程序内核代码相关的知识,希望对你有一定的参考价值。

PS.贺邦 原创作品转载请注明出处 《Linux内核分析》MOOC课程 http://mooc.study.163.com/course/USTC-1000029000

1.mykernel实验指导(操作系统是如何工作的)

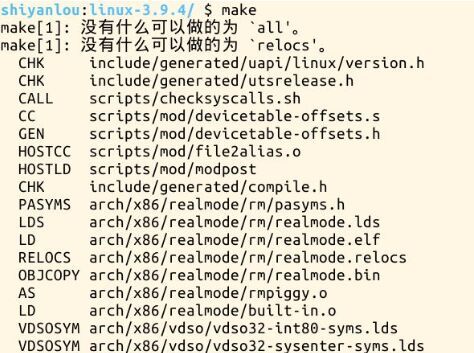

使用实验楼虚拟机打开shell输入下列代码

- 1 cd LinuxKernel/linux-3.9.4

- 2 qemu -kernel arch/x86/boot/bzImage

可以看到初始的内核运行情况如下:

内核不停的执行my_start_kernel(),每隔一段时间被my_timer_handler()中断,然后执行一条打印语句:printk(KERN_NOTICE “\n>>>>>>>>>>>>>>>>>my_timer_handler here<<<<<<<<<<<<<<<<<<\n\n”);

后,又回到my_start_kernel()继续执行。

打开mymain.c文件,可以看到其中只有如下这一个函数。它作为内核启动的起始位置,从这个函数开始运行,并无限循环。

打开myinterrupt.c文件,里面也只有一个my_timer_handler(),它被Linux内核周期性调用,从而产生了一个周期性的中断机制。

2.修改内核代码,使之成为一个简单的时间片轮转多道程序内核,然后重新编译运行。

从https://github.com/mengning/mykernel上下载mypcb.h;mymain.c;myinterrupt.c;

然后替换位于home/shiyanlou/LinuxKernel/linux-3.9.4/mykernel/中的mymain.c;myinterrupt.c;

将mypcb.h也放在这里。

然后执行make,重新编译内核。效果如下:

然后再次输入:

- qemu -kernel arch/x86/boot/bzImage 命令

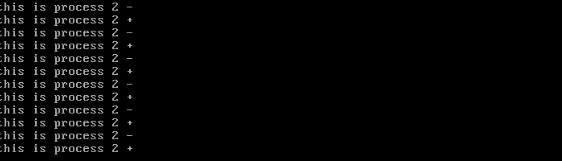

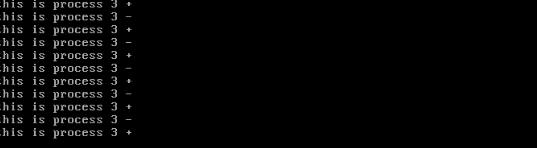

启动内核。 可以发现跳转和时间片都有了明显的改变。

实验结果与预期结果相符,实验成功。

3.重点代码理解

mymain.c

void__init my_start_kernel(void) {

Int pid = 0;

Int i;

/* Initialize process 0*/

task[pid].pid = pid;//task[0].pid=0;

ask[pid].state = 0;/* -1 unrunnable, 0 runnable, >0 stopped */

task[pid].task_entry = task[pid].thread.ip = (unsignedlong)my_process;//令0号进程的入口地址为my_process();

task[pid].thread.sp = (unsignedlong)&task[pid].stack[KERNEL_STACK_SIZE-1];//0号进程的栈顶为stack[]数组的最后一个元素

task[pid].next = &task[pid];//next指针指向自己/*fork more process */

for(i=1;i<MAX_TASK_NUM;i++)//根据0号进程,复制出几个只是编号不同的进程

{

memcpy(&task[i],&task[0],sizeof(tPCB));//void *memcpy(void *dest, const void *src, size_t n);从源src所指的内存地址的起始位置开始拷贝n个字节到目标dest所指的内存地址的起始位置中。

task[i].pid = i; task[i].state = -1;//这些进程的状态都设置为未运行。

task[i].thread.sp = (unsignedlong)&task[i].stack[KERNEL_STACK_SIZE-1]; task[i].next = task[i-1].next;//新创建的进程的next指向0号进程的首地址

task[i-1].next = &task[i];//前一个进程的next指向最新创建的进程的首地址,从而成为一个循环链表。

mypcb.h

#define MAX_TASK_NUM 4 //最大进程数,这里设置为了4个。

#define KERNEL_STACK_SIZE 1024*8 //每个进程的内核栈的大小。

/* CPU-specific state of this task */

structThread { unsignedlongip;//用于保存进程的eip

unsignedlongsp;//用户保存进程的esp};

typedefstructPCB{ intpid;//进程的id号

volatilelongstate; /* 进程的状态:-1 unrunnable, 0 runnable, >0 stopped */

charstack[KERNEL_STACK_SIZE];//进程的栈,只有一个核心栈。/* CPU-specific state of this task */

structThread thread;//每个进程只有一个线程。

unsignedlongtask_entry;//进程的起始入口地址。

myinterrupt.c

if(next->state == 0)/*如果下一个将要运行的进程已经处于运行状态 -1 unrunnable, 0 runnable, >0 stopped */

{

/* switch to next process */

asm volatile(

"pushl %%ebp\n\t" /* 保存当前进程的ebp到自己的栈中。 save ebp */

"movl %%esp,%0\n\t" /* 保存当前进程的esp到自己的栈中。 save esp */

"movl %2,%%esp\n\t" /* 从next->thread.sp中弹出下一个进程的esp。与第二句相对应。 restore esp */

"movl $1f,%1\n\t" /* 将下一个进程的eip设置为1f。$1f就是指标号1:的代码在内存中存储的地址 save eip */

"pushl %3\n\t" /* 将next->thread.ip压入当前进程的栈中。*/

"ret\n\t" /* 从当前进程的栈中弹出刚刚压入的next->thread.ip。完成进程切换。 restore eip */

"1:\t" /* 即$1f指向的位置。next process start here */

"popl %%ebp\n\t" /* 切换到的进程把ebp从栈中弹出至ebp寄存器。与第一句相对应。*/

: "=m" (prev->thread.sp),"=m" (prev->thread.ip)

: "m" (next->thread.sp),"m" (next->thread.ip)

);

my_current_task = next; //当前进程切换为next

printk(KERN_NOTICE ">>>switch %d to %d<<<\n",prev->pid,next->pid); //打印切换信息

}

else//如果下一个将要运行的进程还从未运行过。

{

next->state = 0;//将其设置为运行状态。

my_current_task = next;////当前进程切换为next

printk(KERN_NOTICE ">>>switch %d to %d<<<\n",prev->pid,next->pid);//打印切换信息

/* switch to new process */

asm volatile(

"pushl %%ebp\n\t" /* save ebp */

"movl %%esp,%0\n\t" /* save esp */

"movl %2,%%esp\n\t" /* restore esp */

"movl %2,%%ebp\n\t" /* restore ebp */

"movl $1f,%1\n\t" /* 将要被切换出去的进程的ip设置为$1f。这样等一下它被切换回来时(一定是运行状态)肯定会进入if判断分支,可以从if中的标号1处继续执行。 save eip */

"pushl %3\n\t" /* 将next->thread.ip(因为它还没有被运行过,所以next->thread.ip现在仍处于初始状态,即指向my_process(),压入将要被切换出去的进程的堆栈。*/

"ret\n\t" /* 将刚刚压入的next->thread.ip出栈至eip,完成进程切换。 restore eip */

4.分析进程的启动和进程的切换机制。

首先,内核启动__init my_start_kernel(void),创建了4个进程,分别是0,1,2,3号,设置0号为运行态,其它3个进程为未运行态。

0号进程的入口都被初始化为 task[pid].task_entry = task[pid].thread.ip = (unsigned long)my_process;即指向my_process()。

0号进程的栈顶被初始化为 task[i].thread.sp = (unsigned long)&task[i].stack[KERNEL_STACK_SIZE-1];

之后的进程也都是根据0号进程复制得到,所以它们的起始入口也是my_process(),初始栈顶也是指向了自己的stack[KERNEL_STACK_SIZE-1];

my_current_task = &task[pid];将当前进程设置为0号进程。然后从0号进程开始运行。

“movl %1,%%esp\n\t”

将0号进程的栈顶放入esp寄存器。

“pushl %1\n\t” /* push ebp */

当前esp指向了stack数组的末尾,这里也是栈顶,因为栈是空的,所以esp==ebp。

“pushl %0\n\t” /* push task[pid].thread.ip */

“ret\n\t” /* pop task[pid].thread.ip to eip */

切换到0号进程的入口地址开始执行。

“popl %%ebp\n\t”

这句多余,在ret之后,不会被执行。

:

: “c” (task[pid].thread.ip),”d” (task[pid].thread.sp)

之后0号进程不断执行my_process()。一段时间后,my_timer_handler()被内核调用,触发中断, my_need_sched = 1;将全局变量my_need_sched 设置为了1。

此后,当0号进程执行到了if(my_need_sched == 1)时就会进入这个if条件分支中,执行 my_schedule();执行进程调度。

0号进程的next指针指向的是1号进程,所以在my_schedule()中的next指针指向了1号进程,prev指针指向了0号进程。

因为1号进程当前还未被运行过,所以会执行else条件分支:next->state = 0;//将1号进程设置为运行状态。

my_current_task = next;//当前进程切换为1号进程printk(KERN_NOTICE “>>>switch %d to %d<<<\n”,prev->pid,next->pid);//打印switch 0 to 1

“pushl %%ebp\n\t” /* save ebp */

“movl %%esp,%0\n\t” /* save esp */

将0号进程的ebp和esp都保存到0号进程的栈上。

“movl %2,%%esp\n\t” /* restore esp */

“movl %2,%%ebp\n\t” /* restore ebp */

将1号进程的存在1号进程结构体中next->thread.sp保存的esp的值存入esp寄存器和ebp寄存器,因为1号进程还未被运行过,所以esp仍指向了1号栈的stack[KERNEL_STACK_SIZE-1]。

“movl $1f, %1\n\t” 将0号进程的eip设置为if。

“pushl %3\n\t”

“ret\n\t”

将1号进程的eip加入0号进程的栈中,然后通过ret指令,将这个eip从0号进程的栈中弹出,存入eip寄存器,完成从0号进程到1号进程的切换。此后类似。

5.对“操作系统是如何工作的”理解。

操作系统的内核有一个起始位置,从这个起始位置开始执行。开始工作时,CPU分配给第一个进程,开始执行第一个进程,然后通过一定的调度算法,比如时间片轮转,在一个时间片后,发生中断,

第一个进程被阻塞,在完成保存现场后将CPU分配给下一个进程,执行下一个进程。这样,操作系统就完成了基本的进程调度的功能。

以上是关于Linux内核分析:完成一个简单的时间片轮转多道程序内核代码的主要内容,如果未能解决你的问题,请参考以下文章