如何使用Python实现爬虫代理IP池

Posted

tags:

篇首语:本文由小常识网(cha138.com)小编为大家整理,主要介绍了如何使用Python实现爬虫代理IP池相关的知识,希望对你有一定的参考价值。

第一步:找IP资源

IP资源并不丰富,换句话说是供不应求的,因此一般是使用动态IP。

免费方法,直接在网络上找,在搜索引擎中一搜索特别多能够提供IP资源的网站,进行采集即可。

付费方法,通过购买芝麻ip上的IP资源,并进行提取,搭建IP池。

第二步,检测可用IP保存。提取到的IP,可以进一步进行检测是否可用,比如访问某个固定的网站,找出访问成功的IP进行保存。

第三步,随机调用IP

在爬虫需要使用IP时,可用读取保存IP的文件,进行随机调用IP。

本文介绍了如何建爬虫的IP池方法,可以说搭建IP池很容易,可有些IP的时效性很短,使用之前还可以再测试一次的。

可以根据爬虫对象的限制策略,写个程序进行定时定量自动重拨就可以。 参考技术C 为了突破次数的限制就可以使爬虫更高效的工作,代理IP是突破次数限制,提高爬虫高效工作的最好的工具。所以,很多人都想通过建立IP池的方法,实现换IP突破限制,那么这IP池如何进行搭建,接下来IPIDEA全球http简单的给大家讲讲如何搭建一个代理IP池。

一:搭建IP代理池的方法

1.主要用途

当进行数据爬取的时候,有一部分网站是设置了一些反爬虫的设置,这样你的本地IP就会被拉入该网站的系统黑名单中,从而达到禁止本地IP访问数据的请求。而使用代理IP池,即可通过更换IP的方法,突破IP的限制。

2.IP抓取

爬取代理ip,这也需要找网页,这就得看看哪个网页提供这些代理ip了,可以直接网上搜搜,然后进行IP抓取。

3.IP验证

抓取来网站代码之后,进行html的解析。并将代理IP验证,存放队列等操作。

判断是否用的方法就是随便拿一个获取别的网站,加上代理ip发送get请求,看看status_code()的返回码是不是200,即可。

4.运行效果

以上就是简单搭建的代理ip池了,等到以后慢慢完善,你可以把他们存入你的数据库,然后要用的时候,就随机拿出来,先看看有没有用,没用的话就删除,有用就拿来用即可。

二、拨号服务器搭建

如果需要高效果,可以选择拨号服务器,搭建代理IP池,,毕竟是独享,效果很好。但是用过一段时间后,就会出现一些问题,需要花费大量的时间去维护,甚至有时候出现的问题很难解决,烦不胜烦。所以,自己搭建代理IP池是有一定的难度,还需要更多的维护成本。

使用http是个提高效率的方法IPIDEA整合全球ip资源来自220+国家地区的ip资源支持自定义提取,提供IP的同时更注重保障安全性。可以应用在很多行业领域,比如网络投票,网络爬虫等行业,但在使用的过程中,也要遵守行业规则。

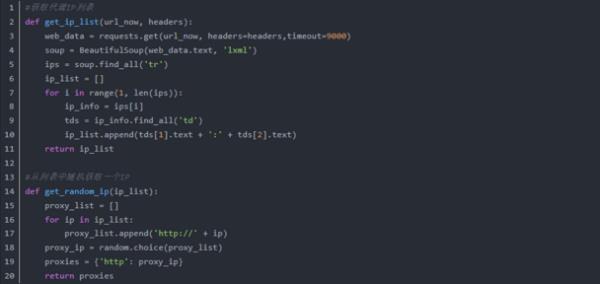

python 爬虫 ip池怎么做

我们先来了解下Python中高层次的数据结构,动态类型和动态绑定,使得它非常适合于快速应用开发,也适合于作为胶水语言连接已有的软件部件。用Python搭建一个可用的代理IP池其实并不难的。下面我们来看看搭建一个可用的代理IP池的代码,可以分为以下的模块:1、ProxyGetter,代理获取的相关代码,可以抓取网站上的免费代理,经测试每天更新的可用代理只有六七十个,当然也支持自己扩展代理接口。

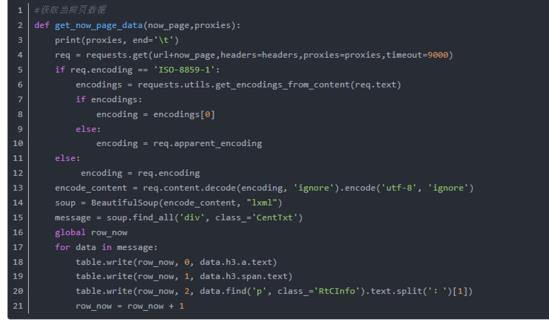

2、Api,api接口相关代码,目前api是由Flask实现,代码也非常简单。客户端请求传给Flask,Flask调用ProxyManager中的实现,包括get/delete/refresh/get_all。

3、Util,存放一些公共的模块方法或函数,包含GetConfig:读取配置文件config.ini的类,ConfigParse:集成重写ConfigParser的类,使其对大小写敏感,Singleton:实现单例,LazyProperty:实现类属性惰性计算。

4、DB,数据库相关代码,目前数据库是采用SSDB。代码用工厂模式实现,方便日后扩展其他类型数据库。

5、Schedule,定时任务相关代码,现在只是实现定时去刷新代码,并验证可用代理,采用多进程方式。

6、Manager,get/delete/refresh/get_all等接口的具体实现类,目前代理池只负责管理proxy,日后可能会有更多功能,比如代理和爬虫的绑定,代理和账号的绑定等等。

7、其他文件,配置文件:Config.ini,数据库配置和代理获取接口配置,可以在GetFreeProxy中添加新的代理获取方法,并在Config.ini中注册即可使用。大家平常搭建一个可用的代理IP池也是按照这些的方法吗?如果不是,也可以参考下的。如果想快捷方便有效可以使用http,IPIDEA全球http每日9000w的IP量包含全球240+地区的ip,足以符合需求量大的标准。 参考技术A 这里有比较详细的介绍

以上是关于如何使用Python实现爬虫代理IP池的主要内容,如果未能解决你的问题,请参考以下文章