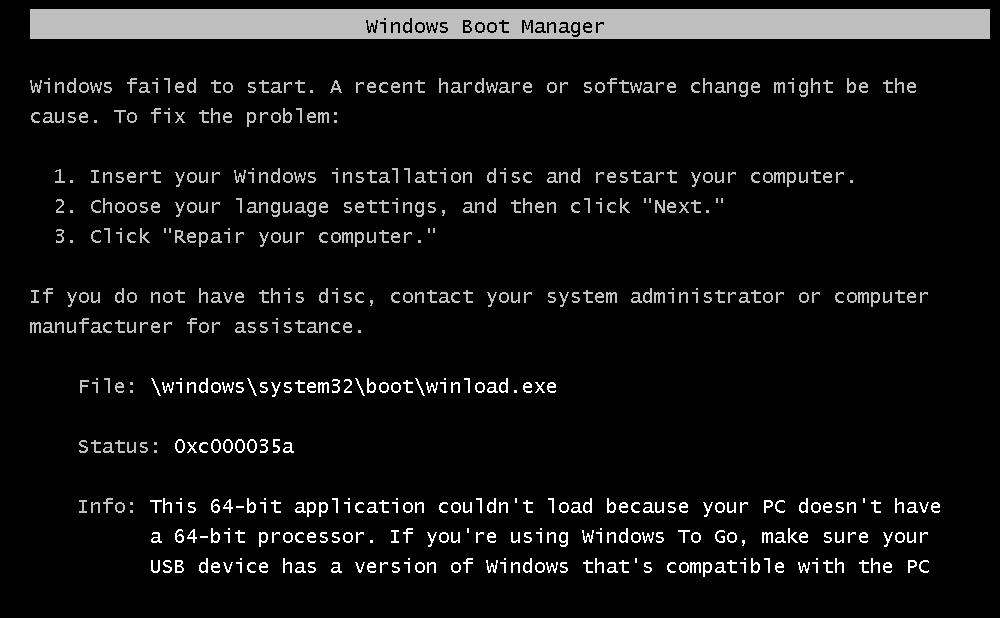

win7 64位系统上虚拟机安装win server2012R2时报错0xc000035a

Posted

tags:

篇首语:本文由小常识网(cha138.com)小编为大家整理,主要介绍了win7 64位系统上虚拟机安装win server2012R2时报错0xc000035a相关的知识,希望对你有一定的参考价值。

我在电脑上使用虚拟机安装windows server 2012r2时,出现报错 0xc000035a 及下面的提示this 64-bit application couldn't load because your pc doesn't have a 64-bit processor. if you're using windows to go, make sure your usb device has a version of windows that's compatible with the pc 我目前的主机操作系统是win7 x64 旗舰版,CPU是I3 M350 主板虚拟化已经打开,

首先检查你的机器是否支持64位操作系统,这个可以查看pc的cpu型号以及是否支持。

如果cpu型号过老,本来就不支持64位操作系统,那就到此为止了,你不能安装64位的虚拟操作系统。

这里主要说明pc本身是支持安装64位操作系统,但是vmware不能安装64位操作系统的问题。

1.可以借助硬件辅助虚拟化检测工具检查(可以直接百度收索此关键词 即可找到下载源),最好到微软官方网站上下载(havdetectiontool.exe)。如果出现下图的话,那sorry,只能去bios中查看和修改了

2.到bios中查看是否开启了VT功能

如果没有开启 VT 虚拟化技术支持,VT 要在 BIOS 中启用,不同的 BIOS 设置位置有点不同,但是选项基本是一样的,具体可以百度。

4

至于启用VT以后的正常安装,可以参照百度经验,有作者把正常流程已经弄出来了。追问

我的机器虚拟化选项已经打开了,CPU也支持64位,主机系统已经安装了64位的操作系统

参考技术A 用U盘安装的?试试用iso文件挂到虚机光驱安装。提示的错误原因是,当前虚机的cpu不是64位的。追问

不是用USB装的,用的ISO镜像装的,用的虚拟光驱,主板的虚拟化选项已经打开了,我的主机系统安装的就是win7 64位系统,按说CPU应该是支持的,我也查了下,这个CPU是支持64位运算的

参考技术B 虚拟机设置不是64位Windows2012追问你所说的虚拟机设置不是64位win2012是指哪里设置,我配置的时侯没有这个选项啊

追答新建虚拟机的时候可以选择操作系统类型,也可以在虚拟机设置里改

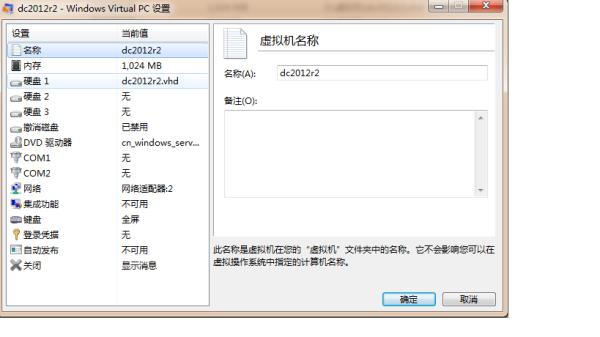

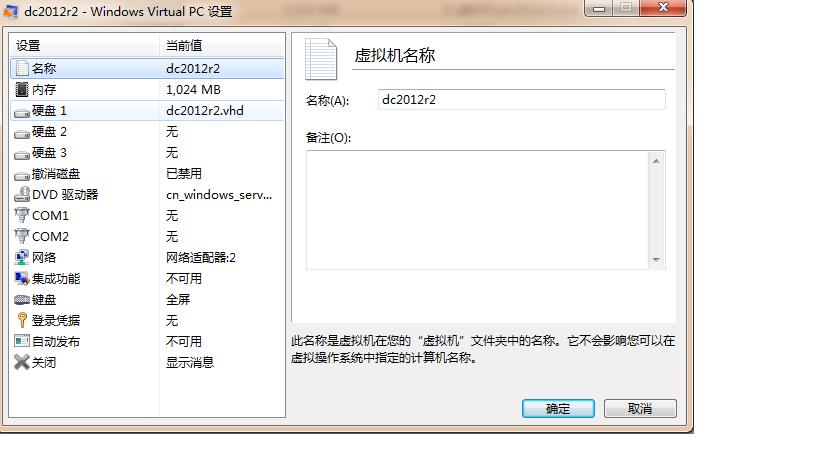

追问我新建的时侯没有这个选项啊,只有内存硬盘等的设置。我使用的是windows virtual pc

建议你还是用VMware Workstations或者VirtualBox吧

本回答被提问者采纳tensorflow serving目录解读

tf_serving-----WORKSPACE|

-----tensorflow-serving/----BUILD

| |

| -----workspace.bzl

| |

| -----example/-------BUILD

| |

| --------imagenet_lsvrc_2015_synsets.txt

| |

| --------imagenet_metadata.txt

| |

| --------inception_client.cc

| |

| --------inception_client.py

| |

| --------inception_k8s.yaml

| |

| --------inception_saved_model.py

| |

| --------mnist_client.py

| |

| --------mnist_iput_data.py

| |

| --------mnist_saved_model.py

|

-----------tensorflow/-------BUILD

| |

| --------WORKSPACE

| |

| ----tensorflow/------BUILD

| |

| -------workspace.bzl

|

-----------tf_models/----WORKSPACE

|

-----official/

|

-----tutorials/

|

-----research/-------inception/-------------------WORKSPACE

|

-------------------inception/--------BUILD

|

---------inception_train.py

|

---------inception_model.py

|

---------inception_eval.py

|

---------inception_distributed_train.py

解读:

项目文件夹名称为"tf_serving",WORKSPACE文件放在"tf_serving"项目文件夹的根目录

*************************************************************************

tf_serving/WORKSPACE解读:

*************************************************************************

#声明工作空间名称,与项目名称一致

workspace(name = "tf_serving")

#声明本地仓库'tensorflow'的名称及路径

local_repository(name = "org_tensorflow", path = "tensorflow",)

#声明io_bazel_rules_closure

http_archive(……)

#把新的Tensorflow Serving依赖加到workspace.bzl

load("//tensorflow_serving:workspace.bzl","tf_serving_workspace")

tf_serving_workspace()

#指定bazel最低要求版本

load("@org_tensorflow//tensorflow::workspace.bzl", "check_version")

check_version("0.5.4")*************************************************************************

tf_serving/tensorflow_serving/workspace.bzl解读:

*************************************************************************

#tensorFlow Serving外部依赖加载到WORKSPACE文件

load('@org_tensorflow//tensorflow::workspace.bzl', 'tf_workspace')

#此处是所有Tensorflow Serving的外部依赖。

#workspace_dir是Tensorflow Serving repo的绝对路径,如果是作为submodule

#连接,路径形式应该是'__workspace_dir__ + "serving"'

def tf_serving_workspace():

native.new_local_repository(

name = "inception_model",

path = "tf_models/research/inception",

build_file = "tf_models/research/inception/inception/BUILD",

)

tf_workspace(path_prefix = "", tf_repo_name = "org_tensorflow")

#gRPC依赖

native.bind(

name = "libssl",

actual = "@boringssl//:ssl",

)

native.bind(

name = "zlib",

actual = "@zlib_archive//:zlib")*************************************************************************

tf_serving/tensorflow_serving/BUILD解读:

*************************************************************************

# Tensorflow serving描述 package( default_visibility=["//tensorflow_serving:internal"], ) licenses(["notice"]) exports_files(["LICENSE"]) #开放源代码标记 package_group( name = "internal", package = [ "//tensorflow_serving/...", ], ) filegroup( name = "all_files", srcs = glob( ["**/*"], exclude = [ "**/METADATA", "**/OWNERS", "g3doc/sitemap.md", ], ), )

*************************************************************************

tf_serving/tensorflow/tensorflow/workspace.bzl解读:

*************************************************************************

# 可以在WORKSPACE文件中加载的Tensorflow外部依赖 load(……) def _is_windows(): …… def _get_env_var(): …… # 从'native.bazel_version'中解析bazel版本字符串 def _parse_bazel_version(): …… # 检查正在使用指定版本的bazel def check_version(): …… # 支持将Tensorflow作为submodule的临时工作区 def _temp_workaround_http_archive_impl(): …… # 如果非零code退出,则执行指定参数的命令并调用'fail' def _execute_and_check_ret_code(): …… # 在仓库根目录应用补丁文件 def _apply_patch(): …… # 下载仓库,在根节点应用补丁 def _patched_http_archive_impl(): …… # 如果Tensorflow连接为submodule,path_prefix不再使用 # tf_repo_name正在考虑中 def tf_workspace(): ……

*************************************************************************

tf_serving/tensorflow/tensorflow/BUILD解读:

*************************************************************************

package(default_visibility = [":internal"])

licenses(["notice"])

exports_files([

"LICENSE",

"ACKNOWLEDGMENTS",

# leakr文件用于//third_party/cloud_tpu

"leakr_badwords.dic",

"leakr_badfiles.dic",

])

load("//tensorflow:tensorflow.bzl", "tf_cc_shared_object")

load("//tensorflow/core:platform/default/build_config.bzl",

"tf_additional_binary_deps",

)

# 各种config setting

config_setting()

package_group()

filegroup()

py_library()

filegroup(

name = "all_opensource_files",

data = [

":all_files",

"//tensorflow/c:all_files",

"//tensorflow/cc:all_files",

……],

visibility = [':__subpackages__'],

)

load("//third_party/mkl:build_defs.bzl",

"if_mkl",

)

filegroup(

name = "intel_binary_blob",

data = if_mkl(

[

"//third_party/mkl:intel_binary_blob",

],

),

)

filegroup(

name = "docs_src",

data = glob(["docs_src/**/*.md"]),

)

tf_cc_shared_object(

……

)以上是关于win7 64位系统上虚拟机安装win server2012R2时报错0xc000035a的主要内容,如果未能解决你的问题,请参考以下文章

win10 64位自带虚拟机装好win7系统后启动不了怎么解决

SQLServer2000在64位win7系统中如何安装? 具体步骤?