linux查看当前的spark任务命令

Posted

tags:

篇首语:本文由小常识网(cha138.com)小编为大家整理,主要介绍了linux查看当前的spark任务命令相关的知识,希望对你有一定的参考价值。

使用命令spark-submit --list来查看当前正在运行的Spark任务。你可以使用命令spark-submit --list --all来查看更详细的信息,它会列出正在运行的Spark任务相关的所有信息,比如当前状态、已运行的时间等。 参考技术A 可以通过 grep 命令进行过滤查看。查看内核/操作系统/CPU信息的linux系统信息命令: uname -a

Grep 是 Global Regular Expression Print 的缩写,它搜索指定文件的内容,匹配指定的模式,默认情况下输出匹配内容所在的行。注意,grep 只支持匹配而不能替换匹配到的内容。 参考技术B Linux查看当前的Spark任务命令为:spark-submit --list 参考技术C 使用命令spark-submit --list可以查看当前的spark任务。 参考技术D 可以使用命令`ps -ef | grep spark`来查看当前的spark任务。

linux常用命令3:python自动任务管理

一、查看自动任务进程

方法1:

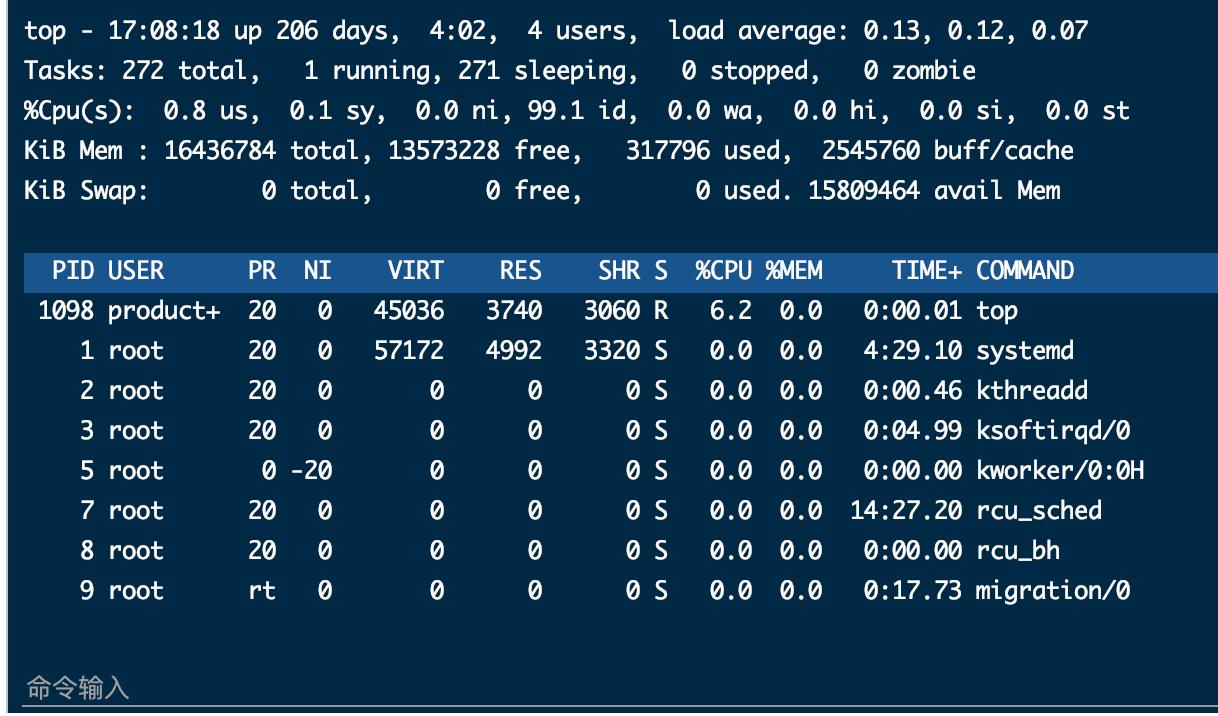

top ##查看所有任务,但是只能根据command为python层级确认当前自动任务有哪些

kill PID; #kill某自动任务

方法2:

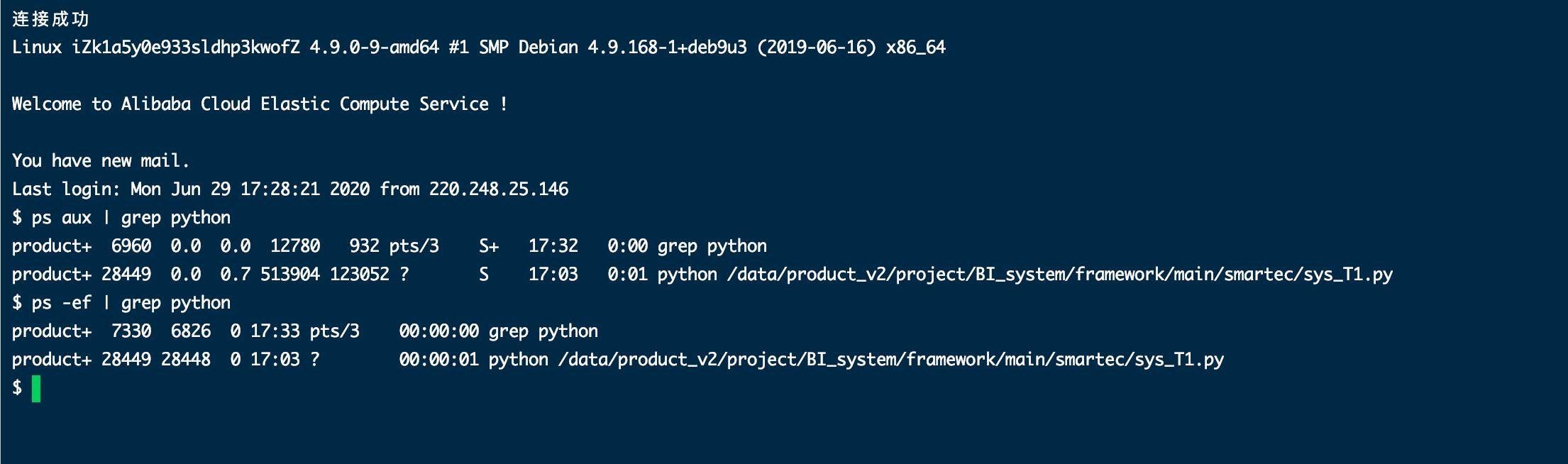

ps aux | grep python ##查看当前正在运行的自动任务,可以根据command为python名字确认当前自动任务有哪些

或ps -ef | grep python

kill PID; #kill某自动任务

grep 起到一个过滤的作用

字段含义如下:

UID PID PPID C STIME TTY TIME CMD

root 18887 18828 0 08:09 pts/0 00:00:00 grep ApacheJetspeed

ps:将某个进程显示出来

-A 显示所有程序。

-e 此参数的效果和指定"A"参数相同。

-f 显示UID,PPIP,C与STIME栏位。

grep命令是查找

中间的|是管道命令 是指ps命令与grep同时执行

这条命令的意思是显示有关Apachejetspeed有关的进程

UID PID PPID C STIME TTY TIME CMD

各相关信息的意义:

UID 程序被该 UID 所拥有

PID 就是这个程序的 ID

PPID 则是其上级父程序的ID

C CPU 使用的资源百分比

STIME 系统启动时间

TTY 登入者的终端机位置

TIME 使用掉的 CPU 时间。

CMD 所下达的指令为何

二、通过黑框kill进程

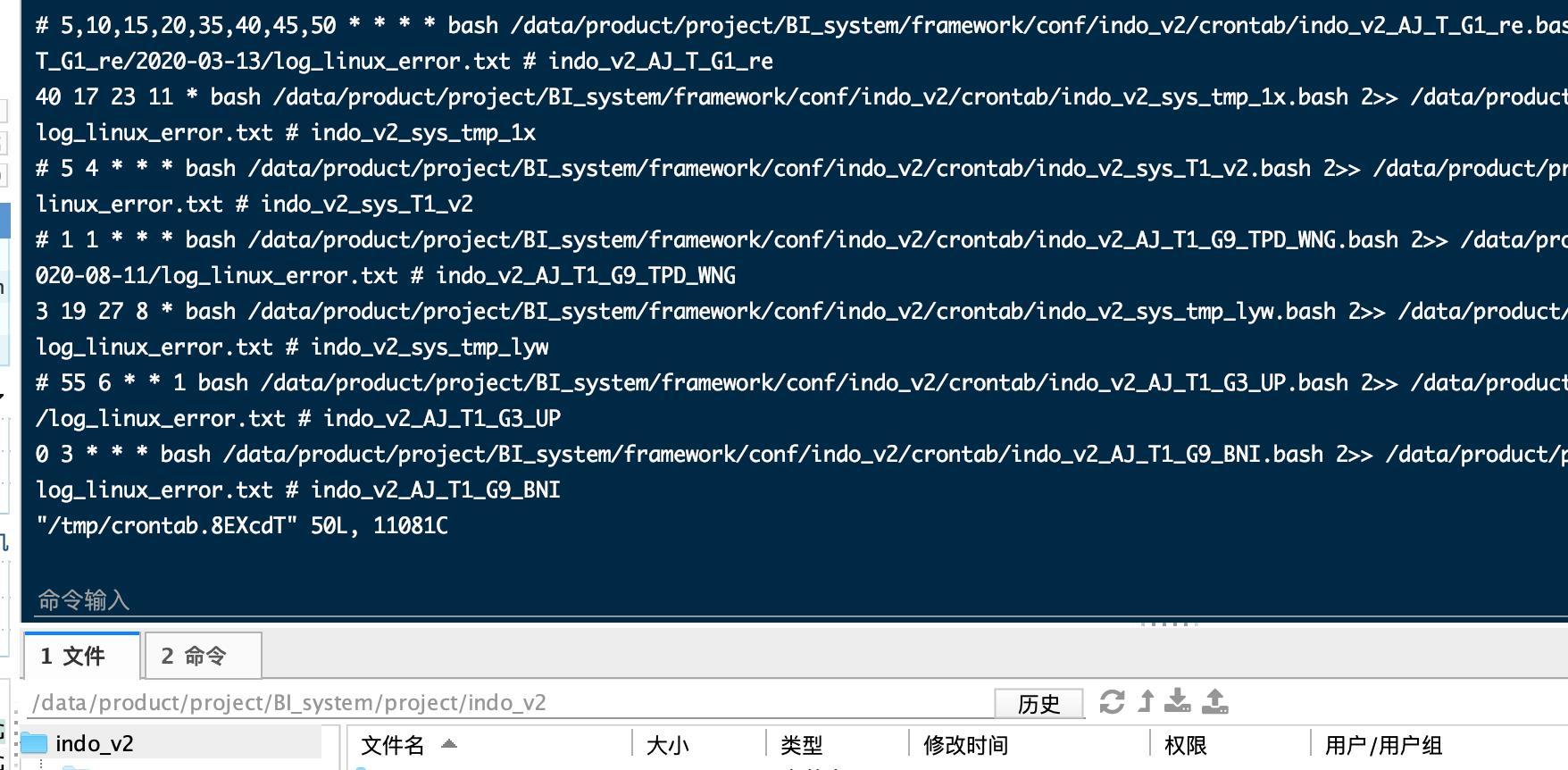

crontab -e #进入任务清单

crontab -e # 进入crontab

i # 进入编辑模式

j # 向上

k # 向下

esc # 退出编辑模式

:q! # 撤销操作并退出crontab

:wq # 保存操作并退出crontab

以上是关于linux查看当前的spark任务命令的主要内容,如果未能解决你的问题,请参考以下文章