The Lab Renderer学习笔记

Posted 房燕良

tags:

篇首语:本文由小常识网(cha138.com)小编为大家整理,主要介绍了The Lab Renderer学习笔记相关的知识,希望对你有一定的参考价值。

前言

Unity Vision VR/AR Summit来到中国了(http://www.bagevent.com/event/197605?bag_track=http://www.bagevent.com/event/197605 ),最近也关注了一下Unity的VR开发。

大概是6月份看到新闻:Steam发布了The Lab所使用的渲染器的所有源代码。我一直挺好奇的, 对于Unity3D这样不开源的引擎,如果搞一个渲染器呢?今天有时间读一下代码,一探究竟。

相关链接:

- 官方帖子:http://steamcommunity.com/games/250820/announcements/detail/604985915045842668

- GitHub下载:https://github.com/ValveSoftware/the_lab_renderer

- Unity Asset Store下载:https://www.assetstore.unity3d.com/en/#!/content/63141

特性&实现

从GitHub下载了The Lab Renderer之后,粗略的浏览一遍,内容不多,主要是几个组件的C#代码和一些Shader。接下来就看看它的主要特性是怎么实现的。

Single-Pass Forward Rendering

The Lab Renderer使用Forward Rendering的原因主要是为了MSAA(MultiSampling Anti-Aliasing)和效率。然而Unity默认的Forward Rendering使用了Multi-Pass来渲染所有灯光(每个物体的每个动态灯要多一个Pass来渲染它的光照),The Lab Renderer提供了一个单Pass渲染多个灯光的解决方案。

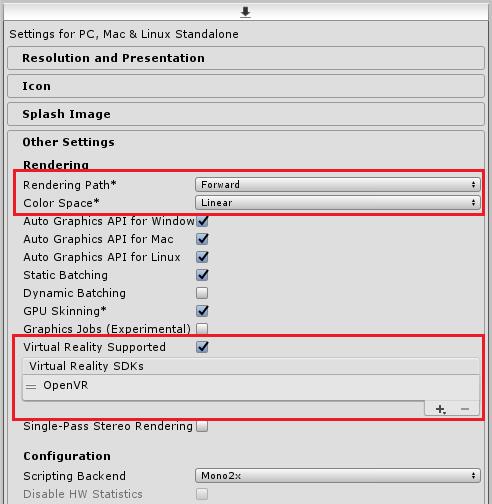

为了实现Single-Pass Forward Rendering,首先要在Player Settings做一些设置,如上图所示。所谓的“Single-Pass”主要靠Shader来实现了。大体思路就是在“vr_lightng.cginc”这个shader文件中定义了一系列灯光参数的数组:

#define MAX_LIGHTS 18

...

float4 g_vLightColor[ MAX_LIGHTS ];

float4 g_vLightPosition_flInvRadius[ MAX_LIGHTS ];

float4 g_vLightDirection[ MAX_LIGHTS ];然后使用一个for循环,一次性计算所有灯光的光照:

LightingTerms_t ComputeLighting( float3 vPositionWs ...)

{

[ loop ] for ( int i = 0; i < g_nNumLights; i++ )

{}

}接下来就是在C#层来处理灯光信息了。

- 首先,需要为每个Unity中的灯光对象添加“ValveRealtimeLight.cs ”脚本,class ValveRealtimeLight管理一个静态变量“List< ValveRealtimeLight > s_allLights”用来簿记所有的灯光数据。

然后,需要在Main Camera对象上添加“ValveCamera.cs”脚本。在class ValveCamera.UpdateLightConstants()成员函数中,会计算所有的灯光相关的参数,并设置到Shader的常量中。

以上就是The Lab Renderer的Single-Pass Forward Rendering这个特性的实现思路。

Shadows

The Lab Renderer还接管了阴影的渲染。需要在Unity的Quality->Shadows settings 中选择“Disable Shadows”来关闭Unity默认的阴影。

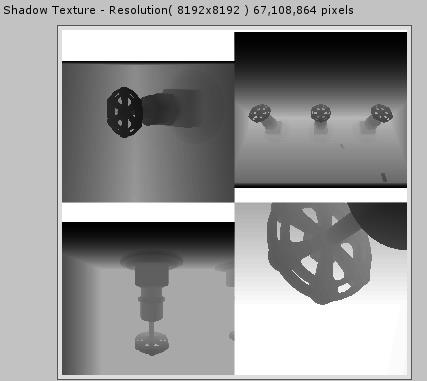

如上图所示,The Lab Renderer使用Shadow Mapping的算法来生成实时阴影。这个算法粗略的过程是这样的:

- 从灯光的角度渲染一个深度缓冲。这个深度缓冲的几何意义,可以粗略的理解为每个像素点到灯光最近的距离;这个深度缓冲又被成为Shadow Buffer或者Shadow Map。

- 在渲染Back Buffer的时候,对于每个需要着色的点,将其“投影”(Projection)到上述的Shadow Map空间,然后进行比较,来判断这个点是不是离灯光最近—-也就是有没有被其他物体遮挡,即在阴影之中。

- 生成Shadow Buffer的渲染,对于Spot Light非常直观啦;对于方向光,The Lab采用了近似的方法:将方向光替换成一个“非常远”的点光源;对于点光源,The Lab使用6个假的Spot Light来替代。0_0|||

上述算法的流程控制,在ValveCamera.cs脚本中实现。首先它需要一个从灯光角度渲染的Camera、一个RenderTexture用做Shadow Map,还需要一个Shader来进行Shadow Map渲染(Resources/vr_cast_shadows.shader)。

[ExecuteInEditMode]

[RequireComponent( typeof( Camera ) )]

public class ValveCamera : MonoBehaviour

{

...

[NonSerialized] private Camera m_shadowCamera = null;

[NonSerialized] public RenderTexture m_shadowDepthTexture = null;

[NonSerialized] public Shader m_shaderCastShadows = null;

...

}在ValueCamera.OnPreCull()脚本回调函数中会调用ValueCamera.ValveShadowBufferRender()来渲染Shadow Buffer。如上图的Shadow所示,The Lab把所有灯光渲染到了一个整体的Shadow Buffer之中,把每个灯光Shadow Buffer对应的区域,存储到Shader参数“g_vShadowMinMaxUv”之中。这样在前面讲的Single-Pass Forward Rendering过程中,就可以在一个Pass实现所有灯光的光影计算了。

至于vr_cast_shadows.shader的内容,就很简单了,它核心就是一个Vertex Shader,用来计算Projection之后的Position坐标就好,UV啊什么之类的都可以省略掉了。

在灯光渲染的Shader中(vr_lighting.cginc)通过ComputeShadow_PCF_3x3_Gaussian()函数来计算阴影。所谓的PCF就是Percentage Closer Filter,为的是产生阴影的边缘柔滑效果。在这个函数中,它才算有了高斯过滤来对目标点周围的3x3范围进行计算。

Adaptive Quality

对于VR来说,帧速率是非常重要的,所以Valve的大牛就添加了这个特性:动态调节渲染质量,达到稳定的搞效率,这是他在GDC 2016上的一个演讲:https://www.youtube.com/watch?v=eIlb688pUu4

这部分主要涉及到何时去调节质量,调节哪些地方(哪些是不能随便调的),具体的逻辑都在ValveCamera.UpdateAdaptiveQuality()这个函数里了。

以上是关于The Lab Renderer学习笔记的主要内容,如果未能解决你的问题,请参考以下文章