spark-2.0.0与hive-1.2.1整合

Posted 潇洒的麦兜

tags:

篇首语:本文由小常识网(cha138.com)小编为大家整理,主要介绍了spark-2.0.0与hive-1.2.1整合相关的知识,希望对你有一定的参考价值。

SparkSQL与Hive的整合

1. 拷贝$HIVE_HOME/conf/hive-site.xml和hive-log4j.properties到 $SPARK_HOME/conf/

2. 在$SPARK_HOME/conf/目录中,修改spark-env.sh,添加

export HIVE_HOME=/opt/hive-1.2.1

export SPARK_CLASSPATH=$HIVE_HOME/lib:$SPARK_CLASSPATH

3. 另外也可以设置一下Spark的log4j配置文件,使得屏幕中不打印额外的INFO信息:

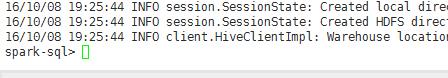

log4j.rootCategory=WARN, console

(但还是有信息提示)

进入$SPARK_HOME/bin执行 spark-sql

以上是关于spark-2.0.0与hive-1.2.1整合的主要内容,如果未能解决你的问题,请参考以下文章

为啥 spark-xml 会因 NoSuchMethodError 与 Spark 2.0.0 依赖关系而失败?

Spark 2.0.0 SPARK-SQL returns NPE Error